| 排名 | 模型 | Elo 得分 | 描述 | 许可证 |

|---|---|---|---|---|

| 1 | 🥇 GPT-4 | 1274 | OPENAI 公司:ChatGPT-4 | OpenAI公司专有 |

| 2 | 🥈Claude-v1 | 1224 | Anthtopic 公司:Claude | Anthtopic公司专有 |

| 3 | 🥉 GPT-3.5-turbo | 1155 | OPENAI 公司:ChatGPT-3.5 | OpenAI公司专有 |

| 4 | ⭐️ Vicuna-13B | 1083 | 一个聊天助手,由LLaMA对LMSYS的用户共享对话进行了微调 | 开源模型 |

| 5 | Koala-13B | 1022 | BAIR的学术研究对话模型 | 开源模型 |

| 6 | RWKV-4-Raven-14B | 989 | 一种能匹配LLM大模型的RNN递归神经网络 | Apache 2.0 |

| 7 | Oasst-Pythia-12B | 928 | LAION为每个人提供的开放式助理 | Apache 2.0 |

| 8 | ChatGLM-6B | 918 | 清华大学的开放式双语对话语言模式 | 开源模型 |

| 9 | StableLM-Tuned-Alpha-7B | 906 | 稳定性AI语言模型 | CC-BY-NS-SA-4.0 |

| 10 | Alpaca-13B | 904 | 根据斯坦福大学的演示,在教学中对LLaMA进行了微调 | 开源模型 |

| 11 | FastChat-T5-3B | 902 | 由LMSYS从FLAN-T5微调的聊天助手 | Apache 2.0 |

| 12 | Dolly-V2-12B | 863 | 一种由Databricks实现的指令调优开放式大型语言模型 | MIT |

| 13 | LLaMA-13B | 826 | 基于Meta的开放高效基础语言模型 | 开源模型 |

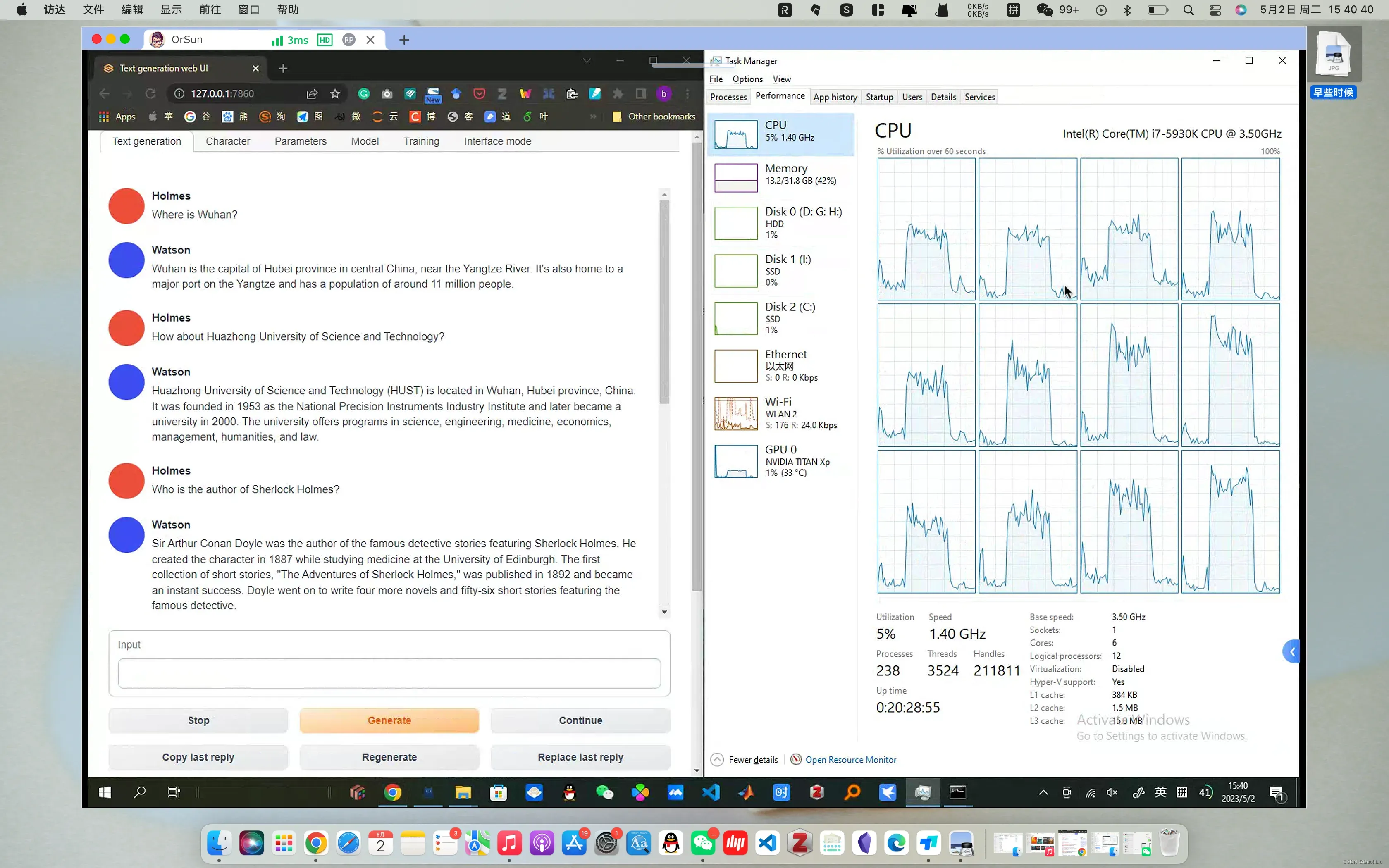

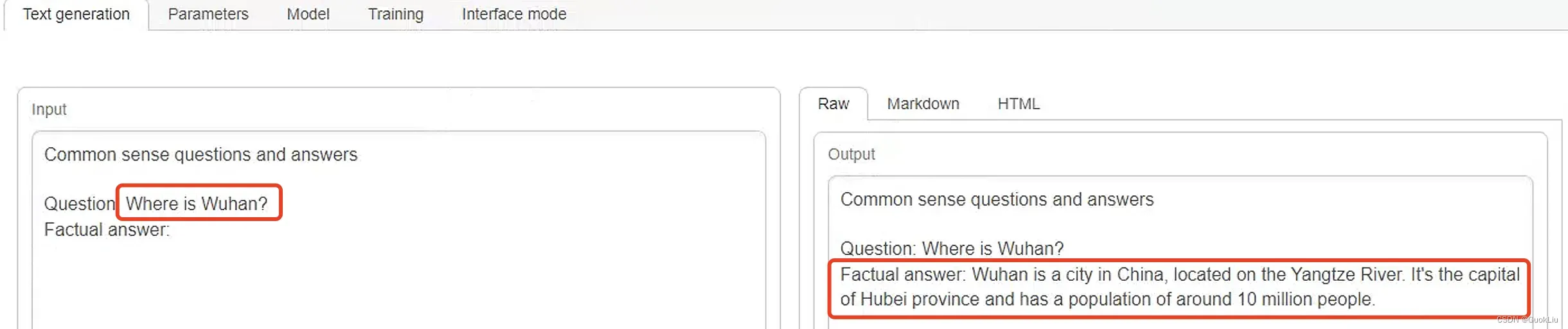

最终效果

- 在对话过程中,GPU与CPU均会有波动,但是主要还是CPU波动为主

相关资料

| 序号 | 链接 | 说明 |

|---|---|---|

| 001 | 本地CPU+6G内存部署类ChatGPT模型(Vicuna 小羊驼) – 知乎 | 极简安装版本,只支持CPU与命令行 |

| 002 | 最新开源语言模型 Vicuna 媲美GPT-4 支持本地化私有部署 – 知乎 | Youtube-Vicuna介绍 |

| 003 | 如何在你的电脑本地部署”GPT-4″ | Youtube-Vicuna安装 |

| 004 | GPT-4 “认为” 我们的开源版对话模型达到了ChatGPT 90%的性能 —— Vicuna 开发深度经验分享 – 知乎 | UCB开发者介绍 |

| 005 | 【CV2NLP】Chinese-Vicuna 中文小羊驼 – 知乎 | 微调中文Vicuna |

| 006 | 大模型也内卷,Vicuna训练及推理指南,效果碾压斯坦福羊驼 – 知乎 | 安装及微调介绍 |

| 007 | 小羊驼模型(FastChat-vicuna)运行踩坑记录 – 知乎 | 通过Webserver访问 |

| 008 | 用低配电脑离线运行ChatGPT开源平替 – 知乎 | ⭐️CPU+GPU版本安装 |

| 009 | 10元将Vicuna升级成多模态GPT-4,从图片中读取生命和宇宙的终极答案 – 知乎 | 通过外部算力平台部署 |

| 010 | 最新开源模型 StableVicuna 或将成为130亿参数最佳模型 – 知乎 | StableVicuna |

| 011 | FastChat/vicuna v1.1本地部署 – 知乎 | 本地命令行安装 |

| 012 | Vicuna-13B模型可在线试玩,参数已开源可下载 – 知乎 | 项目介绍 |

| 013 | Stability AI连扔两个王炸!首个开源RLHF模型登基,DeepFloyd IF像素级出图 – 知乎 | RLFH+DeepFloyd IF |

| 014 | HuggingChat叫板ChatGPT!300亿参数大模型免费用,网友:真香 – 知乎 | HuggingChat |

| 015 | 建立自己的ChatGPT:LLama私有化部署及测试 – 知乎 | LLama |

| 016 | 手搓具有GPT-4 90%能力的开源大语言模型FastChat – 知乎 | Vicuna-7B |

| 017 | 全球最大的 ChatGPT 开源替代品来了,支持 35 种语言,网友:不用费心买 ChatGPT Plus了! – 知乎 | Open Assistant |

| 018 | VICUNA开源人工智能模型!本地电脑安装和运行 OOBABOOGA WEBUI – YouTube | ⭐️Youtube安装视频 |

配置安装

本文主要参考的是

008与018,但是由于oobabooga-windows.zip已经更新,直接参考这两个方法都失效了。

Step 1: 下载权重

- 网址:https://huggingface.co/anon8231489123/vicuna-13b-GPTQ-4bit-128g/tree/main

- 文件:vicuna-13b-4bit-128g.safetensors 7.45G

Step 2: 下载UI界面

- 网址:https://github.com/oobabooga/text-generation-webui

- 文件:oobabooga-windows.zip

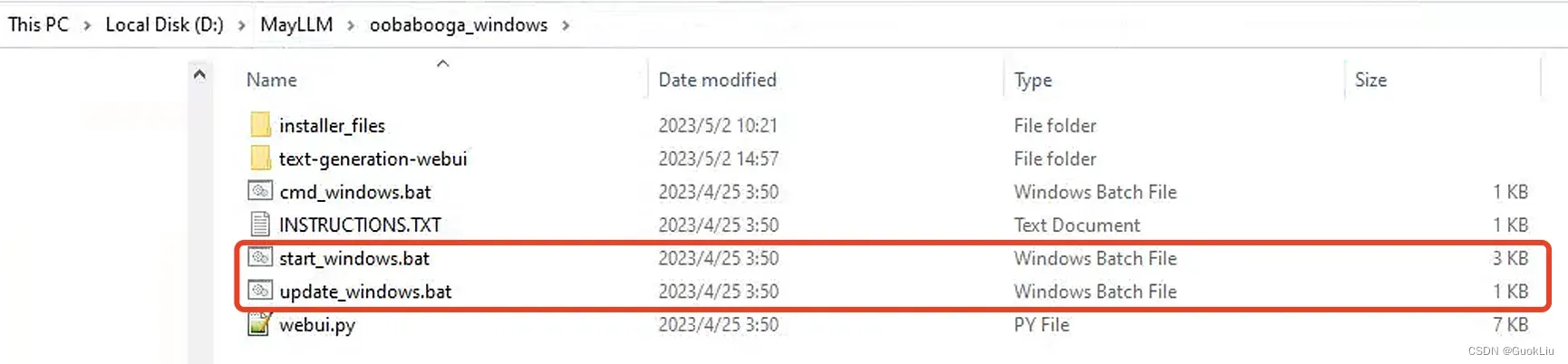

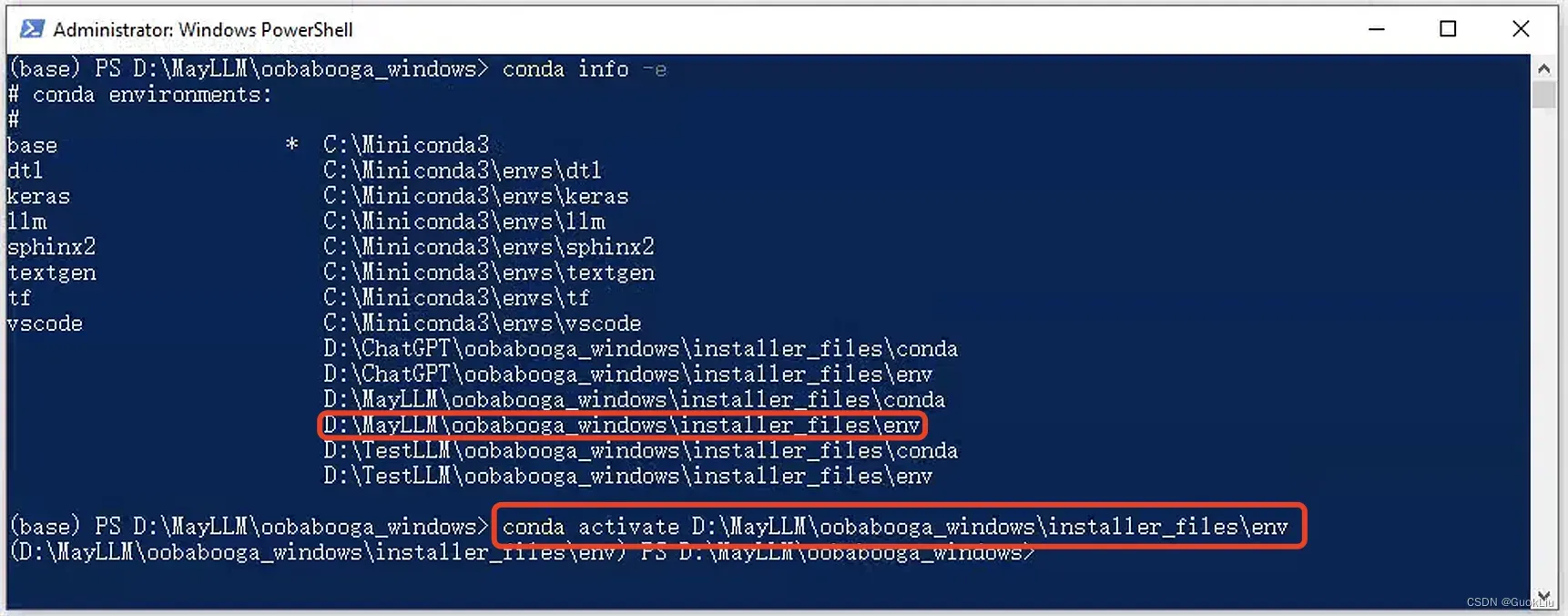

Step 3:双击安装

- start_windows.bat

- update_windows.bat

- 如果网络原因,有部分没有安装成功

- 可以多次点击

start_windows.bat,update_windows.bat直至安装成功

- ⚠️ 注意1: 默认的torch安装的是cpu版本,如果是安装GPU版本,需要自己指定版本,可参考如下

conda install torchvision torchaudio pytorch-cuda=11.7 git -c pytorch -c nvidia

-

⚙️ 否则:

- 始终默认使用cpu;

- UI界面的Chat窗口始终无法回答

is typing...;

- UI界面的Chat窗口始终无法回答

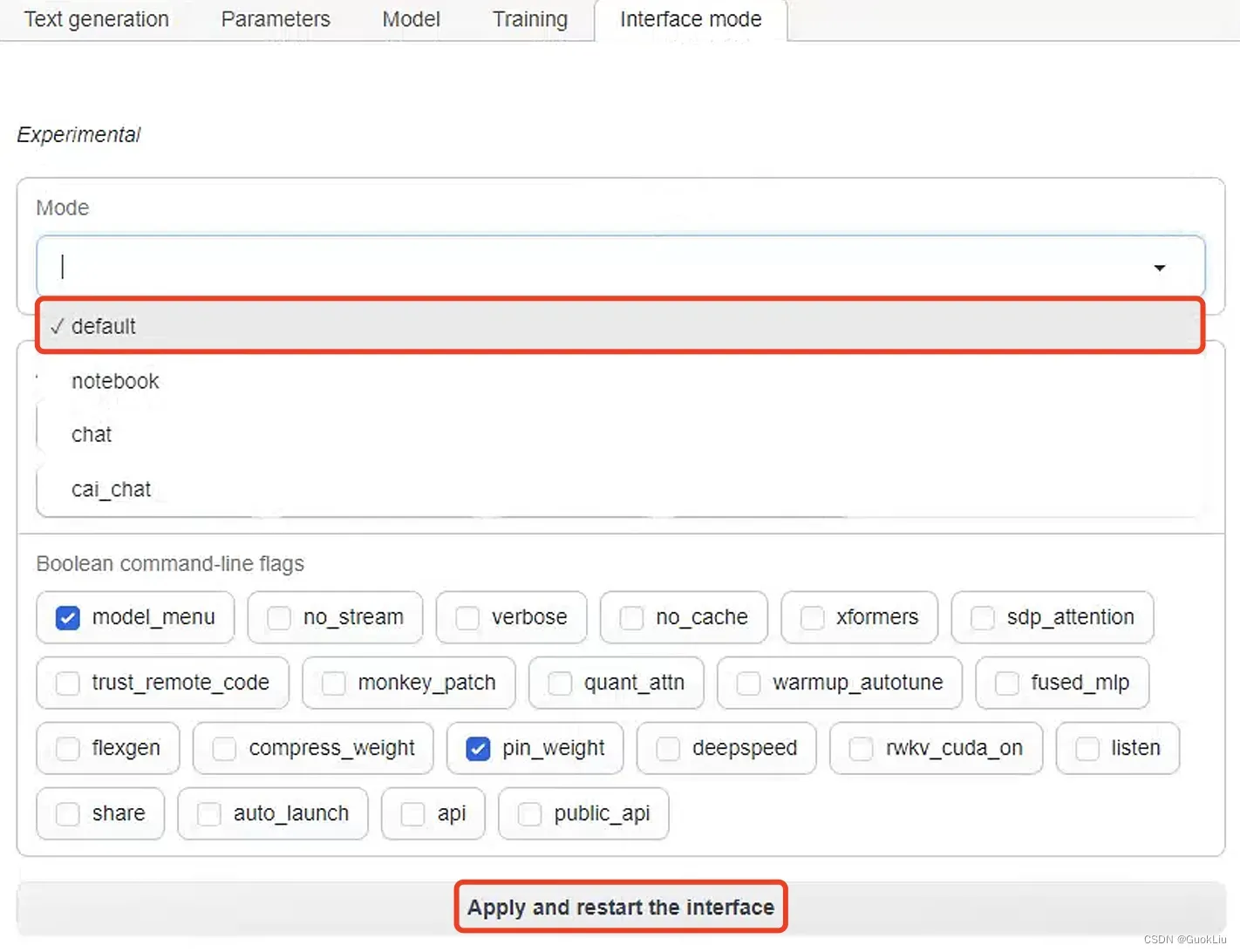

- 在最后的Tab面板选择default窗口可单独显示回答

-

修改对话窗口

-

输入提示词:

-

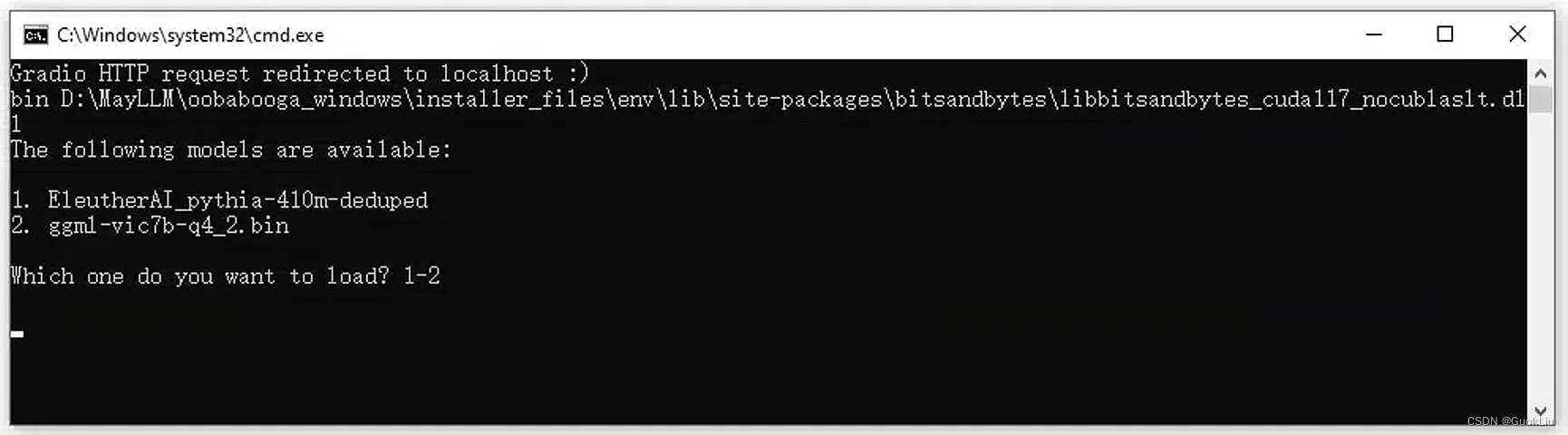

⚠️注意2: 有些下载的模型可能不匹配或不兼容,会报错,可以多试几个其它的模型,例如下面截图的第2个模型

参考资料

本文主要参考的是008与018:

VICUNA是一个开源GPT项目,对比最新一代的chat gpt4.0, 已经达到了它90%的能力。并且,我们可以把它安装在自己的电脑上!

这期视频讲的是,如何在自己的电脑上面安装开源的GPT模型VICUNA。

除此之外,我们还将给GPT模型配置一个友善的可视化界面 - OOBABOOGA!在上面可以聊天,训练,培养劳拉模型。。。

### 关于项目需要的硬件配置,信息和安装指示,可以在git hub网站上获取。

https://github.com/lm-sys/FastChat

### 文字链接:

https://www.notion.so/90-ChatGPT-VICUNA-OOBABOOGA-WEBUI-8ef428d225eb449a90982892b3827497

### 【错误提示】

1. 安装过程中途发生问题,中途退出或者无法继续安装:

删除oobabooga-windows文件夹里面的installer_files文件夹。点击install.bat重新安装;

2. WEBUI运行之后,出现Expecting value: line 1 column 1 (char 0),通常是因为开了代理。把代理关闭,重新启动start-webui.bat

3. webui可以正常进入,但是聊天时,电脑终端(CMD)提示 RuntimeError: CUDA out of memory。

修改start-webui.bat文件,以下这行,多加一个参数(--pre_layer 20),但是这样回答速度会变慢:

call python server.py --auto-devices --cai-chat --wbits 4 --groupsize 128 --pre_layer 20

GPT4ALL V.2重大升级 | CPU运行,商业许可证、一键安装、新UI、基于GPT-J新模型

开源AUTO-GPT:自主管理功能的GPT-4!| WINDOWS电脑安装和功能展示!

90%的ChatGPT功能?|CPU运行VICUNA开源人工智能模型 | WINDOWS电脑安装

在本地电脑运行的ChatGPT | 克隆大型GPT训练模型- 适用于 Mac/Windows/Linux | 基于LLAMA & GPT-3.5-TURBO开源项目

文章出处登录后可见!

已经登录?立即刷新