目录

- 简化流程

- 数据集存放样式

- 制作数据集流程

- 1. 获取数据集

- 2. 将make_txt.py和train_val.py写入根目录

- 3. 运行make_txt.py

- 4. 运行train_val.py

- 5. 删减文件夹的结构至需要格式

- reference

简化流程

得到数据集文件夹→修改文件夹名称并加入两个py文件→修改py文件→运行两个py文件→删减文件夹结构至所需结构

数据集存放样式

官网上有两种数据集的存放样式

- 传入数据集的txt文件,txt文件中保存的是图片的绝对路径。

由于在云端服务器训练的时候查到不到路径会报错。因此我并没有选择这种存放样式。

path: ../datasets/coco # dataset root dir

train: train2017.txt # train images (relative to 'path') 118287 images

val: val2017.txt # train images (relative to 'path') 5000 images

test: test-dev2017.txt

- 传入图片所在的文件夹,文件夹下直接存放jpg文件。这里选择这种方式来存储数据。

path: ../datasets/coco128 # dataset root dir

train: images/train2017 # train images (relative to 'path') 128 images

val: images/train2017 # val images (relative to 'path') 128 images

test: # test images (optional)

预计存放样式结构为:

|datasets

├— ——— mydata

│ ├── images

│ │ ├── train

│ │ └── val

│ └── labels

│ ├── train

│ └── val

└yolov5

制作数据集流程

1. 获取数据集

获取数据集分为自制数据集和在网上下载公共数据集

- 自制数据集:参考其他博主 https://blog.csdn.net/qq_45945548/article/details/121701492

- 下载公共数据集

一般下载的公共数据集文件结构如下:

└─VOC2028

├─Annotations---→all_xml更改文件夹的名称

└─images---→all_images如上

2. 将make_txt.py和train_val.py写入根目录

voc2028

├── all_images

├── all_xml

├── make_txt.py

└── train_val.py

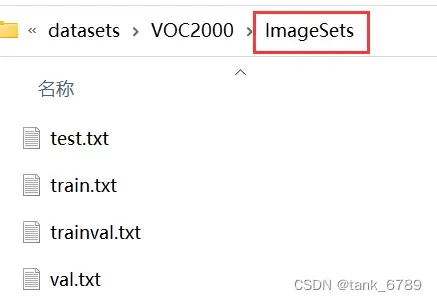

make_txt.py:将数据集按比例划分,得到4个txt文件存放对应数据的文件名(无后缀)。

import os

import random

trainval_percent = 0.9 # 训练集和验证集一共占所有数据的90%

train_percent = 0.9 # 训练集占训练集和验证集的90%

xmlfilepath = 'all_images'

txtsavepath = 'ImageSets'

total_xml = os.listdir(xmlfilepath)

num = len(total_xml)

list = range(num)

tv = int(num * trainval_percent)

tr = int(tv * train_percent)

trainval = random.sample(list, tv) #从所有list中返回tv个数量的项目

train = random.sample(trainval, tr)

if not os.path.exists('ImageSets/'):

os.makedirs('ImageSets/')

ftrainval = open('ImageSets/trainval.txt', 'w')

ftest = open('ImageSets/test.txt', 'w')

ftrain = open('ImageSets/train.txt', 'w')

fval = open('ImageSets/val.txt', 'w')

for i in list:

name = total_xml[i][:-4] + '\n'

if i in trainval:

ftrainval.write(name)

if i in train:

ftrain.write(name)

else:

fval.write(name)

else:

ftest.write(name)

ftrainval.close()

ftrain.close()

fval.close()

ftest.close()

train_val.py:用来将所有的xml文件all_xml转为txt文件并存放到all_labels文件夹,并生成训练所需架构。

# -*- coding=utf-8 -*-

import xml.etree.ElementTree as ET

import pickle

import os

import shutil

from os import listdir, getcwd

from os.path import join

sets = ['train', 'val', 'test'] # 如果不需要test就不写

classes = ['with_mask', 'without_mask', 'mask_weared_incorrect'] # 修改成自己数据集的类别

def convert(size, box):

dw = 1. / size[0]

dh = 1. / size[1]

x = (box[0] + box[1]) / 2.0

y = (box[2] + box[3]) / 2.0

w = box[1] - box[0]

h = box[3] - box[2]

x = x * dw

w = w * dw

y = y * dh

h = h * dh

return (x, y, w, h)

def convert_annotation(image_id):

in_file = open('all_xml/%s.xml' % (image_id),encoding='utf-8')

out_file = open('all_labels/%s.txt' % (image_id), 'w')

tree = ET.parse(in_file)

root = tree.getroot()

size = root.find('size')

w = int(size.find('width').text)

h = int(size.find('height').text)

for obj in root.iter('object'):

difficult = obj.find('difficult').text

cls = obj.find('name').text

if cls not in classes or int(difficult) == 1:

continue

cls_id = classes.index(cls)

xmlbox = obj.find('bndbox')

b = (float(xmlbox.find('xmin').text), float(xmlbox.find('xmax').text), float(xmlbox.find('ymin').text),

float(xmlbox.find('ymax').text))

bb = convert((w, h), b)

out_file.write(str(cls_id) + " " + " ".join([str(a) for a in bb]) + '\n')

wd = getcwd()

print(wd)

for image_set in sets:

if not os.path.exists('all_labels/'):

os.makedirs('all_labels/')

image_ids = open('ImageSets/%s.txt' % (image_set),encoding='utf-8').read().strip().split()

image_list_file = open('images_%s.txt' % (image_set), 'w',encoding='utf-8')

labels_list_file=open('labels_%s.txt'%(image_set),'w',encoding='utf-8')

for image_id in image_ids:

image_list_file.write('%s.jpg\n' % (image_id))

labels_list_file.write('%s.txt\n'%(image_id))

convert_annotation(image_id) #如果标签已经是txt格式,将此行注释掉,所有的txt存放到all_labels文件夹。

image_list_file.close()

labels_list_file.close()

def copy_file(new_path,path_txt,search_path):#参数1:存放新文件的位置 参数2:为上一步建立好的train,val训练数据的路径txt文件 参数3:为搜索的文件位置

if not os.path.exists(new_path):

os.makedirs(new_path)

with open(path_txt, 'r') as lines:

filenames_to_copy = set(line.rstrip() for line in lines)

# print('filenames_to_copy:',filenames_to_copy)

# print(len(filenames_to_copy))

for root, _, filenames in os.walk(search_path):

# print('root',root)

# print(_)

# print(filenames)

for filename in filenames:

if filename in filenames_to_copy:

shutil.copy(os.path.join(root, filename), new_path)

#按照划分好的训练文件的路径搜索目标,并将其复制到yolo格式下的新路径

copy_file('./images/train/','./images_train.txt','./all_images')

copy_file('./images/val/','./images_val.txt','./all_images')

copy_file('./images/test/','./images_test.txt','./all_images')

copy_file('./labels/train/','./labels_train.txt','./all_labels')

copy_file('./labels/val/','./labels_val.txt','./all_labels')

copy_file('./labels/test/','./labels_test.txt','./all_labels')

3. 运行make_txt.py

生成新文件夹:

4. 运行train_val.py

datasets

├── voc2000

│ ├── all_images

│ ├── all_labels # 第四步生成

│ ├── all_xml

│ ├── ImageSets # 第三步生成

│ │ ├── test.txt # 占所有数据的10%

│ │ ├── trainval.txt # train+val,占所有数据的90%

│ │ ├── train.txt # 90%*90%

│ │ └── val.txt # 90%*10%

│ ├── images

│ │ ├── train

│ │ └── val

│ ├── labels

│ ├── train

│ └── val

│ ├── images_train.txt # 存放图片名称(有后缀),方便使用第一种数据访问途径

│ ├── images_trainval.txt

│ ├── labels_train.txt

│ ├── labels_trainval.txt

│ ├── make_txt.py

│ └── train_val.py

5. 删减文件夹的结构至需要格式

|datasets

├ ——— mydata

│ ├── images

│ │ ├── train

│ │ └── val

| | |——test

│ └── labels

│ ├── train

│ └── val

| |——test

└yolov5

reference

链接: https://blog.csdn.net/weixin_48994268/article/details/115282688?(更改了这位博主在数据集划分上的程序)

文章出处登录后可见!

已经登录?立即刷新