目录

AI大模型的现状与发展是人工智能领域中备受关注的话题。近年来,随着计算能力的不断增强和数据规模的扩大,AI大模型的发展进入了一个高潮期,其中“百模大战”(Hundred-Model Battle)作为一个代表性事件,更是引起了业界和学术界的广泛关注。本文将探讨AI大模型的现状、发展趋势,以及其带来的影响和挑战。

一、AI大模型的现状与发展

AI大模型是指拥有数十亿到数万亿参数的深度学习模型,如GPT-3、BERT、T5等。这些大模型以其卓越的性能和通用性,成为了自然语言处理、计算机视觉等领域的标志性成果。它们可以在多种任务上展现出色,甚至在一些任务中超越了人类的表现。

-

巨型预训练模型:GPT-3是当前最著名的AI大模型之一,拥有1750亿个参数。通过预训练的方式,它可以“无监督”地从大规模文本数据中学习知识,并在各种任务上进行“零样本”学习,即不需要针对特定任务进行微调即可取得不错的效果。

-

预训练-微调范式:AI大模型的兴起,推动了“预训练-微调”范式在自然语言处理领域的广泛应用。预训练阶段大大提高了模型的通用性和迁移能力,微调阶段则使模型更好地适应特定任务。

-

应用领域扩展:AI大模型已经广泛应用于机器翻译、问答系统、自动摘要、文本生成、图像生成等多个领域。它们不仅在学术研究中取得了巨大成功,而且在工业界的实际应用也愈发广泛。

-

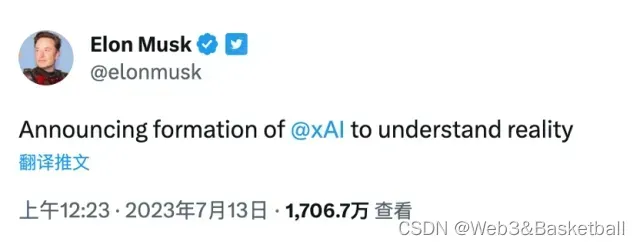

竞争激烈:AI大模型领域的竞争日益激烈。不仅有大公司如OpenAI、Google、Facebook等在推出超大模型,还有众多创业公司和研究机构也在尝试打破记录。其中,“百模大战”成为了衡量AI大模型性能的一个标杆性竞赛。

二、AI大模型的发展趋势

AI大模型的发展仍处于快速演进的阶段,未来几个方面将成为其发展的重要趋势:

-

规模持续增大:随着技术进步和硬件设备的不断升级,AI大模型的规模将继续增大。更大规模的模型能够提供更强大的语言理解和生成能力,但同时也会增加训练和推理的资源消耗。

-

多模态融合:AI大模型将更多地关注多模态融合,即同时处理文本、图像、音频等多种数据类型。这将进一步拓展大模型在跨领域任务上的适用性,提高模型的多样化应用能力。

-

联邦学习和隐私保护:AI大模型的发展面临着隐私和安全方面的挑战。为了处理海量数据,AI大模型可能需要借助联邦学习等技术,在不暴露用户敏感信息的前提下进行模型训练,以保护用户隐私。

-

网络架构优化:AI大模型的网络架构将持续优化,以提高模型的效率和训练速度。这包括改进Transformer结构,研究更加高效的Attention机制等。

三、AI大模型的影响与挑战

AI大模型的兴起带来了深远的影响,同时也面临一些挑战:

-

技术推动创新:AI大模型的发展推动了自然语言处理、计算机视觉等领域的技术创新。通过探索更大、更强大的模型,我们能够更好地理解人类语言和图像,并为其他领域带来新的突破。

-

智能应用拓展:AI大模型的应用拓展了人工智能在实际生活中的应用范围。例如,它们可以应用于智能客服、智能助手、智能翻译等场景,为用户提供更加智能化和便捷的服务。

-

资源消耗和环境影响:AI大模型的训练和推理需要大量的计算资源,这导致了巨大的能源消耗。为了推动AI大模型的发展,需要寻求更加环境友好的计算方案,以降低其对环境的影响。

-

伦理和社会问题:随着模型规模的增大,AI大模型带来了更多的道德和伦理问题,如信息真实性、隐私保护、模型偏见等。在推动AI大模型的发展时,需要谨慎权衡这些问题,确保技术的应用是可持续的、安全的,并且造福于整个社会。

结论:

AI大模型的现状与发展展现出了人工智能领域的蓬勃生机。随着技术的不断进步和创新,我们有理由相信AI大模型将在未来继续取得更加卓越的成就。然而,同时也需要认真思考其带来的挑战,包括资源消耗、隐私保护、伦理问题等,以确保其可持续发展并为人类社会创造更多积极的影响。通过全球社区的共同努力,我们可以推动AI大模型向着更加智能、高效和公平的方向发展,让人工智能更好地造福于人类。

各个AI大模型对比优缺点:

-

GPT-3:

优点:模型规模巨大,具有强大的通用性,可以用于多种任务,无需针对特定任务进行微调。

缺点:巨大的模型规模意味着训练和推理成本很高,且对计算资源要求很高。 -

BERT(Bidirectional Encoder Representations from Transformers):

优点:在预训练任务中采用双向Transformer架构,使其能够更好地理解上下文信息,适用于各种NLP任务。

缺点:相比于GPT-3,BERT在生成文本方面可能相对较弱。 -

T5(Text-to-Text Transfer Transformer):

优点:采用“文本到文本”框架,将不同的NLP任务转化为文本生成问题,统一了任务表述,有助于减少模型规模。

缺点:尽管相对于GPT-3减少了模型规模,但T5仍然需要大量的计算资源进行训练。 -

XLNet:

优点:解决了BERT中的“masking”问题,提供了更加全面和准确的预训练方法。

缺点:相比于BERT,XLNet的计算复杂度更高,训练时间更长。 -

RoBERTa:

优点:基于BERT进行改进和优化,通过更长的预训练和更大的批次尺寸来提高性能。

缺点:与BERT相似,RoBERTa在生成任务上可能相对较弱。

需要注意的是,每个大模型都有其特定的适用领域和任务,因此选择合适的模型取决于具体的应用场景和需求。随着技术的不断发展,AI大模型的规模和性能预计将继续提升,但同时也需要解决计算资源、能源消耗等方面的挑战。

文章出处登录后可见!