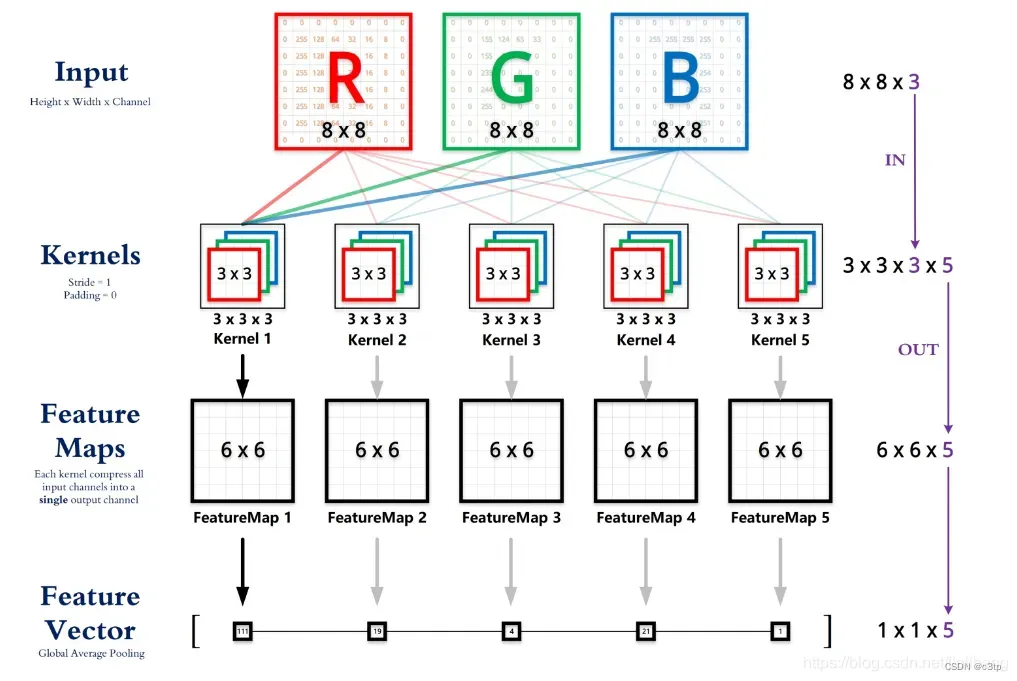

首先明确两点:

CNN的卷积核通道数 = 卷积输入层的通道数;

CNN的卷积输出层通道数 = 卷积核的个数;

1. 输入矩阵x格式:四个维度,依次为:样本数、图像高度、图像宽度、图像通道数

- 输入 x:[batch, height, width, in_channel] 四个维度

- 权重 w:[height, width, in_channel, out_channel]

- 输出 y:[batch, height, width, out_channel]

如图所示:

Input:batch=1、height=8、width=8、in_channel=3 (四维矩阵)

Kernels:卷积核大小 3×3 (决定输出层特征尺寸)

卷积核通道数:3 (RGB)

卷积核个数:5 (决定输出通道数)

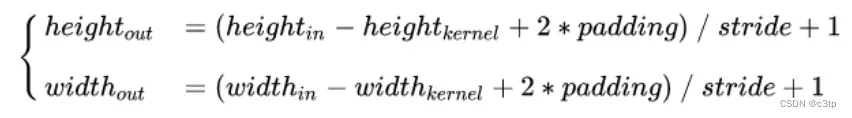

输出尺寸计算公式:

2.卷积过程示意图(注意偏执大小)

输入尺寸7×7,通道数3,2个卷积核w0和w1,大小都是3×3, 所以卷积核函数形式为3x3x3x2

pytorch查看通道数 维数 尺寸大小方式

查看tensor

x.shape # 尺寸

x.size() # 形状

x.ndim # 维数

pytorch中与维度/变换相关的几个函数

torch.size ():可用来查看变换后的矩阵的维度

>>>import torch

>>>a = torch.Tensor([[[1, 2, 3], [4, 5, 6]]])

>>>a.size()

torch.Size([1, 2, 3])

torch.view():把原本的tensor尺寸,转变为你想要的尺寸(-1代表自适应)

>>>b=a.view(-1, 3, 2)

>>>b

tensor([[[1., 2.],

[3., 4.],

[5., 6.]]])

>>>b.size()

torch.Size([1, 3, 2])

torch.squeeze()和torch.unsqueeze()

torch.squeeze() 这个函数主要对数据的维度进行压缩,去掉维数为1的的维度,比如是一行或者一列这种,一个一行三列(1,3)的数去掉第一个维数为一的维度之后就变成(3)行。

squeeze(a)就是将a中所有为1的维度删掉。不为1的维度没有影响。a.squeeze(N) 就是去掉a中指定的维数为一的维度。

还有一种形式b=torch.squeeze(a,N),即若a的N维为一则去掉。

>>> b.squeeze(2).size()

torch.Size([1, 3, 2])

>>> b.squeeze(0).size()

torch.Size([3, 2]))

torch.unsqueeze() 函数主要是对数据维度进行扩充。给指定位置加上维数为一的维度,比如原本有个三行的数据(3),在0的位置加了一维就变成一行三列(1,3)。

a.squeeze(N) 就是在a中指定位置N加上一个维数为1的维度。还有一种形式就是b=torch.squeeze(a,N) a就是在a中指定位置N加上一个维数为1的维度。

>>> b.unsqueeze(2).size()

torch.Size([1, 3, 1, 2])

>>> b.unsqueeze(2)

tensor([[[[1., 2.]],

[[3., 4.]],

[[5., 6.]]]])

torch.permute()

这个函数表示,将原始的tensor,按照自己期望的位置重新排序,例如原始tensor的第0、1、2维分别是1、3、2,那么当我执行permute(2, 0, 1),则将第三维放在最前,第一维放在中间,第二维放在最后,也就变成了2 * 1 * 3,注意这里表示的维数的index,而不是具体几维:

>>>b

tensor([[[1., 2.],

[3., 4.],

[5., 6.]]])

>>> b.permute(2, 0, 1)

tensor([[[1., 2.],

[3., 4.],

[5., 6.]]])

>>>b.size()

torch.Size([2, 1, 3])

文章出处登录后可见!