目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导: https://blog.csdn.net/qq_37340229/article/details/128243277

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯毕业设计-基于生成对抗网络的图像风格迁移

课题背景和意义

图像风格迁移是目前计算机视觉领域的研究热点。风格迁移的目的是将一幅图像转换 成另一幅或多幅具有特定目标的图像,例如:输入一张纯色马的图片,输出的是斑马的图 片;输入一张油画的图片,输出的是中国画的图片等等。图像风格迁移不仅可以显著降低 获取相关数据集的成本,而且还可以创建源数据以外的新图像,所以利用生成模型扩大研 究数据集可有效提高深度学习网络模型的训练质量。 Goodfellow 等提出一种生成对抗网络模型,该模型由生成网络和判别网络组成,这 两个网络在互相博弈的过程中优化彼此。随着判别网络的辨伪能力不断增强,生成网络产 生的数据将更接近真实数据,生成对抗网络与其他网络相比具有更好的数据生成能力,因 此生成对抗网络在图像生成和风格迁移领域得到了广泛应用。生成对抗网络(Generative Adversarial Network, GAN)可以生成和真实图像较接近的 生成图像。作为深度学习中较新的一种图像生成模型,GAN 在图像风格迁移中发挥着重要 作用。

实现技术思路

一、相关工作

BicycleGAN

生成对抗网络的思想是利用博弈不断优化生成器和判别器从而使得生成的图像更加逼近 真实样本,在图像风格迁移领域已经证明了生成对抗网络在图像合成中的巨大潜力。

传统 的图像风格迁移模型都是输入一张图片只能产生一种风格,缺乏多样性。为了避免输出的 单一性,由 Zhu 等提出的 BicycleGAN 网络模型,首次尝试输入图像可以得到多种对应样 式的输出图像,强制生成器不得忽略噪声,使用噪声来获得样化的图片。 BicycleGAN 的模型结构如图所示。

残差块

在深度学习中,网络的层数越多,意味着能够提取到的特征越丰富,并且越深的网络 提取的特征越抽象、越具有语义信息,但如果简单地增加深度,会导致退化问题。随着 网络层数增加,在训练集上的准确率趋于饱和甚至下降。为了解决这种退化现象,ResNet 被 He 等提出,其结构如图所示。

残差网络的思想就是将网络学习的映射从 X 到 Y 转为 学习从 X 到 Y-X 的差,然后把学习到的残差信息加到原来的输出上即可。即便在某些极端 情况下,这个残差为 0,那么网络就是一个 X 到 Y 的恒等映射。残差块一个通用的表示方式是:

注意力机制

人的眼睛可以有选择性地看自己关注的事物,从而忽略一部分不感兴趣的信号,重点 聚焦自己感兴趣的事物,这就是注意力机制。注意力机制能够使得模型在生成图片过程中 可以自己关注不同特征区域。

如图所示,输入数据通过卷积初始化,使用数量为 C/K (k=8) 且大小为 1×1 的卷积核来对输入数据执行卷积运算,以获得特征图 f(x)和 g(x),使用一个数 1量为 C 且大小为 1×1 的卷积核对输入数据执行卷积运算以获得特征图 h(x)。经过局部自我 注意特征图计算,重新调整特征图尺寸。

其数学表达式如下:

在局部信息的基础上增加全局信息得到:

![]()

注意力层的最终输出:

![]()

谱归一化

谱归一化 (Spectral normalization ,SN)通过限制每一层的频谱范数来约束判别器的 Lipschitz 常数,从而提高生成对抗网络的稳定性。谱归一化与其他归一化方法相比计算成 本较小,不需要额外的超参数调整。它通过约束判别器 D 中每层 f 的权重矩阵的 L2 矩阵范 数来控制 Lipschitz 常数。对于线性层 f(x)=Wx,给出了它的 Lipschitz 范数如式所示。根 据定义,其中𝜎(𝑤)代表矩阵 W 的 L2 矩阵标准,它也等于 W 的最大奇异值。

如果为每层选择的激活函数 a 的 L i p s c h i t z 范数为 1,根据范数相容性,可以获得判 别器 D 中的 L i p s c h i t z 范数的边界,如不等式,其中 L 是 D 的层数。

![]()

因此,需要一种频谱归一化方法来确保𝜎(𝒘)始终等于 1,谱归一化如等式所示:

二、基于生成对抗网络的风格迁移模型

生成器模型

本文改进和优化了原始 GAN 的生成器部分,引入残差块和自注意力机制,使得在图像 风格迁移过程中生成图像的真实性有较大提高,改善了生成图像的质量。所设计的生成器由 编码器、转换器、解码器三部分组成, 编码器由卷积神经网络组成、转换器由自注意力机 制网络层与残差网络块结构组成、解码器由反卷积神经网络组成,生成器网络如图所示。

整个生成器的网络结构参数配置如表所示,编码器和转换器使用实例归一化 (Instancenormalization, IN)[10] 和 ReLU 激活函数,解码器最后一层使用 Tanh 激活函数。自 注意力机制有助于在图像的相邻区域之间建立长期的、多层次的依赖关系。通过在生 成器中引入自注意力机制,更好地在局部依赖基础上增加全局依赖,这有助于生成器合成 更逼真的风格迁移图像。

![]()

在生成器中对真实图像 B 进行编码,以提供潜在矢量的真实样本并从中进行采样。首 先使用生成器从随机噪声中生成伪图像 𝐵̂,然后对𝐵̂进行编码,最后计算其与输入随机噪 声差异。向前计算步骤为首先随机产生一些噪声,然后串联图 A 以生成伪图像 𝐵̂ ,将真 实图片 B 编码为多元高斯分布的潜在编码,然后从它们中采样以创建噪声输入,再用同样 的编码器将伪图像 𝐵̂ 编码为潜矢量。最后,从编码的潜矢量中采样,并用输入噪声 Z计算 损失。损失函数为式子。

判别器模型

本文判别器网络采用 Wang 等提出的 PatchGAN 作为模型的判别器,用来对输入的 生成图片与真实图片进行真伪判别。判别器网络如图所示。

PatchGAN 将输入的图像划分为 70×70 的多个小块,小块代表输入图像的感受野,然后 对每个图像块进行真伪判断,其输出二维矩阵中每一个元素的值表示每个图像块是真实样 本的概率,每个图像块真实概率的平均值作为最终整体图像的判定结果。该判别器可以很 大程度上保持图像的高分辨率和细节。为了缓解梯度消失从而增加模型的稳定性,本文在 判别器每层卷积后面加入谱归一化。判别器的网络结构如表所示。

感知损失

Johnson 等利用感知损失可以增强图像细节。为了生成图像的真实视觉效果,本文使 用感知损失来优化生成网络。感知损失依赖训练的 VGG16 模型提取图像高级特征,先提取 生成图像和原始图像的特征,然后计算它们之间的差异。为了最大限度地减少细节的丢失, 应用感知损失来提高细节保护能力,如等式所示:

![]()

三、实验与结果分析

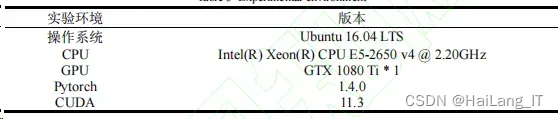

实验平台与数据集

本文实验环境如表所示。

实验结果

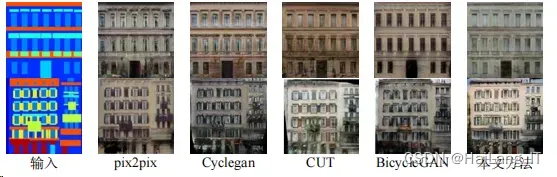

在 Facades 和 AerialPhoto&Map 数据集上分别进行了图像风格迁移实验。为了验证本文 方法的有效性,将本文方法的实验结果与 pix2pix、Cyclegan、CUT、BicycleGAN 进行了对 比。

1、在 Facades

数据上实验结果 Facades 数据集上的实验结果如图所示,目的是将输入语义图还原为真实建筑图像。 图中第 1 列是输入的建筑语义图像,第 2、第 3、第 4 和第 5 列分别为 pix2pix 模型、 Cyclegan模型、CUT模型和 BicycleGAN模型的图像风格迁移实验结果,第 6列为本文方法 的实验结果。

2、AerialPhoto&Map

数据集实验结果 AerialPhoto&Map 数据集上的实验结果如图所示,目的是将输入语义图还原为真实航 拍卫星图像。图中第1列是输入的地图语义图像,第 2、第 3、第 4 和第 5 列分别为 pix2pix 模型、Cyclegan 模型、CUT 模型和 BicycleGAN 模型的航拍卫星图像风格迁移实验 结果,第 6 列为本文方法的实验结果。

评价指标

为了客观地反映不同模型的生成图像的效果,采用峰值信噪比(PSNR)和结构相似性 (SSIM)指标来评价生成图像。这两个指标常用于作为图像处理的评价指标。两幅图像之间 较高的 PSNR 值表示生成图像和原始图像之间失真较小,即生成图像质量较高。

SSIM 是一种度量两个图像相似性的标 准。通过将模型绘制的图像与原始彩色图像进行比较,验证了该算法的有效性和准确性。 计算公式如下:

在 Facades 数据集和 AerialPhoto&Map 数据集上的实验数据 PSNR 分数如表所示。

SSIM 分数如表所示。

![]()

![]()

四、总结

传统的 BicycleGAN网络模型在图像风格迁移过程中图像细节不清晰,训练不稳定,有 时会出现梯度爆炸的现象。本文对 BicycleGAN进行了改进,在生成器中引入残差块,改善 模型训练的退化现象,利用自注意力机制获得更多的图像特征,使得生成图像更接近真实 图像。在判别器中引入谱归一化,提高训练稳定性,提升判别能力。

实现效果图样例

风格迁移图像:

我是海浪学长,创作不易,欢迎点赞、关注、收藏、留言。

毕设帮助,疑难解答,欢迎打扰!

最后

文章出处登录后可见!