学习率的概念

这里的学习率指的是深度学习神经网络训练过程中选取的一个超参数。

学习率作为参数更新时的一个乘数项,可以影响网络训练的速度,或者说是每次迈步的大小。

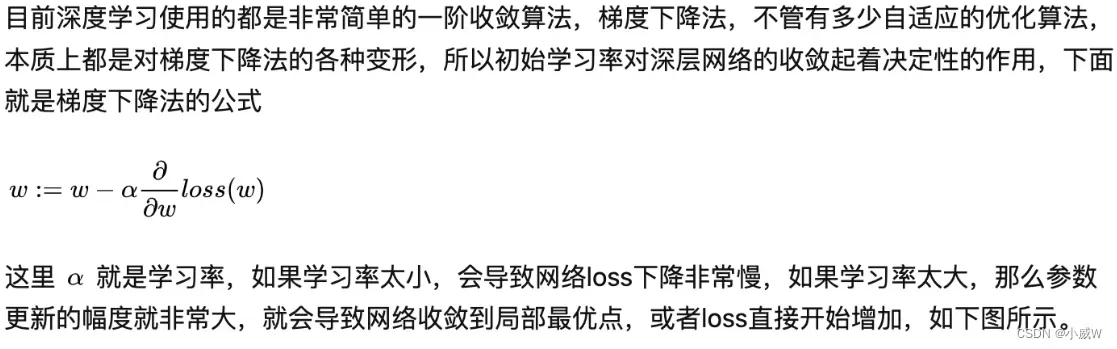

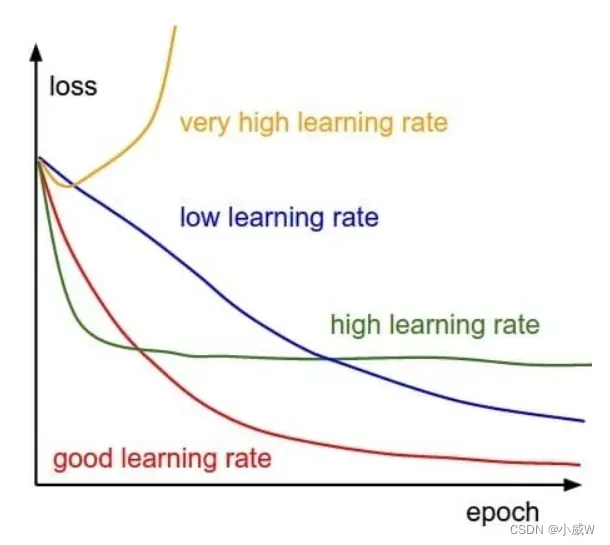

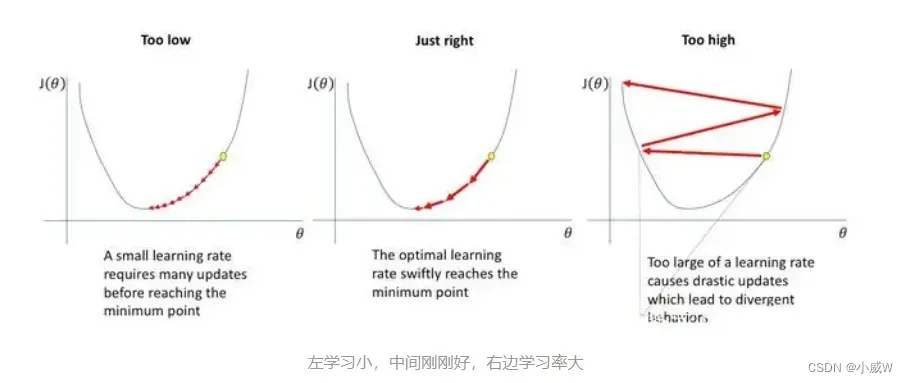

可以这样理解,如果学习率过大,那么步子就会很大,容易越过了正确答案,从一个错误到另一个错误;如果学习率过小,那么步子就很小,训练很慢,而且不容易跳出局部最优解。如下图所示。

可以看出小学习率会进入局部最优解中,但是它也跳不出去。大的学习率无法进入局部最优,甚至随着训练越来越坏。

学习率的选择方法

学习率的选择更多的依靠经验。那么除了经验之外呢?

https://arxiv.org/abs/1506.01186

上面的论文提出了一种方法来寻找初始学习率。

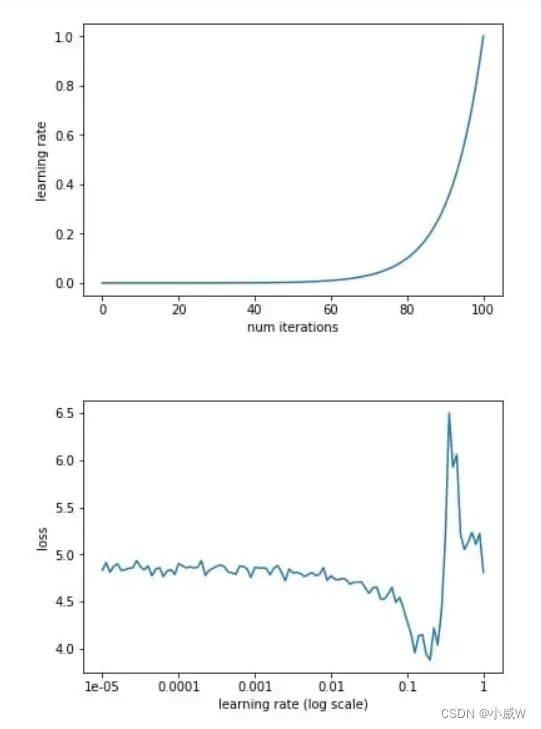

即

首先我们设置一个非常小的初始学习率,比如1e-5(还可以更小),然后在每个batch之后都更新网络,同时增加学习率,统计每个batch计算出的loss。最后我们可以描绘出学习的变化曲线和loss的变化曲线,从中就能够发现最好的学习率。

从上面的图片可以看到,随着学习率由小不断变大的过程,网络的loss也会从一个相对大的位置变到一个较小的位置,同时又会增大,这也就对应于我们说的学习率太小,loss下降太慢,学习率太大,loss有可能反而增大的情况。从上面的图中我们就能够找到一个相对合理的初始学习率,0.1。

之所以上面的方法可以work,因为小的学习率对参数更新的影响相对于大的学习率来讲是非常小的,比如第一次迭代的时候学习率是1e-5,参数进行了更新,然后进入第二次迭代,学习率变成了5e-5,参数又进行了更新,那么这一次参数的更新可以看作是在最原始的参数上进行的,而之后的学习率更大,参数的更新幅度相对于前面来讲会更大,所以都可以看作是在原始的参数上进行更新的。正是因为这个原因,学习率设置要从小变到大,而如果学习率设置反过来,从大变到小,那么loss曲线就完全没有意义了。

另外还有两种方法见参考资料一。

参考资料

https://baijiahao.baidu.com/s?id=1662117095018026462&wfr=spider&for=pc

https://blog.csdn.net/m0_37789876/article/details/85248565

https://blog.csdn.net/u010087338/article/details/122949354

https://zhuanlan.zhihu.com/p/31424275

文章出处登录后可见!