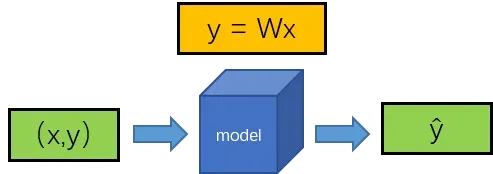

图1 模型输入输出图

图1简单描述了神经网络的整体情况,输入为(x,y),经过映射f:y= Wx后,得到预测值。神经网络训练过程就是希望得到函数y=Wx,能够使得y值尽可能得接近真实情况,显然这个训练过程的核心在于寻找合适的参数W.

参考《深入浅出图神经网络》,给定样本(x,y),前向传播可以得到输出,对应的损失值为

,其中L为损失函数(具体可参阅以前的文章深入浅出图神经网络》阅读笔记-第2章 图神经网络基础(1))。

符号说明:

是第l层的输出,

是第l层的输入,第l-1层的输出

经过激活函数的输出,

是第l层的偏差输入。

一般来说:,对于第一层:

随后的反向传播推理步骤如下:

1、使用链式法则求参数矩阵:的梯度

:

=

2、定义误差项-该误差项衡量了

对损失值的影响,之后使用链式法则:

3、基于公式且

可得:

是哈达玛积,是一种对应元素想成的二元运算符。

是激活函数的导数。从式子中可以看出第一层的误差与第l+1层的误差有关,这就是反向传播的来源。

4、对于可以得到:21

5、对于偏置项d的导数:

文章出处登录后可见!

已经登录?立即刷新