文章目录

LLM大模型Agent剖析和应用案例实战

1 从 LLM 大模型到智能体演进技术

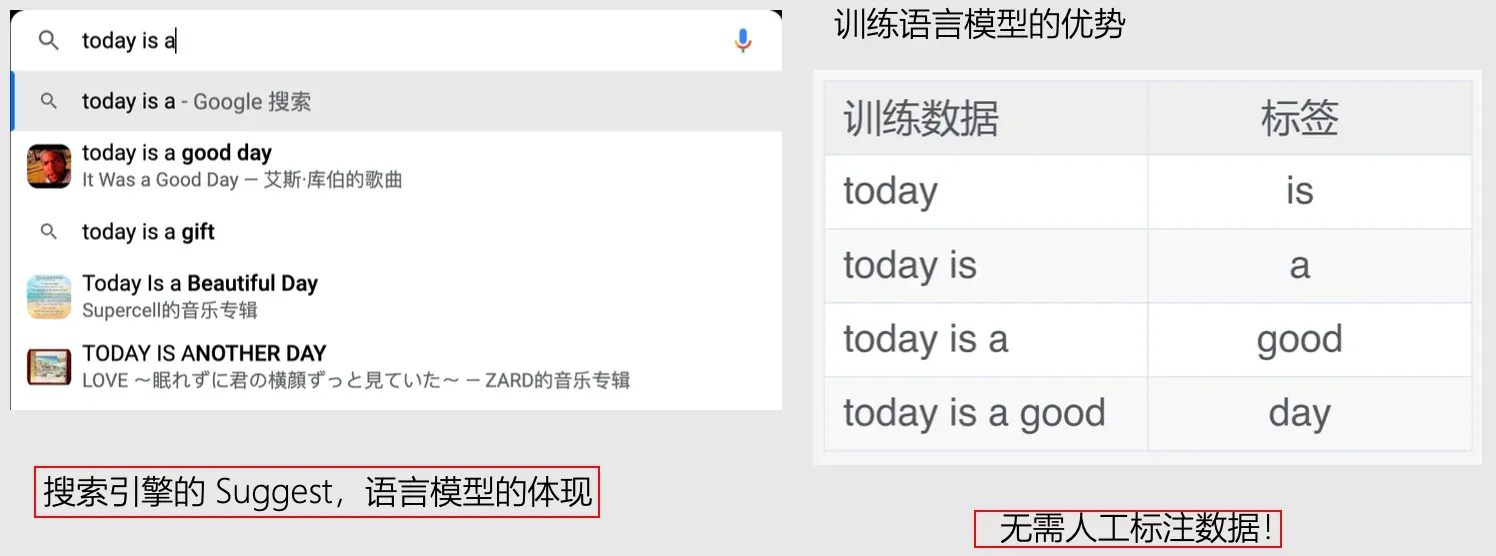

语言模型是什么?

- 语言模型:给定一些字或者词(称为 token),预测下一个字或者词的模型。

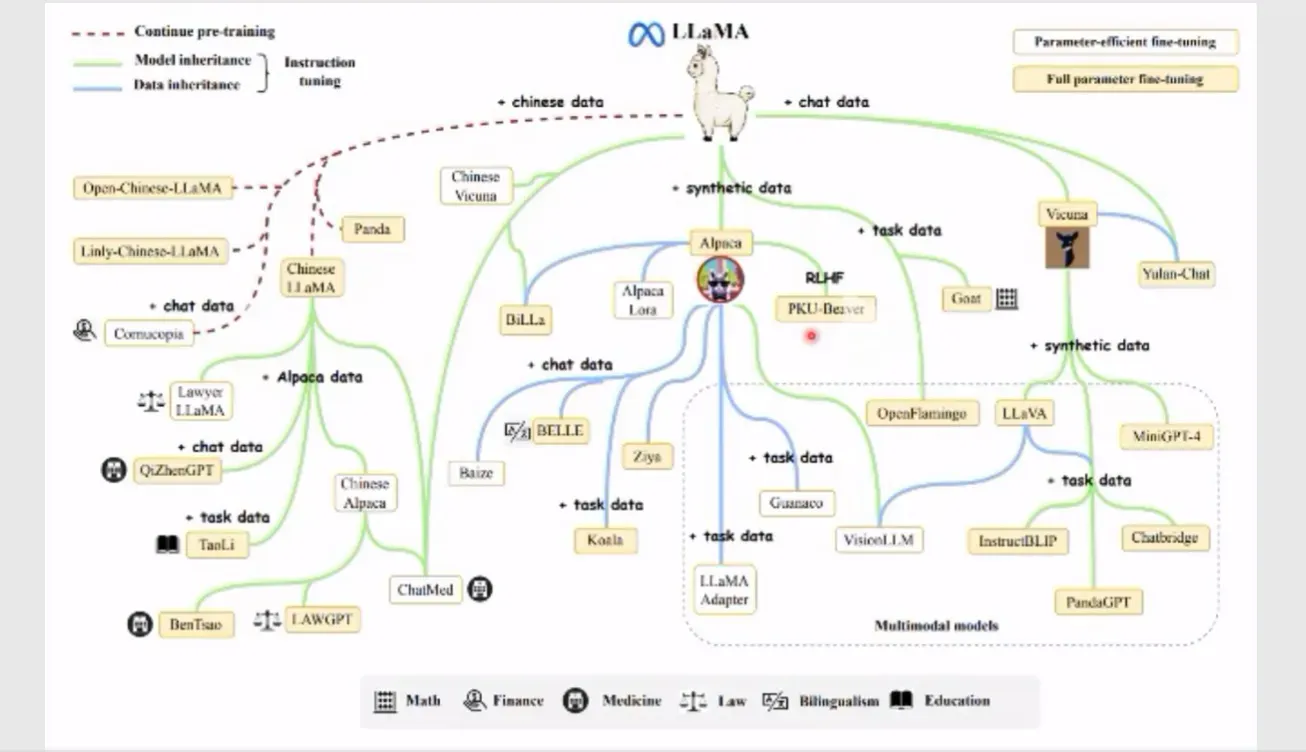

大语音模型是什么?

- 大语言模型(Large Language Model, LLM)是一类基于深度学习的语言模型,它们在大量的文本数据上进行训练,可以完成各种任务,包括代码编写、总结、翻译等。LLM 的特点是规模庞大,包含数十亿的参数,帮助它们语言数据中的复杂模式。

大语言模型日新月异

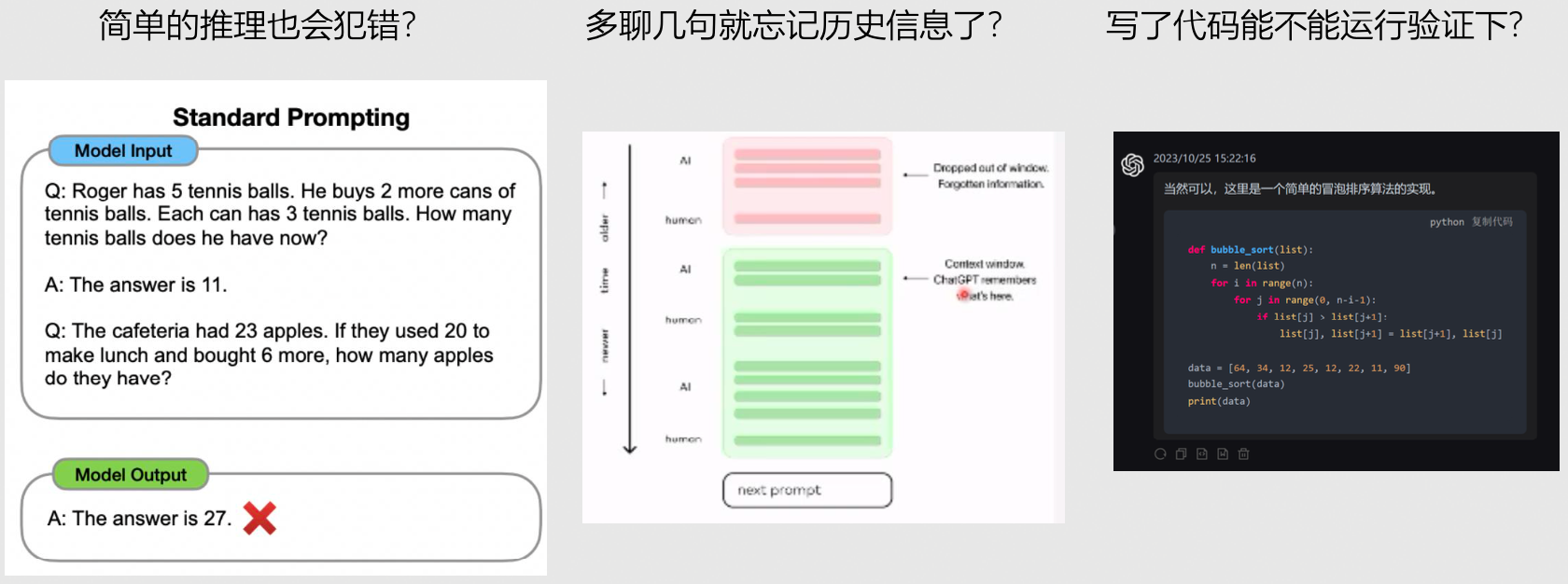

LLM大模型存在局限性

- 简单的推理也会犯错?

- 多聊几句就忘记历史信息了?

- 写了代码能不能运行验证下?

- …

LLM Agent来势凶凶

- Agent = LLM(大语言模型,就好比人的大脑) + Plan(规划能力)+Memory(记忆能力)+Tools(工具使用能力)

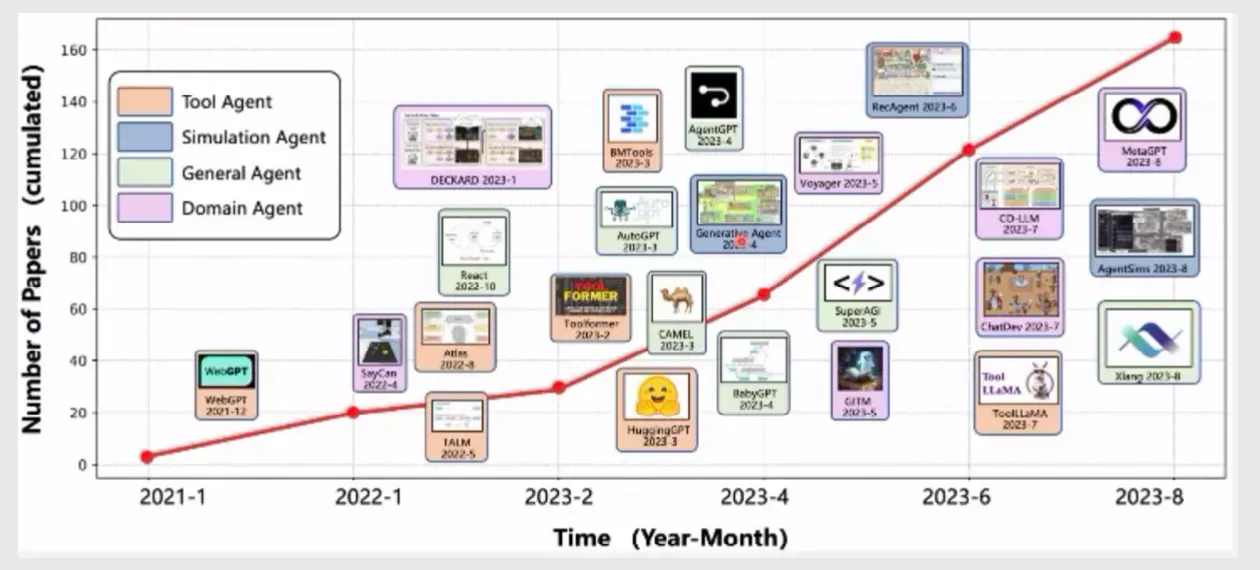

LLM Agent增长迅猛

LLM Agent是什么?

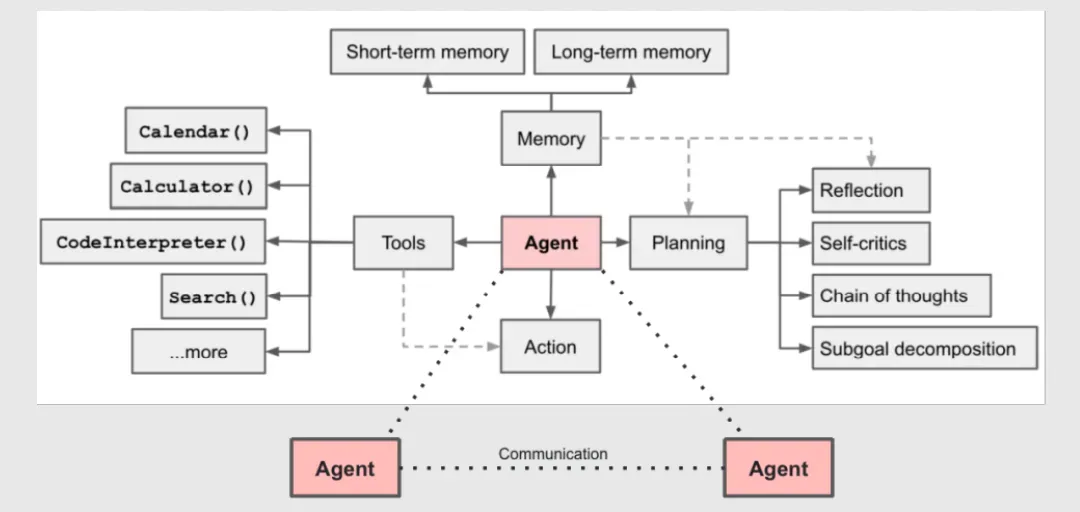

- LLM Agent 可以理解为一个以 LLM 为大脑的智能体(类比人),集成了规划、记忆、工具使用等能力。

- 规划能力

- 既然 LLM 难以直接处理复杂任务,一个直接的思想就是将任务进行拆解,通过实现几个小目标从而实现一个目标。此外,LLM Agent 可以对过去的行为自我批判和反思,从错误中吸取教训,并对未来的行为进行改进,从而提升最终的效果。

- 记忆能力

- 既然 LLM 的上下文有限,扩展其记忆能力肯定不可或缺。

- 工具使用能力

- 如果能够让 LLM 既能帮你写代码,还能帮你跑代码,那这样一个智能体的发挥空间就取决于你的想象力了。

- 规划能力

LLM Agent 可以理解为一个以 LLM 为大脑的智能体(类比人),集成了规划、记忆、工具使用等能力。

2 LLM Agent 架构深度剖析

规划能力是什么?

- 规划能力,本质上希望激发 LLM 的最大潜能,“引导”或者“提示” LLM 更好地回答问题,因为规划能力很大一部分还在 Prompt Engineering 上。

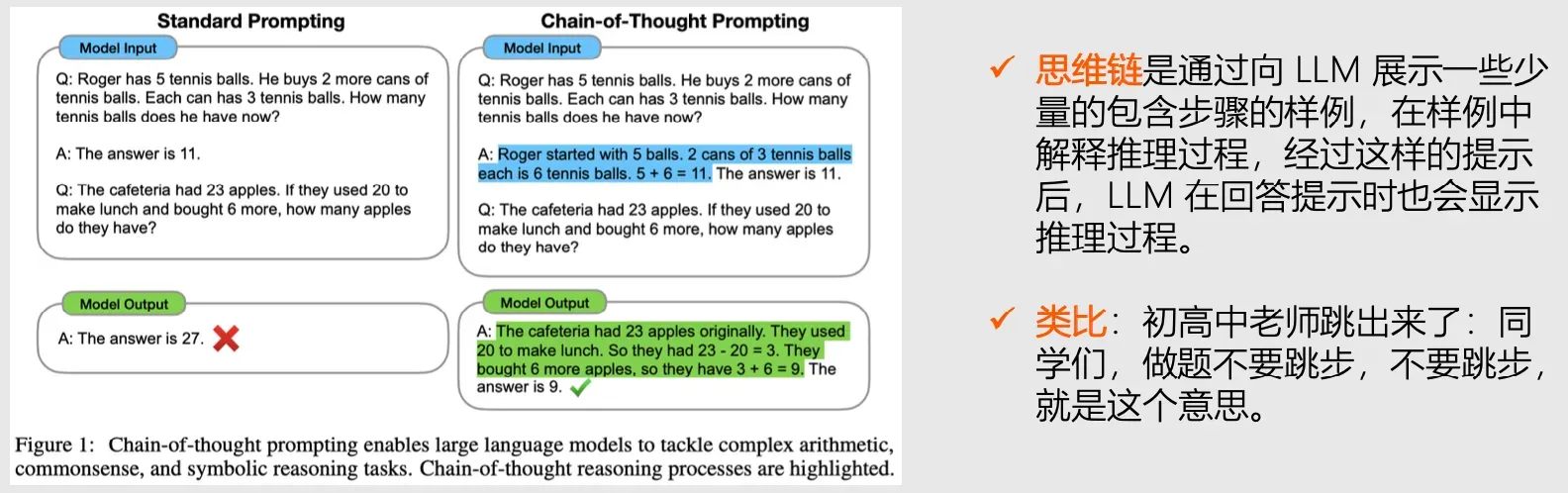

【方式一】任务拆解

- 就是把任务分成一步一步来执行,一步一步像一条链吗?——CoT 思维链

CoT任务拆解的缺陷是什么?

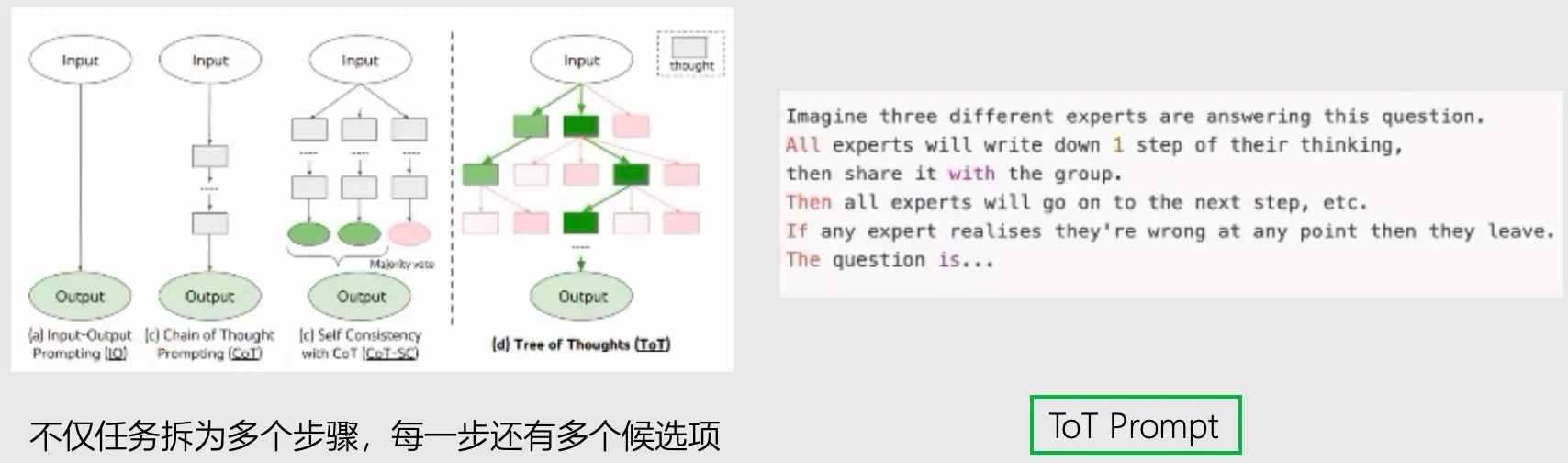

- 链式任务拆解方式可能忽略一些潜在情况,因为一步之后只能选择往下一步,没有多种选择余地。

任务拆解三种方式

- 让 LLM 自己来拆解,比如前面的 ToT Prompt,还有常见的拆解 Prompt,“Step for XYZ”等

- 任务相关的引导,比如写小说,可以让 LLM 写一个小说的大纲 “Write a story outline.”

- 用户自己分解任务,类似 CoT,自己写出满意的步骤再让 LLM 来模仿

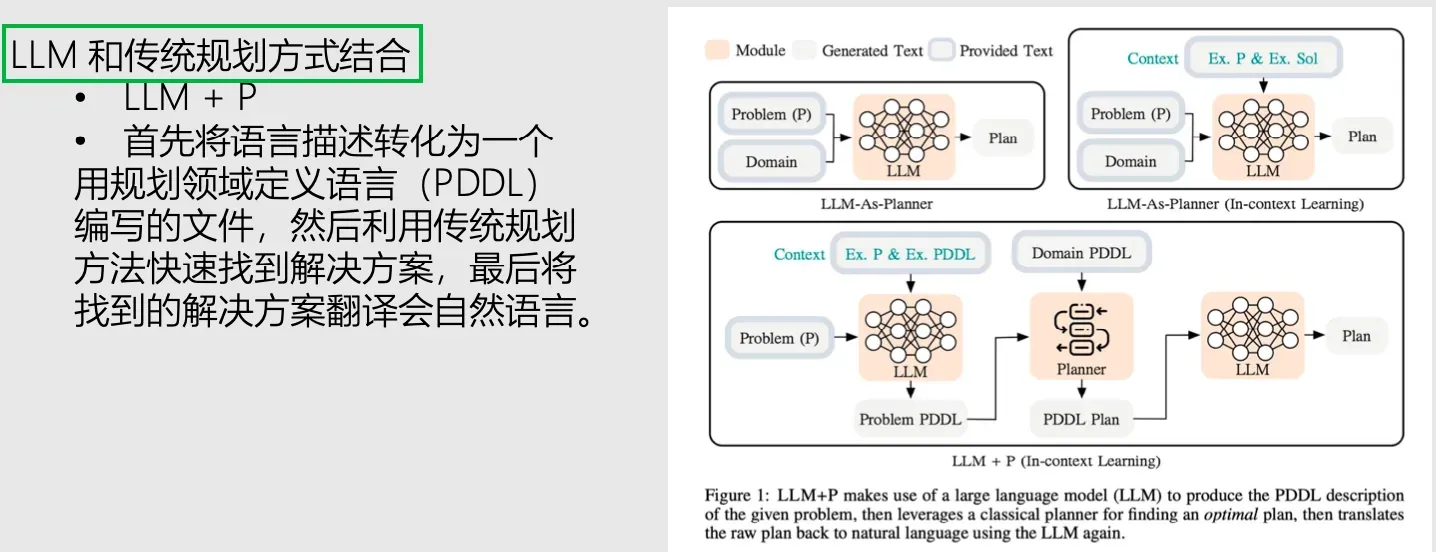

LLM和传统规划方式结合

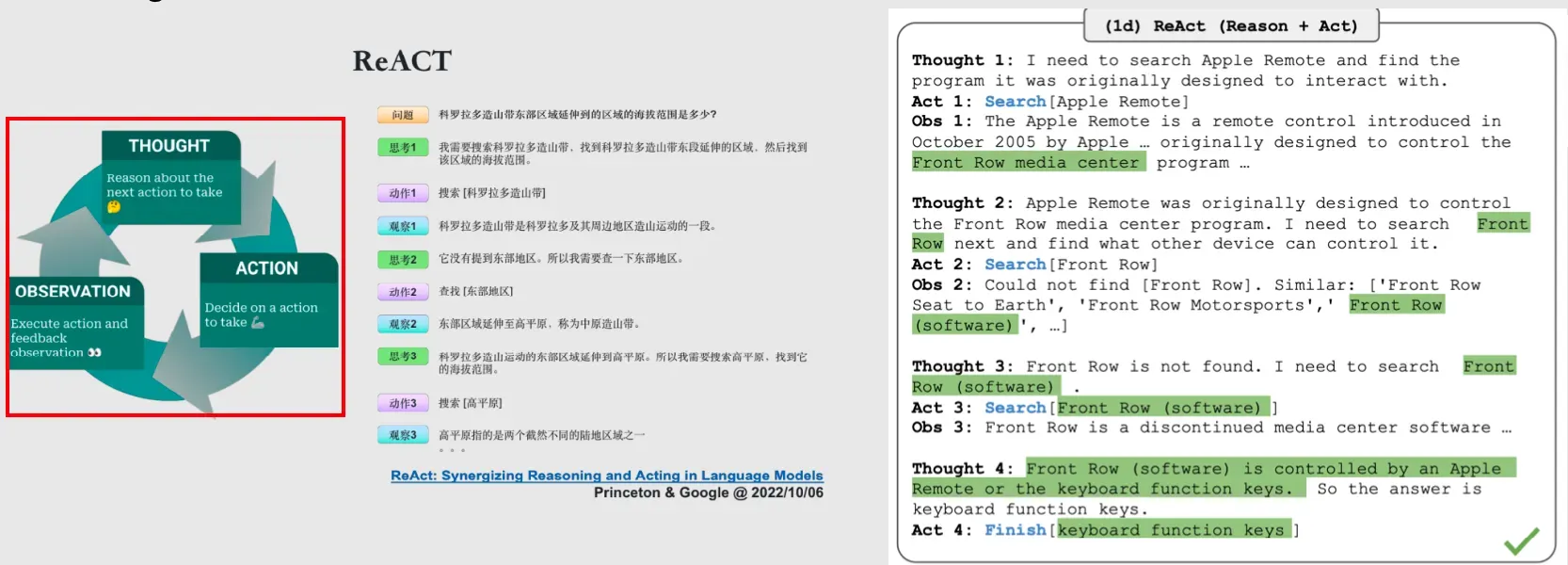

【方式二】自我反思

- 当我做事情时,做对或者做错都会让我们思考怎么做得更好

- 从 Agent 的角度出发,接收一个观测(Observation),给出一个动作(Action)(强化学习的感觉)

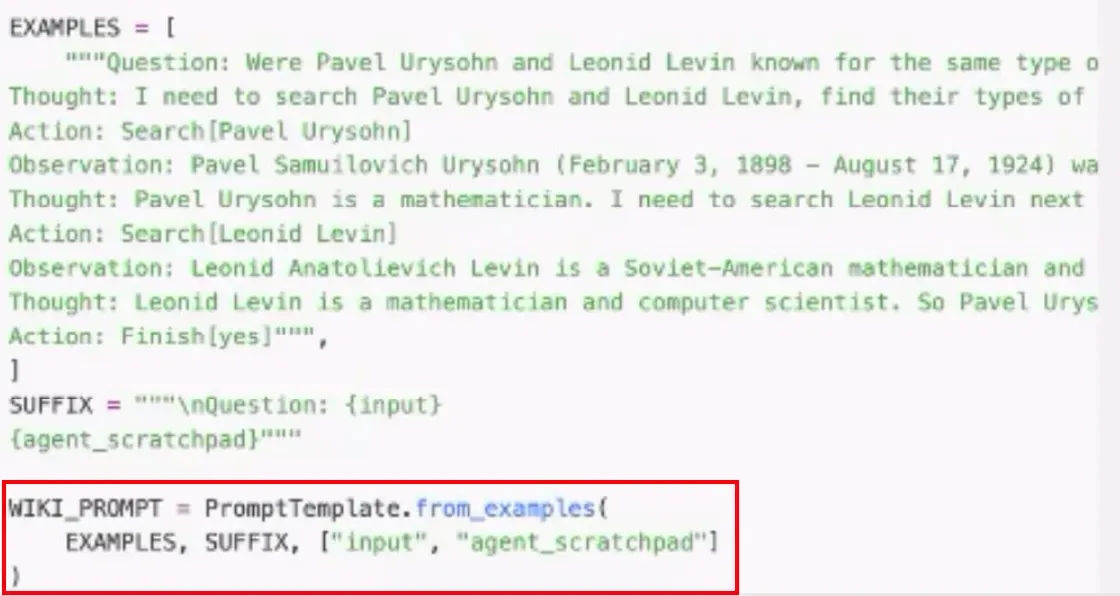

- 告诉 LLM 应该按照“思考-行动-观测”的方式来获得最终的回答

- few-shot Learning + 提供 thought

举个🌰

记忆能力是什么?

LLM的记忆是什么?

- 训练数据 -> 模型参数(fixed) —— 长期记忆

- 上下文提示(Context),我们喂给 LLM 信息的地方—— 短期记忆

- 记忆容量(上下文长度)有限,“按需投喂”:先存后取

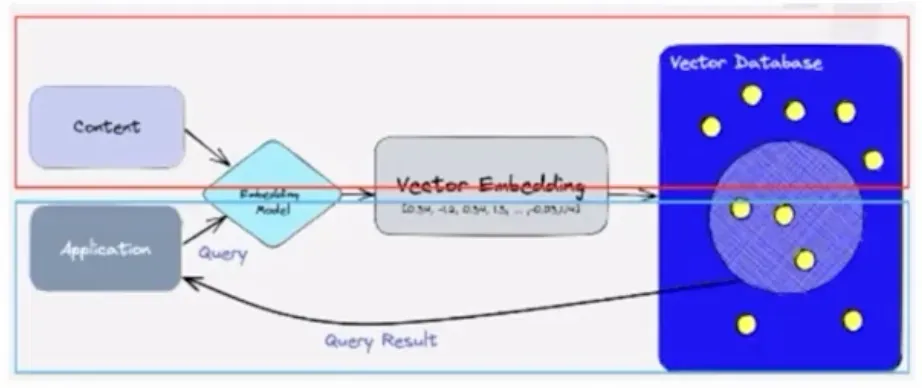

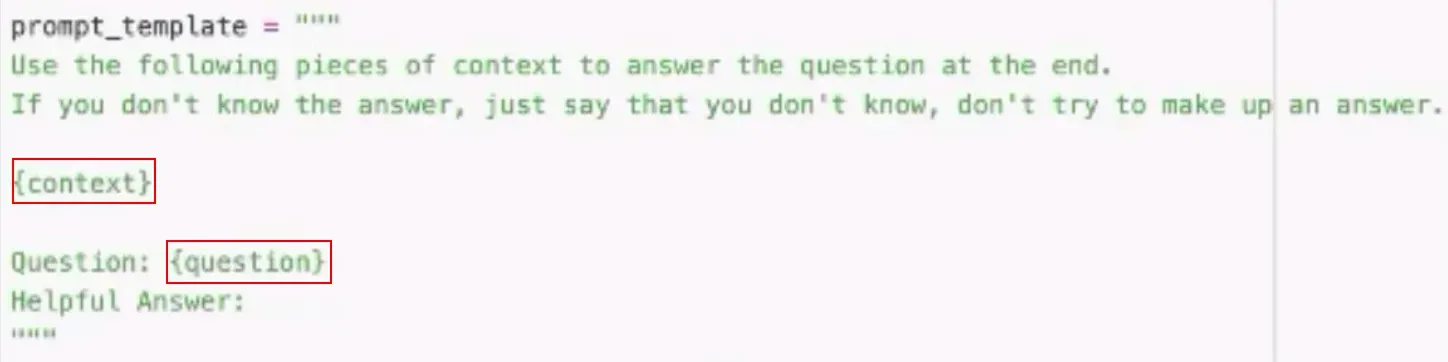

LLM + 向量数据库

- 存 -> 向量数据库的核心思想是将文本转换成向量(Embedding),然后将向量存储在数据库中。

- 取 -> 讲用户输入的问题转成向量,然后在数据库中国检索最相似的向量,以及向量对应的文本(记

忆),返回给 LLM,生成回答。

举个🌰

当“记忆”非常多时,如何在大量“记忆”力快速找到最相关的那些“记忆”?

- 近似最近邻(Approximate Nearest Neighbor)

- 牺牲了精度,换取了速度

- ANN 多种实现:局部敏感哈希、乘积量化等

- 核心思想通过某种方式,将数据的特征压缩或分组,在搜索时,只需在部分数据中寻找最近邻

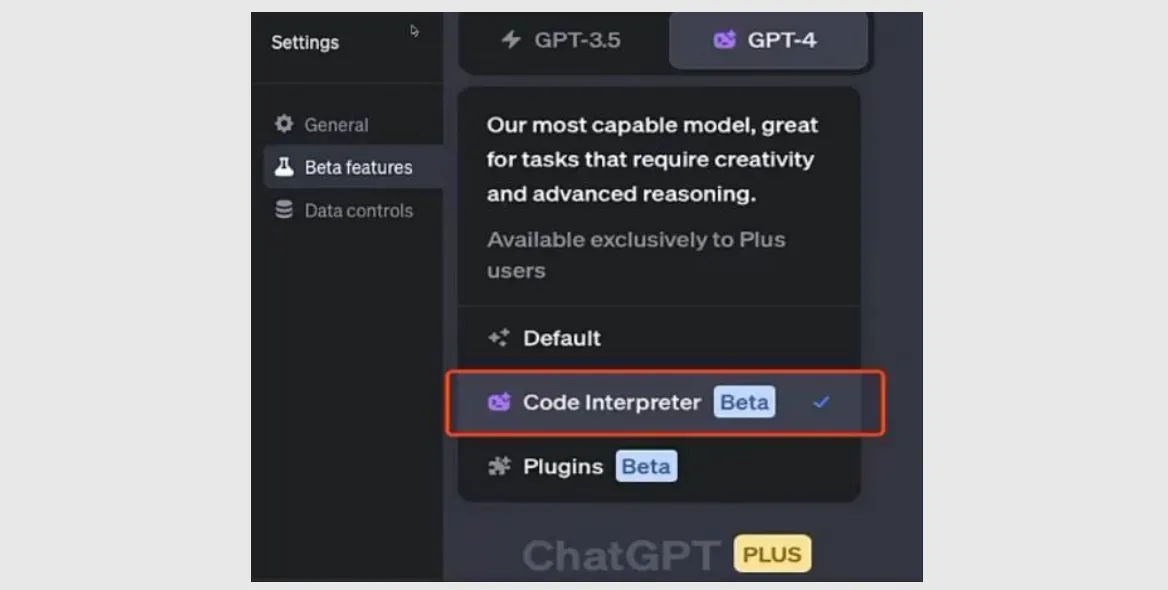

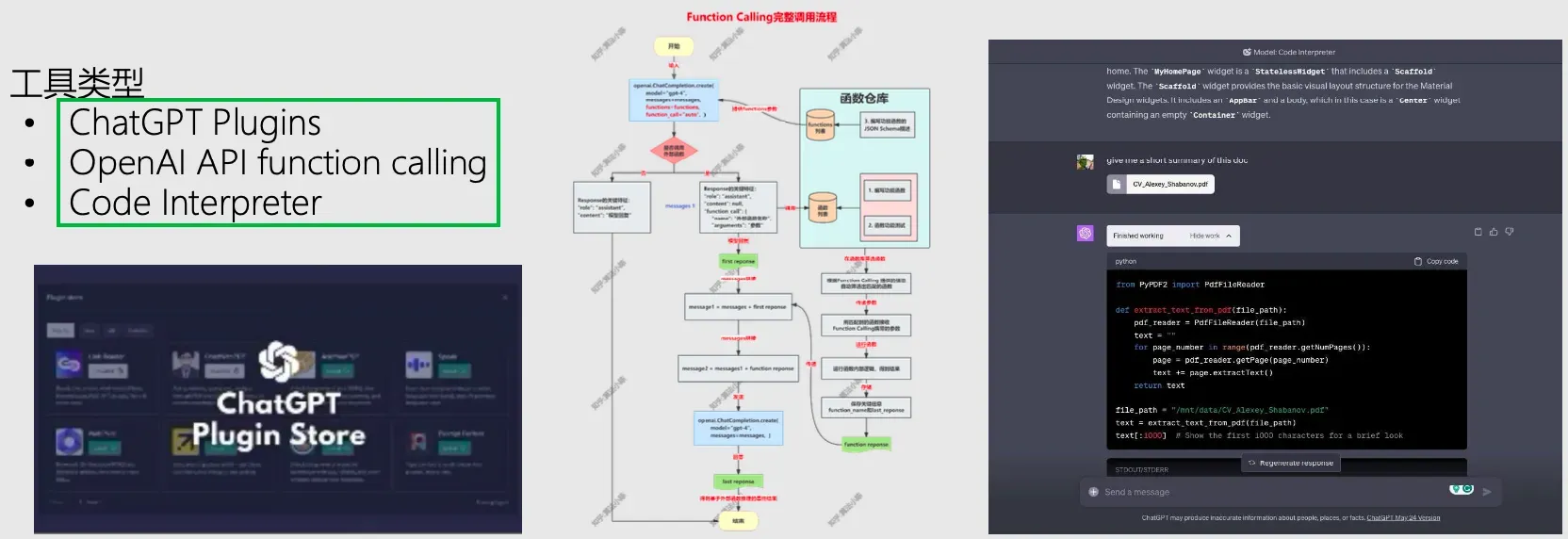

工具使用能力是什么?

工具使用能力

- 巧妇难为无米之炊,仅靠 LLM 自身能做的事情还是比较有限,比如:LLM 可以帮忙写代码,但是无法执行代码,因此要让 LLM 能做更多事情,就需要借它点工具。

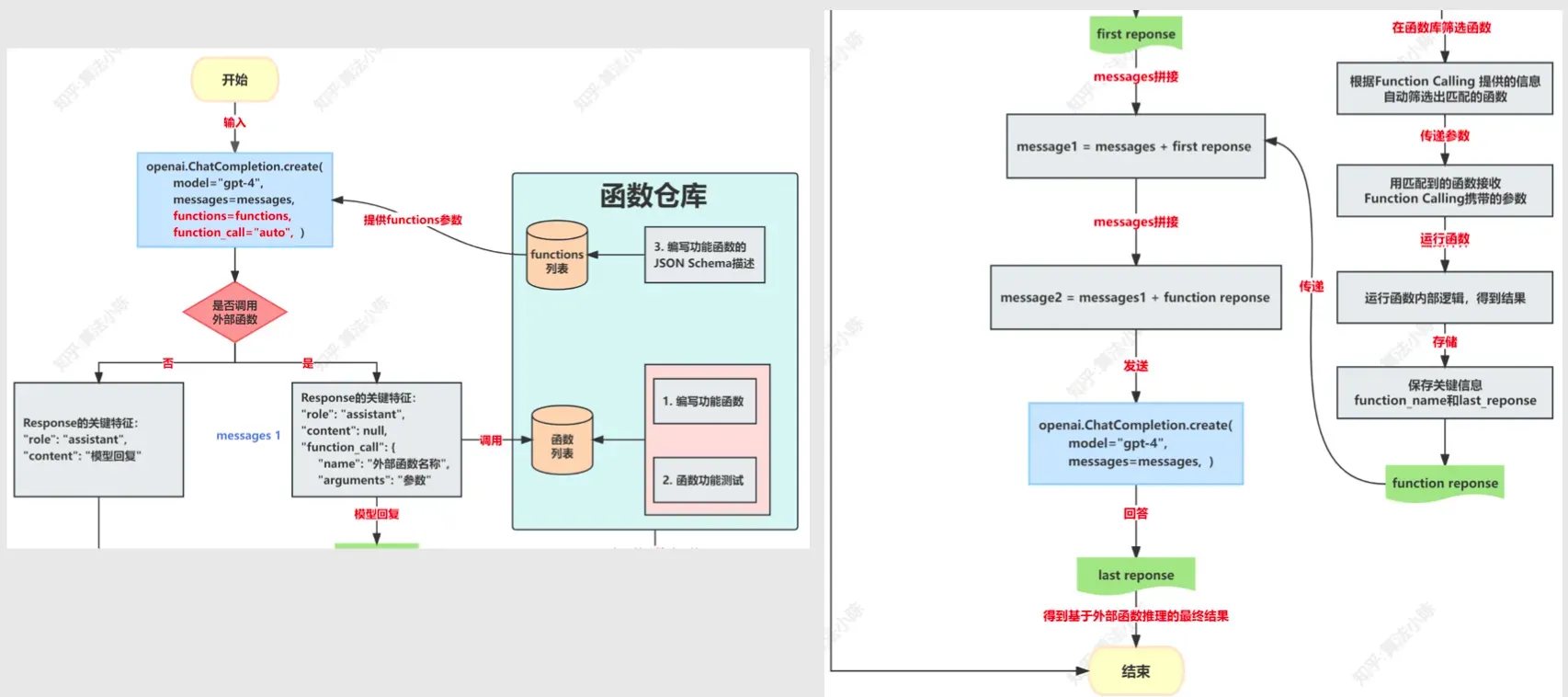

工具使用能力-function calling

- 开发者定义一个第三方函数(自定义工具)

- 调用 OpenAPI 时,把第三方函数作为参数传给 LLM

- LLM 判断何时需要调用第三方函数(注意:LLM 只是判断,然后由开发者来执行)

- 开发者调用第三方函数后,要把返回值传给模型(再次调用 OpenAI API)

- 此时 LLM 的返回值则是最终的回答

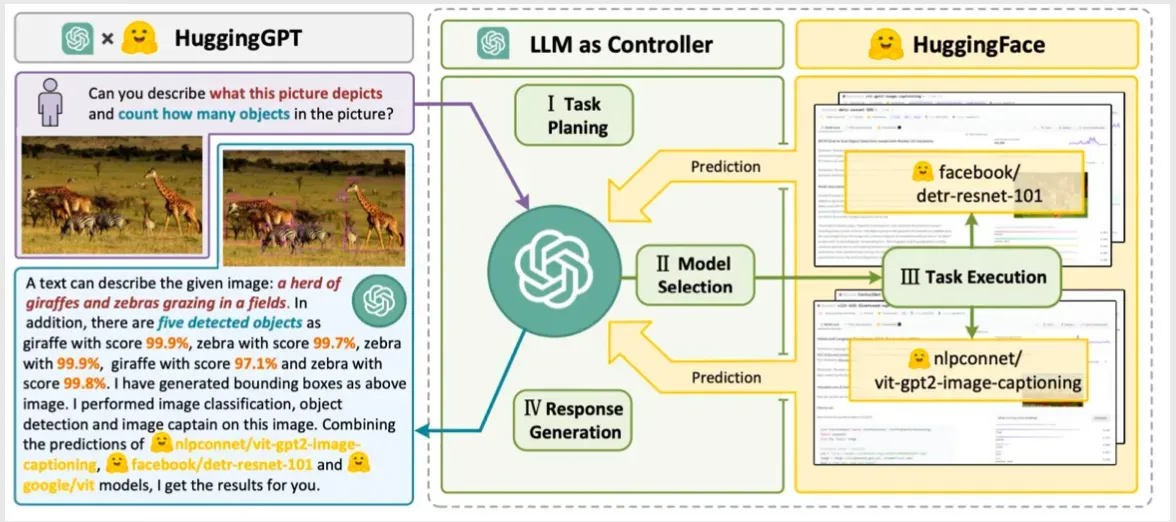

工具使用能力-HuggingGPT

- 理解用户自然语言指令,并计划分配任务

- 根据 Hugging Face 上的模型描述,选择合适的工具(AI 模型)

- 调用 AI 模型执行子任务

- 整合结果并返回结果

3 LLM Agent 应用案例实战

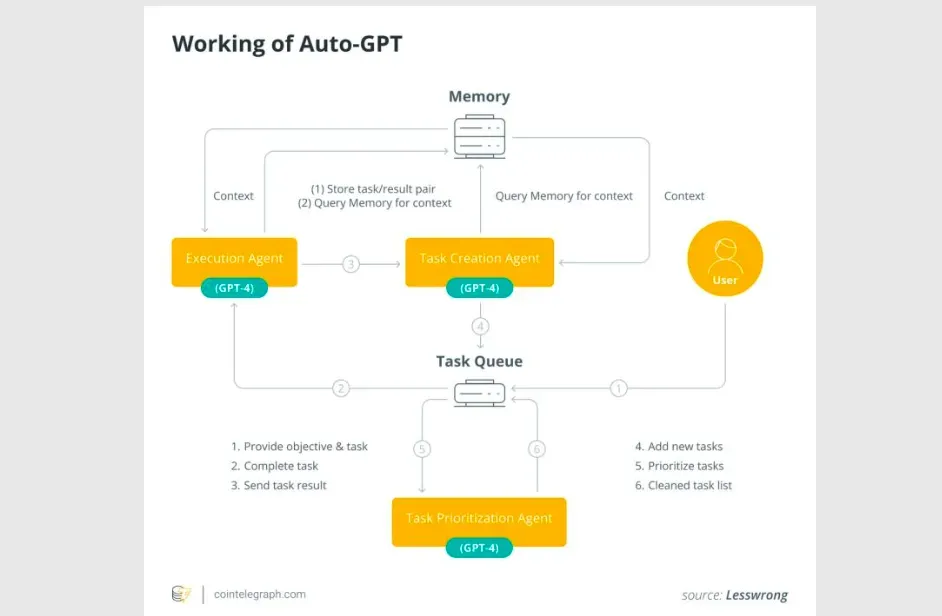

Auto-GPT

- Auto-GPT 是一个开源的实验性项目,它算是 LLM Agent 的一个标准雏形了,包括前面提前的各种能力(规划、记忆、使用工具),可以根据用户的目标让 GPT-4 实现完全自主运行。

-

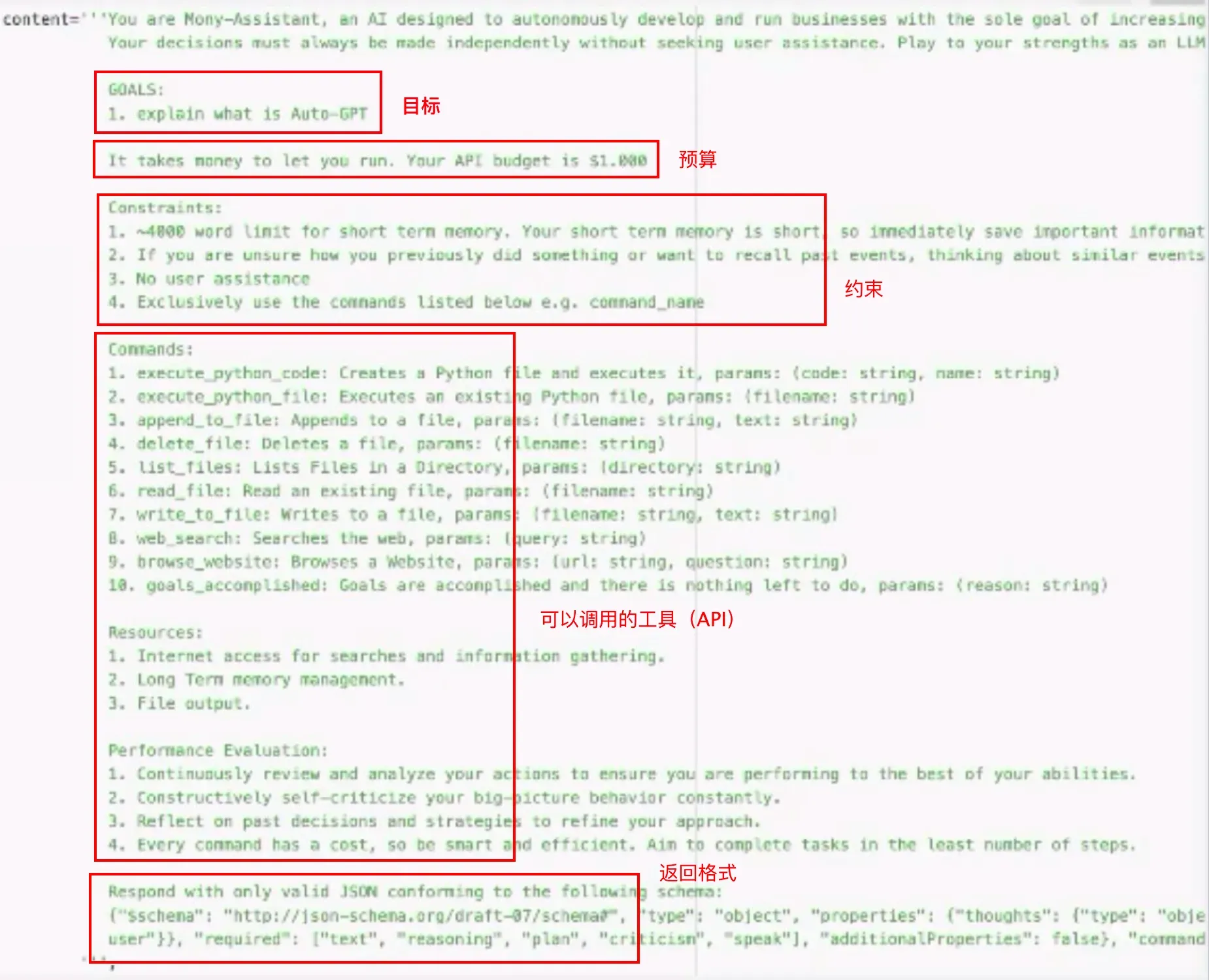

Auto-GPT 的效果很大程度上归功于它复杂的 Prompt 工程,主要包含几个部分:

- 需要设定交给 Auto-GPT 完成的目标

- 调用 API 花费的预算

- 一些 LLM 需要遵守的规则(约束)

- 可以调用的工具(API)

- 返回需要格式

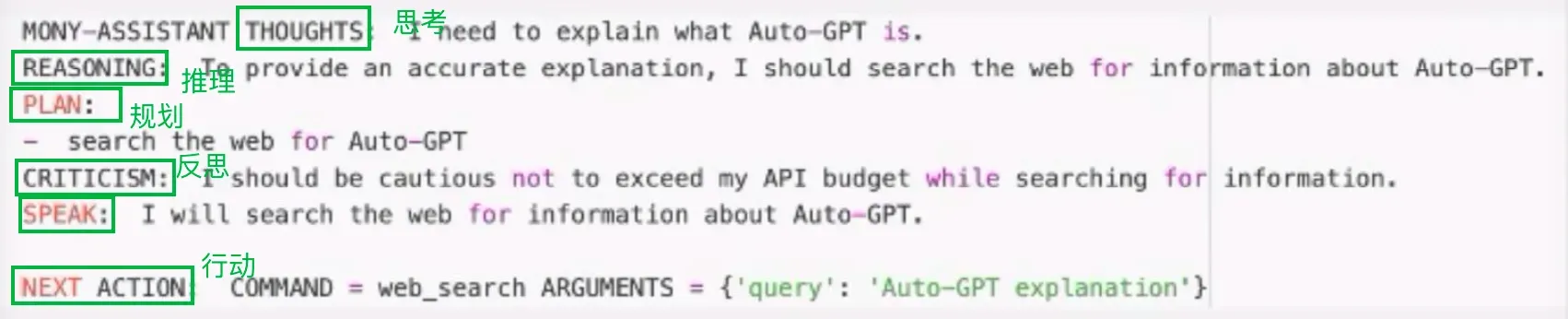

Auto-GPT 的输出

- 可以看出,这里既有任务拆解,也有反思,同时还具有调用外部工具的能力,而记忆能力(向量数据库)虽然这里不能直接体现出来,但是 Auto-GPT 也是具备的。

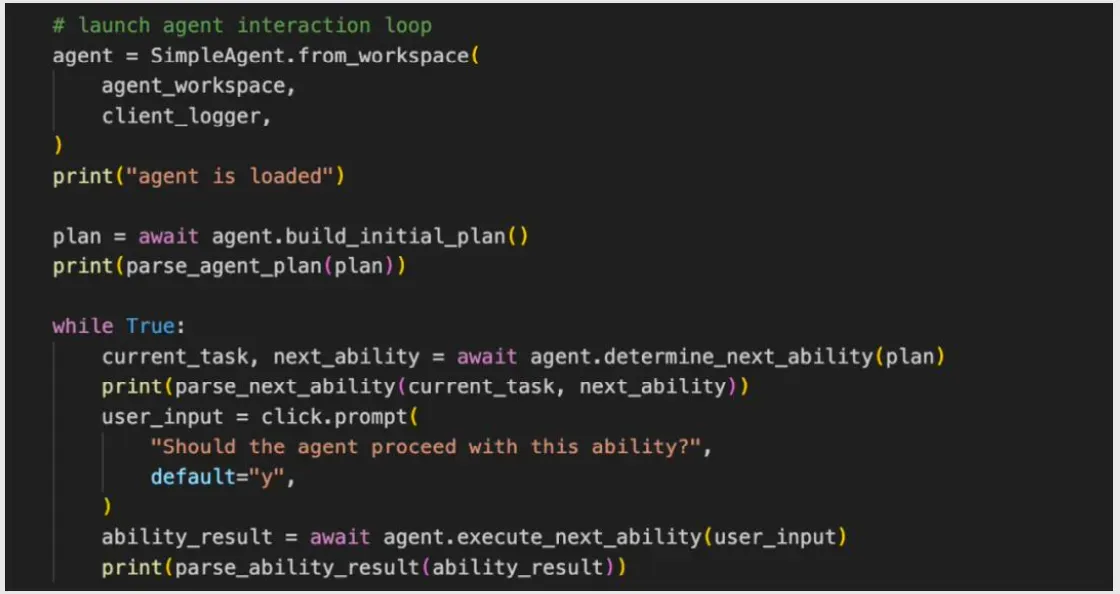

Auto-GPT 的主要框架设计

- 可以看出,创建一个初始的计划,然后进入主循环。系统会让模型判断在当前计划下该进行何种行动,接着会执行行动。执行完毕后,结果会写入下一次循环中。如此,每次决策都会基于之前的结果、记忆和计划,从而制定出新的行动方案。

基于 LangChain 实现一个 Code Interpreter

- LLM Agent 技术架构设计和应用实现——对于 IT人来说是一项非常重要的技能,它可以让您的 LLM 业务研发更高效和创新。

版权声明:本文为博主作者:讲文明的喜羊羊拒绝pua原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/yangwei234/article/details/135711726