LeNet、AlexNet和VGG都有一个共同的设计模式:通过一系列的卷积层与汇聚层来提取空间结构特征;然后通过全连接层对特征的表征进行处理。 AlexNet和VGG对LeNet的改进主要在于如何扩大和加深这两个模块。

然而这种形式的网络也存在一个问题:全连接层的参数太多,一条样本有多个分量(特征)进入全连接层。这极大地占用了内存与计算带宽,我们在训练中也可以感受到,除此以外还容易导致过拟合。

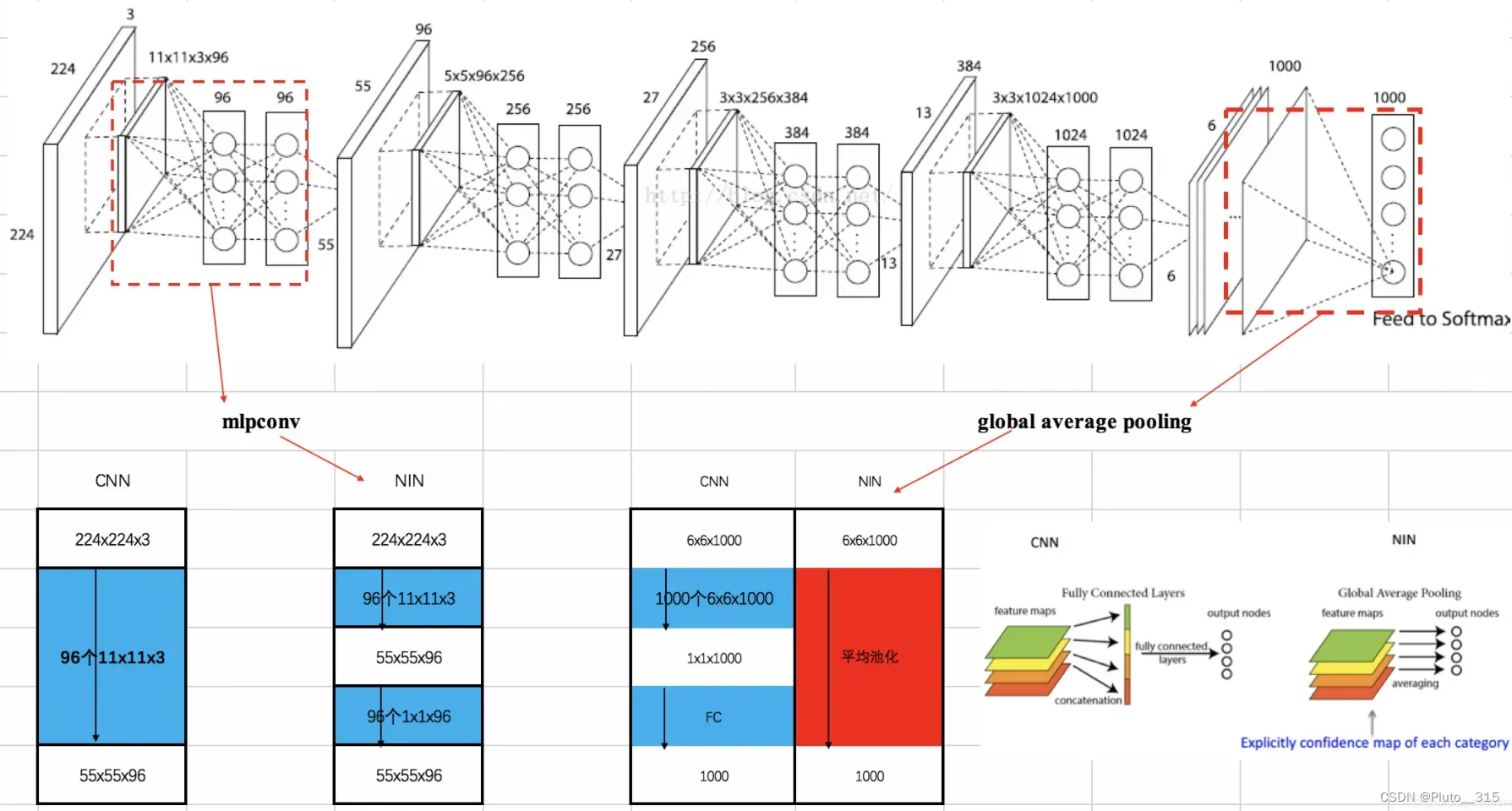

网络中的网络(NiN)提供了一个非常简单的解决方案:在每个像素的通道上分别使用多层感知机, 不再使用全连接层,使用卷积层代替。

创新点:完全取消全连接层

卷积层的输入和输出由四维张量组成,张量的每个轴分别对应样本、通道、高度和宽度。 另外,全连接层的输入和输出通常是分别对应于样本和特征的二维张量。

NiN的想法是在每个像素位置(针对每个高度和宽度)应用一个全连接层。 具体做法是:在一个卷积层后跟两个1X1的卷积层,步幅为1,且无填充,这样使得输出形状与输入形状一样,起到全连接层的作用。

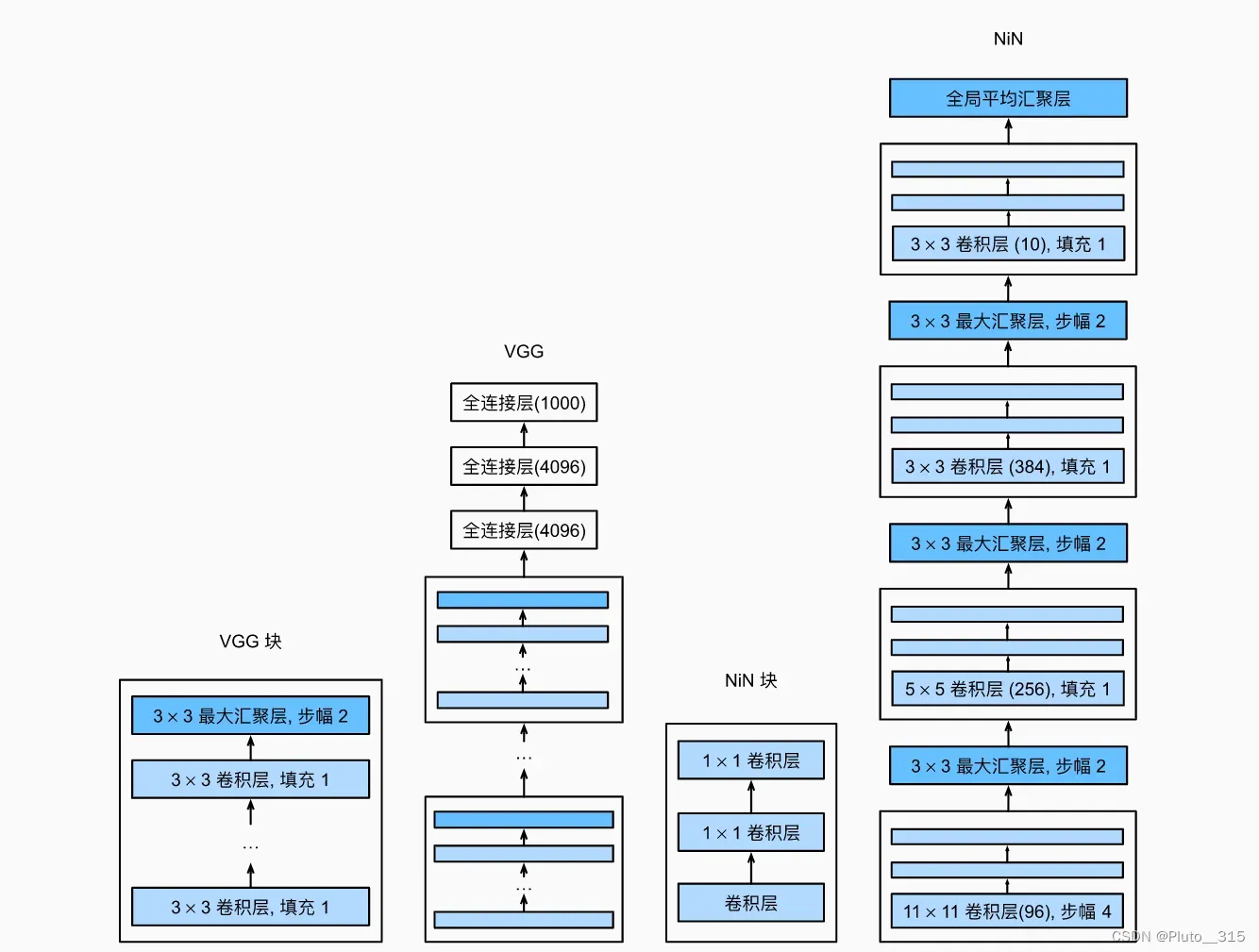

下图说明了VGG和NiN及它们的块之间主要架构差异。 NiN块以一个普通卷积层开始,后面是两个1×1的卷积层。这两个1×1卷积层充当带有ReLU激活函数的逐像素全连接层。 第一层的卷积窗口形状通常由用户设置。 随后的卷积窗口形状固定为1×1。

NiN设计的一个优点是,它显著减少了模型所需参数的数量。交替使用的NiN块和步幅为2的池化,达到了逐步减小高宽和增大通道数的目的。 然而,在实践中,这种设计有时会增加训练模型的时间。

- NiN使用由一个卷积层和多个1×1卷积层组成的块。该块可以在卷积神经网络中使用,以允许更多的每像素非线性。

- NiN去除了容易造成过拟合的全连接层,将它们替换为全局平均汇聚层(即在所有位置上进行求和)。该汇聚层通道数量为所需的输出数量。

- 移除全连接层可减少过拟合,同时显著减少NiN的参数。

- NiN的设计影响了许多后续卷积神经网络的设计。

文章出处登录后可见!

已经登录?立即刷新