一、概述

这篇文章做了两个任务:一个适用于需要多模态推理的任务,例如 VQA;另一个适用于需要多模态匹配的任务,例如Image-Text Matching。

这篇文章在【多模态】《Hierarchical Question-Image Co-Attention for Visual Question Answering》论文阅读笔记这篇文章需要对视觉和文本进行互相的co-attention建模的基础之上,提出多跳融合。尽管前者同时应用了视觉和文本注意,但它独立地执行共同注意的每个步骤,而无需对先前的共同注意输出进行推理。 相反,这篇论文的方法通过基于先前注意力的记忆的多个推理步骤来移动和细化两个注意力,这有助于视觉和文本数据之间的密切相互作用。

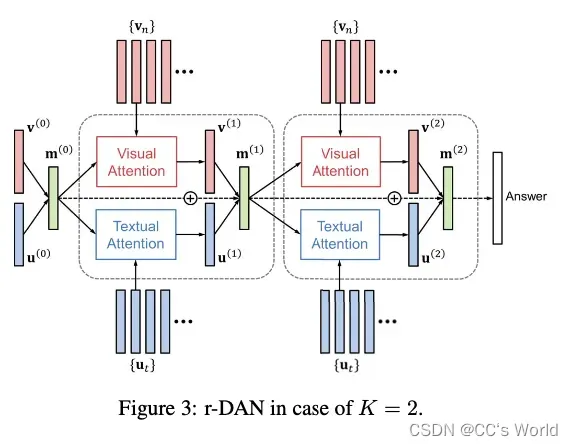

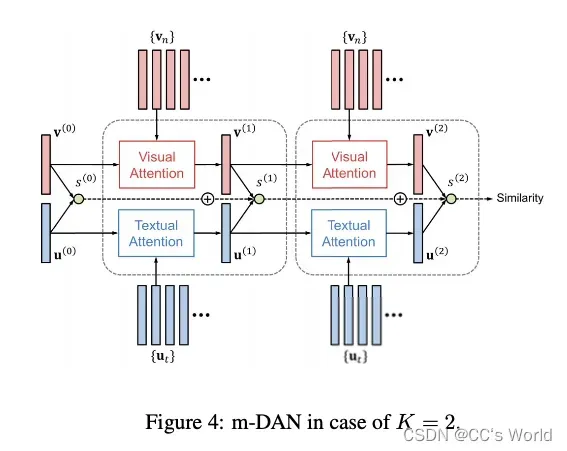

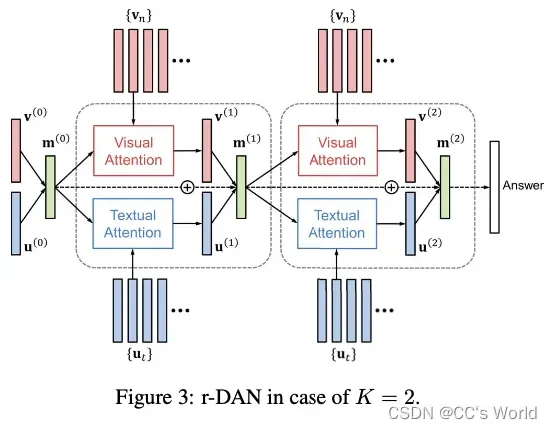

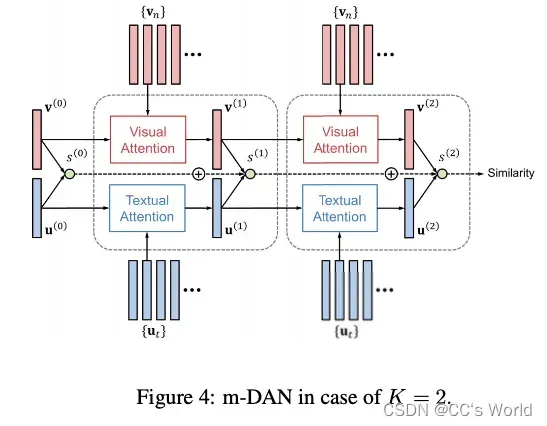

即:在本文中,我们提出了双重注意网络(DAN),它联合学习视觉和文本注意模型,以探索视觉和语言之间的细粒度交互。 我们研究了 DAN 的两种变体,分别称为推理 DAN (r-DAN) 和匹配 DAN (m-DAN)。 r-DAN 使用联合记忆协同执行视觉和文本注意,该联合记忆组装先前的注意结果并指导下一个注意。 它适用于需要多模态推理的任务,例如 VQA。 另一方面,m-DAN 将具有不同记忆的视觉和文本注意模型分开,但联合训练它们以捕获图像和句子之间的共享语义。 这种方法最终找到了一个联合嵌入空间,它有助于高效的跨模态匹配和检索。

所以这篇文章的创新点主要在两方面,一方面是提出多跳双重注意力网络,分别对视觉和文本都进行attention;另一方面是在两个不同的任务上进行应用。

这里需要特别注意的是本文的第二个亮点,基于推理的多模态任务和基于匹配的多模态任务在本质上是不同的:

基于推理的多模态任务是需要融合视觉和文本模态以得到一个统一的多模态表征去进行后面的答案生成或答案多项选择,为了将视觉和文本模态融合到同一个表征空间,需要在多跳推理的中间步也进行一定的融合,并用融合的特征再对视觉和文本模态进行attention,即:

**而基于匹配的多模态任务是需要得到视觉和文本模态各自的表征,然后可以求两个模态之间的内积来衡量相似度。所以每一步的attention是在模态内部做的。同时,以end2end的方式对这种模型进行训练,可以一步步逼近将两个模态映射到相同的语义空间中,这个相同的语义空间这样理解:这是视觉和文本两个语义空间,但是两个语义空间是可以衡量相似性的。可以类比成 man-women 和 king-queen的关系。**即:

二、Dual Attention Networks (DANs)

2.1 Image representation

常规操作,先resize成448 * 448的图片,然后过ResNet或VGGNet等抽出一个feature map。最终得到的视觉特征记作:{ }。每一个

是512维的,N是feature map的n个region。

2.2 Text representation

常规操作,先过embedding matrix,得到每一个one-hot词对应的embedding,然后用BiLSTM建模文本序列。最终得到的文本特征记作:{ }.

2.3 Attention Mechanisms

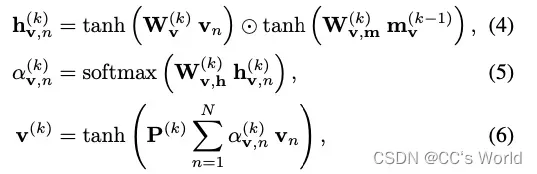

2.3.1 Visual Attention

视觉注意力旨在通过关注输入图像的某些部分来生成上下文向量。 在步骤 k,视觉上下文向量 v(k) 由下式给出:

![]()

- 在基于推理的多模态任务中,它被理解为第k-1步的视觉和文本融合向量,因为在后续的推理过程中,还需要根据这个融合向量去做进一步的attention;

- 在基于融合的多模态任务中,它就是第k-1步的视觉向量,因为在后续的过程中,它需要根据最终匹配得分的梯度一步步回传来更新视觉空间,从而实现让视觉空间和文本空间可以进行语义相似度的比较。

V_Att被实现为:

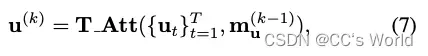

2.3.2 Textual Attention

文本attention和视觉attention实现的方式基本相同,不同之处在于式(6)和式(10):

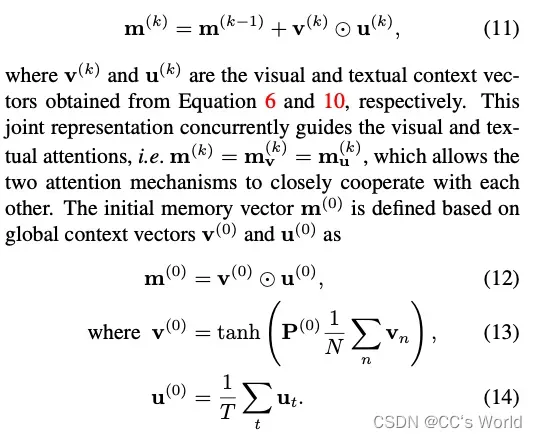

三、r-DAN for Visual Question Answering

VQA 是一个有代表性的问题,需要对多模态数据进行联合推理。 为此,r-DAN 维护一个联合记忆向量 m(k),该向量累积在步骤 k 之前已经处理的视觉和文本信息。 它由递归更新:

五、m-DAN for Image-Text Matching

图像-文本匹配任务通常涉及大量图像和句子之间的比较,其中有效和高效地计算跨模态相似性至关重要。 为了实现这一点,我们的目标是学习一个满足以下属性的联合嵌入空间。 首先,嵌入空间对图像和句子域中经常同时出现的共享概念进行编码。 此外,图像和句子在没有配对的情况下自动嵌入到联合空间中,因此空间中的任意图像和句子向量可以直接比较。

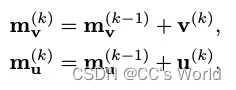

我们的 m-DAN 联合学习视觉和文本注意模型以捕获两种模式之间的共享概念,但在推理时将它们分开以在嵌入空间中提供一般可比较的表示。 与使用联合记忆的 r-DAN 不同,m-DAN 为视觉和文本注意维护单独的记忆向量,如下所示:

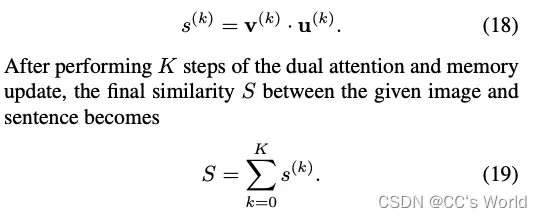

在每一步,我们通过它们的内积计算视觉和文本上下文向量之间的相似度 s(k):

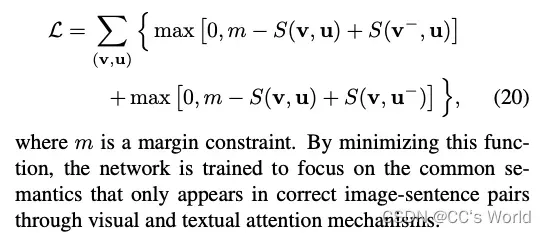

该网络使用双向max-margin ranking loss进行训练:

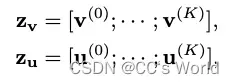

在推理时,通过连接其上下文向量将任意图像或句子嵌入到联合空间中:

其中 zv 和 zu 分别是图像 v 和句子 u 的表示。 请注意,这些向量是通过视觉和文本注意的单独管道获得的,即学习的共享概念是从图像或句子本身而不是从图像-句子对中揭示的。 联合空间中两个向量之间的相似度可以简单地通过它们的内积来计算,例如 S(v, u) = zv · zu

文章出处登录后可见!