👀日报&周刊合集 | 🎡生产力工具与行业应用大全 | 🧡 点赞关注评论拜托啦!

👀 看热闹不嫌事大!马斯克:OpenAI首席科学家 Ilya 应该跳槽到xAI

https://www.businessinsider.com/openai-cofounder-ilya-sutskever-invisible-future-uncertain-2023-12

OpenAI 内部「政变」余波仍在,除了陆续爆出的 Sam Altman 各类负面信息,前首席科学家 Ilya Sutskever 的终局也格外牵动人心。

作为被董事会拉拢参与「政变」又首先妥协投降的关键人物,作为参与创建 OpenAI 却眼看着它越行越远的技术天才,Ilya Sutskever 为自己的信仰和坚持付出了代价——他至今没有明确的新职位信息,在公司鲜少露面,看起来前途未卜 (来自 BusinessInsider)。

12月9日,社交平台X博主@WholeMarsBlog 转发了这篇报道,并评论「Ilya Sutskever 应该跳槽去特斯拉」,马斯克随机跟帖评论「去 xAI 也行」,看起来是向 Ilya 抛出了橄榄枝。

说明:xAI 是马斯克成立的AI创企,近期全面推出AI聊天机器人 Grok,据使用者反馈其英文对话效果不错~

🉑 Mistral AI 团队正式发文介绍 SMoE (稀疏混合专家模型)

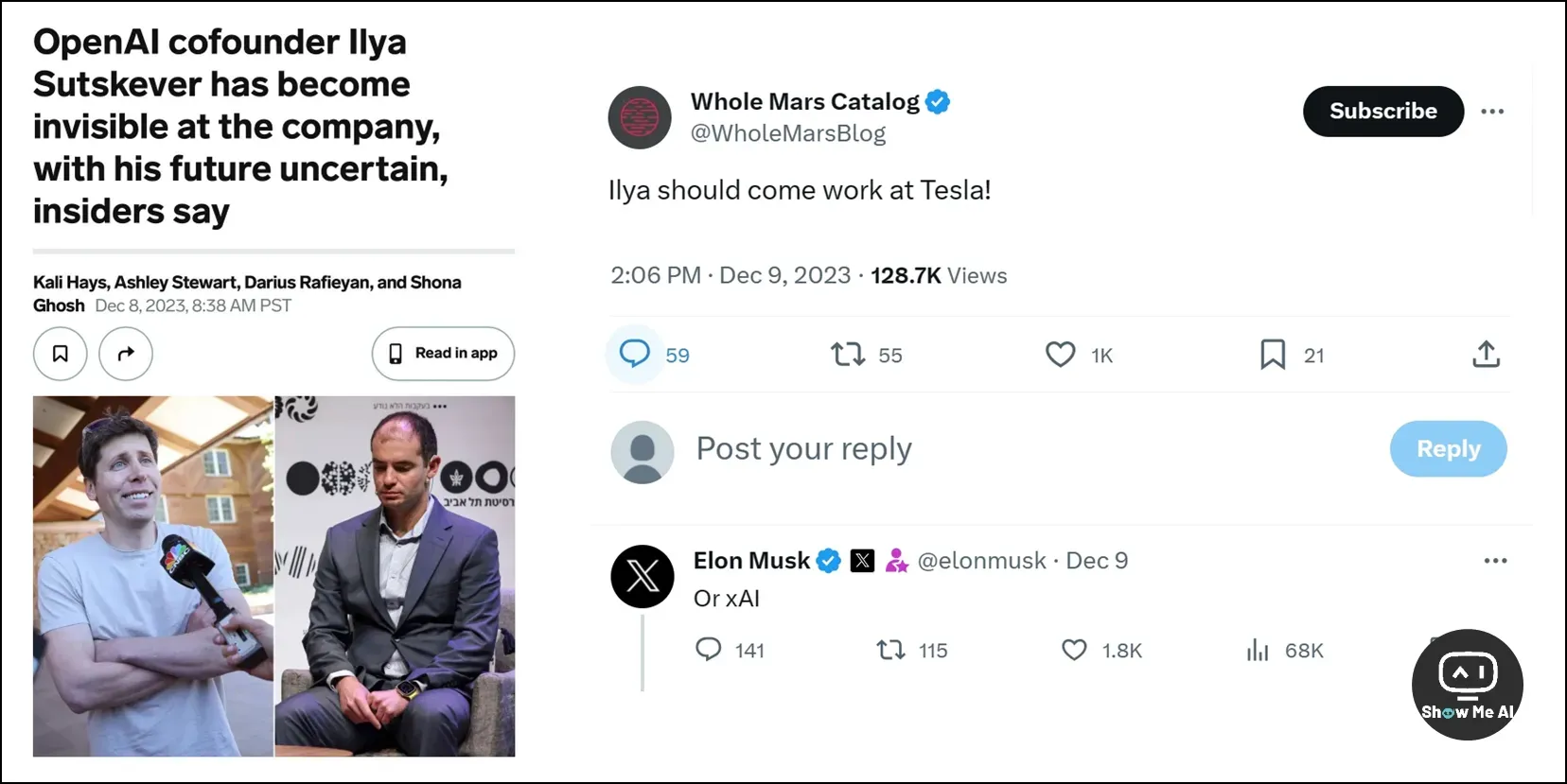

12月11日,Mistral AI 团队的官方博文姗姗来迟,终于介绍了近期引起轰动的 Mixtral 8x7B 模型所使用的 SMoE (Sparse Mixture-of-Experts),也就是稀疏混合专家模型。

高低等到周一再工作,可以,这很法国

博文提供了很多测试数据,值得注意的是,Mixtral 在大多数基准测试中已经超过了Llama 2 70B,并且与 GPT-3.5 相当甚至已经实现了超越,可以说是成本-性能权衡方面的最佳模型。

Mixtral 的主要能力包括以下内容,对其详细信息感兴趣的伙伴,可以前往官网阅读原文:

能够流畅地处理 32K Token 上下文

支持英语、法语、意大利语、德语和西班牙语等多种语言

代码生成能力非常强大

可以调整为遵循指令的模型,在 MT-Bench 上评分高达 8.3 分

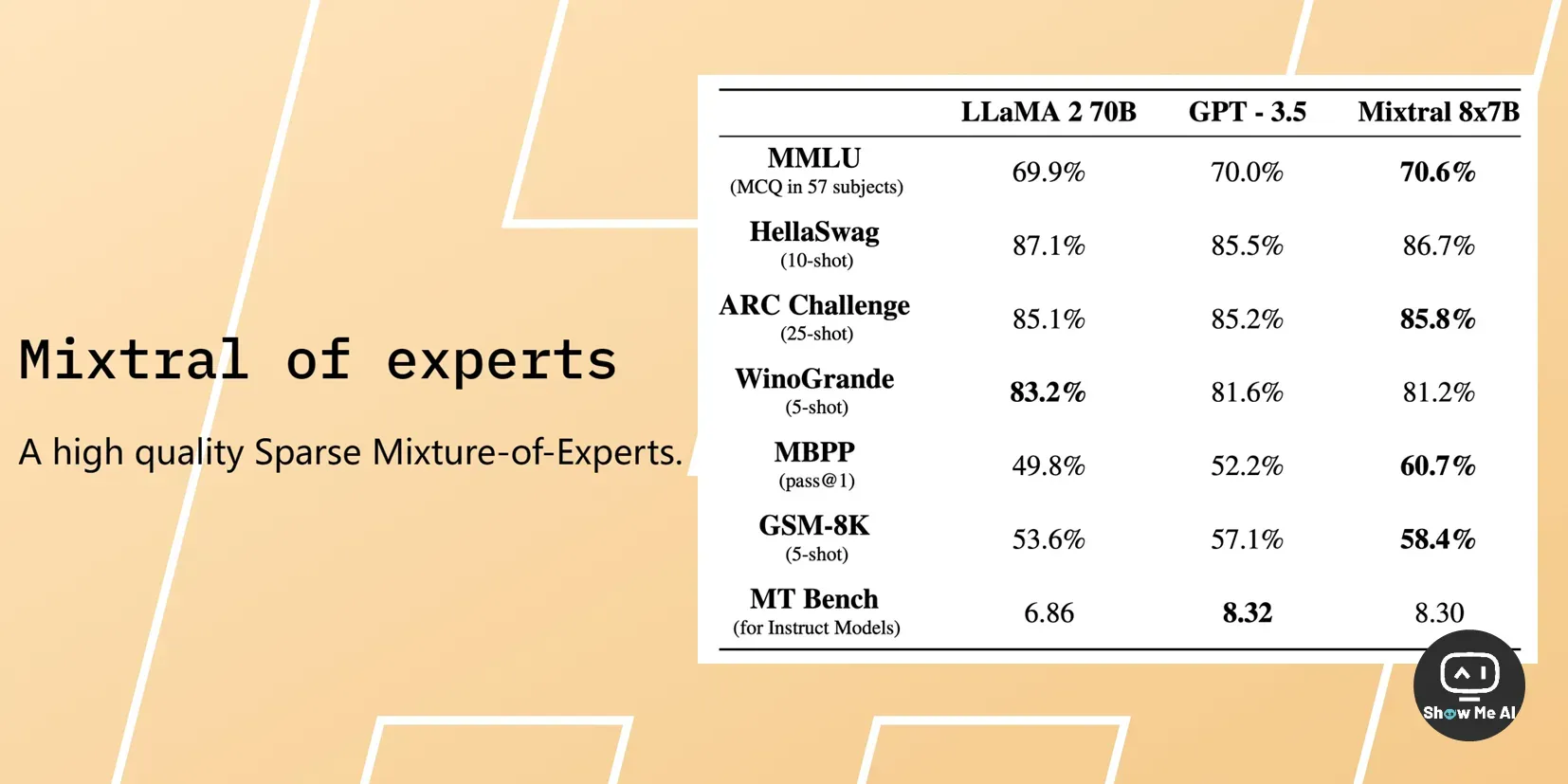

👀 Mistral AI 的定位和操作到底有多高明?听听 Jim Fan 的点评

Jim Fan 是谁呢?他博士毕业于斯坦福大学视觉实验室,师从大佬李飞飞教授。目前在英伟达担任高级研究科学家并领导 AI Agent。此外,他在社交平台X有着 184K 粉丝。

12月12日,Jim Fan 发推文评价了 Mistral 的声名鹊起,不仅有对其研究方向和发布操作的高度赞赏,也有很多不多的技术洞见。日报对这篇推文进行了翻译和整理,并对重点内容进行了加粗:

成功的开局:Mistral 成立的时机非常好,选在了开源与闭源AI激烈讨论的当下,并且迅速完成了2亿美元的A轮融资,顺利将公司估值推到20亿美元,可见其创始团队精明强干

(日报下方有其 CEO 访谈)每个月都有数十个大模型问世,但是只有少数几个能具有持久的影响力。大家对新模型发布已经不觉得新鲜,但是 Mixtral 8x7B 还是成功勾起了大家的好奇心

Mistral做对的地方是选择优化 7B-tier (70亿级别) 的模型,而不是追求更大的模型容量,毕竟对于基层AI工程师来说,70亿和70亿-MoE 更容易进行开发和构建。

- MoE 是AI发展的正确方向,它在小型模型的知识记忆与效率之间找到了一个灵活的平衡点,而且 OpenAI 自训练 GPT-4 以来已经在这条路上走了一年多 (AI社区没有密切关注 MoE 反倒让人惊讶)

- Mistral AI 整个发布过程,本身也非常有意思,一直在颠覆大家的预期:

首先,只发布一个磁力链接,没有任何解释,磁力链接已经成为一种新的吸引眼球的方法

然后,向开源vLLM项目提交一个拉取请求 (PR),帮助社区集成 Megablocks CUDA 内核,这也是一个很棒的举动!

最后,才发布正式的博客文章

- 此外,发布托管的API端点是目前开源模型盈利的最佳方案,不仅可以快速收集客户反馈,还可以迭代实际用例,Mistral 也果断采取了这一方案

- 「Mixtral」是一个非常巧妙又聪明的命名

🉑 国内的大模型结构和 LLaMA 有多相似?从李开复 Yi 开源模型的争议说起

#小程序://哔哩哔哩/QlvcSsX9Px0hxYb

LLaMA 是由 Meta 发布的系列AI模型,其参数量从70亿到650亿不等,这些模型在许多任务中展现出了强大的性能

前段时间,李开复零一万物的「Yi-34B」开源大模型被爆「抄袭 LLaMA」,虽然官方很快发布 说明 但还是引起了AI社区的一阵讨论。

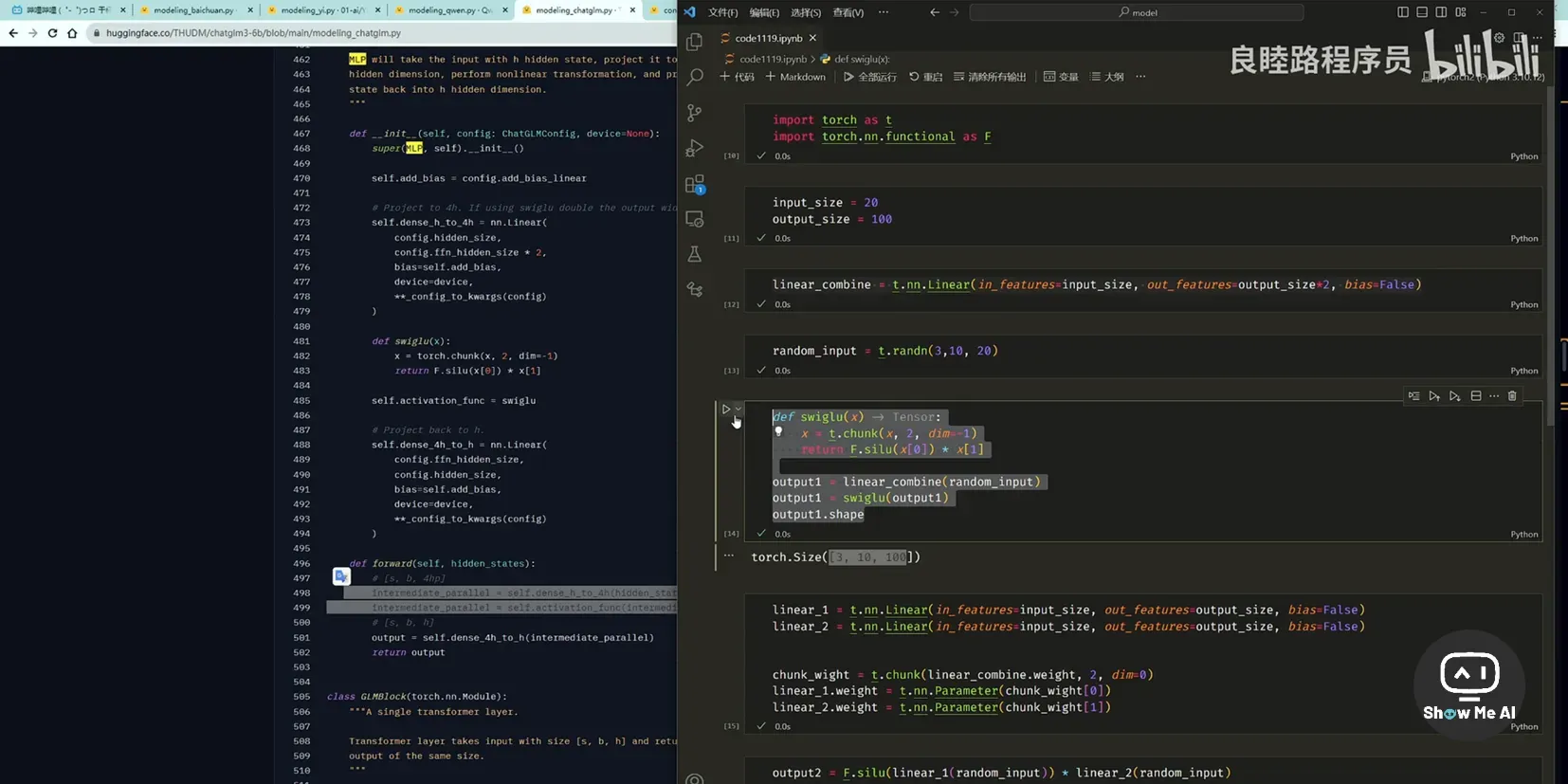

B站Up主 @良睦路程序员 发出了「暴论」:为什么要这么针对 Yi 呢?国内的大模型跟 LLaMA 都是一模一样的。

他在视频里拉出源码,仔细分析 BaiChuan-2、Yi、Qwen、ChatGLM-3、Mistral-7B 等大模型和 LLaMA 的相同之处,还会吐槽一些工程师在 LLaMA 网络结构上进行的「奇怪且没必要」的改动。

那么,和 LLaMA 网络结构一样,就是可耻的么?并不是的。

首先,LLaMA 和 GPT 模型其实也是相似的,模型结构本来就是在互相借鉴中前进的。其次,大模型训练的重点是参数更新这个环节,每一个模型的问世都蕴含着无数工程师的努力,包括如何确保数据清洗质量、如何确保训练过程的稳定等等。

其实,LLaMA 好用就直接老老实实用 LLaMA,没必要追求研发新的模型架构。以及,对于我们每个人,再遇到类似「套壳」争议时,可以选择完整科普,也可以选择闭口不言,没必要输出一顿嘲讽。

🉑 AI Agents 的一些实践经验

Agent (智能体) 承载着人类实现 AGI (通用人工智能) 的希望,是近期及将来一段时间的绝对热点。如果你需要一篇文章快速拉齐对 Agent 的了解,那么推荐公众号这篇文章!科普和实践兼备,20分钟搞懂基本内容~

什么是AI Agents?

- AI Agents 是一种新的工作方式,可以根据人类给定的目标独立完成任务,包括自我提问、自行解决问题、举一反三、自主行动、以及自行确定行动结果

AI Agents 形态

ChatGPT插件:允许 GPT 访问最新信息、运行计算或使用第三方服务,可以自动判断是否需要使用插件、选择哪个插件以及如何使用它们

AgentGPT:基于 LangChain 实现,具有更完善的前端,使用 Plan-and-Solve-Prompting 技术进行推理,并由 LangChain的 OpenAI Functions Agent 负责执行具体任务

Autogen:一个 LLMs 框架,类似于 LangChain,主要用于简化 LLMs 工作流的编排、优化和自动化;提供了可定制和可对话的 Agents,对人工参与度的支持非常好

AI Agents 是未来的方向吗

AI Agents 可能是未来的方向,因为它们让AI具有更强的自主性和灵活性,能够更好地模拟人类大脑的决策过程

AI Agents 可以模仿人类大脑的不同功能和行事逻辑 (例如规划、记忆和工具使用),让 LLMs 完成复杂任务成为可能,并能解决一些小众或独特的需求

AI Agents 目前存在的问题

尽管 AI Agents 具有巨大潜力,但仍存在一些问题需要解决,如错误纠正和反馈、理解人类的隐含需求和期望、记忆管理、资源消耗、执行时长、人工介入的必要性等

在实际业务应用中,AI Agents 可以作为辅助工具,但暂时还无法完全替代人类 ⋙ 阅读全文

🉑 专访Mistral AI CEO:小模型大目标,欧洲最强模型团队的野望

Mistral AI 由来自 DeepMind 和 Meta 的三位青年科学家建立,是欧洲最强模型团队;团队不仅在多模态、RAG 方向上有着丰富经验,公司成立不久后就成功推出了目前市场上最强的小模型,用 7B 模型越级达到了大部分模型 20B 左右的水平

Mistral AI 的最新一轮融资已经接近尾声:领投方为 a16z,预计投资2亿欧元,Nvidia 和 Salesforce 可能会投资1.2亿欧元,这轮融资金额将达到4.5亿欧元 (约合4.87亿美元),估值则可能在 20 亿美金左右 (来自Bloomberg)

在11月初的一期 No Priors 播客节目中,硅谷投资人 Sarah Guo 和 Elad Gil 邀请了 Mistral Co-founder & CEO Arthur Mensch 进行了一次专访,共同探讨该公司在AI领域的发展和未来展望。

Arthur Mensch 的很多回答非常 Geek,深刻直接中肯。让我们通过这位技术天才和创业新秀的目光,看看AI的未来到底是什么样的。非常推荐阅读下方的中文文字版原文,大约15分钟,接收一波小震撼:

在创立 Mistral 前,Arthur Mensch 在 DeepMind 任职,并主导了 Chinchilla、Retro、Flamingo 等重要论文的发表,而这三篇论文分别是 20-22年间 Google 在 LLM、RAG、多模态三个领域最重要的作品,十分全能

六个月前的大模型领域,已经是巨头强力竞争的天下,为什么依然选择创立 Mistral AI:初衷是在欧洲创建一个独立的公司,来提高 AI 性能,研发最前沿的AI,并将开源 AI 作为核心价值

之前在 DeepMind 的研究方向:过去十年专注于算法效率提升和更有效地利用数据构建模型,在 DeepMind 时研究了检索增强模型,并发表了 RETRO 模型论文

Mistral 7B 只用了几个月就完成了,而且性能相当出色,那未来是专注小模型还是开发大模型:只是一个优越性能的7b 小模型并不是终点,未来会训练更大规模的模型以获取更强的推理能力;然后基于这些大模型通过蒸馏或者合成数据等技术,来训练出质量更高的小模型

如何收集、处理和标注数据:数据质量是影响模型表现的重要因素,数据来自于公开网络,并在数据标注方面进行指导以确保模型的可控性

欧洲会诞生一家重要的AI公司来服务全球需求,这个判断的信心来源:欧洲在AI人才储备上有优势,因为欧洲擅长培养数学家而他们会选择留在欧洲,并且伦敦和巴黎的AI生态正在显著崛起和完善 (巴黎已经有几百家初创公司了)

为什么选择开源:过早进入闭源阶段对科学发展有害,希望通过开源推动AI社区朝着更好、更安全的方向前进;我们的真正目标是占据领导地位,并改变游戏规则,因为我们认为当前的发展方向并不正确

对开源AI的安全性看法:禁止开源实际上是一种强制性的监管占用;如果真的禁止小公司开源,确实更有益于大公司的发展,但是这不利于AI领域的整体发展

如何保证AI生成内容的安全:假定模型一定要表现得符合规范,可能是一个错误的方向;我们应该提供一个未经修改、不会禁止各类输入输出的原始模型,然后应用开发者可以在此基础上添加新的过滤器,用于检测他们不想要的输入输出

对于自研模型平台的计划:正在构建一个平台,提供高效的推理服务,管理和调度客户需求,并提供模块化过滤器和机制

对AI安全风险的看法:分析了三个层次的AI安全问题,认为当前模型还不具有复杂性,因此不必过分担心存在性风险

是否研究推动 AI Agents 的技术:让模型变小有助于降低 AI Agents 的计算成本,这将有助于构建有趣的应用,长期来看,我们将走向一个 Agents 和AI交互的世界

对任意计算和规模上限的看法:表示质疑,认为模型的能力不仅取决于规模,也取决于数据,应该关注模型的实际能力而非预设的市场条件 ⋙ 阅读文字版(中文版)

👀 AI原生应用,为什么难产?

AI原生应用 (AI-native applications) 是指从设计和开发之初就充分考虑并融入AI技术的应用

移动互联网的原生应用是微信、抖音、小红书等等;AI原生应用有哪些呢?还不知道,目前还没出现

这篇文章讨论了AI原生应用在中国的发展现状和面临的挑战。尽管业界普遍认识到AI原生应用的巨大潜力,但实际的产品开发却遭遇了困难,许多项目并未取得预期的成功。

端到端研发的弊端:当前的AI应用开发往往采取「端到端」的研发思路,即一个应用对应一个大模型,这导致了应用与大模型的深度耦合,限制了应用的灵活性和多样性

大模型与应用解耦的必要性:为了克服端到端研发的弊端,提出了大模型与应用解耦的新思路,这包括大模型与应用的解耦、在应用内部不同环节使用不同的大模型

新生态的雏形:多模型多应用的模式将催生一个新的生态,这需要大模型服务商的出现,它们可以在底层大模型和企业应用之间搭建桥梁,提供定制化的服务

商业模式的重塑:AI应用可能会从分散、点状的出现逐渐向平台化靠拢,而且AI原生应用将颠覆现有的商业模式,产业链上的资本将重新分配,商业模式需要回归满足消费者真实需求的本质 ⋙ 阅读原文

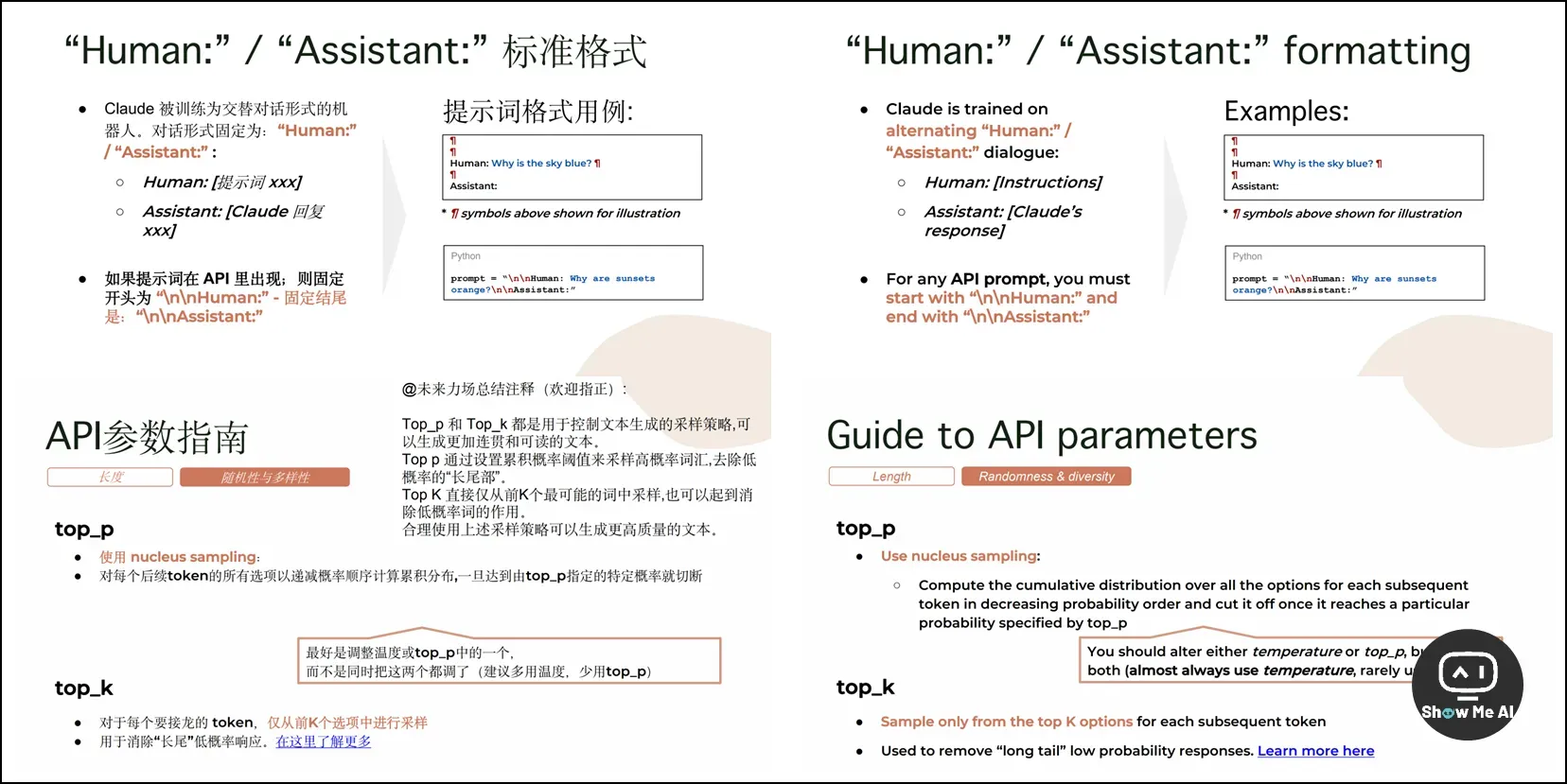

🉑 Claude 官方提示词工程技巧@未来力场大白话编译版

ShowMeAI知识星球资源编码:R199

Anthropic 上个月在官网更新了一篇提示词教程「Guide to Anthropic’s prompt engineering resources」,提供了大量的教程和最佳实践、调试清单、提示词示例等等,帮助你掌握 Claude 的使用技巧。以下是官方教程的内容大纲:

- 开始使用

- 提示工程教程

- 深入提示工程

Claude 提示工程技术演示

提示工程文档

- 示例与代码

示例提示与模板

示例代码与演示

- 软件开发工具包 (SDK)

通用 Anthropic SDK

Claude 在 Bedrock 上的 SDK

- 其他有用资源

Claude for Sheets (Claude 用于表格)

提示工程支持清单

@未来力场 将其编译成了中文,并制作成了中英文对照的PPT。现在各种各样的关于提示词工程的文档和教程很多,中文互联网上的内容通常比较碎片化,反而官方文档成了被忽视的宝藏。

其实提示词工程远远算不上难度大,跟「艰深」也压根儿不沾边儿。本文档里有提到,提示词工程是非常「empirical (经验性的)」,原理其实就那么几条,重点还是要:说人话、多迭代、积累样本和各种用例。

感谢贡献一手资讯、资料与使用体验的 ShowMeAI 社区同学们!

◉ 点击 👀日报&周刊合集,订阅话题 #ShowMeAI日报,一览AI领域发展前沿,抓住最新发展机会!

◉ 点击 🎡生产力工具与行业应用大全,一起在信息浪潮里扑腾起来吧!

文章出处登录后可见!