最近人工智能爆炸性消息层出不穷,先是百度和微软分别宣布将于近期发布新款类ChatGPT产品,随着相关消息披露,商业化成为业内最为关注的话题。此前OpenAI宣布开放ChatGPT的API接口。这意味着,任何公司和个人都可以在自己的程序中自由调取ChatGPT的相关功能。随着ChatGPT的强大功能不断被验证,近期一批A股上市公司纷纷宣布接入或计划接入ChatGPT等类似系统。随着ChatGPT的API接口正式开放,更多公司的加入将会加速相关模型的商业化落地。

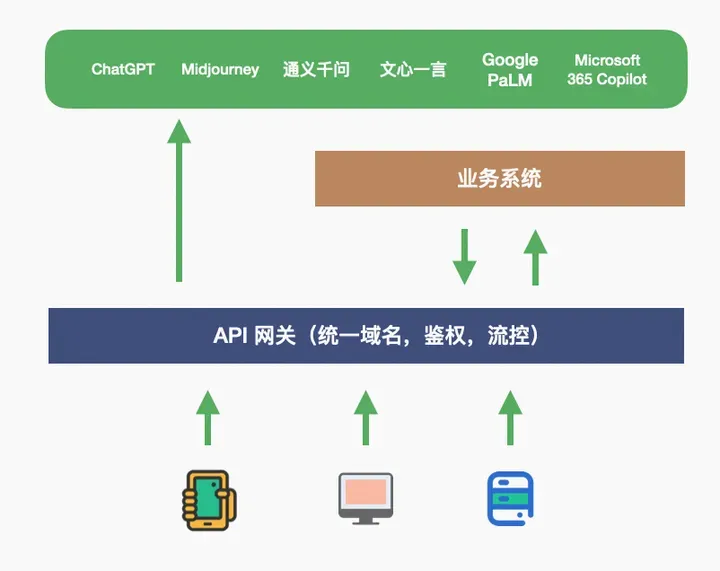

在继3月16日百度发布文心一言大模型后,国内众多科技、AI巨头都相继公布了各家大模型的发布会时间:4月8日华为盘古大模型发布、4月10日商汤大模型发布、4月11日阿里大模型发布,国内大模型的“百家争鸣”,AI已经成为大厂的必争之地,一些通用性AI能力将成为基础设施,以后大家看到的APP可能都离不开这些AI提供的能力。未来我们上线的APP的整体架构可能会是这样的:

AI能力作为基础设施处于最底层,客户端和用户的业务系统都有调用AI的API的需求。用户的业务系统可以通过API网关将所有AI的API包装起来,对客户端和业务系统提供统一的访问方式,统一控制访问权限和访问频率。这个架构还有个好处,就是用户购买的AI能力和用户业务API通过API网关上托管的统一的域名对客户端提供服务,可以统一控制相关权限和流量。下面我们分块描述下阿里云API网关在能力开放这块提供的基础能力。

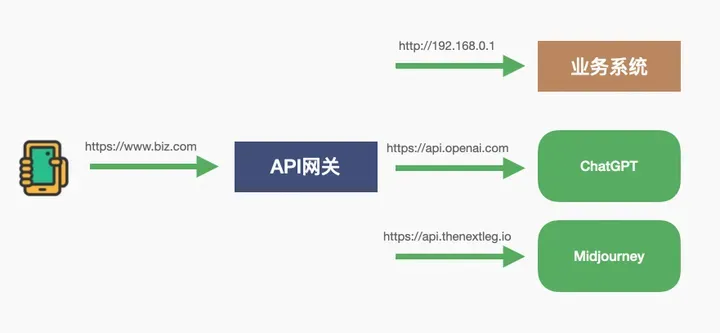

统一域名证书

用户可以将自己的业务域名和对应的SSL证书统一托管到API网关,将所有AI的API和自己业务系统的API包装到API网关后,对客户端和外部系统提供统一的域名进行访问,将所有AI的服务域名都包装起来。调用者并不知道后端真正提供能力实现的系统名称,用户可以根据业务运行的情况来替换AI的供应商,调用者感知不到后端API的变化。

鉴权

不同的AI能力提供者对用户派发了不同的访问凭证,调用不同的AI提供者的API的鉴权方式各有不同。用户可以将这些复杂度统统在阿里云的API网关配置上,对其调用者提供统一的鉴权方式。用户可以通过API网关为不同的用户生成不同的访问凭证,并且为这些访问凭证设置有效期,也可以在API网关控制台随时删除指定的访问凭证。

阿里云API网关除了为用户提供访问凭证类型的鉴权方式,还提供了标准的JWT的鉴权方式,用户可以通过颁发Token的方式对调用者进行动态鉴权,并且可以通过管理API网关的插件数据集方式来Block已经颁发的Token。

阿里云API网关还提供了灵活的第三方鉴权的能力,用户配置自己的鉴权服务为API的访问进行鉴权,API网关在调用API后端服务之前先调用用户的鉴权服务,收到鉴权服务的鉴权成功应答后才会继续调用后端服务,否则给客户端返回鉴权失败的应答。

支持流式输出(SSE)

目前众多类ChatGPT的AI提供方提供的服务形式都是对话性质的,在返回应答的时候都是流式输出的,如上图所示,返回的应答都是逐字逐句返回的。阿里云的API网关可以通过简单的配置支持流式输出的特性(SSE),以适配目前流行的对话型AI服务模式。

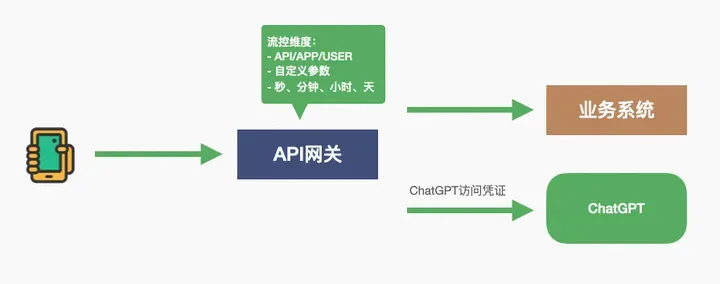

流控

流控是API网关最基础的能力,无论用户的业务API还是AI的API都需要有流控的保护。阿里云API网关允许用户根据后端系统最大承受能力设置流量阈值,当客户端请求总量超过阈值时,网关把多出的请求直接驳回,保证后端服务不会遇到过载请求的情况。API网关允许用户通过多个维度对请求进行流控,可以对API,App(访问凭证),用户(访问方的App归属用户)三个维度进行秒、分钟、小时、天等时间维度进行流控,API网关同时提供针对请求中自定义参数这个维度的限流,请求的任意一个参数都可以成为流控的锚定值,比如用户可以指定请求中的IP头作为流控锚定值,那么可以通过API网关的流控能力轻松控制每个IP的请求RPS。

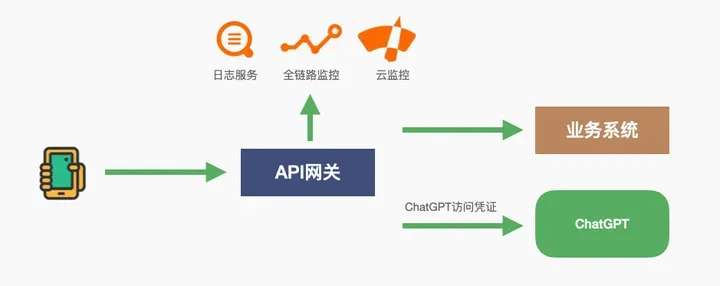

监控与报警

业务的可观测性和异常情况报警是一个系统的必备基础能力,API网关作为用户业务流量入口,天生是业务观测最佳位置。阿里云的API网关将所有业务访问日志同时同步到了阿里云的三个产品中:日志服务(SLS)、应用实时监控服务(ARMS)、云监控服务,用户可以在不同的云产品中通过不同的方式去观测与监视自己的业务监控情况。

- 通过日志服务(SLS)查看每一个请求的详细情况,包括请求和应答、后端服务耗时等细节;

- 通过应用实时监控服务(ARMS)观测整个请求链条中,每个网络节点的耗时请求,对全链路耗时情况进行分析;

- 通过云监控服务,对所有业务日志进行监控,并可以根据业务情况针对后端应答码、后端服务耗时设置报警规则。

请求与应答大小限制

在调用类ChatGPT的API的时候,请求和应答中存在需要传输文件的场景,比如传输一张图片给ChatGPT,或者从ChatGPT中下载一个生成的视频文件。阿里云API网关在请求和应答的限制上针对类似场景给出非常优化的限制:

- Request Body大小,共享实例最大为8MB,专享实例最大为32MB。

- Response Body大小,无限制,但需要在API设置的后端超时时间内返回。专享实例后端超时时间最大允许为90秒。

性能

性能是所有API网关的一个非常核心的一个指标,所有业务请求都需要过API网关,API网关的性能会是整个系统性能指标的的非常关键的一环。阿里云API网关商业化后在公有云对公众用户提供服务七年有余,在性能上做个多次大幅度的优化,可以给大家分享两个2022年统计的两个专享实例的关键性能指标:98.17%的请求在API网关耗时在1毫秒以内,99.23%的请求在API网关耗时在2毫秒以内。

阿里云的API网关除了性能优秀,本身耗时极低,还可以为用户提供无限扩容的专享实例,可以为用户生成支持超过百万RPS的专享实例,在性能上和容量上彻底打消后顾之忧。

小结

在AI成为基础设施的今后,以AI为基础的应用会随着AI能力的普及大量地出现在人们的视野中。未来以AI作为基础设施的应用系统架构中,使用阿里云的API网关作为统一API入口,将AI能力的复杂性包装在API网关内,提供统一的鉴权、流控等基础能力。API网关内部集成了阿里云日志监控类云产品,为用户提供API调用统计、全链路监控、报警等功能,方便对API进行管理和维护,提高接口的稳定性和可靠性。API网关提供极高的并发能力和扩容能力,可以满足高并发的业务需求。

本文为阿里云原创内容,未经允许不得转载。

版权声明:本文为博主作者:阿里云云栖号原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/yunqiinsight/article/details/130482172