概览简介

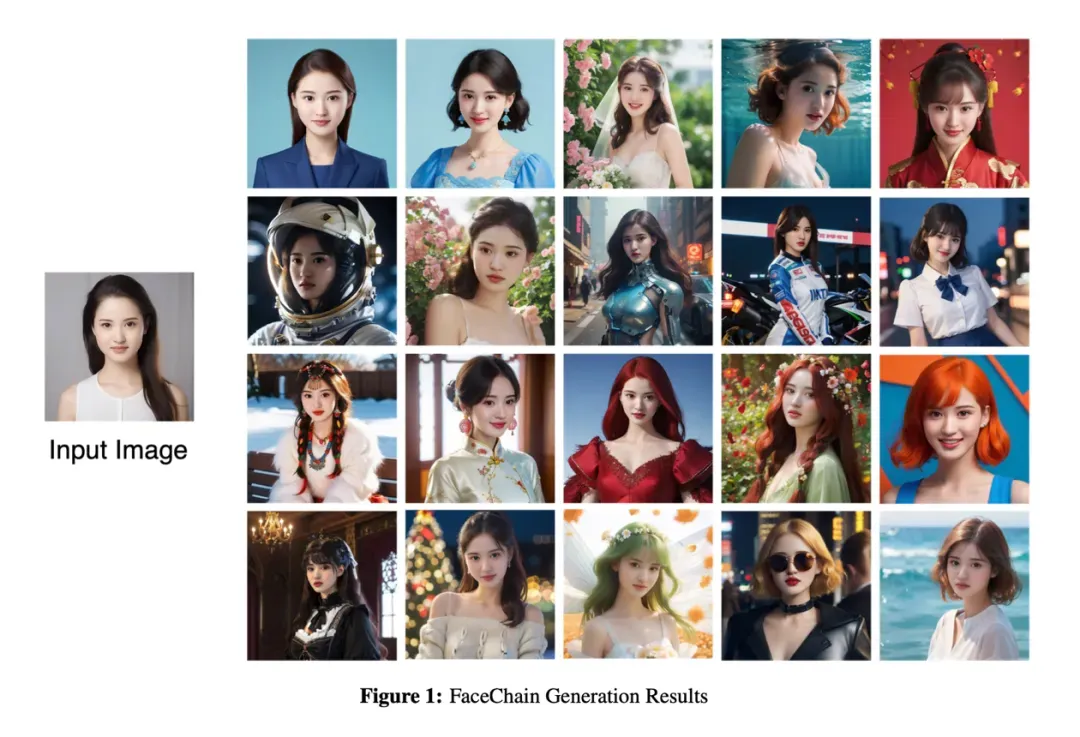

FaceChain 是一个可以用来打造个人数字形象的深度学习模型工具平台。用户仅需要提供最低一张照片即可获得属于自己的个人形象数字替身。结合不同的风格模型和写真模版,可以生成超乎想象空间的个人写真作品。

更有意思的是,FaceChain 还集成了说话人与虚拟试衣的功能,让你的数字替身更加生动真实,拓展出了更多的商业价值与落地场景。FaceChain 自 8 月份首次开源 v1 版本以来,主要做了以下几件事:

1. 推动社区发展(包含但不限于制作教学直播/录播视频、培训课程进大学、创建开发者社区等);

2. 推动应用发展(包括但不限于老人 AI 写真慈善行、开发灵积 dashscope API、万相写真馆应用等);

3. 核心功能迭代:one-shot 训练、无限风格计划、SDXL 提升图像细腻度,增加虚拟试衣、说话人视频、动漫风格化等功能。

相关物料如下:

开源项目:

https://github.com/modelscope/FaceChain

论文地址:

https://arxiv.org/abs/2308.14256c

在线免费体验:

https://tongyi.aliyun.com/wanxiang/app/portrait-gallery

https://www.modelscope.cn/studios/CVstudio/cv_human_portrait/summary

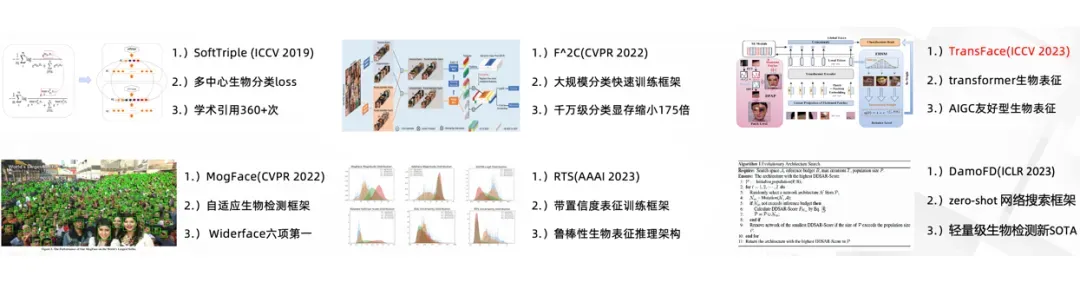

FaceChain 团队在人物感知理解技术上有较强的基础。本年度有 TransFace(ICCV 2023)、DamoFD(ICLR 2023)两篇中稿工作,另外还有多篇在投中。在人物感知理解方向的投入,团队旨在利用更便捷、表征能力更强的框架来完成 AIGC 时代下的感知理解技术升级,以进一步推动人物 AIGC 应用的发展。相关节选代表文章如下:

接下来,首先为大家介绍 FaceChain v2 带来的基本功能优化,其次介绍 FaceChain v2 的拓展功能,最后剧透 FaceChain v3 版本的未来规划。

功能优化

1. one-shot训练

为了尽可能实现 one-shot 训练的能力,FaceChainv2 着重在 1)如何减小训练样本的分布空间;2)通过 pretrain 提供更好的训练初始点;3)寻找合适的 lora 训练超参等三方面入手。

最终通过大量的实验,目前已经沉淀出了较为稳定的 one-shot 训练能力。80% 的情况下,用户可以通过单张图上传就能完成相应人物 lora 的 finetune 训练,从而获得专属的个人形象模型,这大大降低了训练成本。在训练式人物写真方法上,FaceChain 首次将训练成本降低到了 SOTA 商业应用的 1/10,做到了近 one-shot 的训练能力。相应结果示意如下:

此外,FaceChain 还在研发 train-free 的保 ID 人物生成方法,目前内部实验上已显著超过 IP-Adapter 的效果,预计将会在 FaceChain v3 版本中做发布,简称 FaceChain-FaceAdapter 技术。

2. 无限风格计划

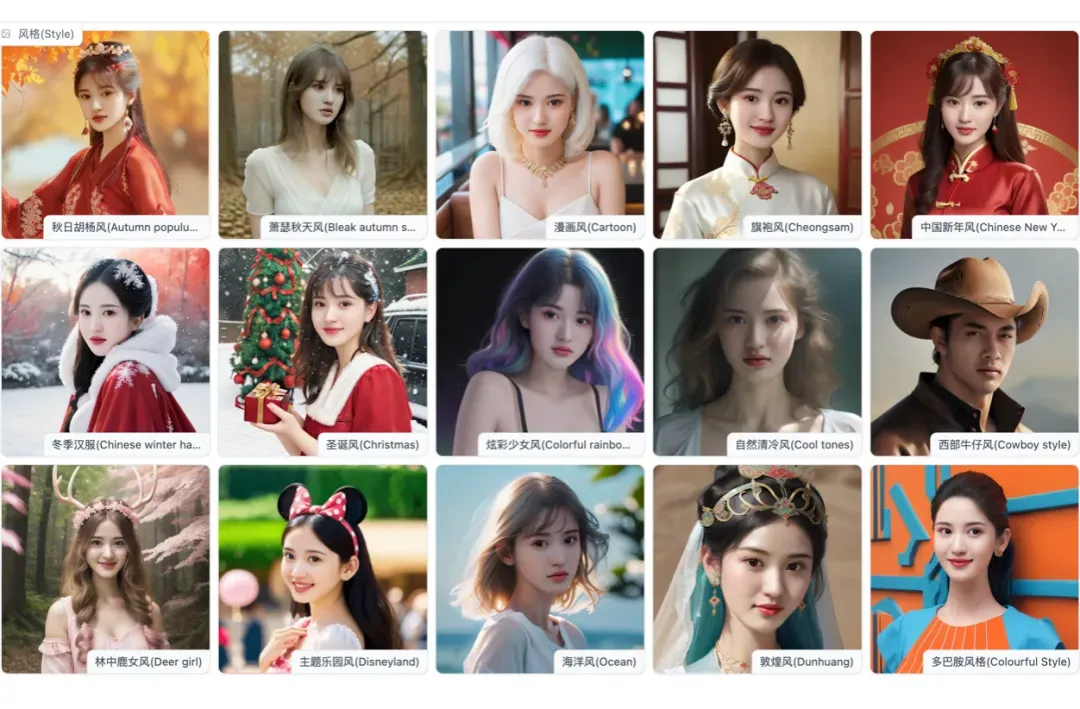

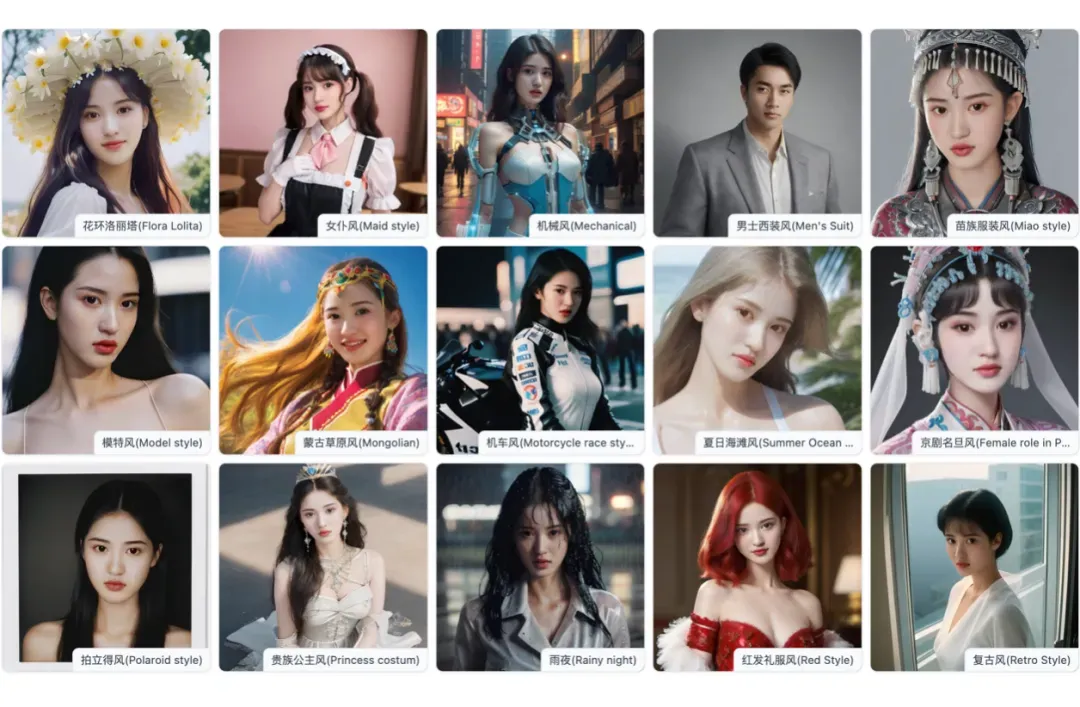

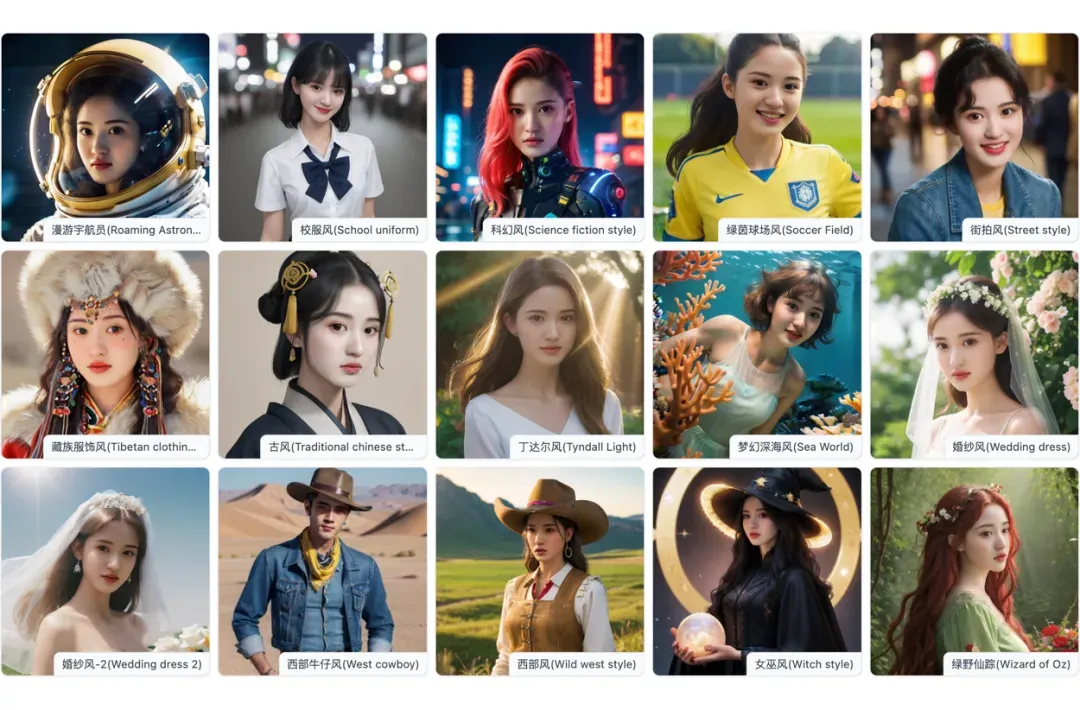

相较于 FaceChain v1 初始版本,v2 版本增加了上百种精美的风格,重点是全部免费。目前在众多的图片/视频分享网站上,已经有非常多介绍如何使用 FaceChain 做免费精美写真生成的视频,FaceChain 俨然已经成为免费精美写真制作的强力工具。

除此之外,还有很多自由职业者在用 FaceChain 为用户提供写真服务,以及很多开发者及企业在做 FaceChain API 的接入。针对无限风格计划,FaceChain预计将在 FaceChain v3 版本中提供一键式的写真风格训练接口,为写真风格的制作提供便捷且高可用的一键化训练接口,简称 FaceChain-StyleMaker 技术。部分开源免费精美风格:

3. SDXL写真质感

FaceChain v2 集成了强大的文生图模型 SDXL 1.0。SDXL 1.0 是 Statbility AI 发布的新一代文生图模型,通过各种严格的实验验证,SDXL 已经超越了各种版本的 Stable Diffusion 模型,并且与当前商业级文生图模型 Midjournal 生成效果不相上下。在 SDXL 的加持下,FaceChain 的人像生成的质感有了质的飞跃,下图是 FaceChain 基于 SDXL 的生成结果:

可以看到:1)在生成细节上,生成的图像在细节上更加细腻有质感;2)在背景虚化上,生成图像的虚化更加的动态、有层次;3)在人物神态上,生成的模特表情更加自然传神,微笑更加温柔亲和。

FaceChainv2 与 SDXL 的结合将为用户开启高质量的开源 AI 写真体验。当然目前离专业级摄影光效等,还是有进一步的优化空间,这部分建议做更多独有的 lora 特效模型训练,往后应该会有越来越多的摄影光效 lora 的出现。为进一步提升写真出图质量,FaceChain 预计将在 v3 版本征集更多的摄像特效 lora 或者行之有效的特效方案,简称 FaceChain-SpecialEffects 技术。

功能拓展

1. 虚拟试衣

虚拟试衣这个话题由来已久,电商行业兴起后,就有相关的研发讨论。由其所见即所得的属性,它可以进一步提升用户服装购买体验。它既可以为商家做商品展示服务,也可以为买家做上身体验服务,这让它同时具备了 B 和 C 的两个用户属性。随着 AIGC 的兴起,虚拟试衣也取得了一定的突破,FaceChainv2 拓展了虚拟试衣功能,其效果图如下所示:

根据是否需要对衣服做变形生成来划分,虚拟试衣又可分为形变保 ID 与非形变保 ID。其中非形变保 ID(局部保 ID)部分已在 FaceChainv2 中开源,另外形变保 ID 虚拟试衣技术已投递 CVPR,预计将在 FaceChain v3 中开源,简称 FaceChain-TryOn 技术。

2. 说话人视频

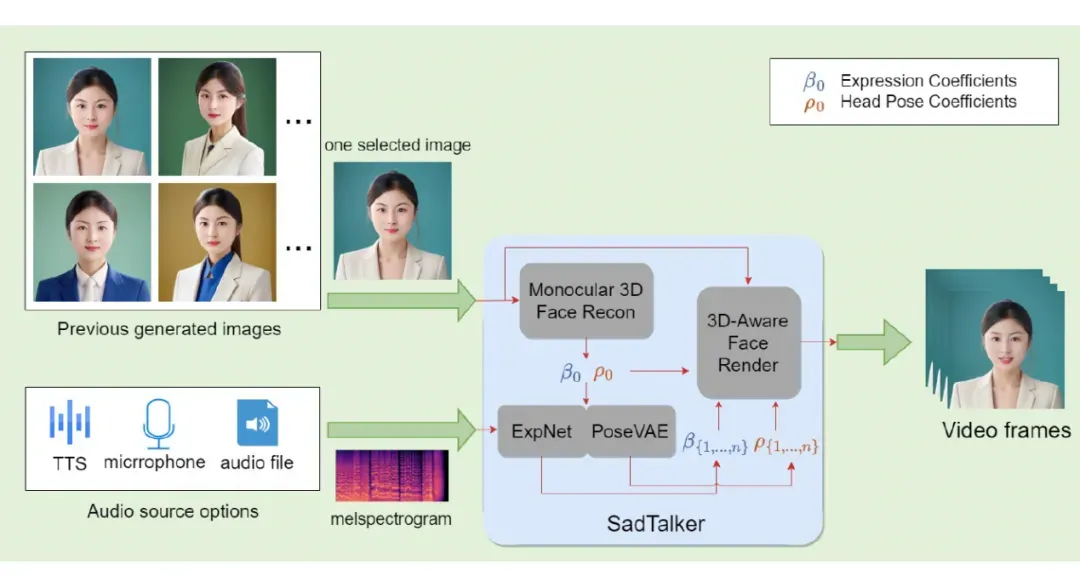

说话人生成旨在将给定的肖像动态化,使其的嘴唇运动和音频高度一致,这在数字人应用中至关重要。FaceChain v2 集成了主流的开源算法 SadTalker,相较于其他算法 Wav2Lip 和 video-retalking,SadTalker 可以控制头部姿态和面部表情,并且还可控制眨眼频率,能够输出更生动的说话视频。

除了原始的驱动功能,FaceChain v2 的说话人视频模块还支持使用 GFPEN 作为后处理来提高生成质量,同时对于音频输入,支持三种选项,包括 1)TTS 合成,2)麦克风录制,和 3)本地文件上传,用户可以根据自己的需要来选择输入。

此外,用户可以从之前生成的写真照片中选择一张进行驱动,由此串联了写真照生成功能和说话人生成两个功能,从而满足了用户多样且丰富的生成需求。整个处理链路如图所示:

在 FaceChain v3 版本中,人物视频生成将是最主要的应用更新方向,FaceChain 团队在 v3 版本中将发布 FaceChain-video 功能,会覆盖 MagicTalker,MagicSinger,MagicLife,MagicDay,MagicMove 等视频功能。

3. 动漫风格化

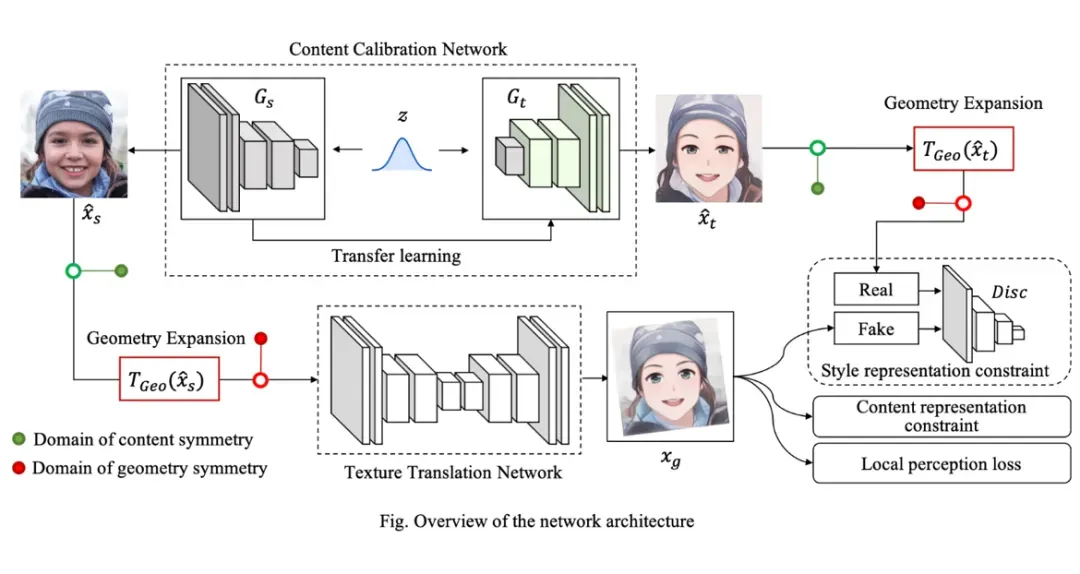

动漫风格化可以将输入图片的人物图像转化成二次元虚拟形象,返回卡通化后的结果图像。FaceChain v2 集成了 DCT-Net 人像卡通化模型,DCT-Net 模型同时提供人脸的 2D 动漫,3D,手绘,素描,美术风格的人脸转换,目前 FaceChain 仅支持 2D&3D 动漫人脸生成。DCT-Net 对训练数据的 scale 要求较低,给定一小部分目标风格样本,就能学习映射关系,将原风格迁移到目标风格,并保留原图内容信息。

同时,DCT-Net 不仅有更好的人脸风格迁移质量及泛化能力,还能做人物全身图片的风格迁移。它的「先校准再生成」新思路,就是让少数目标形成的目标风格域与原始域对齐,再以此辅助网络,让模型更好学习原风格和目标风格的映射关系,并利用几何扩展模块减小空间约束,使风格迁移效果更为准确,又不丢失原始图片信息。网络 Pipeline 如下:

未来规划

FaceChain v3 版本将在功能优化与功能拓展两方面持续发力:

1. 功能优化层面,会着重聚焦于 zero-shot 以及 RLHF 框架下的 human aigc 方案,在提升效果上限的同时也大幅降低计算需求到 CPU 级;

2. 功能拓展层面,会着重聚焦于人物视频生成 FaceChain-video 方向,包括但不限于 MagicTalker,MagicSinger,MagicLife,MagicDay,MagicMove 等人物视频功能。

此外,团队还将持续打造 AIGC 友好型的人物感知理解技术,为人物 AIGC 应用打造更便捷的感知理解基础设施。

综上,身在 AI 浪潮之上,FaceChain 团队将责无旁贷持续做人物感知理解与生成的前沿学术研究及其应用开源,为人物 AIGC 的发展贡献绵薄之力。有志同道合的同学想一起合作的话,可以联系 FaceChain 团队。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

·

·

版权声明:本文为博主作者:PaperWeekly原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/c9Yv2cf9I06K2A9E/article/details/135142992