多梯度下降算法

考虑如下的无约束多目标优化问题:

一般的做法是对多个目标作加权处理得到一个单目标的函数,然后利用梯度下降,智能优化算法如状态转移算法,遗传算法等求解。当然,也可以直接利用智能优化算法求解上述问题,得到一组Pareto解。尽管智能优化算法在求解全局最优解方面相对梯度下降算法有着一定优势,但其求解速度往往是比较慢的。那么,有没有基于梯度的算法来求解问题(1)呢?答案是有的,这就是多梯度下降算法 (Multiple Gradient Descent Algorithm (MGDA)) ,参见文献12:

梯度下降

我们都知道,对于无约束的单目标优化问题,利用梯度下降算法,在足够小的步长下,能保证下一步的值比上一步要小,其更新方式:

, 其中

为步长,

为搜索方向,当

时, 该算法也叫最速下降算法。为得到此结论,首先对

进行泰勒展开:

由上式可知函数沿着

方向下降的速率为:

其中 为梯度

和搜索方向

间的夹角,不难看出,要使得函数f(x_k) 沿着

下降(也即

),夹角

应大于90度,也即

; 要使得下降速率最大,夹角

应该为180度,

为梯度的相反方向

, 因此此时

也可表示为:

多梯度下降

上面可以看出,梯度下降的本质其实是找到一个搜索方向 使得

, 那么对于多目标问题,如果能找到一个搜索方向

使得

, 则该方向会使得所有目标函数都朝着下降的方向去更新,那怎么求一个最速下降的搜索方向呢?上文提到过,对于单目标的梯度下降,搜索方向可通过求解问题(2), 类似的,多梯度下降的方向可通过求解下面的优化问题3:

其思路也比较清楚,首先最大化 , 然后的过程和问题(2)一样,就是要使得

最大的值也小于0,那么这样就达到了

能使得所有目标函数下降的目的。不过 (3)并不好解,因此我们将其转化成:

该问题的对偶问题为4:

且问题(4)的KKT条件为: 3。可以看出, d_k为

的一个凸组合。

根据问题(3)可以看出,如果说不存在这样的使得

, 则(3)的最优解

,此时算法无法继续更新,达到Pareto最优点。如果存在这么一个

使得

,则有

。因此,假设

为问题 (4) 的解,则可得到如下推论1:

- 如果

是Pareto最优解,则

,

- 如果

不是Pareto最优解,则有:

两个目标的场景

在两个目标的场景下, 其中,

。可通过求解

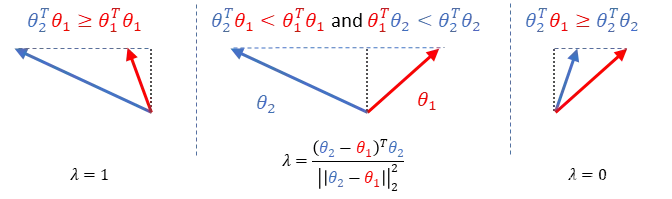

,其示意图如下:

上图较为直观,图中间的情况可通过对目标函数求导得到, 这里不做细致的推导,可参考文献567 。

应用场景

目前该算法已被应用到多个领域,如多任务学习5,多车牌识别67, 联邦多目标学习8等。

-

Fliege J, Svaiter B F. Steepest descent methods for multicriteria optimization[J]. Mathematical methods of operations research, 2000, 51: 479-494. ↩︎ ↩︎

-

Désidéri J A. Multiple-gradient descent algorithm (MGDA) for multiobjective optimization[J]. Comptes Rendus Mathematique, 2012, 350(5-6): 313-318. ↩︎

-

Fliege J, Vaz A I F, Vicente L N. Complexity of gradient descent for multiobjective optimization[J]. Optimization Methods and Software, 2019, 34(5): 949-959. ↩︎ ↩︎

-

Liu S, Vicente L N. The stochastic multi-gradient algorithm for multi-objective optimization and its application to supervised machine learning[J]. Annals of Operations Research, 2021: 1-30. ↩︎

-

Sener O, Koltun V. Multi-task learning as multi-objective optimization[J]. Advances in neural information processing systems, 2018, 31. ↩︎ ↩︎

-

周晓君,高媛,李超杰,阳春华.基于多目标优化多任务学习的端到端车牌识别方法[J].控制理论与应用,2021,38(05):676-688. ↩︎ ↩︎

-

Zhou X, Gao Y, Li C, et al. A multiple gradient descent design for multi-task learning on edge computing: Multi-objective machine learning approach[J]. IEEE Transactions on Network Science and Engineering, 2021, 9(1): 121-133. ↩︎ ↩︎

-

Z. Hu, K. Shaloudegi, G. Zhang and Y. Yu, “Federated Learning Meets Multi-Objective Optimization,” in IEEE Transactions on Network Science and Engineering, vol. 9, no. 4, pp. 2039-2051, 1 July-Aug. 2022, doi: 10.1109/TNSE.2022.3169117. ↩︎

版权声明:本文为博主作者:lieyiyang原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/lieyiyang/article/details/129458068