安装

https://github.com/Mozilla-Ocho/llamafile

下载

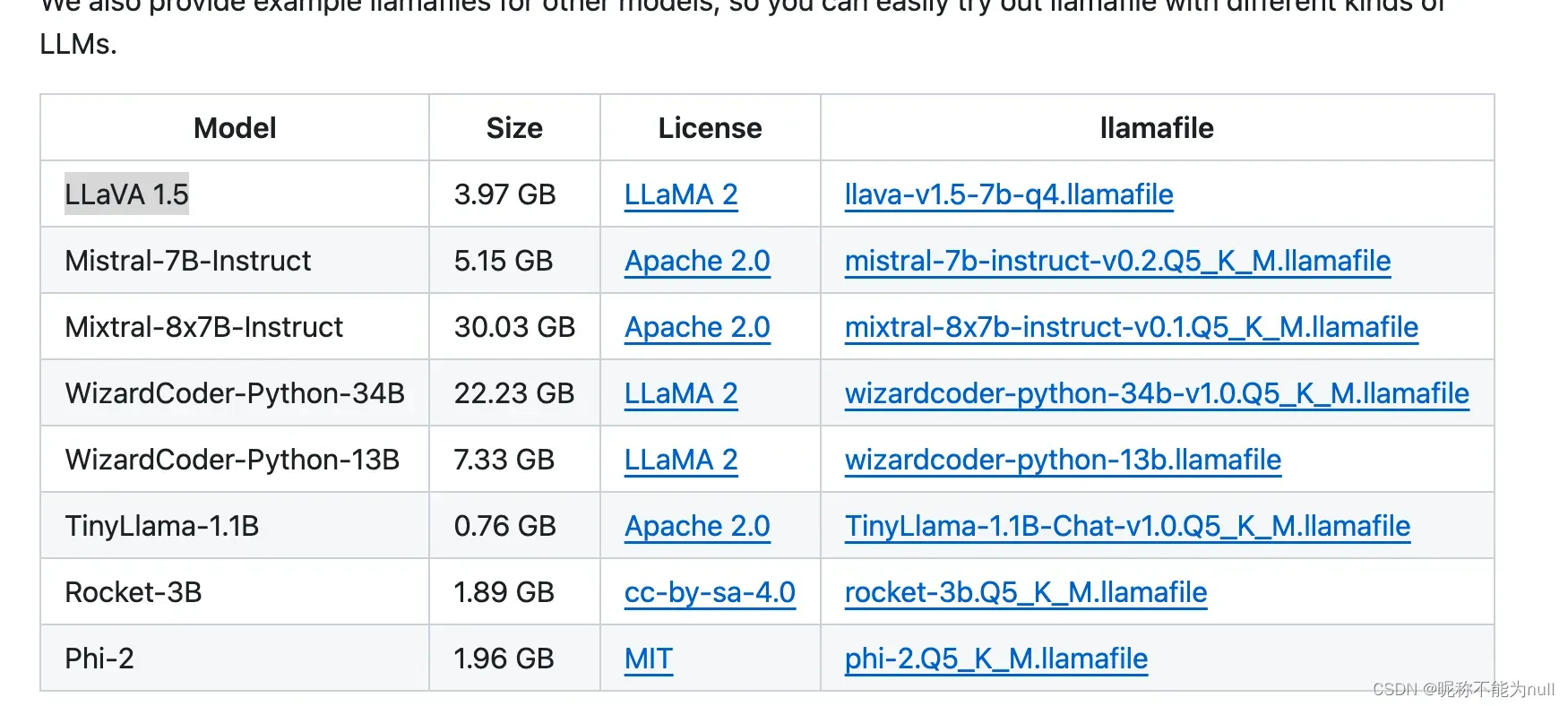

大模型文件,选择列表中任意一个

wget https://huggingface.co/jartine/llava-v1.5-7B-GGUF/resolve/main/llava-v1.5-7b-q4.llamafile?download=truehttps://github.com/Mozilla-Ocho/llamafile?tab=readme-ov-file#other-example-llamafiles

这里选择LLaVA 多模态的

使用

chmod +x llava-v1.5-7b-q4.llamafile

./llava-v1.5-7b-q4.llamafile

# --host xx.xx.xx.xx --port 8080默认打开http://127.0.0.1:8080 即可开始对话

版权声明:本文为博主作者:昵称不能为null原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/HDF734839030/article/details/137008392