如何选择适合深度学习的GPU?

- 为什么GPU比CPU更适合机器学习或者深度学习?

- 什么是张量处理单元(TPU)?

- 目前主流的GPU厂商:Nvidia和AMD

- 选择GPU时需要关注的主要属性

- 什么样的显卡适合我们?

- 还有哪些选择GPU的建议?

- 总结一下

- 参考资料

当我们在学习机器学习或者是深度学习的时候,训练深度神经网络模型的时候,经常使用GPU而不是CPU,这是因为在处理深度神经网络方面,GPU的处理能力优于CPU。

但是,很多人并不十分清楚我们到底需要什么样的GPU?因此,本文给大家做一些简单的分析,并提出一些建议。

为什么GPU比CPU更适合机器学习或者深度学习?

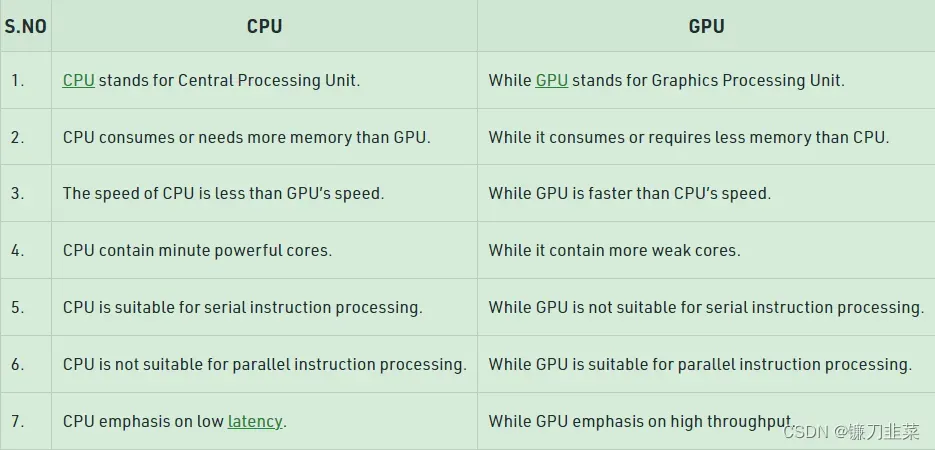

CPU(中央处理器)是计算机的核心,它非常灵活,不仅需要处理来自各种程序和硬件的指令,并且处理速度也非常优秀。为了在这种多任务环境中表现出色,CPU具有少量且灵活快速的处理单元(也称为核)。

GPU(图形处理单元)在多任务处理方面不那么灵活。但它可以并行执行大量复杂的数学计算。这是通过拥有更多数量的简单核心(数千个到上万)来实现的,这样可以同时处理许多简单的计算(并行计算)。

并行计算的要求非常适合于:

- 图形渲染——移动的图形对象需要不断地计算它们的轨迹,这需要大量不断重复的并行数学计算。

- 机器和深度学习——大量的矩阵/张量计算,GPU可以并行处理。

- 任何类型的数学计算,可以拆分为并行运行。

下图是CPU和GPU的主要区别:

什么是张量处理单元(TPU)?

随着深度学习的发展,有了更专门的处理核心,称为张量核(Tensor cores)。在执行张量/矩阵计算时,它们更快更有效。为什么使用张量处理单元,是因为在机器/深度学习中所处理的数据类型就是张量。

目前主流的GPU厂商:Nvidia和AMD

目前,使用最多的GPU来自Nvidia。虽然可以使用AMD的GPU进行机器/深度学习,但是目前来看,Nvidia的GPU具有更高的兼容性,对于生态的支持比较好,也就是说,通常可以更好地集成到TensorFlow和PyTorch等工具中(比如目前PyTorch的AMD GPU的支持还只能在Linux上使用)。

使用AMD GPU需要使用额外的工具(ROCm),这个会有一些额外的工作,并且版本可能也不会更新的很快。这种情况将来可能会有所改善,但是现在为止,最好还是使用Nvidia。

选择GPU时需要关注的主要属性

选择一个适合机器学习或深度学习,重要的是符合预算的GPU,需要考虑四个因素:

- GPU有多少内存?

- GPU有多少个CUDA和/或张量核?

- 这个GPU显卡使用了什么芯片架构?

- GPU的功耗是多少?(可选)

下面我们一一介绍。

1. GPU的内存需要多少?

当然是越多越好!实际上取决于你的任务,以及这些模型有多大。如果你正在处理图像、视频或音频,那么你将处理相当大量的数据,GPU RAM将是一个非常重要的考虑因素。

可能有人会说,总有办法解决内存不足的问题(例如减少批处理大小)。但是这将会浪费训练的时间,如果在预算充足的时候,还是选择内存大的GPU。

下面是根据经验的一些建议:

- 4GB:这是绝对的最小值,只要你不是在处理过于复杂的模型,或者大的图像、视频或音频,这个在大多数情况下能工作,但是达不到日常使用的需要。

- 8GB:这是一个适合日常学习的大小,可以在不超过RAM限制的情况下完成大多数任务,但在使用更复杂的图像、视频或音频模型时会遇到问题。

- 12GB:这是科研最基本的的要求。可以处理大多数较大的模型,甚至是那些处理图像、视频或音频的模型。

- 12GB+ :越多越好,这样你将能够处理更大的数据集和更大的批处理大小。超过12GB才是价格真正开始上涨的开始。

一般来说,如果成本相同的话,选择“速度较慢”但内存较大的GPU显卡会更好。但请记住,GPU的优势是高吞吐量,这在很大程度上依赖于可用的RAM来通过GPU传输数据。

2. 需要多少核心?是CUDA核心还是Tensor核心?

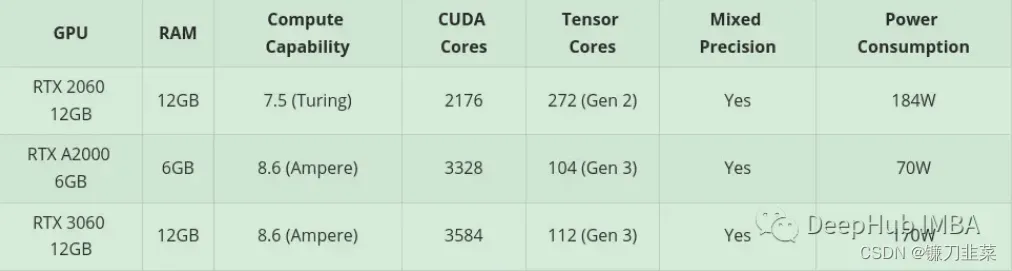

对于核心数目,越多越好!首先考虑内存,然后是计算核心。对于机器/深度学习来说,Tensor核比CUDA核更好(更快,更有效)。因为它们是为机器/深度学习领域所需的计算而精确设计的。

但是这并不是必须的,因为CUDA核已经足够快了。当然,如果有Tensor核的显卡,当然是更好的,但是显然可能会更贵。

下面是一些常见的CUDA相关的名词:

- CUDA核心——这些是显卡上的物理处理器,通常有数千个,4090已经1万6了。

- CUDA 11——这里的数字可能会改变,是指安装的软件/驱动程序的版本,以允许显卡正常的工作。Nvidia会定期发布新版本,它可以像任何其他软件一样安装和更新。

- CUDA代数(或计算能力)——这描述了显卡的更新迭代的代号,它由数字和一个代号来区分。

3. 哪一种GPU的芯片架构较好?

这实际上比你想象的更重要。但是这里我们不讨论AMD的GPU,因为我们推荐选择使用Nvidia的。

30系列的卡就是Ampere架构,40系列是Ada Lovelace。一般Nvidia都会使用一个著名科学家和数学家来对架构命名,40系列选择的是著名英国诗人拜伦之女,建立了循环和子程序概念的女数学家、计算机程序创始人Ada Lovelace来命名。

这里需要注意两个方面:

1)选择的芯片架构是否具有显著的功能改进

这里一个重要的功能就是:混合精度训练。首先介绍使用精度低于32位浮点数的数字格式的好处。

- 首先它们需要更少的内存,从而能够训练和部署更大的神经网络。

- 其次它们需要更少的内存带宽,从而加快数据传输操作。

- 第三数学运算在精度降低的情况下运行得更快,尤其是在具有Tensor Core的GPU上。

混合精度训练实现了所有这些好处,同时确保与完全精度训练相比不会丢失特定于任务的准确性。它通过识别需要完全精度的步骤并仅对这些步骤使用32位浮点而在其他任何地方使用16位浮点来实现这一点。

https://docs.nvidia.com/deeplearning/performance/mixedprecisiontraining/index.html

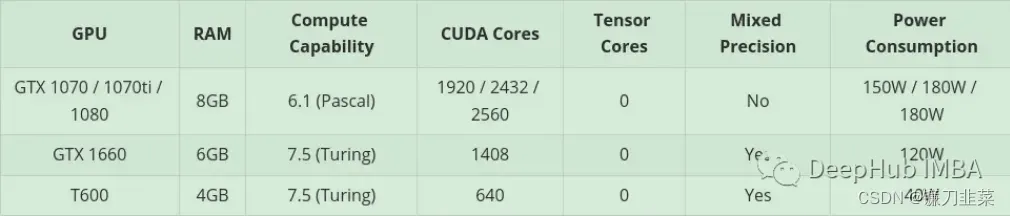

如果GPU具有7.x (Turing) 或更高的架构,才有可能使用混合精确训练。也就是说 桌面的RTX 20 系列或高版本,或服务器上的 “T”或“A”系列。

混合精度训练具有如此优势的主要原因:它降低了 RAM 使用率,Tensor Core的GPU会加速混精度训练,如果没有的话使用FP16也会节省显存,可以训练更大的批大小,间接提升训练速度。

2)选择的芯片架构是否会被弃用

如果对RAM有特别高的要求,但又没有足够的预算买高端卡,那么可能会选择二手市场上的老款GPU。这有一个相当大的缺点……那就是这张卡的寿命可能快要结束了。

举个例子:一个典型的例子就是Tesla K80,它有4992个CUDA核心和24GB的RAM。2014年,它零售价约为7000美元。现在的价格从150到170美元不等!(咸鱼的价格600-700左右)这么小的价格却有这么大的内存,也许你可能会很兴奋。但是这有一个非常大的问题。K80的计算架构是3.7 (Kepler),从CUDA 11起已经不支持这个芯片架构。这意味着这张卡已经废了,所以它才卖的这么便宜。所以在选择二手显卡时一定要看清楚它是否支持最新版本的驱动和CUDA程序,这是最重要的。

什么样的显卡适合我们?

Nvidia把他们的显卡分为两部分。高端游戏卡(消费类显卡)和工作站/服务器卡(专业级显卡)。

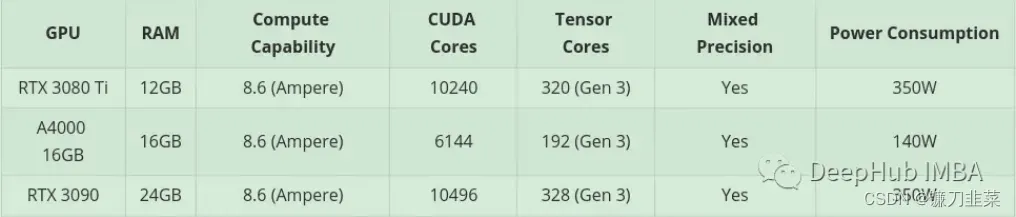

这两个部分之间有明显的区别,对于相同的规格(RAM, CUDA内核,架构),消费类显卡通常会更便宜。但是专业卡通常会有更好的质量,和较低的能源消耗(其实涡轮的噪音挺大的,放机房还可以,放家里或者试验室有点吵)。

高端(非常昂贵)的专业卡,可能你已经注意到它们有很大的RAM(例如RTX A6000有48GB, A100有80GB!)。这是因为它们通常直接针对3D建模、渲染和机器/深度学习专业市场,这些市场需要高水平的RAM。当然啦,如果你有充足的预算,买A100就对了!

还有哪些选择GPU的建议?

基于预算的需求,最后给出一些建议。这里将预算分为三个等级:低预算、中等预算和高预算。

- 对于高预算,还是那句话如果你有充足的预算:A100,H100尽情购买,比如王总。

- 对于低预算,可以从二手市场购买。还可以考虑一些专业桌面系列卡(T600、A2000和A4000),因为它的一些配置比同类消费类显卡稍差,但功耗明显更好。

- 中等预算

除了这些,如果不想花钱,还可以使用在线/云服务。可以利用谷歌Colab,它可以让你免费使用GPU。但这是有时间限制的,如果你使用GPU太长时间,他们会把你踢出去,然后回到CPU上。如果GPU处于非活动状态太长时间,可能是在你写代码的时候,它也会把GPU拿回来。GPU也是自动分配的,所以你不能选择你想要的确切的GPU(你也可以每月9.9刀弄个Colab Pro,我个人觉得要比低预算好很多,但是要求有梯子,$49.99的Colab Pro+有点贵,不建议)。

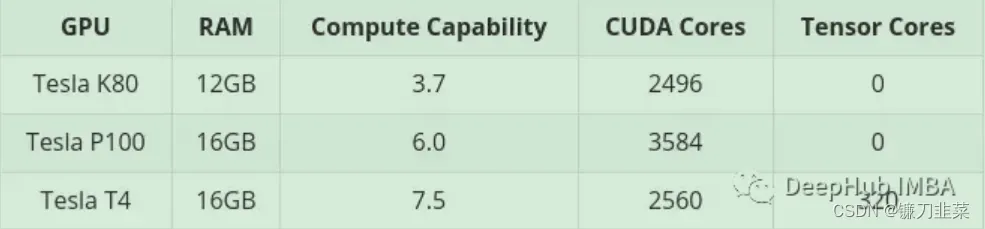

下面是通过Colab可以获得的GPU:

注意,K80有24GB的RAM和4992个CUDA核心,它基本上是两个K40卡连在一起。这意味着当你在Colab中使用K80时,你实际上可以访问一半的卡,所以也就是只有12GB和2496个CUDA内核。

总结一下

16384 CUDA + 24GB,对比3090 的10496 CUDA ,真的很香。而4080 16G的9728CUDA 如果价格能到7000内,应该是一个性价比很高的选择。对于AMD的 7900XTX 应该也是一个很好的选择,但是兼容性是个大问题。

参考资料

- https://mp.weixin.qq.com/s/tmwpuiCIwqz0bGm7-rsU2g

- https://blogs.nvidia.com/blog/2009/12/16/whats-the-difference-between-a-cpu-and-a-gpu/

- https://www.geeksforgeeks.org/difference-between-cpu-and-gpu/

文章出处登录后可见!