大家好,我是微学AI,今天给大家介绍 深度学习技巧应用2-神经网络中的‘残差连接’。

一、残差连接介绍

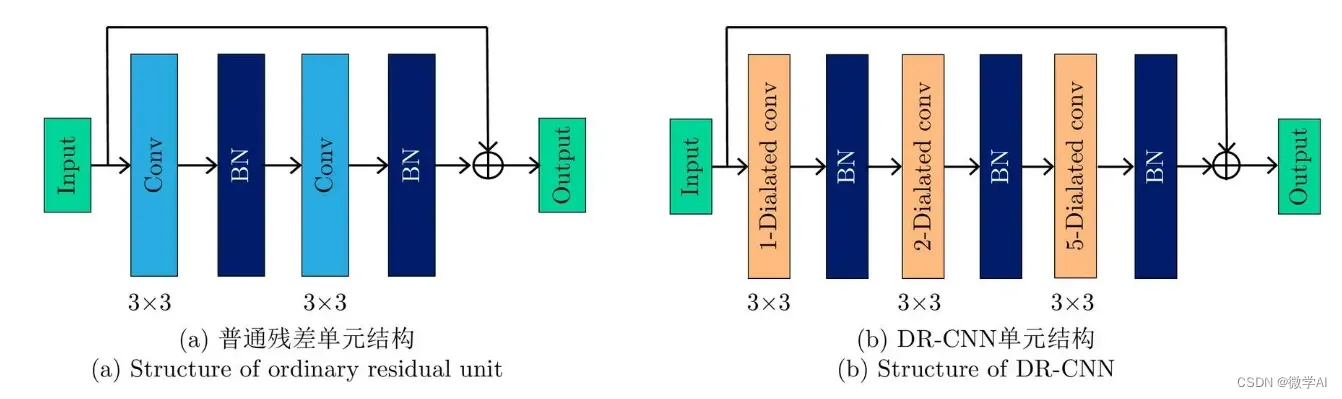

残差连接是一种神经网络中的一种运用技巧。由于深层网络容易出现梯度消失或梯度爆炸的问题,因此可以通过残差连接的方式,将网络的深度扩展到数十层以上,从而提高模型的性能。残差连接的基本思想是,在网络的某些层中,将输入的信号直接连接到输出,从而在网络中引入“跨层连接”。

二、残差连接解决问题

残差连接技巧主要用于深度神经网络的训练中,尤其是在深度网络层数较多时。具体而言,残差连接技巧可以应用于以下几个场景:

解决梯度消失问题:深度神经网络的层数增加时,梯度的传播容易受到梯度消失的影响,导致训练困难。残差连接技巧可以通过跨层直接连接来提供捷径,从而缓解梯度消失问题。

提高模型性能:残差连接技巧可以增加模型的深度,从而提高模型的表达能力和性能。此外,由于残差连接可以提供跨层直接连接的效果,因此可以帮助模型更好地学习特征,从而进一步提高模型性能。

降低训练难度:残差连接技巧可以加速模型的训练,从而降低训练难度。由于残差连接可以提供跨层直接连接的效果,因此可以使模型更容易收敛,减少训练时间和计算资源的消耗。 总之,残差连接技巧在深度学习领域中具有广泛的应用价值,可以帮助深度神经网络更好地学习特征和提高性能,也可以降低训练难度和消耗。

三、残差连接原理

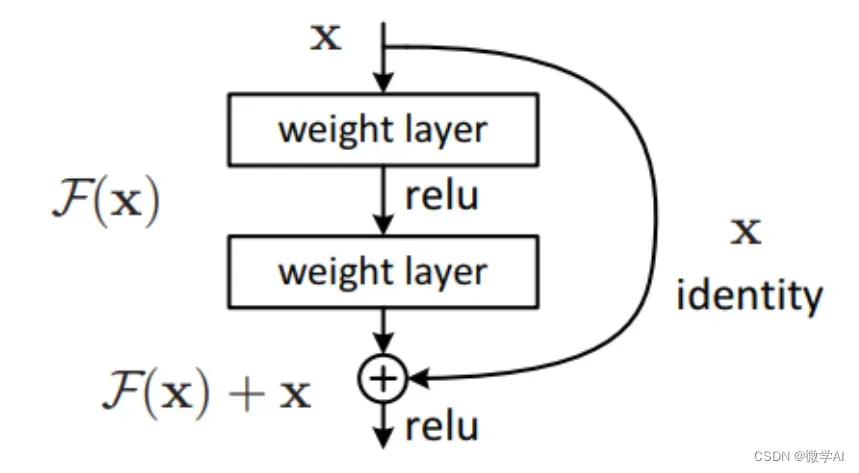

残差连接(Residual Connection)是指在神经网络中,将前一层的输出直接与后一层的输入相加,从而构成了一种跨层连接的方式。这种跨层连接的计算方式:

假设前一层的输出为,后一层的输入为

,则残差连接可以表示为:

其中 是后一层的非线性变换(例如 ReLU 或 sigmoid),+ 表示元素级别的相加运算。 这种跨层连接的主要目的是解决深度神经网络中的梯度消失和梯度爆炸问题。

在传统的神经网络中,每一层的输入都是前一层的输出,通过不断地进行非线性变换,逐渐提取高级别的特征。但是,随着网络层数的增加,梯度在反向传播过程中会逐渐变小,从而导致模型训练出现困难。 残差连接通过直接将前一层的输出加到后一层的输入中,使得梯度能够更容易地传递到前一层,从而使得深度神经网络的训练更加容易。此外,残差连接还能够减少模型的训练误差,并且可以提高模型的泛化能力,从而更好地适应未见过的数据。因此,在深度学习领域,残差连接已经成为了一种广泛使用的技术,被应用于各种神经网络模型中,例如 ResNet、DenseNet 等。

四、残差连接代码实例

下面举一个简单的全连接神经网络,包含若干个使用残差连接的残差块(ResidualBlock),这些残差块通过 nn.ModuleList 组成了一个残差网络(ResidualNet)。在每个残差块中,前一层的输出(即 identity)会被直接加到后一层的输入(即 out)中,从而实现了残差连接的效果。残差网络通过调用 forward 方法来进行前向传播。代码实例:

import torch.nn as nn

import torch

class ResidualBlock(nn.Module):

def __init__(self, in_features, out_features):

super(ResidualBlock, self).__init__()

self.linear1 = nn.Linear(in_features, out_features)

self.relu = nn.ReLU(inplace=True)

self.linear2 = nn.Linear(out_features, out_features)

def forward(self, x):

identity = x

out = self.linear1(x)

out = self.relu(out)

out = self.linear2(out)

out += identity

out = self.relu(out)

return out

class ResidualNet(nn.Module):

def __init__(self, in_features, hidden_features, out_features, num_blocks):

super(ResidualNet, self).__init__()

self.linear1 = nn.Linear(in_features, hidden_features)

self.relu = nn.ReLU(inplace=True)

self.blocks = nn.ModuleList([ResidualBlock(hidden_features, hidden_features) for _ in range(num_blocks)])

self.linear2 = nn.Linear(hidden_features, out_features)

def forward(self, x):

out = self.linear1(x)

out = self.relu(out)

for block in self.blocks:

out = block(out)

out = self.linear2(out)

return out下面构造一个大小为 的随机输入数据

# 构造输入数据

x = torch.randn(10, 5) # 输入数据大小为 10x5

# 构造残差网络模型

model = ResidualNet(in_features=5, hidden_features=10, out_features=2, num_blocks=2)

# 进行模型预测

y_pred = model(x)

# 输出预测结果

print(y_pred)更多细节,可以关注微学AI,欢迎私信与合作。

文章出处登录后可见!