Title: Efficient and Explicit Modelling of Image Hierarchies for Image Restoration

PDF: https://arxiv.org/pdf/2303.00748

Code: https://github.com/ofsoundof/GRL-Image-Restoration.git

导读

全局,区域和局部范围的特征可以很好地被神经网络用于图像恢复任务,本文提出了一种基于锚点Anchored的条纹自注意力机制用于实现全局范围依赖性建模,它在自注意力的空间和时间复杂度以及超越区域范围的建模能力之间取得了良好的平衡;其次提出了一种新的Transformer网络GRL,通过基于锚点的条纹自注意力机制,窗口自注意力和通道注意力,明确地模拟了全局、区域和局部范围内的图像层次结构特征。最后将提出的网络应用于七种图像恢复任务中,都达到了最先进的结果!

引言

::: block-1

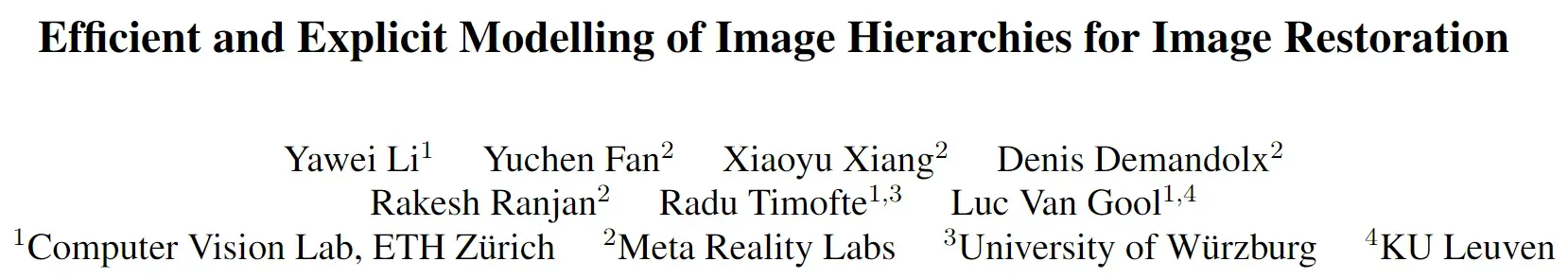

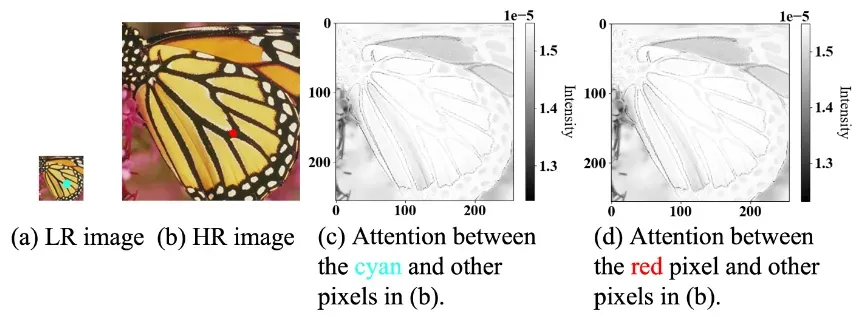

图1. 局部特征(边缘、颜色)和区域特征(粉色框处)可以很好地由卷积神经网络(CNN)和窗口自注意力进行建模。但相比之下,全局特征(青色矩形处)难以有效且明确地进行特征建模。

:::

图像恢复旨在从低质量图像恢复出高质量图像,这些低质量图像通常是由于图像退化过程(如模糊、降采样、噪声引入和JPEG压缩)导致的。因为在图像退化过程中,其重要内容信息缺失,所以图像恢复是一个具有挑战性的逆过程。因此为了恢复高质量图像,应该充分利用退化图像中展现出的丰富信息。

自然图像包含全局、区域和局部范围内的一系列特征,这些特征可以被深度神经网络用于图像恢复。 局部特征通常是一些边缘和颜色特征,由于其只跨度几个像素,所以可以使用小卷积核(例如3 x 3)进行建模捕获;对于区域特征,其通常跨度数十个像素,这一窗口区域特征通常可以覆盖一些小物体和大物体的某个部分(如上图1的粉色框),由于区域特征范围更大,因此可选择使用大卷积核进行建模,但其参数量和计算量未免过大且低效,因此带有窗口注意力机制的Transformer会是更好的选择;除了局部和区域特征之外,某些特征具有全局跨度性(图1中的青色矩形):主要体现在对称性和多尺度模式重复性(图1a),同一尺度的纹理相似性(图1b),以及大物体内容结构相似性和一致性(图1c),为了建模处理这个范围的特征,需要网络具备全局图像理解的能力。

上面提到的局部和区域范围特征可以很好的建模捕获,但全局特征的建模存在两个主要的挑战:

- 首先,现有的基于卷积和窗口注意力的图像恢复网络不能通过使用单个计算模块来明确捕获长距离依赖关系,因此全局图像理解主要通过将特征通过重复的计算模块进行逐步传播来实现。

- 其次,当图像的分辨率不断提高,长距离依赖建模面临计算负担的挑战。

上述讨论引出了一系列研究问题:

- 如何高效地在高维图像中对全局范围特征进行建模以进行图像恢复?

- 如何通过单个计算模块明确地建模图像层次结构信息(局部、区域、全局),以进行高维图像恢复?

- 这种联合建模如何能够在不同的图像恢复任务中带来统一的性能改进?

为此,本文围绕以上三个研究问题,逐一提出解决方案:

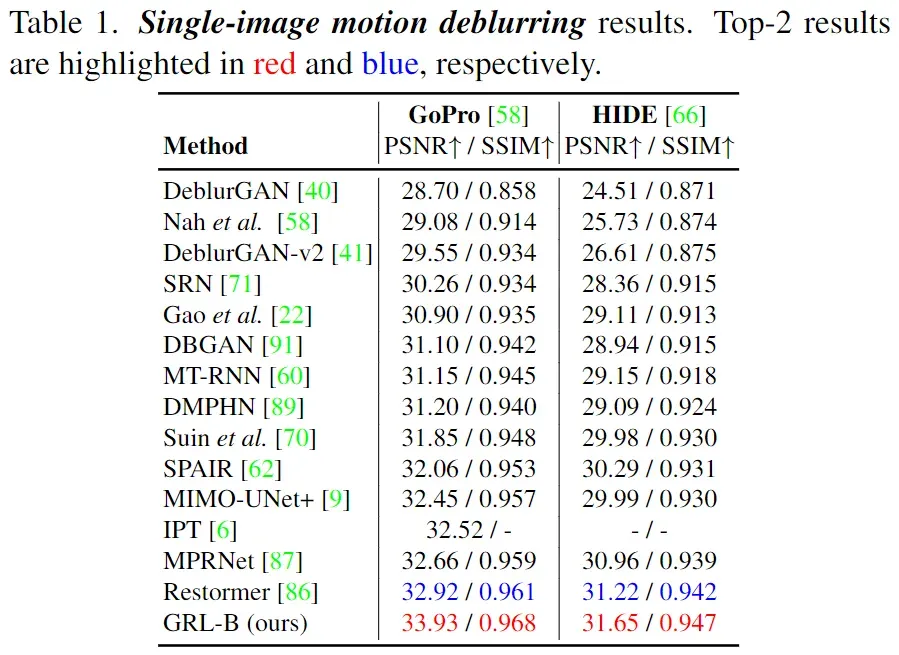

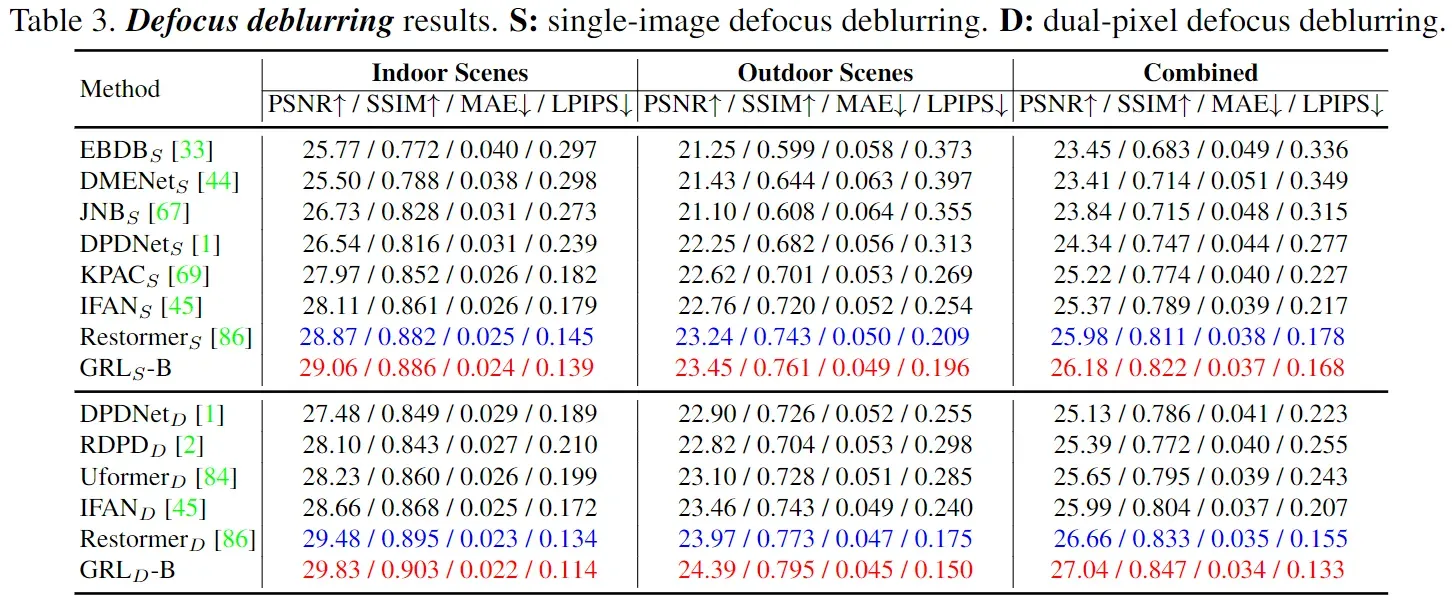

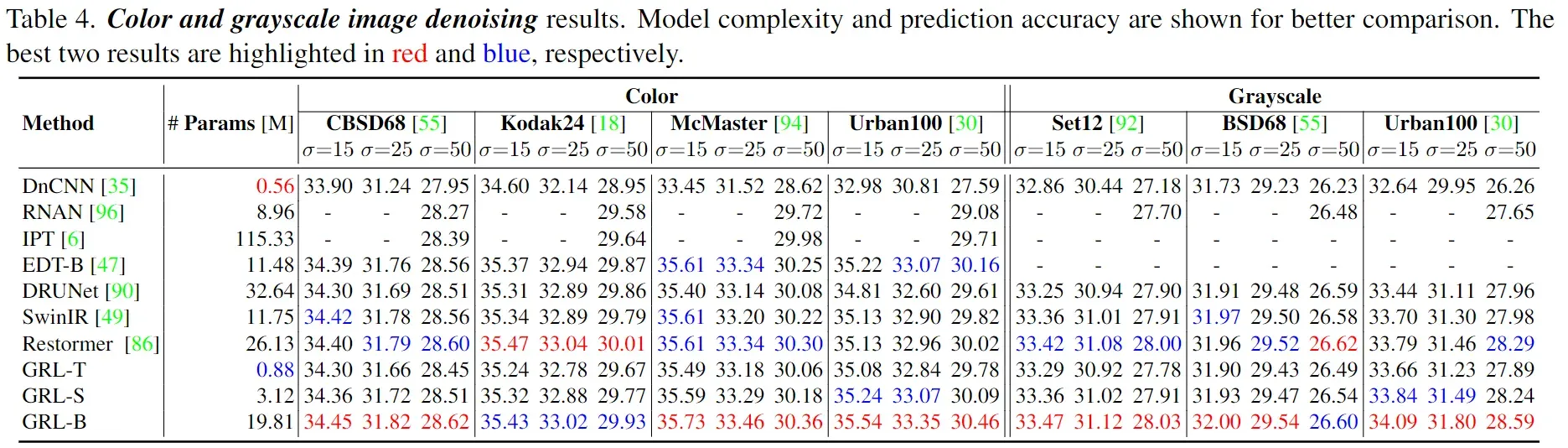

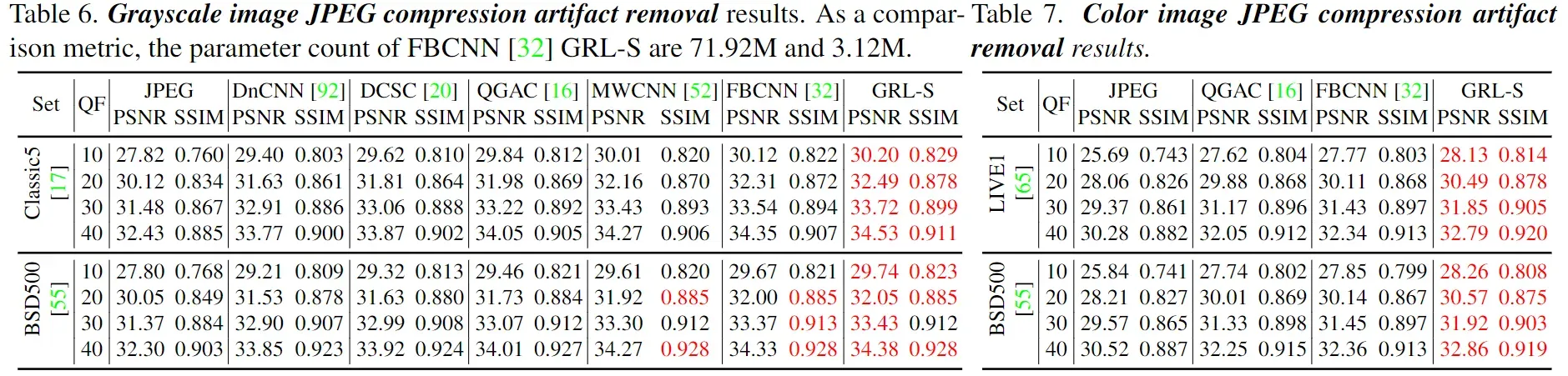

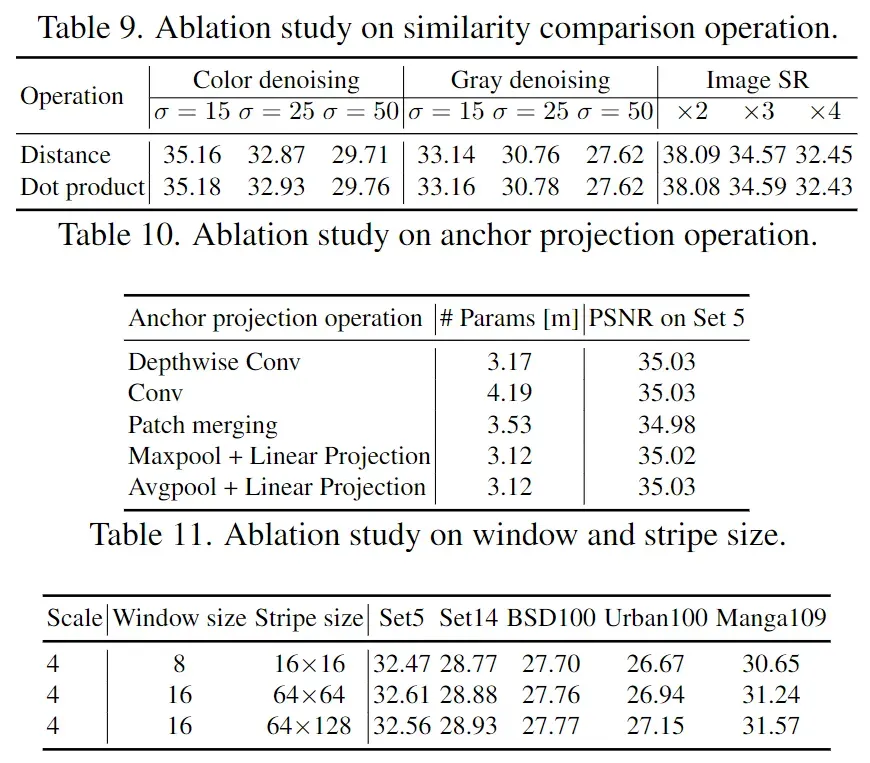

首先,本文提出了一种基于锚点的条纹自注意力机制用于实现全局范围依赖性建模;其次,提出了一种新的Transformer网络GRL用于在单个计算模块中明确地模拟全局,区域和局部范围的依赖关系;最后,所提出的GRL网络在七类图像恢复任务中(图像超分,去噪,JPEG压缩伪影去除,去马赛克,真实图像超分,单图运动去模糊,散焦去模糊)全部表现SOTA!如下图2所示:

::: block-1

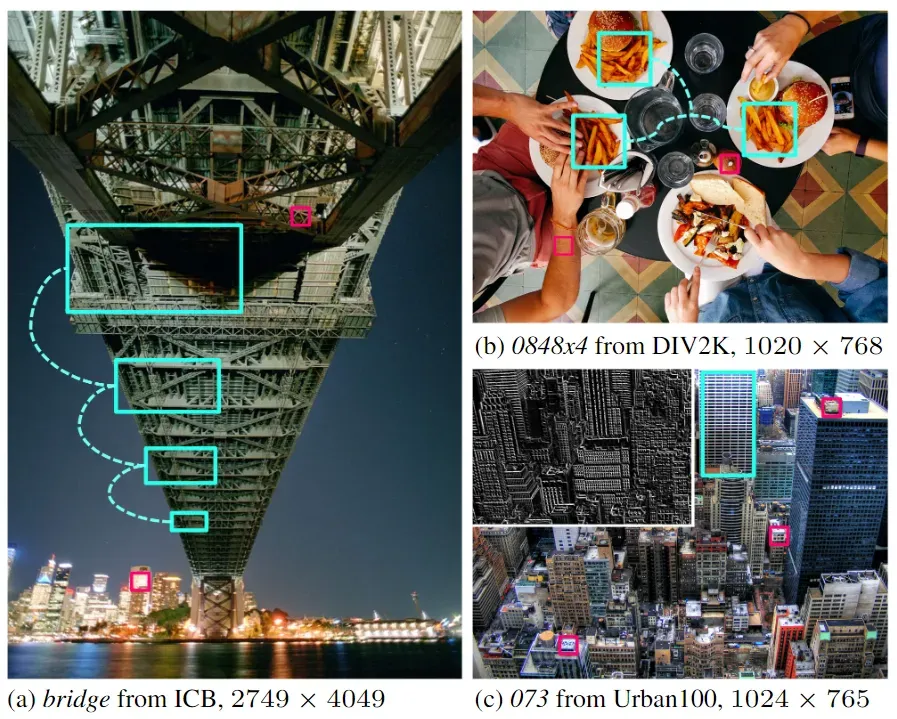

图2. 所提出的GRL网络在各种图像恢复任务中都实现了最先进的结果

:::

方法

::: block-1

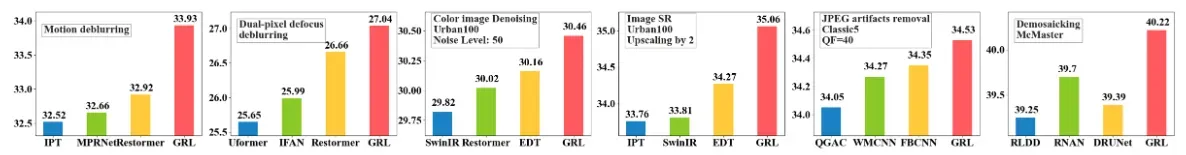

图3. 上图(a)展示了所提出的GRL网络架构图,它由多个

Transformer Layer组成。上图(b)展示了Transformer Layer计算模块,它由三个子模块组成并用于建模全局,区域和局部图像结构特征,其中基于锚点的条纹自注意力机制Anchored Stripe Attention用于建模全局图像结构特征,基于窗口的自注意力机制Window Attention V2用于建模区域特征,而两个串联的3 x 3卷积再接一个通道注意力Channel Attention可用于建模出高效的局部特征。 上图(c) 展示了基于锚点的条纹自注意力机制结构图,该注意力机制可以帮助网络捕获超越区域范围(全局)的图像结构特征。

:::

Transformer自注意力机制架构虽然可以很好的建模出长远距离依赖关系并以此捕获全局特征信息,但图像tokens数量众多导致计算量巨大。为了降低计算复杂度,所以可以在窗口区域进行自注意力,但该类基于窗口的自注意力机制受限于窗口大小,仅能捕获基于窗口区域的上下文特征信息。那么这就引出一个问题:如何在低计算量情况下,建模出超出窗口区域范围的特征呢?

::: block-1

图4. 上图(a)和(b)是来自两个不同分辨率的相同图片,(a)中蓝色的像素点和(b)中红色的像素点都取自相同的一个位置。图(c)表示了蓝色像素点和其它像素点的注意力图;图(d)表示了红色像素点和其它像素点的注意力图。我们可以发现:图(c)和图(d)注意力图是非常相近的,这就是本文所说的跨尺度相似性。

:::

作者通过如上图4发现了跨尺度相似性原理,于是作者想到了一个办法:通过对具有小分辨率的图像进行自注意力(小分辨率图像具有更少的tokens)来达到大分辨率图像进行自注意力的效果(基于跨尺度相似性原理),这就大大降低了计算量,而又可以有效建模出超越窗口区域范围的特征(全局特征)。

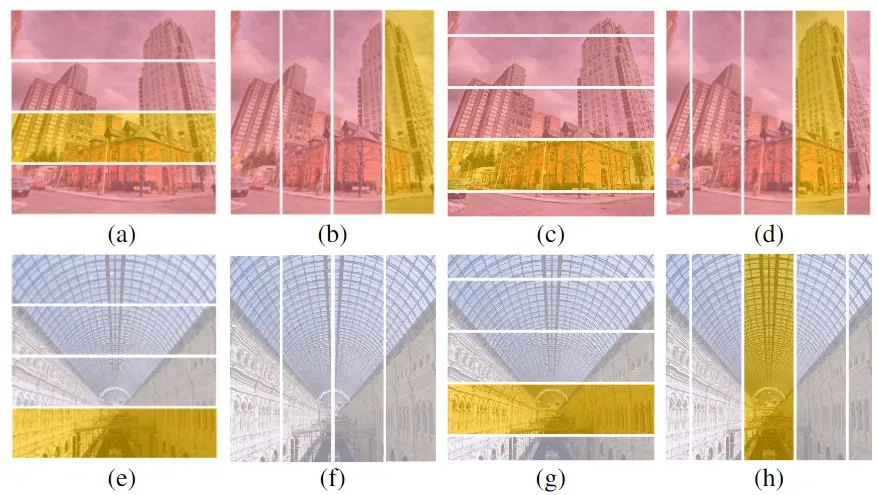

为了进一步降低计算量,作者发现了自然图像另一个重要的特性:自然图像的特征通常以非各向同性的方式出现,如上图5所示,图5©和(d)中的单个物体、图5(h)中的多尺度相似性、图5(e)和(g)中的对称性等。因此,全局范围的各向同性注意力对于捕捉非各向同性图像特征是多余的。基于此,文章提出了在非各向同性条纹内进行注意力处理的方法,该注意力机制包括四种模式:水平条纹、垂直条纹、平移水平条纹和平移垂直条纹。水平和垂直条纹的注意力机制可以在Transformer网络中交替使用。通过这种注意力方式,可以在保持全局范围建模能力的同时,降低全局自注意力计算的复杂度。

因此,再结合锚点的概念,提出了锚定条纹自注意力。对于这种注意力机制,利用引入的锚点在垂直和水平条纹内进行高效自注意力计算。

实验结果

结论

本文受到两个图像属性的启发:跨尺度相似性和各向异性图像特征,从而提出了一种高效的锚定条纹自注意力模块,用于建模图像的长远距离依赖关系。以此进一步提出了一种多功能网络架构GRL用于图像恢复任务,该网络可以有效的建模出全局,区域和局部范围的距离依赖关系,具备低计算量的同时,还在各大图像恢复任务中取得了最先进的结果。

写在最后

如果您也对人工智能和计算机视觉全栈领域感兴趣,强烈推荐您关注有料、有趣、有爱的公众号『CVHub』,每日为大家带来精品原创、多领域、有深度的前沿科技论文解读及工业成熟解决方案!

同时欢迎添加小编微信: cv_huber,备注CSDN,加入官方学术|技术|招聘交流群,一起探讨更多有趣的话题!

文章出处登录后可见!