目录

一、引言

- 人工智能技术的发展呈现出计算智能、感知智能和认知智能三个阶段。

- 计算智能:主要以科学运算、逻辑处理、统计查询等形式化规则化运算为核心,能存会算会查找。

- 感知智能:主要以图像理解、 语音识别、机器翻译为代表,基于深度学习模型,能听会说能看会认。

- 认知智能:主要以理解、推理、 思考和决策为代表,强调认知推理,自主学习能力,能理解会思考决策。

- 博弈智能:作为决策智能的前沿范式,是认知智能的高阶表现形式,其主要以博弈论(game theory)为理论支撑,以反事实因果推理、可解释性决策为表现形式,强调将其它智能体(队友及对手)纳入己方的决策环进行规则自学习、博弈对抗演化、可解释性策略推荐等。

- 多智能体系统(multi-agent system,MAS):由多个独立的智能体组成的分布式系统,每个智 能体均受到独立控制,但需在同一个环境中与其它智能体交互。MAS是分布式人工智能(distributed AI,DAI)的一个重要分支, 主要研究智能体之间的交互通信、协调合作、冲突消 解等方面的内容,强调多个智能体之间的紧密群体合作,而非个体能力的自治和发挥。

- 由于每个智能体均能够自主学习,多智能体系统通常表现出涌现性(emergent)能力。

- 多智能体系统模型常用于描述共享环境下多个具有感知、计算、推理和行动能力的自主个体组成的集合,典型应用包括各类机器博弈、拍卖、 在线平台交易、资源分配(包路由、服务器分配)、 机器人足球、无线网络、多方协商、多机器人灾难救援、自动驾驶和无人集群对抗等。

- 多智能体学习(multi-agent learning, MAL)主要研究由多个自主个体组成的多智能体系统如何通过学习探索、利用经验提升自身性能的过程。通过博弈策略学习提高多智能体系统的自主推理与决策能力是人工智能和博弈论领域面临的前沿挑战。

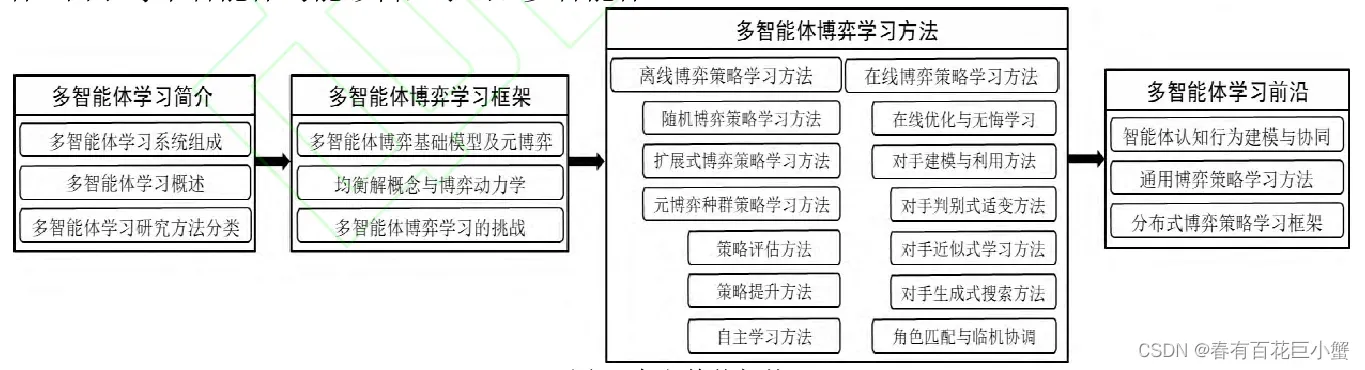

- 文章整体架构:

二、多智能体学习简介

- 基于认知行为建模的智能体能够从与环境及其他智能体的交互经验中学会有效地提升自身行 为。在学习过程中,智能体可以学会与其它智能体进行协调,学习选择自身行为、其它智能 体如何选择行为以及其目标、计划和信念是什么等。

- 伴随着深度学习(感知领域)和强化学习(决策领域)的深度融合发展,多智能体学习方法在机器博弈领域取得了长足进步。

2.1多智能体学习系统组成

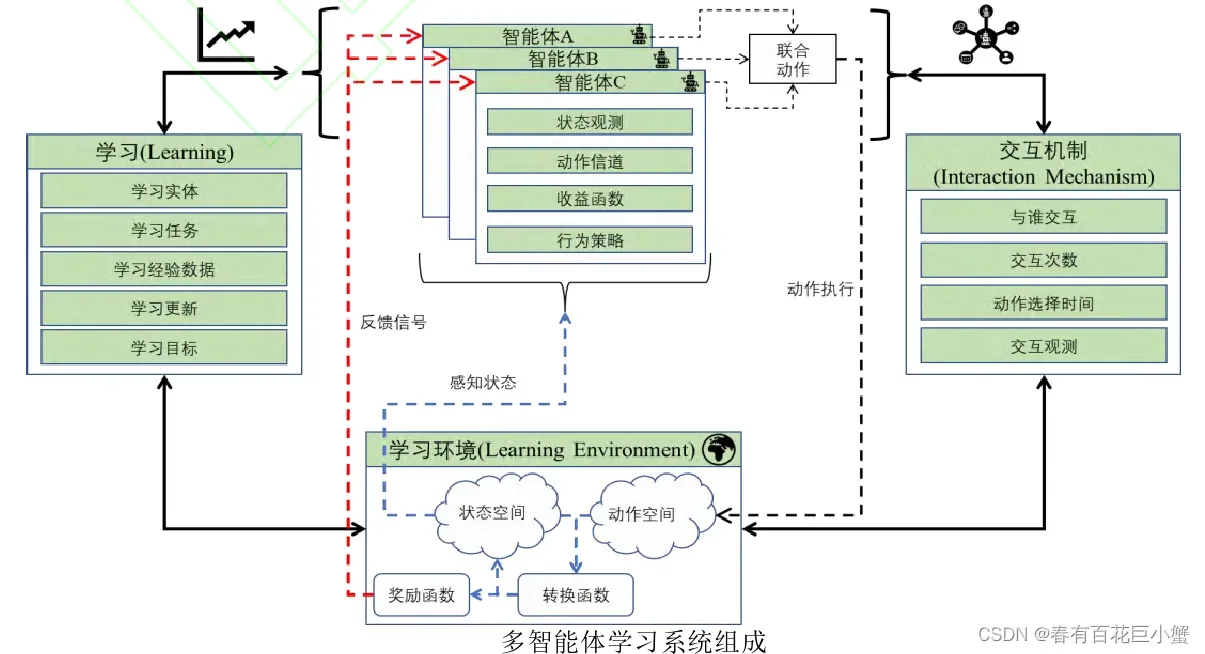

- 多智能体学习系统共包含四大模块:环境、智能体、交互机制和学习方法。

- 环境模块:由状态空间、动作空间、转换函数和奖励函数构成。状态空间指定单个智能体在任何给定时间可以处于的一组状态;动作空间是单个智能体在任何给定时间可用的一组动作;转换函数或环境动力学指定了环境在给定状态下执行动作的每个智能体(或智能体的子集)改变的 (可能是随机的)方式;奖励函数根据状态-行动转换结果给出奖励反馈信号。

- 智能体模块:该模块需要定义智能体与环境的通信关系,用于获取观测状态和输出指定动作、智能体之间的行为通信方式、智能体的效用函数以表征环境状态偏好以及选择行动的策略。

- 学习模块:由学习实体、学习目标、学习经验数据、学习更新和学习目标定义。学习实体需要指定单智能体还是多智能体级别。学习目标描述了正在学习的任务目标,通常表现为目标或评价函数。学习经验数据描述了学习实体可以获得哪些信息作为学习的基础。学习更新定义了在学习过程中学习实体的更新规则。

- 交互机制模块:定义了智能体相互交互多长时间,与哪些其他智能体交互,以及他们对其他智能体的观察。交互机制还规定了任何给定智能体之间交互的频率 (或数量),以及它们的动作是同时选择还是顺序选择(动作选择的定时)。

2.2 多智能体学习概述

- 多智能体学习的四个明确定义问题:问题描述、分布式人工智能、博弈均衡和智能体建模

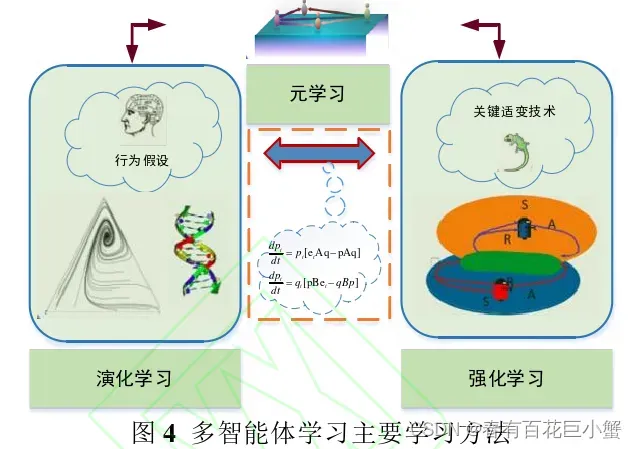

- 多智能体学习的主流方法主要包括强化学习、演化学习和元学习等内容

2.3 多智能体学习研究方法分类

- Jan’t Hoen等很早就从合作与竞争两个角度对多智能体学习问题进行了区分。

- Panait等对合作型多智能体学习方法进行了概述:团队学习(team learning), 指多智能体以公共的、唯一的学习机制集中学习最优联合策略;并发学习(concurrent learning), 指单个智能体以相同或不同的个体学习机制,并发学习最优个体策略。

- Busoniu等首次从完全合作、完全竞争和混合三类任务的角度对多智能体强化学习方法进行了分类总结。

- Zhang等对具有理论收敛性保证和复杂性分析的多智能体强化学习算法进行了选择性分析, 并首次对联网智能体分散式、平均场博弈和随机势博弈多智能体强化学习方法进行综述分析

- 吴军等从模型的角度出发,对面向马尔可夫决策的集中式和分散式模型,面向马尔可夫博弈的共同回报随机博弈、零和随机博弈和一般和随机博弈,共五类模型进行了分类分析。

- 杜威等从完全合作、完全竞争和混合型三类任务分析了多智能体强化学习方法。

- 孙长银等从学习算法结构、环境非静态性、部分可观性、基于学习的通信和算法稳定性与收敛性共五个方面分析了多智能体强化学习需要研究的重点问题。

三、 多智能体博弈学习框架

- Lu等从强化学习和博弈论的整体视角出发对多智能体博弈的解概念、虚拟自对弈 (fictitious self-play,FSP)类方法和反事实后悔值最小化(counterfactual regret minimization,CFR) 类方法进行了全面综述分析。

- Yang等对同等利益博弈、零和博弈、一般和博弈和平均场博弈中的学习方法进行了分类总结

- Bloembergen等利用演化博弈学习方法分析了各类多智能体强化学习方法的博弈动态,并揭示了演化博弈论和多智能体化学习方法之间的深刻联系

3.1 多智能体博弈基础模型及元博弈

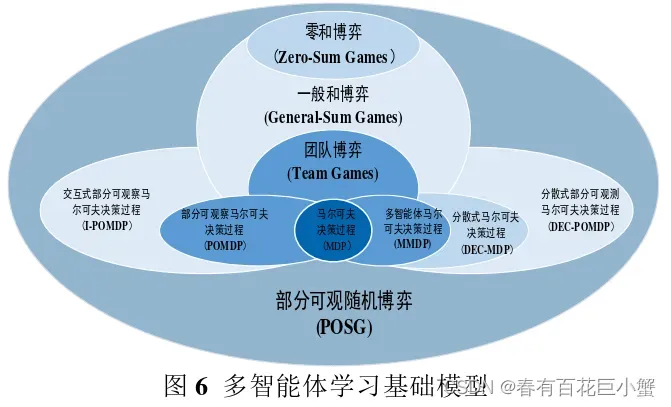

3.1.1 多智能体博弈基础模型

- 马尔可夫决策过程(Markov decision process,MDP)常用于人工智能领域单智能体决策过程建模

- 基于决策论的多智能体模型主要有分散式马尔可夫决策过程(decentralized MDP, Dec-MDP)及多智能体马尔可夫决策过程 (multi-agent MDP,MMDP)

- Dec-MDP 模型,每个智能体有独立的、关于世界状态的观察,智能体根据观察的局部信息选择动作;

- MMDP模型,不区分每个智能体可利用的、私有的信息和全局状态信息,而由系统统一制定出集中式的策略,再分配给每个智能体去执行

- 分散式部分可观马尔可夫决策过程(Dec-POMDP) 关注动作和观察中存在不确定性情况下多智能体的协调问题。Dec-POMDP模型中智能体的决策是分散式的,每个智能体根据自身所获得的局部观察信息独立的做出决策

- 利用递归建模方法对其他智能体的行为进行显式的建模,Doslli等提出的交互式部分可观马尔可夫决策 (interactive-POMDP,I-POMDP) 模型,它是博弈论与决策论的结合

- 当前的一些研究将决策论与博弈论统合起来,认为两类模型都属于部分可观察随机博弈(partially observable stochastic games, POSG)模型

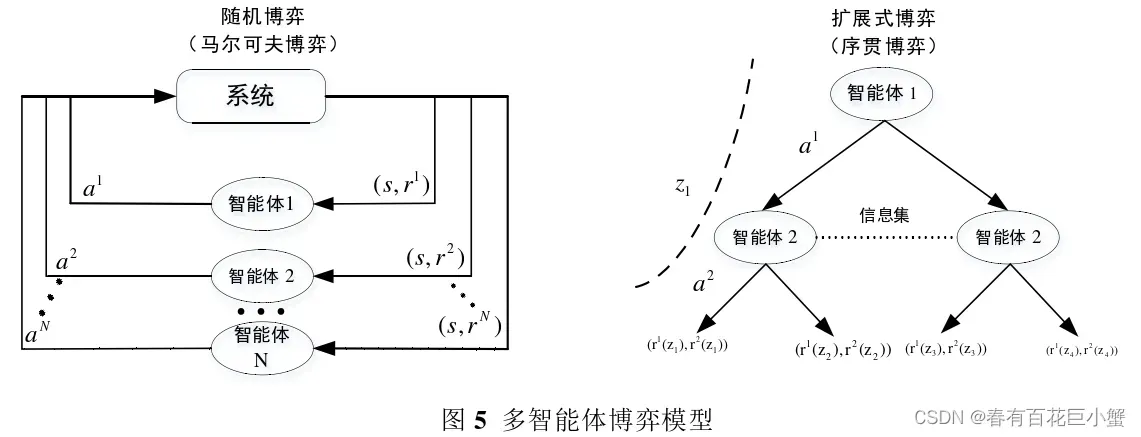

- 从博弈论视角来分析,两大典型博弈模型: 随机博弈(stochastic game, SG)和扩展式博弈(extensive-form game, EFG)模型。最新的一些研究将扩展式博弈模型重构成因子可观随机博弈(factored observation stochastic game) 模型,探索利用强化学习等方法求解扩展式博弈

- 随机博弈模型可分为面向合作的团队博弈(team games)模型、面向竞争对抗的零和博弈模型和面向竞合(混合)的一般和模型

- 团队博弈可广泛用于对抗环境下的多智能体的合作交互建模,如即时策略游戏、无人集群对抗、联网车辆调度等;

- 零和博弈和一般和博弈常用于双方或多方交互建模,其中扩展型博弈包括两种子类型,正则式(normal-form)表示常用于同态行为(simultaneous-move)决策场景描述;序贯式 (sequence-form)表示常用于行为策略多阶段交互场景描述;回合制博弈(turn based game,TBG) 常用于双方交替决策场景。

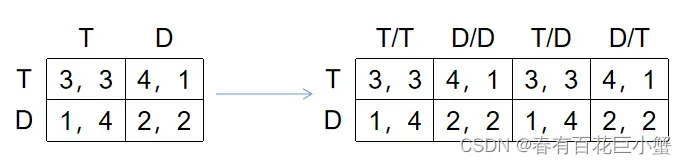

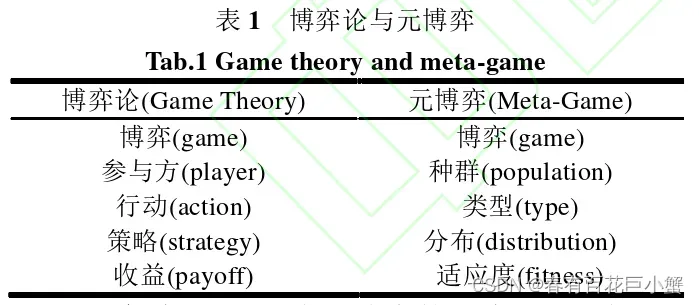

3.1.2 元博弈模型

- 元博弈(meta game),即博弈的博弈,常用于博弈策略空间分析。是研究实证博弈理论分析(empirical game theoretic analysis,EGTA)的基础模型。目前已广泛应用于各种可采用模拟器仿真的现实场景:供应链管理分析、广告拍卖和能源市场;设计网络路由协议,公共资源管理;对抗策略选择、博弈策略动态分析等。

- EGTA:基于复杂的原博弈得到一个规模小得多的实证博弈empirical game/meta game,通过实证博弈的推理(meta-reasoning)得到元策略(meta-strategies),依托这些信息指导在原策略空间中寻找新的策略,同时逼近可能的原博弈的均衡解。通俗一点来说,因为原博弈有些复杂,因此基于原博弈的特征,提炼出一个规模比较小的、简单点的实证博弈,该实证博弈的均衡解近似原博弈的均衡解,那么求解原博弈的问题,就转换为了求解规模较小的实证博弈的问题了。

- 对于任意联合策略的期望收益,通过适当的方法进行估计并记录在经验收益矩阵 empirical payoff table中。该方法能够有效解决大规模博弈均衡求解过程中的计算复杂度问题。

- 元博弈(meta-game):如果A对B的策略选择有先验知识,博弈即为meta-game。以囚徒困境为例,假设有囚徒A和囚徒B,囚徒A可以选择坦白或者抵赖,囚徒A知道囚徒B的四种潜在策略(对方是A,我是B):对方坦白我坦白(T/T),对方坦白我抵赖(D/T),对方抵赖我抵赖(D/D),对方抵赖我坦白(T/D)【T/D表示A选择抵赖(D)的情况下,B选择坦白(T)】。也就是说,A知道当A采取动作后B会采取什么动作,接着将每种可能的联合策略的回报记录在回报矩阵中。这是博弈中的博弈。

- 一些研究对博弈的策略空间几何形态进行了探索

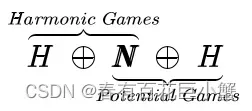

- Jiang等首次利用组合霍奇理论(combinatorial hodge theory)研究图霍尔海姆茨(Helmholtzian)分解

- Candogan等探索了策略博弈的流(flow)表示,提出策略博弈主要由势 (potential)部分、调和(harmonic)部分和非策略部分组成。

- Hwang等从策略等价的角度研究了正则式博弈的分解方法

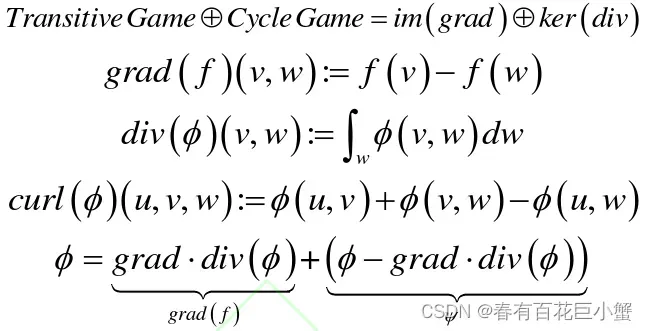

- Balduzzi等研究提出任何一个泛函式博弈(functional-form game,FFGs)可以做直和分解成传递压制博弈(transitive game) 和循环压制博弈(cycle game)两部分,可以利用梯度(grad)、散度(div)和旋度(curl)等刻画博弈策略空间几何形态:函数

表示从

到

的流,根据霍奇(Hodge)分解可知,博弈的向量空间满足正交分解:

其中,传递压制博弈的旋度为0,循环压制博弈的散度为0。对于对称(单种群)零和博弈,可以采用舒尔(Shur)分解、主成分分析(PCA)、奇异值分解(SVD)、分布式随机邻域嵌入(tSNE)等方法分析博弈的策略空间形态结构

其中,传递压制博弈的旋度为0,循环压制博弈的散度为0。对于对称(单种群)零和博弈,可以采用舒尔(Shur)分解、主成分分析(PCA)、奇异值分解(SVD)、分布式随机邻域嵌入(tSNE)等方法分析博弈的策略空间形态结构 - Omidshafiei等利用智能体的对抗数据,根据博弈收益,依次绘制响应图(response graph)、直方图,得到谱响应图、聚合响应图和收缩响应图,采用图论对传递博弈与循环博弈进行拓扑分析,绘制智能体的博弈策略特征图,得出传递博弈与循环博弈特征距离较远。

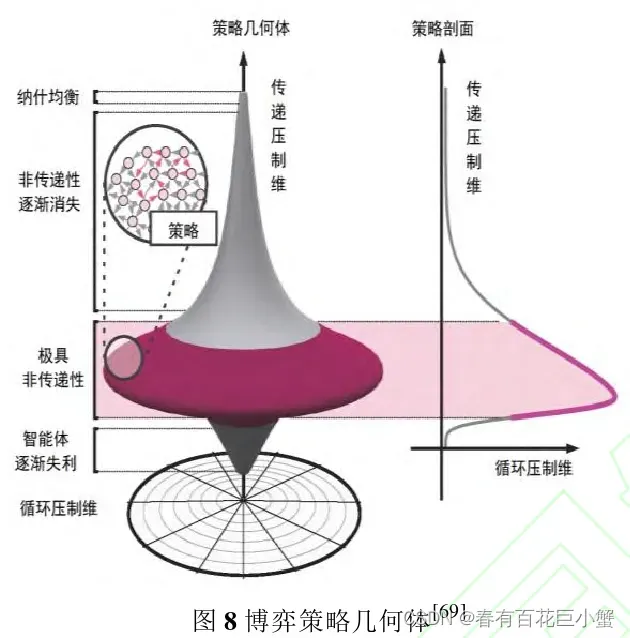

- Czarnecki等根据现实世界中的各类博弈策略的空间分析提出博弈策略空间的陀螺几何体模型猜想,纵向表示传递压制维,几何体顶端为博弈的纳什均衡,表征了策略之间的压制关系,横向表示循环压制维,表征了策略之间可能存在的首尾嵌套非传递性压制关系。

- 关于如何度量博弈策略的循环性压制,即非传递性压制,Czarneck等指出可以采用策略集邻接矩阵A(每个节点代表一个策略,如果策略 i 压制策略 j,则

=1),通过计算dia(

)可以得到循环压制环长度为3的策略个数,但由于节点可能重复访问,dia(

)无法适用于更长循环策略。此外,纳什聚类(nash clustering)方法也可用于分析循环压制环的长度,其中传递性压制部分对手策略的索引、循环压制对应聚类类别的大小。

- Tuyls等证明了元博弈的纳什均衡是原始博弈的2

纳什均衡,并利用Hoeffding给出了批处理单独采样和均匀采样两种情况下的均衡概率收敛的有效样本需求界。

- Viqueria等利用Hoeffding界和Rademacher复杂性分析了元博弈,得出基于仿真学习到博弈均衡以很高概率保证是元博弈的近似均衡,同时元博弈的近似均衡是仿真博弈的近似均衡。

3.2 均衡解概念与博弈动力学

3.2.1 均衡解概念

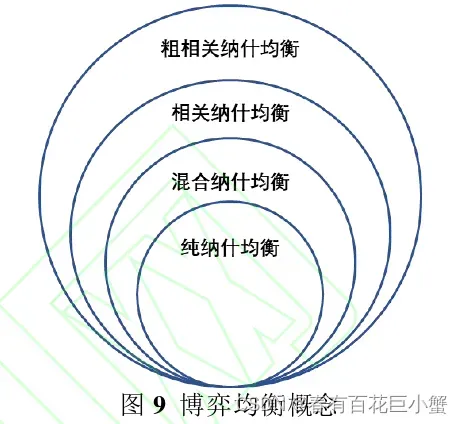

- 许多博弈没有纯纳什均衡(pure nash equilibrium,PNE),但一定存在混合纳什均衡 (mixed nash equilibrium,MNE),比较而言,相关均衡(correlated equilibrium,CE)容易计算,粗 相关均衡(coarse correlated equilibrium, CCE)非常容易计算。

- 由于学习场景和目标的差别,一些 新的均衡解概念也被采纳: ①面向 安全攻防博弈的 斯坦克尔伯格均衡(stackelberg equilibrium), ②面向 有限理性的 量化响应均衡(quantal response equilibrium,QRE), ③面向 演化博弈的 演化稳定策略(evolutionary stable strategy), ④面向 策略空间博弈的 元博弈均衡(metagame equilibrium), ⑤稳定对抗干扰的 鲁棒均衡(robust equilibrium)、也称颤抖手均衡(trembling hand equilibrium), ⑥处理 非完备信息的 贝叶斯均衡(bayesian equilibrium), ⑦处理 在线决策的 无悔或最小后悔值(no/minimal regret), ⑧描述智能体在没有使其它智能体情况变坏的前提下使得自身策略变好的 帕累托最优(pareto optimum), ⑨面向 常和随机博弈的 马尔可夫完美均衡 (Markov perfect equilibrium, MPE)等

- 近来年,一些研究采用团队最大最小均衡(team-maxminequilibrium)来描述零和博弈场景下组队智能体对抗单个智能体,其本质是一类对抗团队博弈(adversarial team game)模型,可用于解决网络阻断类问题、多人扑克问题和桥牌问题。

- 一些基于“相关均衡”解概念的新模型相继被提出,应用于元博弈、扩展式博弈、一般和博弈、零和同时行动随机博弈等。正是由于均衡解的计算复杂度比较高,当前一些近似均衡的解概念得到了广泛运用,如最佳响应(best response)和预言机(oracle)等。

3.2.2 博弈动力学

- 博弈原本就是描述个体之间的动态交互过程。

- 对于一般的势博弈来说,从任意一个局势开始, 最佳响应动力学可确保收敛到一个纯纳什均衡

- 最佳响应动力学过程十分直接,每个智能体可以通过连续性的单方策略改变来搜索博弈的纯策略纳什均衡。

- 最佳响应动力学:只要当前的局势不是一个纯纳什均衡,任意选择一个智能体 i 以及一个对其有利的策略改变

,然后更新局势为

。

- 最佳响应动力学只能收敛到一个纯策略纳什均衡且与势博弈紧密相关。

- 在任意有限博弈中,无悔学习动力学可确保收敛到粗相关均衡。对任意时间点 t = 1,2,…,T,假定每个智能体 i 获得的收益向量

,给定其他智能体的混合策略

,每个智能体 i 使用无悔算法独立地选择一个混合策略

,则智能体选择纯策略

的期望收益:

- 无悔学习方法:如果对于任意

>0,都存在一个充分大的时间域

使得对于在线决策算法M的任意对手,决策者的后悔值最多为

,将称方法M为无悔的。

- 无交换后悔(no swap regret)动力学可确保学习收敛至相关均衡。相关均衡与无交换后悔动力的联系与粗相关均衡和无悔动力学的联系一样。

- 无交换后悔学习方法:如果对于任意

>0,都存在一个充分大的时间域

使得对于在线决策方法M的任意对手,决策者的期望交换后悔值最多为

,将称方法M为无交换后悔的。

- 对于多智能体之间的动态交互一般可以采用种群演化博弈理论里的复制者动态方程或偏微分方程进行描述。

- Leonardos等利用突变理论证明了软Q-learning在异质学习智能体的加权势博弈中总能收敛到量化响应均衡

3.3 多智能体博弈学习的挑战

3.3.1 学习目标多样

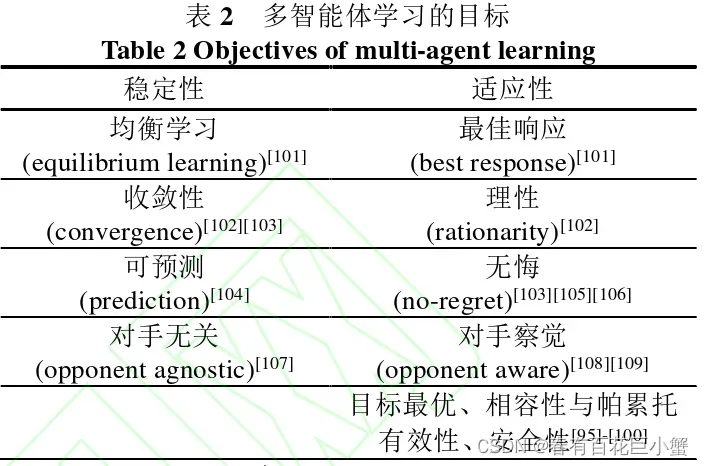

- 学习目标支配着多智能体学习的整个过程,为学习方法的评估提供了依据。

- Powers等在2004年将多智能体学习的学习目标归类为:理性、收敛性、安全性、一致性、相容性、目标最优性等

- Busoniu等将学习的目标归纳为两大类:稳定性(收敛性、均衡学习、可预测、对手无关性)和适应性(理性、无悔、目标最优性、安全性、对手察觉)

- DiGiovanni等将帕累托(Pareto)有效性也看作是多智能体学习目标

- 稳定性表征了学习到一个平稳策略的能力,收敛到某个均衡解,可学习近似模型用于预测推理,学习到的平稳策略与对手无关;适应性表征了智能体能够根据所处环境,感知对手状态,理性分析对手模型,做出最佳响应,在线博弈时可以学习一个回报不差于平稳策略的无悔响应;目标最优、相容性与帕累托有效性、安全性表征了其他智能体可能采用固定策略、自对弈学习方法时,当前智能体仍能适变对手,达到目标最优的适应性要求。

3.3.2 环境(对手)非平稳

- ①多智能体学习过程中,环境状态和奖励都是由所有智能体的动作共同决定的;②各智能体的策略都根据奖励同时优化;③每个智能体只能控制自身策略。基于这三个特点,非平稳性成为影响多智能体学习求解最优联合策略的阻碍,并发学习的非平稳性包括策略非平稳性和个体策略学习环境非平稳性

- 当某个智能体根据其他智能体的策略调整自身策略以求达到更好的协作效果时,其他智能体也相应地为了适应该智能体的策略调整了自己的策略,这就导致该智能体调整策略的依据已经“过时”,从而无法达到良好的协调效果。

- 从优化的角度看,其他智能体策略的非平稳性导致智能体自身策略的优化目标是动态的,从 而造成各智能体策略相互适应的滞后性。

- 非平稳性是多智能体问题面临的最大挑战,当前的处理方法主要有五类:①无视(ignore),即假设环境(对手)是平稳的;②遗忘(forget),即采用无模型方法,忘记过去的信息同时更新最新的观测;③标定(target)对手模型,即针对预定义对手进行己方策略优化;④学习(learn)对手模型的方法,即采用基于模型的学习方法学习对手行动策略;⑤基于心智理论 (theory of mind, ToM)的递归推理方法,即智能体采用认知层次理论递归推理对手及己方策略。

- 面对有限理性或欺骗型对手,对手建模(也称智能体建模)已然成为智能体博弈对抗时必须拥有的能力,它同集中式训练分散式执行、元学习、多智能体通信建模为非平稳问题的处理提供了技术支撑。

3.3.3 均衡难解且易变

- 零和博弈的纳什均衡解是P问题,两人一般和博弈的纳什均衡解是PPAD难问题,纳什均衡的存在性判定问题是NP难问题,随机博弈的纯策略纳什均衡存在性判定问题是PSPACE难问题。多人博弈更是面临“纳什均衡存在性”、“计算复杂度高”、“均衡选择难”等挑战。

- 对于多智能体场景,如果每个智能体都独立地计算纳什均衡策略,那么他们的策略组合可能 也不是全体的纳什均衡,并且智能体可能具有偏离到不同策略的动机。

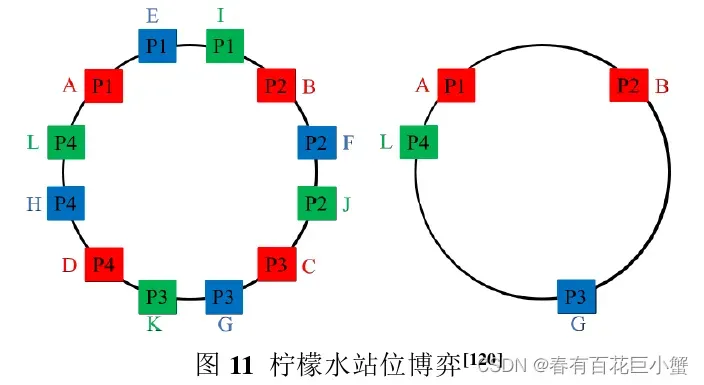

- 柠檬水站位博弈,每个智能体需要在圆环中找到一个位置,使自己与其他所有智能体的距离总和最远 (左图),则纳什均衡就是所有智能体沿环均匀分布,并有无限多的方法可以实现这一点,因此有无限多的纳什均衡,原问题变成了“均衡选择问题”。但如果每个人都独立计算自己的纳什均衡策略,那么最终可能不会有整体的纳什均衡出现(右图)。

- 正是由于多维目标、非平稳环境、大规模状态行为空间、不完全信息与不确定性因素等影 响,高度复杂的多智能体学习问题面临诸多挑战,已然十分难以求解。

四、 多智能体博弈学习方法

根据多智能体博弈对抗的场景(离线和在线)的不同,可以将多智能体博弈策略学习方法分为离线学习预训练(pre-trained)/蓝图(blueprint)策略的方法与在线学习适变 (adaptive)/反制(counter)策略的方法等。

4.1 离线博弈策略学习方法

4.1.1 随机博弈策略学习方法

- 直接面向博弈均衡的学习方法主要为一类基于值函数的策略学习

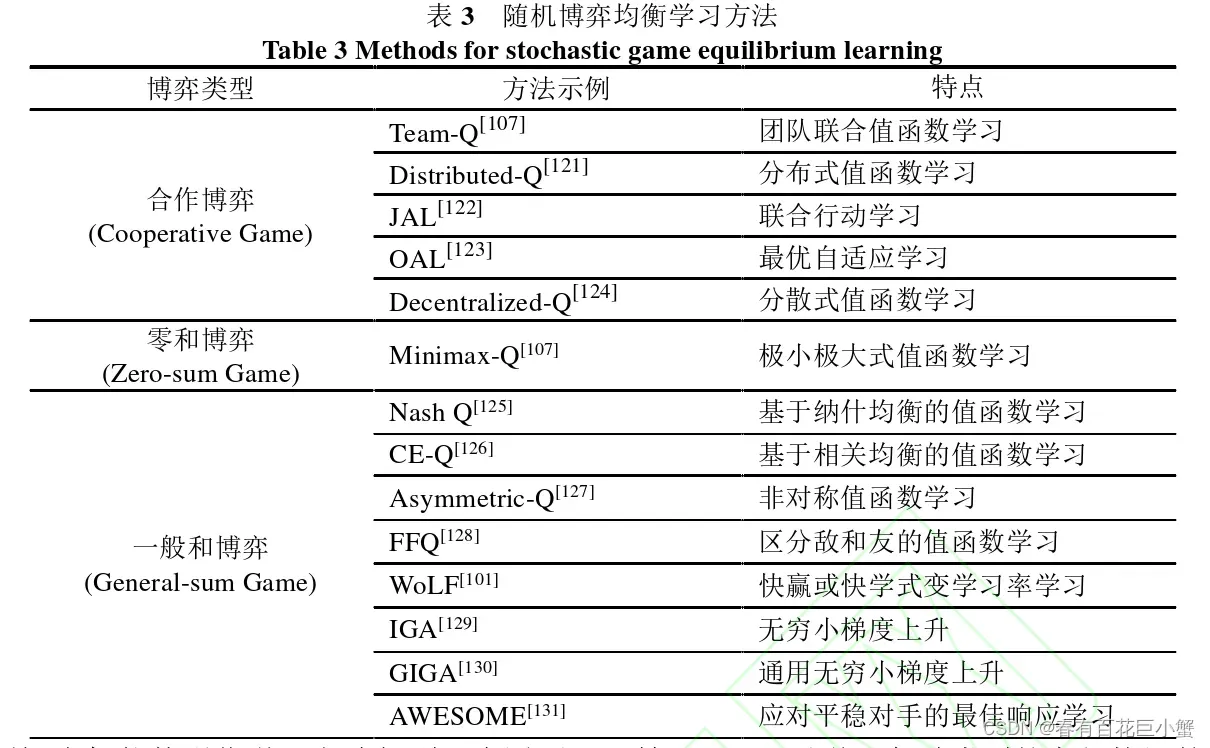

- 根据博弈类型(合作博弈、零和博弈及一般和博弈)的不同均衡学习方法主要分为三大类。Team-Q是一种直接学习联合策略的方法;Distributed-Q采用乐观单调更新本地策略,可收敛到最优联合策略;JAL (joint action learner)方法通过将强化学习与均衡学习方法相结合来学习他们自己的行动与其他智能体的行动值函数;OAL (optimal adaptive learning) 方法是一种最优自适应学习方法,通过构建弱非循环博弈(week acyclic games)来学习博弈结构,消除所有次优联合动作,被证明可以收敛至最优联合策略;Decentralized-Q是一类基于OAL的方法,被证明可渐近收敛至最优联合策略;Minimax-Q方法应用于两人零和随机博弈。Nash Q方法将Minimax-Q方法从零和博弈扩展到多人一般和博弈;CE-Q方法是一类围绕相关均衡的多智能体Q学习方法; Asymmetric-Q是一类围绕斯坦克尔伯格均衡的多智能体Q学习方法;FFQ方法将其他所有智能体分为两组,一组为朋友,可帮助一起最大化奖励回报,另一组为敌人,试图降低奖励回报;WoLF方法通过设置有利和不利两种情况下的策略更新步长学习最优策略。此外这类方法还有IGA、GIGA、AWESOME等。

- 当前多智能体强化学习方法根据训练和执行方式可分为四类:完全分散式、完全集中式、 集中式训练分散式执行和联网分散式训练。

- 对于完全分散式学习方法,研究者们在独立Q学习方法的基础上进行了价值函数更新方式的改进。Distributed Q学习方法,将智能体的个体动作价值函数视为联合动作价值函数的乐观映射,设置价值函数只有在智能体与环境和其他智能体的交互使对应动作的价值函数增大时才更新;Hysteretic Q学习方法通过启发式信息区分“奖励”和“惩罚”两种情况,分别设置两个差别较大的学习率克服随机变化的环境状态和多最优联合策略情况;FMQ方法引入最大奖励频率这一启发信息,使智能体在进行动作选择时倾向曾经导致最大奖励的动作,鼓励智能体的个体策略函数通过在探索时倾向曾经频繁获得最大奖励的策略,提高与其他智能体策略协调的可能性;Lenient式多智能体强化学习方法采用忽略低回报行为的宽容式学习方法;Distributed Lenient Q采用分布式的方法组织Lenient值函数的学习。

- 对于完全集中式学习方法,CommNet方法是一种基于中心化的多智能体协同决策方法,所有的智能体模块网络会进行参数共享,奖励通过平均的方式分配给每个智能体。该方法接收所有智能体的局部观察作为输入,然后输出所有智能体的决策,因此输入数据维度过大会给方法训练造成困难;BiCNet方法通过一个基于双向RNN网络的确定性Actor-Critic结构来学习多智能体之间的通信协议,在无监督情况下,可以学习各种类型的高级协调策略。

- 集中式训练分散式执行为解决多智能体问题提供了一种比较通用的框架。COMA方法为了解 决Dec-POMDP问题中的多智能体信度分配问题,即在合作环境中,联合动作通常只会产生全局性的收益,这使得每个智能体很难推断出自己对团队成功的贡献。该方法采用反事实思维,使用一个反事实基线,将单个智能体的行为边缘化,同时保持其他智能体的行为固定,COMA 基于Actor-Critic实现了集中训练分散执行,适用于合作型任务;MADDPG方法是对DDPG方法为适应多Agent环境的改进,最核心的部分就是每个智能体拥有自己独立的AC网络和独立的回报函数,Critic部分能够获取其余所有 Agent的动作信息,进行中心化训练和非中心化执行,即在训练的时候,引入可以观察全局的Critic来指导训练,而测试阶段便不再有任何通信交流,只使用有局部观测的Actor采取行动。因此,MADDPG方法可以同时解决协作环境、竞争环境以及混合环境下的多智能体问题;MASQL方法利用最大熵构造软(soft)值函数来解决多智能体环境中的广泛出现的“相对过泛化”引起的最优动作遮蔽问题;此外,VDN、QMIX、MAVEN、QTRAN等方法采用值函数分解的思想,按照智能体对环境的联合回报的贡献大小分解全局Q函数,很好地解决了信度分配问题,但是现有分解机制缺乏普适性。VDN方法基于DRQN提出了值分解网络架构,中心化地训练一个由所有智能体局部的Q网络加和得到联合的Q网络,训练完毕后每个智能体拥有只基于自身局部观察的Q网络,可以实现去中心化执行。该方法解耦了智能体之间复杂的关系,还解决了由于部分可观察导致的伪 (spurious)收益和懒惰(lazy)智能体问题。由于VDN求解联合价值函数时只是通过对单智能体的价值函数简单求和得到,使得学到的局部Q值函数表达能力有限,无法表征智能体之间更复杂的相互关系;QMIX对从单智能体价值函数到团队价值函数之间的映射关系进行了改进,在映射的过程中将原来的线性映射换为非线性映射,并通过超网络的引入将额外状态信息加入到映射过程,提高了模型性能;MAVEN采用了增加互信息变分探索的方法,通过引入一个面向层次控制的隐层空间来混合基于值和基于策略的学习方法。QTRAN提出了一种更加泛化的值分解方法,从而成功分解任何可分解的任务,但是对于无法分解的协作任务的问题并未涉及;Q-DPP方法采用行列式点过程方法度量多样性,加速策略探索;MAPPO方法直接采用多个PPO 算法和广义优势估计、观测和层归一化、梯度和值函数裁剪等实践技巧在多类合作场景中表现较好;Shapley Q方法采用合作博弈理论建模、利用Shapley值来引导值函数分析,为信度分配提供了可解释方案。

- 联网分散式训练方法是一类利用时变通信网络的多智能体学习方法。其决策过程可建模成时空马尔可夫决策过程,智能体位于时变通信网络的节点上。每个智能体基于其本地观测和连接的临近智能体提供的信息来学习分散的控制策略,智能体会得到当地奖励。FQI方法采用神经拟合Q值函数;DIGing方法基于时变图拓扑的分布式优化方法;MAAC方法是基于AC算法提出来的,每个智能体都有自己独立的Actor网络和Critic网络,每个智能体都可以独立决策并接收当地奖励,同时在网络上与临近智能体交换信息以得到最佳的全网络平均回报,该方法提供了收敛性的保证。由于多智能体带来的维数诅咒和解的概念难计算等问题,使得其很具有挑战性;SAC方法是一种可扩展的Actor-Critic方法,可以学习一种近似最优的局部策略来优化平均奖励,其复杂性随局部智能体(而不是整个网络)的状态-行动空间大小而变化;NeurComm是一种可分解通信协议,可以自适应地共享系统状态和智能体行为的信息,该算法的提出是为了减少学习中的信息损失和解决非平稳性问题,为设计自适应和高效的通信学习方法提供了支撑。AMAFQI是一种多智能体批强化学习的有效逼近方法,其提出的迭代策略搜索对集中式标准Q函数的多个近似产生贪婪策略。

4.1.2 扩展式博弈策略学习方法

- 对于完美信息的扩展式博弈可以通过线性规划等组合优化方法来求解。近年来,由于计算博弈论在非完美信息博弈领域取得的突破,基于后悔值方法得到广泛关注。

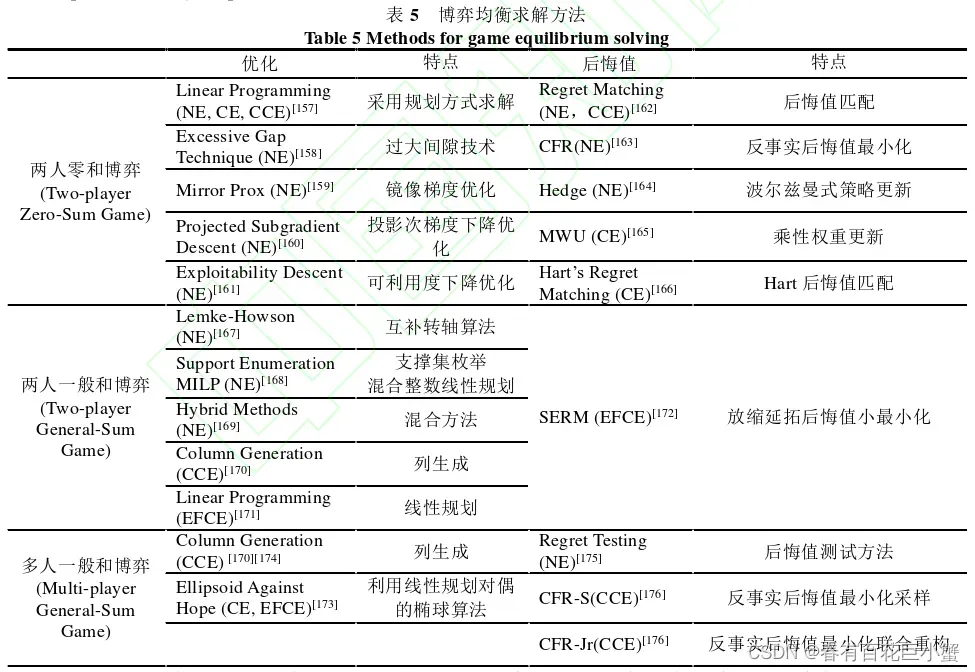

- 面向纳什均衡(nash equilibrium, NE)、相关均衡(correlated equilibrium, CE)、粗相关均衡(coarse correlated equilibrium, CCE)、扩展形式相关均衡(extensive form correlated equilibrium, EFCE)的相关求解方法如下:

- 基于后悔值的方法,其收敛速度一般为

,一些研究借助在线凸优化技术将收敛速度提升到

。这类优化方法,特别是一些加速一阶优化方法理论上可以比后悔值方法更快收敛,但实际应用中效果并不理想。

- 在求解大规模非完全信息两人零和扩展博弈问题中,算法博弈论方法与深度强化学习方法成效显著,形成以Pluribus、DeepStack等为代表的高水平德州扑克AI,在人机对抗中超越人 类职业选手水平。其中,CFR类方法通过计算累计后悔值并依据后悔值匹配方法更新策略;深度强化学习类方法通过学习信息集上的值函数来更新博弈策略并收敛于近似纳什均衡。

- 近年来,一些研究利用Blackwell近似理论,构建起了在线凸优化类方法与后悔值类方法之间的桥梁,Farina等证明了后悔值最小化

及其变体

分别与跟随正则化领先者(follow the regularized leader, FTRL)和在线镜像下降(online mirror descent, OMD)等价,收敛速度为O(T)。

- 一些研究表明后悔值与强化学习中的优势 (advantage)函数等价,现有强化学习方法通过引入“后悔值”概念,或者后悔值匹配更新方法,形成不同强化学习类方法,在提高收敛速率的同时,使得CFR方法的泛化性更强。

- CFR类方法,优化方法和强化学习类方法这三大类方法的紧密联系为求解大规模两人零和非完美信息博弈提供了新方向和新思路。

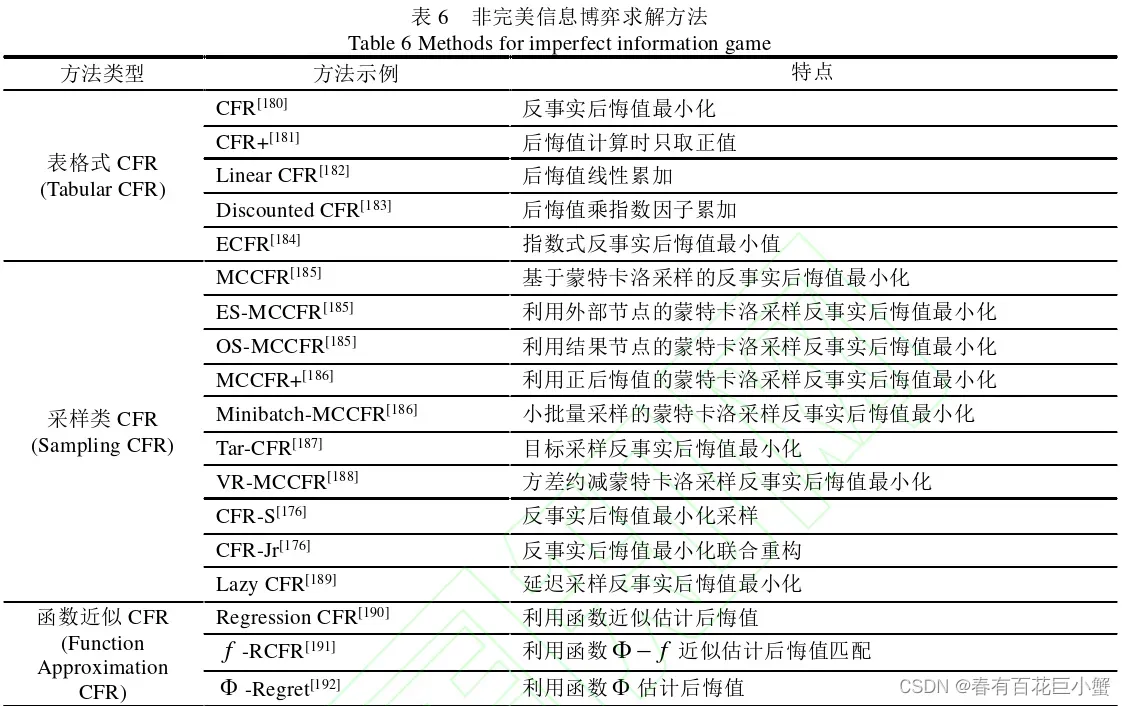

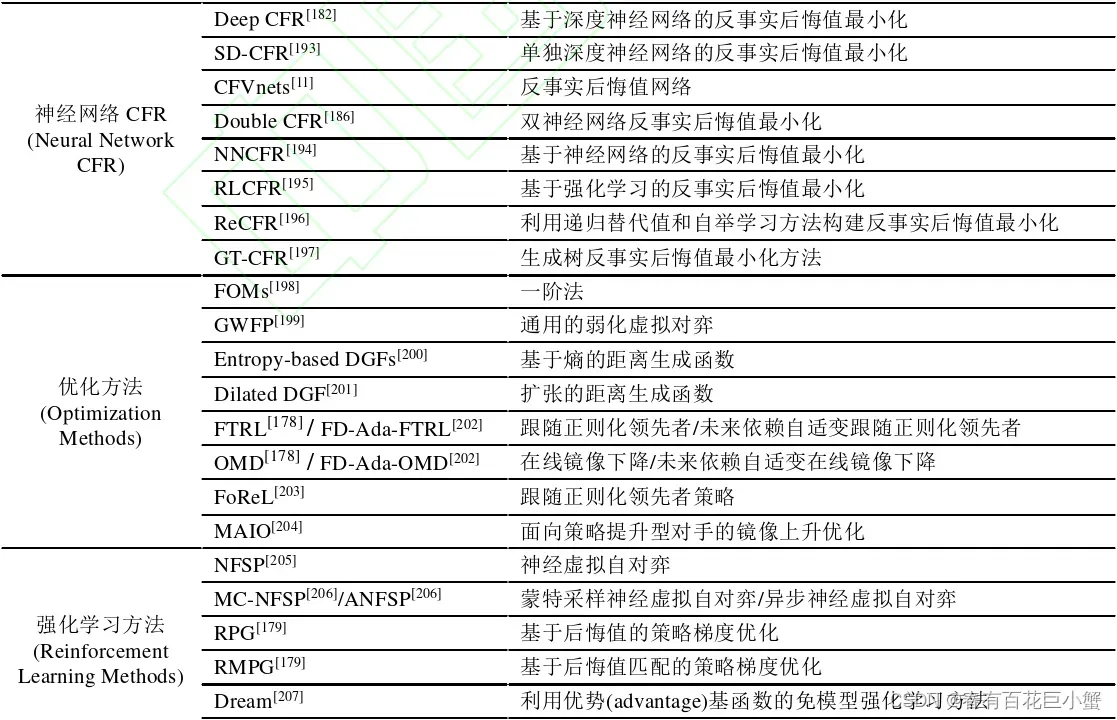

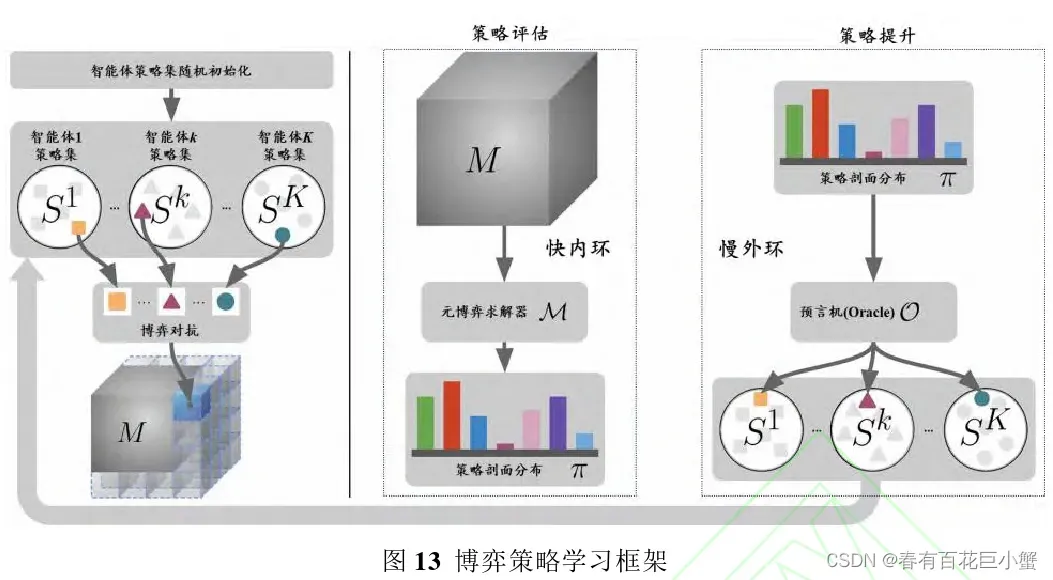

- 非完美信息博弈求解方法主要有表格式、采样类、函数近似和神经网络等CFR类方法,优化方法和强化学习类方法。

- 基础的表格类CFR方法受限于后悔值和平均策略的存储空间限制,只能求解状态空间约为10^14的博弈问题。CFR与抽象、剪枝、采样、函数近似、神经网络估计等方法结合,衍生出一系列CFR类方法,试图从加速收敛速度、减少内存占用、缩减博弈树等,为快速求解近似纳什均衡解提供有效支撑。

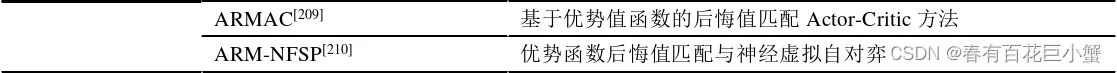

- 采样类CFR方法中蒙特卡洛采样是主流方法,MCCFR通过构建生成式对手,大幅降低迭代时间、加快收敛速度。此外并行计算小批次、方差约减等技术便被用于约束累积方差,各类方法的采样方式会呈现出不同形态,如下所示。

- 函数近似与神经网络类CFR方法主要采用拟合的方法估计反事实后悔值、累积后悔值,求解当前策略或平均策略,相较于表格类方法泛化性更强

- 优化方法有效利用了数学优化类工具, 将非完美信息博弈问题构建成双线性鞍点问题,充分利用离线生成函数、在线凸优化方法、梯度估计与策略探索等方法,在小规模博弈上收敛速 度快,但无法适应空间大的博弈求解,应用场景受限。

- 传递的强化学习方法主要是利用自对弈的方式生成对战经验数据集,进而学习鲁棒的应对策略,新型的强化学习方法将后悔值及可利用性作为强化学习的目标函数,面向大型博弈空间,由于策略空间的非传递性属性和对手适变的非平稳策略,两类方法均面临探索与利用难题。

- 对于多人博弈,一类针对对抗团队博弈 (adversarial team game)模型得到了广泛研究,其中团队最大最小均衡(team-maxmin equilibrium, TME)描述了一个拥有相同效用的团队与一个对手博弈对抗的解概念。

- 针对智能体之间有无通信、有无事先通信、可否事中通信等情形,近年来的一些研究探索了相关解概念,如相关TME(Correlated TME, CTME)、带协同设备的TME (TME with Coordination device, TMECor、带通信设备的TME (TME with Communication device, TMECom)

- 相关均衡求解方法,如增量策略生成,其本质是一类双预言机(oracle)方法。Zhang结合网络阻断(network interdiction)应用场景设计了多种对抗团队博弈求解方法。此外,还有一种团队对手博弈(team adversary game)模型也被用来建模多对一的博弈情形。

4.1.3 元博弈种群策略学习方法

- 对于多智能体博弈策略均衡学习问题,近年来一些通用的框架相继被提出,其中关于元博弈 理论的学习框架为多智能体博弈策略的学习提供了指引。

- 由于问题的复杂性,多智能体博弈策略学习表现出基础策略可以通过强化学习等方法很快生成,而较优策略依靠在已生成的策略池中缓慢迭代产生。

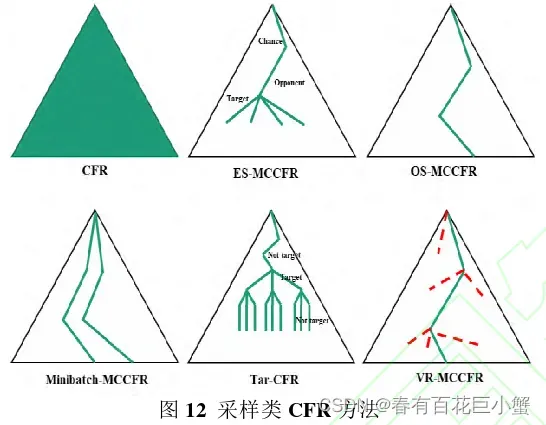

- 当前由强化学习支撑的策略快速生成“内环学习器”和演化博弈理论支撑的种群策略缓慢迭代“外环学习器”组合成的“快与慢”双环优化方法,为多智能体博弈策略学习提供了基本参考框架。

- Lanctot等提出了面向多智能体强化学习的策略空间响应预言机 (policy space response oracle, PSRO)统一博弈学习框架,成功将双预言机(double oracle, DO)这类迭代式增量式策略生成方法扩展成满足元博弈种群策略学习方法,其过程本质上由两个步骤组成“挑战对手”和“响应对手”。

- 为了应对一般和博弈,Muller等提出了基于

和PSRO的通用学习方法框架。

- Sun等提出了满足竞争自对弈(competitive self-play)多智能体强化学习提出了分布式联赛学习框架TLeague,可以云服务架构组织多智能体博弈策略学习

- Zhou等基于种群多智能体强化学习提出了融合策略评估的MALib并行学习框架

- 当前多智能体博弈策略学习主要是通过算法驱动仿真器快速生成博弈对抗样本,得到收益张量M,元博弈求解器(meta-solver)计算策略组合分布, 进而辅助挑战下一轮对战对手(末轮单个、最强k个、均匀采样等),预言机主要负责生成最佳响应,为智能体的策略空间增加新策略。

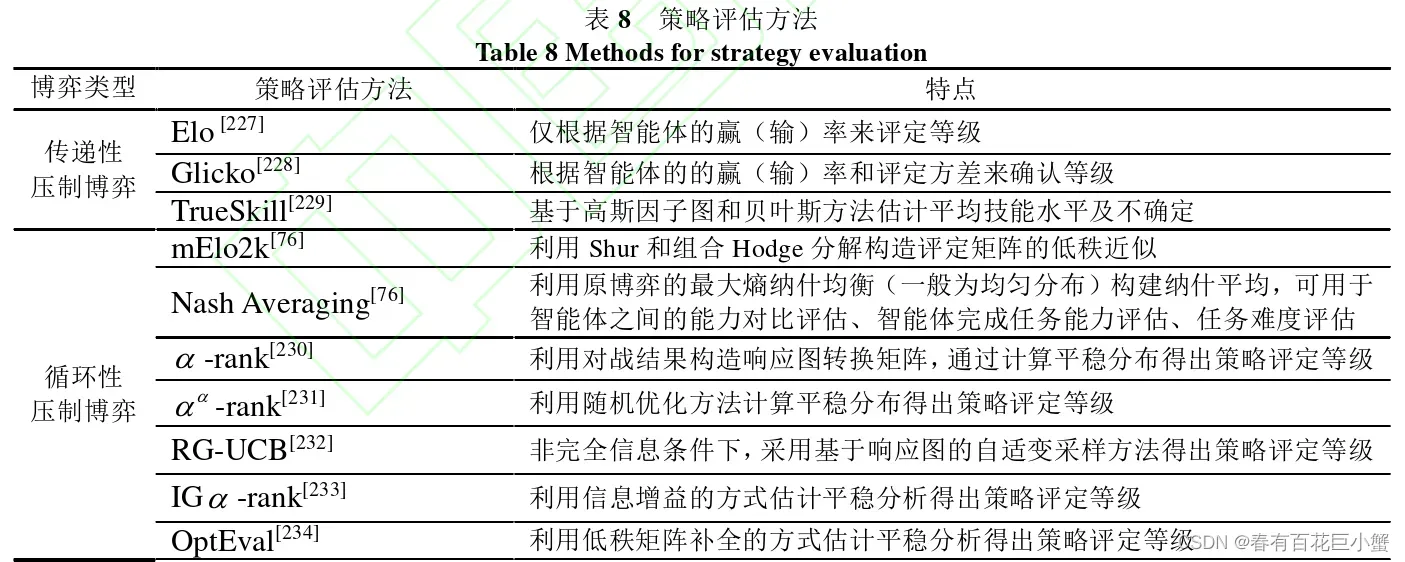

- 策略评估方法:

- 多智能体博弈对抗过程中,由基础“内环学习器”快速生成的智能体模型池里,各类模型的能力水平各不相同,如何评估其能力用于外层的最优博弈策略模型探索可以看作是一个多智能体交互机制设计问题,即如何按能力挑选智能体用于“外环学习器”策略探索。

- 当前,衡量博弈策略模型绝对能力的评估方法主要有可利用性 (exploitability)、方差(variance)和保真性(soundness)等。此外,Park等采用三支分解方法度量智能体的技能(skill)、运气(chance)与非平稳性等。

- 衡量相对能力的评估方法已成为当前的主流。由于博弈策略类型的不同,评估方法的适用也不尽相同。当前策略评估方法主要分传递性压制博弈和循环性压制博弈策略评估方法。

- 通过策略评估,可以掌握种群中对手能力情况及自身能力等级,快速的评估方法可有效加快多样性策略的探索速度。

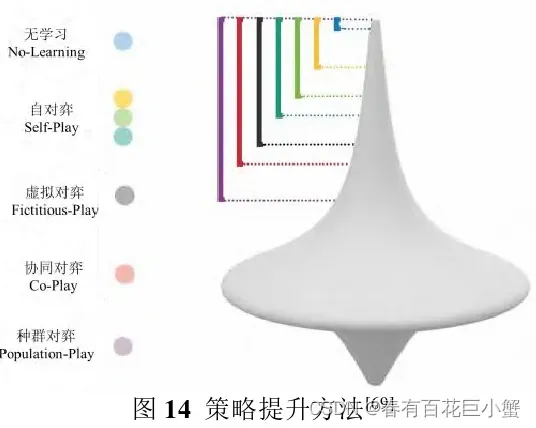

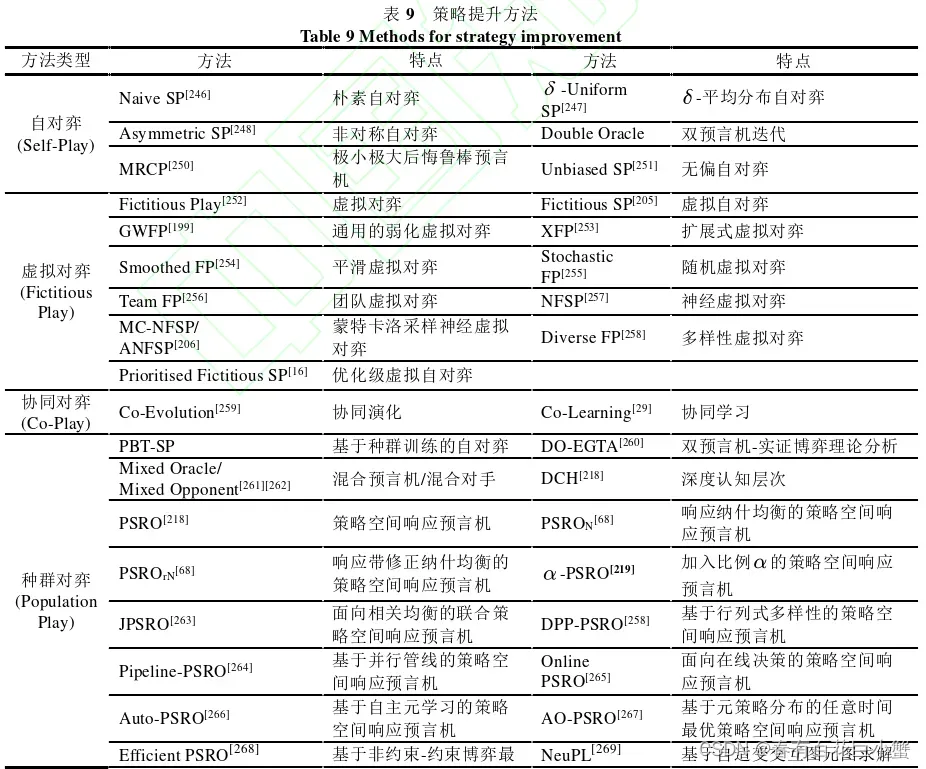

- 策略提升方法:

- 在“内环学习器”完成了智能体博弈策略评估的基础上,“外环学习器”需要通过与不同“段位”的智能体进行对抗,提升策略水平。传统自对弈的方法对非传递压制性博弈的策略探索作用不明显。

- 博弈策略提升的主要方法有自对弈 (self-play)、协同对弈(co-play)、虚拟自对弈(fictitious self-play)和种群对弈(population play)等方法,但各类方法的适用有所区分。

- 研究表明仅当策略探索至种群数量足够多、多样性满足条件后,这类迭代式学习过程才能产生相变。传统的自对弈方法只有当策略的“传递压制维”上升到一定段位水平后才可能有作用,否则可能陷入循环压制策略轮替生成。

- 根据适用范围分类,可以将方法划分成自对弈、协同对弈、虚拟对弈和种群对弈共四大类。自对弈类方法主要有朴素(naive) 自对弈方法,

自对弈、非对称自对弈、双预言机、极小极大后悔鲁棒预言机等,这类方法主要利用与自身的历史版本对抗生成训练样本,对样本的质量要求高,适用范围最小。虚拟对弈类方法主要有虚拟对弈、虚拟自对弈、广义虚拟对弈、扩展虚拟对弈、平滑虚拟对弈、随机虚拟对弈、团队虚拟对弈、神经虚拟自对弈、蒙特卡洛神经虚拟自对弈、优先虚拟自对弈等,这类方法是自对弈方法的升级版本,由于样本空间大,通常会与采样或神经网络学习类方法结合使用,可用于扩展式博弈、团队博弈等场景。协同对弈方法主要有协同演化、协同学习等,这类方法主要依赖多个策略协同演化生成下一世代的优化策略。种群对弈方法主要 有种群训练自对弈、双预言机-经验博弈分析、混合预言机/混合对手、策略空间响应预言机(PSRO)、联合PSRO、行列式点过程PSRO、管线PSRO、在线PSRO和自主PSRO、任意时间最优PSRO、有效PSRO、神经种群学习等多类方法,这类方法与分布式框架的组合为当前绝大部分多智能体博弈问题提供了通用解决方案,其关键在于如何提高探索样本效率,确保快速的内环能有效生成策略样本,进而加快慢外环的优化迭代。

-

自主学习方法:近年来,一些研究试图从算法框架与分布式计算框架进行创新,借助元学习方法,将策略评估与策略提升方法融合起来

-

Feng等基于元博弈理论、利用元学习方法探索了多样性感知的自主课程学习方法,通过自主发掘多样性课程用于难被利用策略的探索。

-

Yang等指出多样性自主课程学习对现实世界里的多智能体学习系统非常关键。

-

Wu等利用元学习方法同时可以生成难被利用和多样性对手,引导智能体自身策略迭代提升。

-

Leibo等研究指出自主课程学习是研究多智能体智能的可行方法,课程可由外生和内生挑战自主生成。

-

当前自主学习类方法需要利用多样性(diversity)策略来加速策略空间的探索,其中有质量的多样性(quality diversity)作为一类帕累托框架,因其同时确保了对结果空间的广泛覆盖和有效的回报,为平衡处理“探索与利用”问题提供了目标导向。

-

当前对多样性的研究主要区分三大类:行为多样性、策略多样性、环境多样性。

-

一些研究拟采用矩阵范数(如范数、范数和谱范数、行列式值)、有效测度 (effective measure)、最大平均差异(maximum mean discrepancy)、占据测度(occupancy measure)、期望基数(expected cardinality)、凸胞扩张(convex hull enlargement)等衡量多样性。

-

行为多样性可引导智能体更倾向于采取多样化的行动;策略多样性可引导智能体生成 差异化的策略、扩大种群规模、提高探索效率;环境多样性可引导智能体适变更多不同的场景,增强智能体的适变能力。

-

4.2 在线博弈策略学习方法

-

由离线学习得到的博弈策略通常被称作蓝图策略

-

在线对抗过程中,可完全依托离线蓝图策略进行在线微调。如即时策略游戏中依据情境元博弈选择对抗策略,棋牌类游戏中可以用两种方式生成己方策略,即从悲观视角出发的博弈最优(game theory optimal, GTO),也就是采用离线蓝图策略进行对抗;从乐观视角出发的剥削式对弈(exploitative play), 即在线发掘对手可能的弱点,最大化己方收益的方式利用对手。

-

正是由于难以应对非平稳对手的策略动态切换、故意隐藏或欺骗,在线博弈过程中通常需要及时根据对手表现和所处情境进行适应性调整,其本质是一个对手意图识别与反制策略生成问题。当前在线博弈策略学习的研究主要包括学会控制后悔值、对手建模与利用、智能体匹配及协作。

4.2.1 在线优化与无悔学习

- 在线决策过程的建模方法主要有在线 (online) MDP、对抗(adversarial) MDP、未知部分可观MDP、未知Markov博弈等。

- 基于在线优化与无悔学习方法的融合是在线博弈策略学习的重点研究方向,其中无悔本是指随着交互时长趋近无穷大时,后悔值呈亚线性递减,即满足

。传统的无悔学习方法主要依赖Hedge和乘性权重(MWU)等,近来的一些研究利用在线凸优化方法设计了基于FTRL和OMD等乐观后悔最小化算法。

- Dinh等利用Hedge方法和策略支撑集数量约束,证明了线动态后悔值的有界性。

- Kash等将无悔学习与Q值函数结合设计了一种局部无悔学习方法,无需考虑智能体的完美回忆条件仍可收敛。

- Lint和Lee等对无悔学习的有限时间末轮迭代(last-iterate)收敛问题展开了 研究,通过附加正则化项的乐观后悔值最小化方法收敛速度更快。

- Daskalkis等研究了几类面向一般和博弈的近似最优无悔学习方法的后悔界。

- 事后(hindsight)理性作为一个与后悔值等效的可替代学习目标,可用于引导在线学习与其它智能体关联的最佳策略。

4.2.2 对手建模与利用方法

通过对手建模可以合理的预测对手的行动、发掘队手的弱点以备利用。当前对手建模方法主 要分两大类:与博弈领域知识关联比较密切的显式建模方法和面向策略的隐式建模方法。当前, 面向在线策略学习的对手利用方法主要有三大类:

- 对手判别式适变方法:Li提出利用模式识别树显式的构建对手模型,估计对手策略与赢率进而生成己方反制策略;Ganzfried等设计机会发掘方法,试图利用对手暴露的弱点;Davis等通过估计对手信息,构建限定性条件,加快约束策略生成。

- 对手近似式学习方法:Wu等利用元学习生成难被剥削对手和多样性对手模型池来指引在线博弈策略学习;Kim等利用对手建模与元学习设计了面向多智能体的元策略优化方法;Foerster等设计的对手察觉(opponent aware)学习方法是一类考虑将对手纳入己方策略学习过程中的学习方法;Silva等提出的在线自对弈课程方法通过在线构建对抗课程引导博弈策略学习。

- 对手生成式搜索方法:Ganzfried等提出基于狄利克雷 (Direchlet)先验对手模型,利用贝叶斯优化模型获得对手模型的后验分布,辅助利用对手的反制策略生成;Šustr等提出利用基于信息集蒙特卡洛采样的蒙特卡洛重解法生成反制策略;Brown等提出在对手建模时要平衡安全与可利用性,基于安全嵌套有限深度搜索的方法可以生成安全对手利用的反制策略;Tian提出利用狄利克雷先验, 基于中国餐馆过程 (Chinese restaurant process, CRP)在博弈策略空 间中生成安全利用对手的反制策略。

4.2.3 角色匹配与临机协调

- 多智能体博弈通常是在多角色协调配合下完成的,通常同类角色可执行相似的任务,各类智能体之间的临机协调是博弈对抗致胜的关键。

- Wang等设计了面向多类角色的多智能体强化学习框架,通过构建一个随机角色嵌入空间, 可以学习特定角色、动态角色和可分辨角色。相近角色的单元完成相似任务,加快空间划分与环境高效探索。

- Gong等利用角色(英雄及玩家)向量化方法分析了英雄之间的高阶交互情况,图嵌入的方式分析了协同(synergy)与压制(suppression)关系,研究了多智能体匹配在线规划问题。

- 临机组队(ad-hoc teamwork, AHT)可以看作是一个机制设计问题。Hu等提出了智能体首次合作的零样本协调(zero-shot coordination, ZSC)问题,利用它对弈(other-play)方法(即基于学习的AI组队方法)为无预先沟通的多智能体协调学习提供了有效支撑。

- 人与AI 组队(human-AI team)作为临机组队问题的子问题,要求AI在不需要预先协调下可与人在线协同。Lucero等利用StarCraft平台研究了如何利用人机组队和可解释人工智能技术帮助玩家理解系统推荐的行动;Waytowich等研究了如何运用自然语言指令驱动智能体学习,基于语言指令与状态的互嵌入模型实现了人在环路强化学习方法的设计;Siu等利用一类合作博弈平台Hanabi评估了各类人与AI组队方法的效果。

五、多智能体博弈学习前沿展望

5.1 智能体认知行为建模与协同

5.1.1 多模态行为建模

- [构建智能体的认知行为模型为一般性问题提供求解方法]是获得通用人工智能的一种探索。

- 各类认知行为模型框架为智能体获取知识提供了接口。

- 对抗环境下,智能体的认知能力主要包含博弈推理(game reasoning)与反制策略(counter strategy)生成、对抗推理(adversarial reasoning)与对抗规划(counter planning)。

- 认知行为建模可为分析对手思维过程、决策行动的动态演化、欺骗与反欺骗等认知对抗问题提供支撑。

- 智能体行为的多模态属性,如合作场景下行为的“解释性、明确性、透明性和预测性”, 对抗场景下行为的“欺骗性、混淆性、含糊性、隐私性和安全性”,均是欺骗性和可解释性认知行为建模的重要研究内容。相关技术可应用于智能人机交互、机器推理、协同规划、具人类意识(human aware)智能系统等领域问题的求解。

5.1.2 对手推理与适变

- 传统的对手建模方法一般会假设对手策略平衡不变、固定策略动态切换等简单情形,但对手建模仍面临对手策略非平稳、风格骤变、对抗学习、有限理性、有限记忆、欺骗与诈唬等挑战。

- 当前,具对手意识的学习、基于心智理论(认知层次理论)的递归推理和基于策略蒸馏和修正信念的贝叶斯策略重用等方法将对手推理模板嵌入对手建模流程中,可有效应对非平稳对手。

- 在线博弈对抗过程中,公共知识与完全理性等条件均可能无法满足,对手缺点的暴露强化了智能体偏离均衡解的动机,基于纳什均衡解采用安全适变策略可有剥削对手且不易被发觉。

5.1.3 人在环路协同

- “人机对抗”是当前检验人工智能AI的主流评测方式,而“人机协同”是人机混合智能的主要研究内容。

- 人与AI的协同可区分为人在环路内、人在环路上和人在环路外共三种模式,其中人在环路上(人可参与干预,也可旁观监督)的相关研究是当前的研究重点,特别是基于自然语言指令的相关研究为人与AI交互预留了更为自然的人机交互方式。

- 此外,围绕“人(博弈局中人)—机(机器AI)—环(博弈对抗环境)”协同演化的相关研究表明,人机协同面临着应用悖论,人机组队后的能力将远超人类或机器,但过度依赖人工智能将会使人类的技能退化,盲目乐观的应用,忽视缺陷和漏洞,对抗中被欺骗可至决策错误,推荐的行动方案受质疑,在某些人道主义应用场景中可能面临伦理挑战。

5.2 通用博弈策略学习方法

5.2.1 大规模智能体学习方法

- 当前多智能体博弈的相关研究正向多智能体集群对抗、异构集群协同等高复杂现实及通用博弈场景聚焦。随着智能体数量规模的增加,行动和状态空间将呈指数级增长,从而在很大程度上限制了多智能体学习方法的可扩展性。

- 传统的博弈抽象、状态及行动抽象方法虽然可以对问题空间做有效约减,但问题的复杂度依然很高,在智能体数目N>>2时,纳什均衡通常很难计算,多人博弈均衡解存在性和求解依然充满挑战。

- Yang等根据平均场思想提出的平均场Q学习和平均场Actor-Critic方法,为解决大规模智能体学习问题提供了参考。

5.2.2 双层优化自对弈方法

- 博弈策略学习的范式正从传统的“高质量样本模仿学习+分布式强化学习”向“无先验知识+端到端竞争式自对弈学习”转变。

- Muller等提出的

和PSRO学习方法是一类元博弈种群策略学习通用框架方法。Leibo等从“问题的问题”视角提出了面向多智能体的“自主课程学习”方法。

- 传统的强化学习和算法博弈论方法是多智能体博弈策略学习方法的通用基础学习器。

- 基于“快与慢”理念的双层优化类方法,其中元学习、自主课程学习和元演化学习、支持并行分布式计算的无导数 (derivative free)演化策略学习方法、面向连续博弈(continuous game)的策略梯度优化方法、面向非平稳环境的持续学习(continual Learning) 方法、由易到难的自主学习方法为自主策略探索学习程序算法设计提供了指引。

5.2.3 知识与数据融合方法

- 基于常识知识与领域专家或专业人类玩家经验的知识驱动型智能体策略具有较强的可解释性,而基于大样本采样和神经网络学习的数据驱动型智能体策略通常具有很强的泛化性。

- 相关研究从加性融合与主从融合、知识牵引与数据驱动、层次化协同与组件化协同等角度进行了探索。此外,张等面向任务级兵棋提出了多智能体策略协同演进框架,打通人类专家与智能算法之间的知识循环。

5.2.4 离线预训练与在线微调方法

- 基于海量数据数据样本的大型预训练模型是通用人工智能的一种探索。

- 相对于基于蓝图策略的在线探索方法,基于离线预训练模型的在线微调方法有着更广泛的应用前景。近来,基于序贯决策Transformer的离线与在线学习方法将注意力机制与强化学习方法融合,为大型预训练模型生成提供了思路,来自DeepMind的Mathieu等设计了面向星际争霸的超大型离线强化学习模型。

5.3 分布式博弈策略学习框架

5.3.1 多智能体博弈基准环境

- 当前,大多数博弈对抗平台采用了游戏设计的思想,将玩家的参与度(engagement)作为设计 目标,通常会为了游戏的平衡性,将对抗多方的能力水平设计成相对均衡状态(如星际争霸中的三个种族之间相对状态),这类环境可看成是近似对称类环境。

- Hernandez等利用元博弈研究了竞争性多玩家游戏的自平衡问题。

- 当前一些研究包括SMAC、Openspiel等基准环境,PettingZoo、MAVA等集成环境。兵棋推 演作为一类典型的非对称部分可观异步多智能体协同对抗环境,红蓝双方通常能力差异明 显,模拟真实环境的随机性使得决策风险高,可以作为多智能体博弈学习的基准测试环境。

5.3.2 分布式强化学习框架

- 由于学习类方法本质上采用了试错(trial and error)机制,需要并行采样大量多样化样本提升训练质量,需要依赖强大的计算资源。

- 基于启发式联赛训练的AlphaStar,需要训练多个种 群才能有效引导策略提升、算法收敛;基于博弈分解的Pluribus,其蓝图策略的离线训练需要依靠超级计算机集群。当前的一些研究提出利用 Ray、SEED、Flatland等分布式强化学习框架。

5.3.3 元博弈种群策略学习框架

- 元博弈种群策略学习框架的设计需要将种群策略演化机制设计与分布式计算平台资源调度协同考虑。当前绝大多数机器博弈AI的实现均需要依靠强大的分布式算力支撑。

- 基于元博弈的种群演化自主学习方法与分布式学习框架的结合可用于构建通用的博弈策略学习框架。当前,基于竞争式自对弈的TLeague和整体设计了策略评估的MAlib等为种群策略学习提供了分布式并行学习框架支撑。

论文地址:

网络首发时间:2022-06-27 16:18:12

网络首发地址:https://kns.cnki.net/kcms/detail/11.2422.TN.20220625.1341.018.html

文章出处登录后可见!