简介

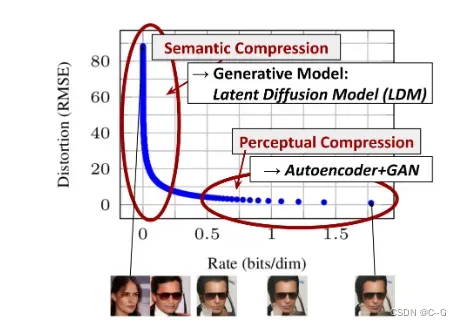

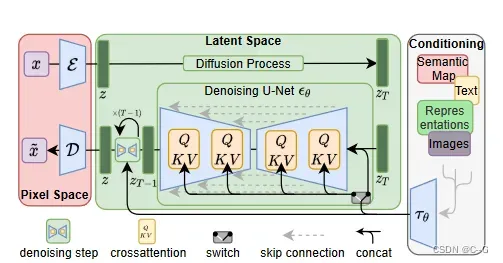

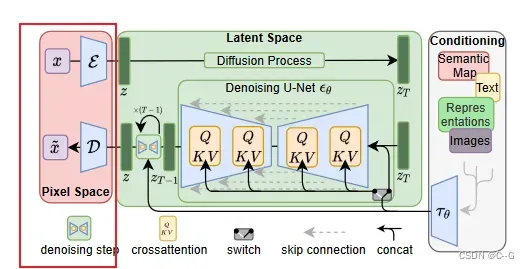

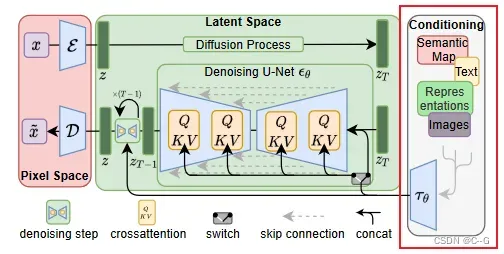

diffusion model明显的缺点是耗费大量的时间、计算资源,为此,论文将其应用于强大的预训练自编码器的潜在空间 ,这是首次允许在复杂性降低和细节保存之间达到一个近乎最佳的点,极大地提高了视觉保真度。通过在模型架构中引入交叉注意层,将扩散模型转化为强大而灵活的生成器,用于一般条件输入,如文本或包围框,并以卷积方式实现高分辨率合成。

这种潜在扩散模型(LDMs)在图像修补和类条件图像合成方面取得了新的最先进的分数,并在各种任务上获得了极具竞争力的性能,包括文本到图像合成,无条件图像生成和超分辨率,同时与基于像素的DMs相比,大大降低了计算需求。

由于扩散模型为空间数据提供了极好的归纳偏差,不需要在潜在空间中对相关生成模型进行大量的空间下采样,但仍然可以通过合适的自动编码模型大大降低数据的维数

数字图像的大多数位对应于难以察觉的细节。虽然 DM 允许通过最小化 responsible loss 来抑制这些语义上无意义的信息,但梯度(在训练期间)和神经网络主干(训练和推理)仍然需要在所有像素上进行评估,导致多余的计算和不必要的昂贵优化和推理。提出潜在扩散模型(DLMs)作为一个有效的生成模型和一个单独的温和压缩阶段,只消除不可察觉的细节

贡献点:

与纯粹基于变压器的方法相比,LDMs更适合于高维数据 。首先,可以在压缩级别上工作,比以前的工作提供更忠实和详细的重建,其次,可有效应用于百万像素图像的高分辨率合成。

LDMs在多个任务(无条件图像合成,修补,随机超分辨率)和数据集上实现了具有竞争力的性能,同时显著降低了计算成本。与基于像素的扩散方法相比,还显著降低了推理成本。

与之前同时学习编码器/解码器架构和基于分数的先验的工作相比,LDMs不需要对重建和生成能力进行微妙的加权。这确保了非常忠实的重建和需要很少的正则化的潜在空间。

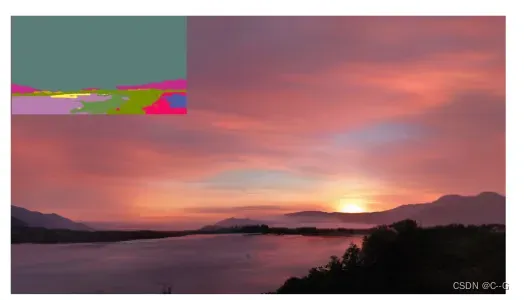

对于超分辨率、修补和语义合成等条件密集的任务,LDMs可以以卷积方式应用,并呈现大而一致的~

px图像。

px图像。

设计了一种基于交叉注意的通用条件反射机制,实现了多模态训练。用它来训练类条件模型、文本到图像模型和布局到图像模型

实现流程

尽管扩散模型允许通过对相应的损失项进行欠采样来忽略感知上不相关的细节,但它们仍然需要在像素空间中进行昂贵的函数评估,这导致了对计算时间和能量资源的巨大需求。论文引入压缩与生成学习阶段的显式分离来规避这一缺点 ,使用了一种自动编码模型,该模型学习的空间在感知上与图像空间等效,但大大降低了计算复杂度 。有以下几个优点:

通过离开高维图像空间,获得的 DMs 在计算上更有效,因为采样是在低维空间上执行的

利用了继承自其UNet架构的 DMs 的归纳偏差,这使得它们对于具有空间结构的数据特别有效 ,减轻了以往方法所要求的激进的、降低质量的压缩级别的需要

得到通用压缩模型,其潜在空间可用于训练多个生成模型,也可用于其他下游应用,如单幅图像CLIP指导生成

Perceptual Image Compression

感知图像压缩 模块由一个结合感知损失和基于补丁的对抗目标训练的自编码器组成 ,其通过加强局部真实感来确保重建被限制在图像流形中,并避免仅依靠像素空间损失(如L2或L1目标)而引入的模糊。

输入图像 ![]() ,编码器

,编码器 ![]() 编码为潜变量

编码为潜变量![]() ,解码器从潜变量中重构图像,即

,解码器从潜变量中重构图像,即![]()

为了避免任意高方差的潜在空间,尝试了两种不同的正则化

KL-reg 对习得潜变量的标准normal施加轻微的kl惩罚,类似于VAE

VQ-reg在解码器中使用矢量量化层,可以解释为一个VQGAN,但量化层被解码器吸收 。后续DM设计用于学习的潜在空间

的二维结构,所以可以使用相对温和的压缩率并实现非常好的重建

的二维结构,所以可以使用相对温和的压缩率并实现非常好的重建

之前的工作依赖于学习空间z的任意1D顺序来对其分布进行自回归建模,从而忽略了z的大部分固有结构,而压缩模型更好地保留了x的细节

Latent Diffusion Models

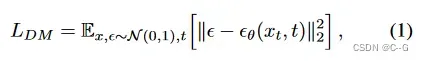

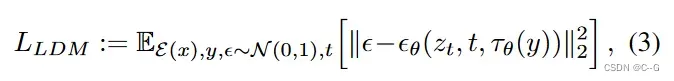

原始DM为:

通过训练过的由![]() 和D组成的感知压缩模型,现在可以获得一个有效的、低维的潜在空间,其中高频的、难以察觉的细节被抽象掉了 。

和D组成的感知压缩模型,现在可以获得一个有效的、低维的潜在空间,其中高频的、难以察觉的细节被抽象掉了 。

与高维像素空间相比,这个空间更适合基于可能性的生成模型,因为它们现在可以

专注于数据的重要语义位

在低维、计算效率更高的空间中训练。

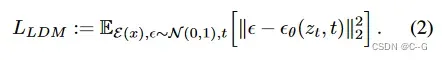

![]() 是时间条件的UNet ,由于正向过程是固定的,所以在训练过程中可以有效地从

是时间条件的UNet ,由于正向过程是固定的,所以在训练过程中可以有效地从![]() 中获得

中获得 ![]() ,并且 p(z) 中的样本可以通过D一次解码到图像空间。

,并且 p(z) 中的样本可以通过D一次解码到图像空间。

Conditioning Mechanisms

使用交叉注意机制(cross-attention mechanism)增强DMs的底层UNet主干,将其转变为更灵活的条件图像生成器,这对于学习各种输入模式的基于注意的模型是有效的

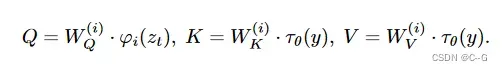

为了从各种模式(如语言提示)对y进行预处理,引入了领域特定的编码器 ![]() ,将y投影到中间表示

,将y投影到中间表示 ![]() ,然后通过实现注意力

,然后通过实现注意力 ![]() 的交叉注意层映射到UNet的中间层

的交叉注意层映射到UNet的中间层

![]() 表示实现

表示实现 ![]() 的UNet的一个(扁平)中间表示,

的UNet的一个(扁平)中间表示,![]() 是可学习的投影矩阵

是可学习的投影矩阵

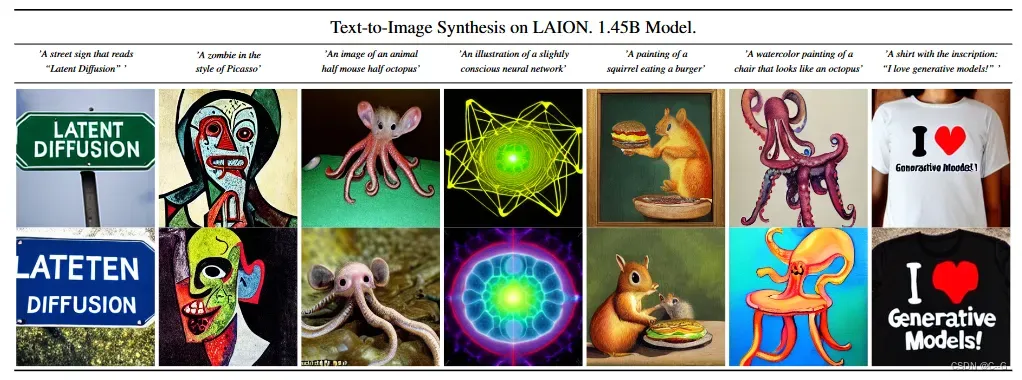

论文使用BERT-tokenizer 实现 ![]() 作为转换器来推断一个潜在代码,该代码通过(多头)交叉注意映射到UNet 。这种学习语言表示和视觉合成的领域特定专家的结合产生了一个强大的模型,它很好地概括了复杂的、用户定义的文本提示

作为转换器来推断一个潜在代码,该代码通过(多头)交叉注意映射到UNet 。这种学习语言表示和视觉合成的领域特定专家的结合产生了一个强大的模型,它很好地概括了复杂的、用户定义的文本提示

用户定义的文本提示样本来自文本到图像合成模型LDM-8 (KL),该模型是在LAION数据库上训练的。以200个DDIM步骤生成样品,η = 1.0。使用无条件引导,s = 10.0。

Experiments

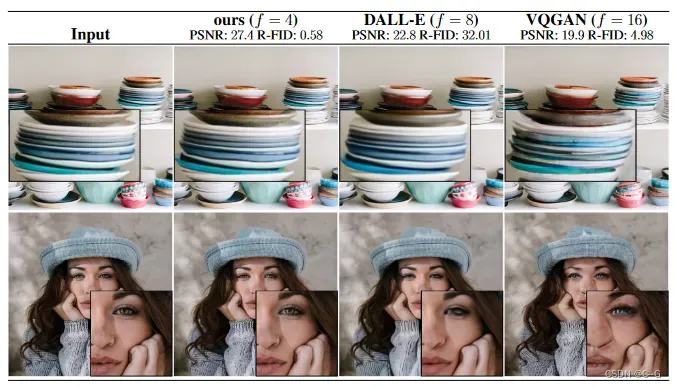

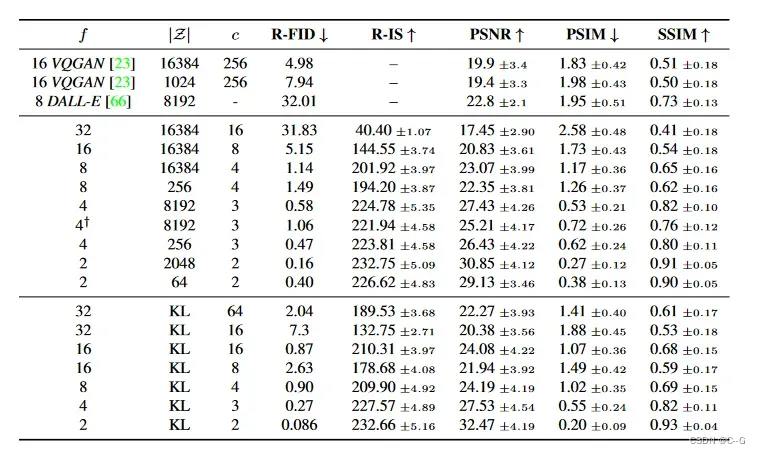

在OpenImages上训练的完整的自编码器,在ImageNet-Val上评估。†表示无需注意的自动编码器

在 VQ正则化潜在空间中训练的 LDMs 有时可以获得更好的样本质量,尽管VQ正则化第一阶段模型的重构能力略低于连续模型cf

编码器下采样因子![]() 。

。

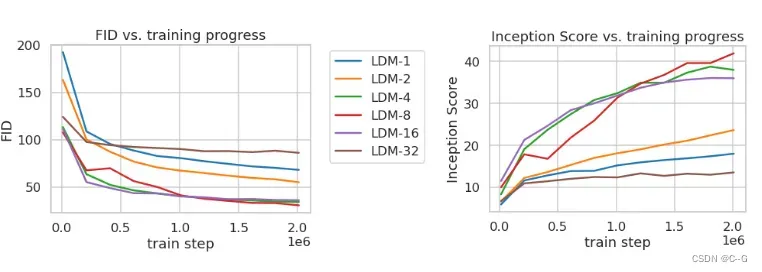

LDM-{1,2}的小下采样因素导致训练进展缓慢 。

过大的f值导致在相对较少的训练步骤后保真度停滞 。原因可以归结为:

将大部分感知压缩留给扩散模型

太强的第一阶段压缩导致信息丢失,从而限制了可实现的质量

LDM-{4-16}在效率和感知忠实结果之间取得了良好的平衡,这体现在2M训练步骤后,基于像素的扩散(LDM-1)和LDM-8之间的FID差距为38

Frechet Inception 距离得分(Frechet Inception Distance score,FID)是计算真实图像和生成图像的特征向量之间距离的一种度量。

FID 从原始图像的计算机视觉特征的统计方面的相似度来衡量两组图像的相似度,这种视觉特征是使用 Inception v3 图像分类模型计算的得到的。分数越低代表两组图像越相似,或者说二者的统计量越相似,FID 在最佳情况下的得分为 0.0,表示两组图像相同。

分析了ImageNet数据集上2M以上训练步具有不同下采样因子的类条件 LDMs 的训练。与具有较大下采样因子(LDM-{4-16})的模型相比,基于像素的LDM-1需要更大的训练时间。LDM-32中过多的感知压缩限制了整体样本质量。所有模型都在一台NVIDIA A100上训练,计算预算相同。100个DDIM步骤[84],且κ = 0。

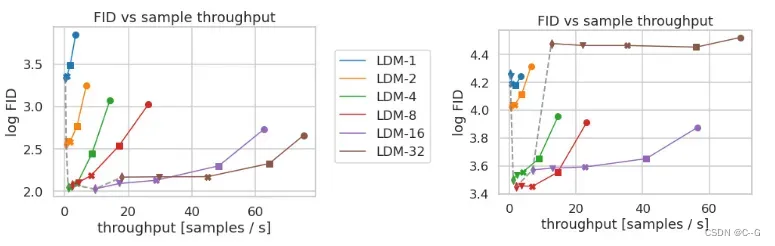

在CelebA-HQ(左)和ImageNet(右)数据集上比较不同压缩的 LDMs。不同的标记表示使用DDIM的{10,20,50,100,200} 采样步骤,沿着每条线从右向左。虚线显示了200步的FID分数,表明LDM{4-8}的强大性能。对5000个样本进行FID评分。在A100上对所有模型进行500k (CelebA) / 2M (ImageNet)步长训练。

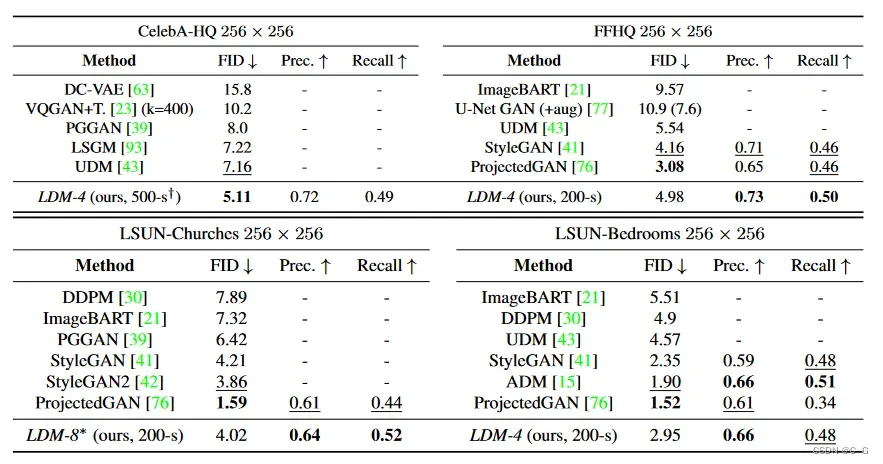

无条件图像合成的评价指标。CelebA-HQ,FFHQ,†:N -s指的是DDIM采样器的N个采样步骤。*:在kl正则化潜空间中训练。

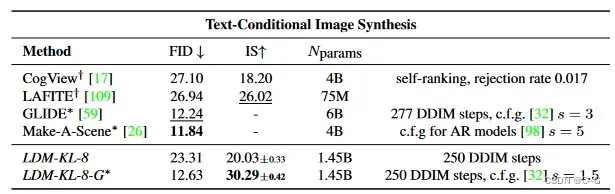

在256 × 256大小的MS-COCO 数据集上评估文本条件图像合成:模型有250个DDIM步,尽管使用了明显较少的参数,但与最新的扩散和自回归[26]方法相当。†/ *:Numbers from

超分辨率

遮挡

Limitations & Societal Impact&Conclusion

Limitations

虽然与基于像素的方法相比,LDMs 显著降低了计算需求,但其顺序采样过程仍然比GANs慢。此外,当需要高精度时,LDMs的使用可能是有问题的:尽管在f = 4自动编码模型中图像质量的损失非常小,但它们的重建能力可能成为在像素空间中需要细粒度精度的任务的瓶颈。超分辨率模型在这方面已经有些局限。

Societal Impact

图像等媒体的生成模型是一把双刃剑:一方面,它们使各种创造性应用成为可能,特别是像我们这样降低训练和推理成本的方法,有可能促进这种技术的使用,并使其探索民主化。另一方面,这也意味着创建和传播被操纵的数据或传播虚假信息和垃圾邮件变得更加容易。特别是,故意操纵图像(“深度造假”)是这一背景下的一个常见问题,女性尤其受其影响较大

生成模型还可以显示他们的训练数据,当数据包含敏感或个人信息并且未经明确同意收集时,这是非常值得关注的。然而,这在多大程度上也适用于图像的 DMs 还没有完全理解。

最后,深度学习模块倾向于重现或加剧数据中已经存在的偏见。虽然扩散模型比基于GANs的方法更好地覆盖了数据分布,但结合了对抗性训练和基于可能性的目标的两阶段方法在多大程度上歪曲了数据仍然是一个重要的研究问题。

Conclusion

提出了潜在扩散模型,这是一种简单有效的方法,可以在不降低扩散模型质量的情况下显著提高去噪扩散模型的训练和采样效率。基于这一点和交叉注意调节机制,实验可以在没有任务特定架构的情况下,在广泛的条件图像合成任务中,与最先进的方法相比,展示出良好的结果。

文章出处登录后可见!