4D-Net for Learned Multi-Modal Alignment

单位:谷歌, Waymo, 谷歌Robotics

ICCV 2021

1.摘要+intro

第一个问题因为单独一个时间点的点云数据有时可能是不够的,例如,对象在很远范围内反馈回的点很稀疏,或者对于非常小的对象点也很少,在其他方法与3D点云输入相结合时,其中更多的信息无疑包含在RGB数据中。 还有个问题就是针对传感器融合的方法,当两者在时间上进行传输时,还没有任何方法尝试将它们组合在一起。

为了解决这些挑战,我们提出了4D-Net(3D+时间),它将点云信息和RGB相机的数据结合在一起,在时间上都是有效的和可学习的(即考虑了点云序列和图像序列)。在我们的方法中,每个模态都被一个合适的体系结构处理,产生丰富的特征,然后通过动态连接学习在不同的层次上对齐和融合这些特征。这与后期融合形成了鲜明对比,因为后期融合的特征可能已经丢失了空间信息。实验结果表明,这是处理来自多个传感器的4D信息的一种有效而高效的方法。重要的是,能够及时合并密集的空间信息和时间上的信息,提高了对较远距离和较小且难以看到的目标的检测。

2.贡献点

(1)第一个跨越4维的4D网络,在时间上结合了点云和图像;

(2)一种新的学习方法,它在4D上学习融合多个模态;

(3)一种简单而有效的3D点云实时采样技术;

3.method

3.1 数据处理

点云的及时处理

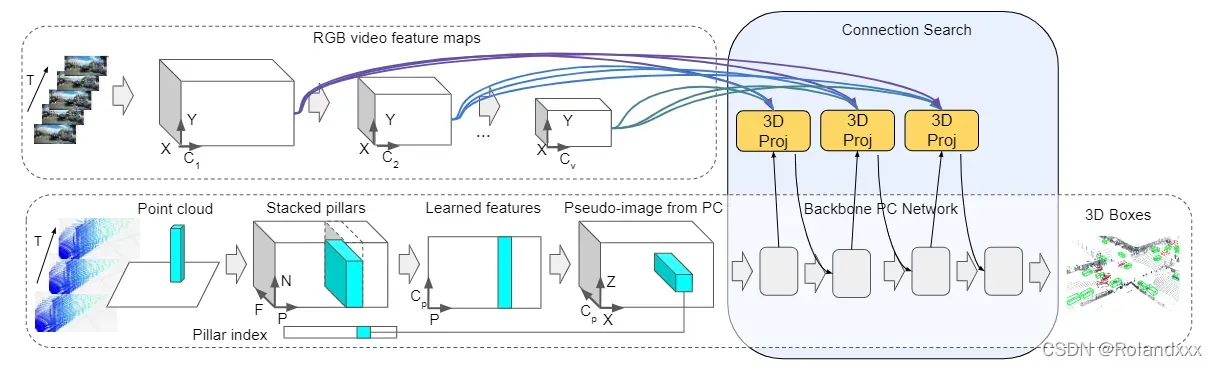

因为假设有T个点云,利用Pointpillar这样创建T个伪图像,然后因为使用2d或3d CNN来处理所有的这些帧是非常耗费时间的。 取而代之的是,作者采用了更简单的方法,但是它保留了每个3D点的原始特征表示,并具有时间感。大体方法就是原始特征表示被直接合并到三维点云中,连同指示其时间戳的特征一起。然后,像以前一样创建PointPillar伪图像表示,这也产生了密度表示,输出特征是个伪图像,shape为HWC,2d CNN可以处理

RGB在时间上的处理

我们将一系列RGB帧作为视频输入使用了Tiny Video Networks进行处理,输出特征是(X,Y,C),2d cnn可以处理的

3.2 4D-Net网络结构(在时间上融合RGB和点云)

为什么要使用投影融合机制和连接搜索来了解融合特征的位置和方式:

1)因为两个传感器需要在几何和空间上对齐;2)因为理想情况下,多模态产生得到的特征融合机制应该从数据中学到。

网络的输出是在点云这个分支是因为我们的最终目标是3D目标检测,所以我们选择将RGB特征融合到点云特征中。

3.2.1 3d投影

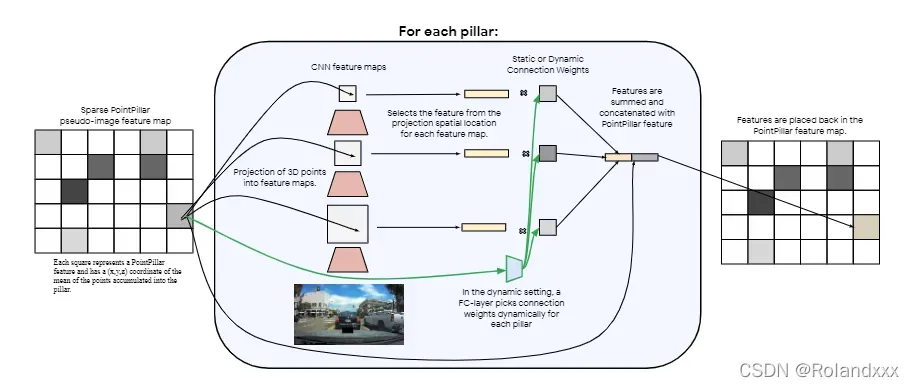

Waymo Open数据集提供所有校准和同步的LiDAR和相机数据。使用投影,我们可以对齐RGB和点云数据,因为RGB有三个尺度,所以一个pillar要通过投影变换分别和这三个RGB对齐。因为每个柱子p还可以得到表示其中心的(x0,y0,z0)坐标,所以这就为每个非空的特征图的位置提供了3d坐标,即一个柱子就对应一个3d坐标,一共有H×W个柱子对应H×W个坐标。将一个坐标为(x,y,z,1)的3d点,投影到2d坐标,因为2d有三个尺度,所以每个pillar要和2d的点对齐,然后坐标对齐后。2d点的RGB特征和对应对齐坐标的每个pillar特征会进行concatenate(因为对齐后每个pillar的位置就对应RGB的一个像素),由于我们的最终目标是3D目标检测,所以我们选择将RGB特征融合到点云特征中。

3.2.2 Connection Architecture Search(连通搜索)

因为上面的投影会在地理上对齐两个传感器,所以对于主要的物体检测任务,网络还没有清楚地知道应该从每个传感器中提取什么信息以及传感器特征如何交互。因此设计了一个轻量级的网络架构来学习传感器之间的连接和融合。

这里介绍了一个学习好了的权重w,它允许网络学习不同层次的特征抽象和不同的特征源(即RGB、点云)之间的关系(有效的原因)。因为每一个pillar投射后要和三个尺度的RGB对齐,如上面第一组箭头Projection of 3D points into feature maps的意思就是 灰色的正方形框就代表RGB的三个尺度,箭头的意思就是把pillar对应到正方形中的一个点上去。然后根据pillar的位置取到对应位置的RGB像素,每个尺度的那一个像素与对应的w(基于softmax输出)相乘决定要不要选取这个像素,总共有三个像素参与这样的操作,因为有三个尺度的RGB特征图。然后留下的RGB像素点和点云图上的那个pillar特征进行concatenate。得到一个新的融合后的pillar,每个pillar都进行这样的操作得到点云特征,用作点云网络下一个层的输入(从网络结构可以看出来,就是随便一个黄色的3d project块到它右下角那一个灰色块的连接,就是这一步操作)。

动态连接权重:因为较远的物体将在RGB图像中看起来较小,所以与近距离的物体相比,较远的物体就越需要越早层的图像特征。所以通过受注意力机制的启发将之前的w改为了动态连接。即将原来的连接权重权重w替换为具有b个输出的线性层ω(softmax作为输出),该线性层的输入是对应的那一天pillar特征,通过学习这个pillar,分别生成3个权重(即分布三个尺度上的对应的那3个像素点位置)。这允许网络根据目前的这一个pillar特征动态的选择要从哪个尺度的RGB信息进行融合。例如,这个pillar特征对应的是小物体的位置(稀疏点云),那么它就会选择和高分辨率的RGB特征进行融合。

3.3 多流4D-Net

因为作者发现加了一个RGB流可以帮助网络更好的识别远处物体,可能可以是获取到了更多的高分辨率特征。让网络可以接受多个RGB输入流,我们可以添加一个单独的塔来处理高分辨率静止图像,或者添加一个使用不同主干或不同时间分辨率的附加视频塔

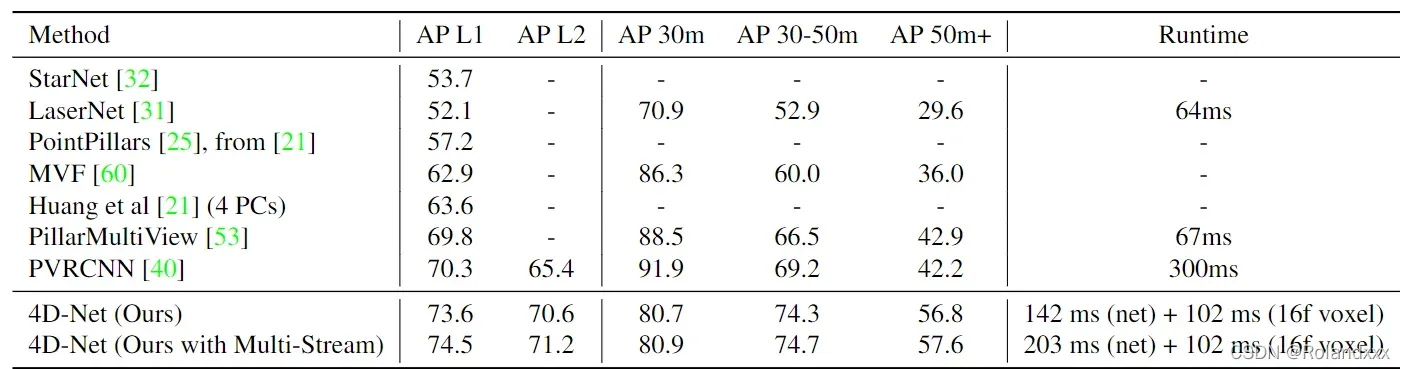

4.实验结果

在Waymo Open数据集下,显示了4D-NET与最近最先进的3d目标检测(SOTA)方法的比较结果,在检测远距离对象时,它的性能比之前最好的高了14.6AP和15.4AP。推理时间也记录了点云预处理(体素化)的时间,相比下来还可以。

版权声明:本文为博主Rolandxxx原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/Rolandxxx/article/details/123275799