相同的数据型态,利用不同的方法分析,就可以解决不同的课题。例如目前已相当纯熟的人脸识别技术,在国防应用可以进行安保工作;企业可做员工门禁系统;可结合性别、年龄辨识让卖场进行市调分析,或结合追踪技术进行人流分析等。

本篇接下来要针对深度学习方法的数据类型或算法,介绍AI常见的应用。

1. 神经网络算法

以算法区分深度学习应用,算法类别可分成三大类:

- 常用于影像数据进行分析处理的卷积神经网络(简称CNN)

- 文本分析或自然语言处理的递归神经网络(简称RNN)

- 常用于数据生成或非监督式学习应用的生成对抗网络(简称GAN)

| CNN卷积神经网络(简称CNN) | CNN主要应用可分为图像分类(image classification)、目标检测(object detection)及语义分割(semantic segmentation)。下图可一目了然三种不同方法的应用方式。 1、图像分类 (Classification) 顾名思义就是将图像进行类别筛选,通过深度学习方法识别图片属于哪种分类类别,其主要重点在于一张图像只包含一种分类类别,即使该影像内容可能有多个目标,所以单纯图像分类的应用并不普遍。不过由于单一目标识别对深度学习算法来说是正确率最高的,所以实际上很多应用会先通过目标检测方法找到该目标,再缩小撷取影像范围进行图像分类。所以只要是目标检测可应用的范围,通常也会使用图像分类方法。图像分类也是众多用来测试算法基准的方法之一,常使用由ImageNet举办的大规模视觉识别挑战赛(ILSVRC)中提供的公开图像数据进行算法测试。图像分类属于CNN的基础,其相关算法也是最易于理解,故初学者应该都先以图像分类做为跨入深度学习分析的起步。使用图像分类进行识别,通常输入为一张图像,而输出为一个文字类别。

一张图像内可有一或多个目标物,目标物也可以是属于不同类别。算法主要能达到两种目的:找到目标坐标及识别目标类别。简单来说,就是除了需要知道目标是什么,还需要知道它在哪个位置。 3、语义分割 (Semantic Segmentation) 算法会针对一张图像中的每个像素进行识别,也就是说不同于目标检测,语义分割可以正确区别各目标的边界像素,简单来说,语义分割就是像素级别的图像分类,针对每个像素进行分类。当然这类应用的模型就会需要较强大的GPU和花较多时间进行训练。 |

| RNN | RNN的特色在于可处理图像或数值数据,并且由于网络本身具有记忆能力,可学习具有前后相关的数据类型。例如进行语言翻译或文本翻译,一个句子中的前后词汇通常会有一定的关系,但CNN网络无法学习到这层关系,而RNN因具有内存,所以性能会比较好。因为可以通过RNN进行文字理解,其他应用如输入一张图像,但是输出为一段关于图像叙述的句子。(如下图) |

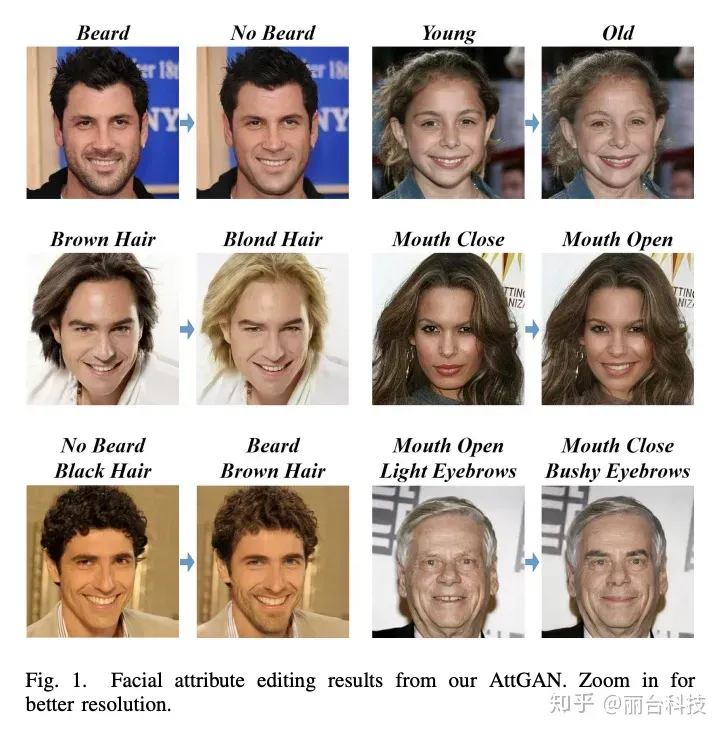

| GAN | 除了深度学习外,有一种新兴的网络称为强化学习(Reinforcement Learning),其中一种很具有特色的网络为生成式对抗网络(GAN)。 这里不详述GAN的理论或实作方式,而是探讨GAN实际应用的场域。深度学习领域最需要的是数据,但往往不是所有应用都可以收集到大量数据,并且数据也需要人工进行标注,这是非常消耗时间及人力成本。图像数据可以通过旋转、裁切或改变明暗等方式增加数据量,但如果数据还是不够呢?目前有相当多领域透过GAN方法生成非常近似原始数据的数据,例如3D-GAN就是可以生成高质量3D对象。当然,比较有趣的应用例如人脸置换或表情置换。(如下图)

|

2. 基于时间序列的预测算法

时间序列预测就是利用过去一段时间的数据来预测未来一段时间内的信息,包括连续型预测(数值预测,范围估计)与离散型预测(事件预测)等,具有非常高的商业价值。

需要明确一点的是,与回归分析预测模型不同,时间序列模型依赖于数值在时间上的先后顺序,同样大小的值改变顺序后输入模型产生的结果是不同的。

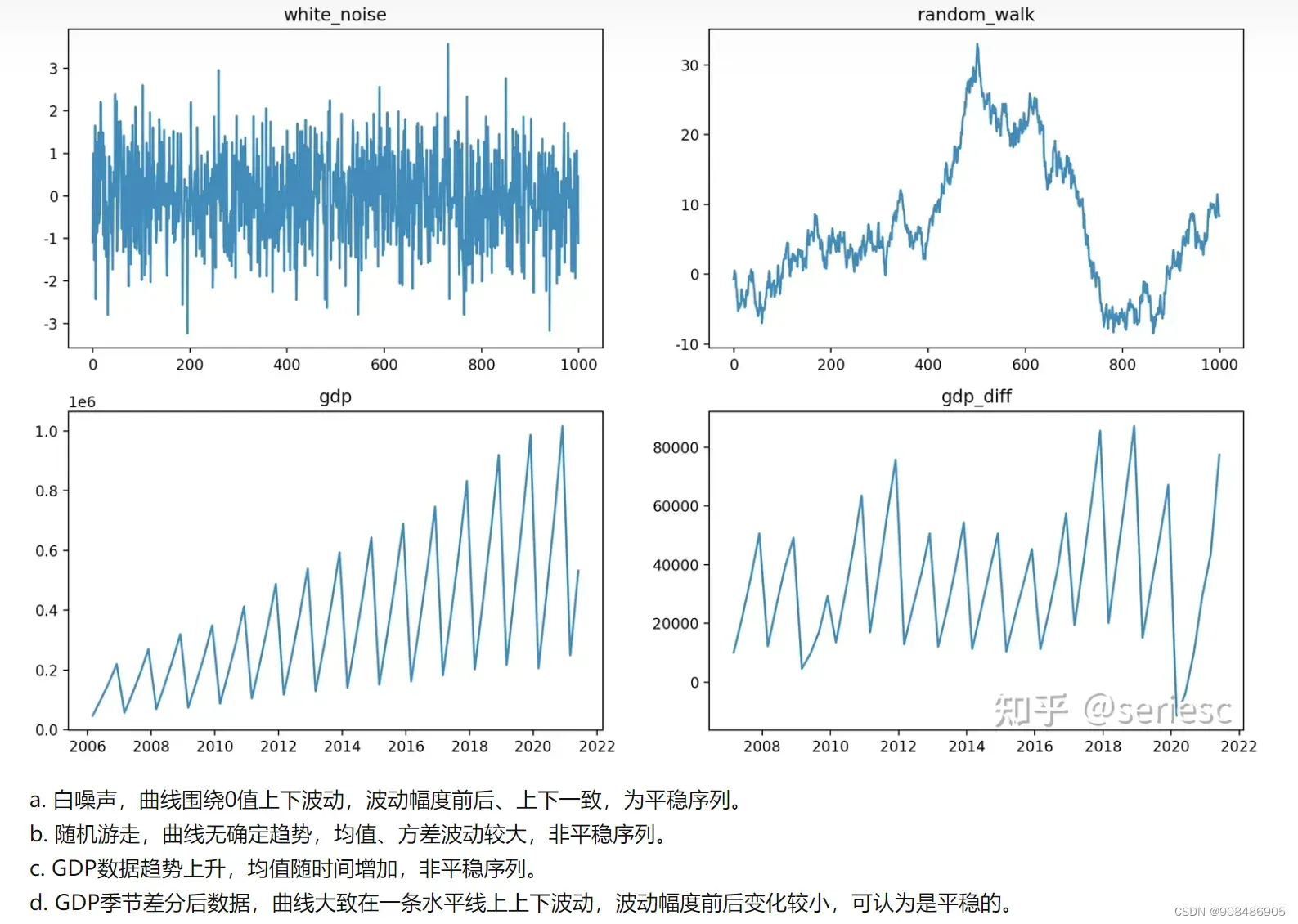

如之前的文章所介绍,时间序列可以分为平稳序列,即存在某种周期,季节性及趋势的方差和均值不随时间而变化的序列,和非平稳序列。

本文为大家总结时间序列预测的有关方法,浅析这些技术并探索如何可以提高这些方法的预测效果。

1) 自回归积分移动平均或ARIMA(Autoregressive Integrated Moving Average Model)模型

自回归积分移动平均模型或ARIMA(p,d,q),相当于在自回归移动平均过程(ARMA)的基础上增加了积分要素,相比AR、MA、ARMA模型来说,不再对数据平稳性存在要求,在模型中可以直接通过积分参数d控制数据差异化的次数。

将预测对象按照时间顺序排列起来,构成一个所谓的时间序列,从所构成的一组时间序列的变化规律,推断今后变化的可能性及变化趋势、变化规律,就是时间序列预测法。

时间序列模型其实也是一种回归模型,其基于的原理是,一方面承认事物发展的延续性,运用过去时间序列的数据统计分析就能推测事物的发展趋势;另一方面又充分考虑到偶然因素影响而产生的随机性,为了消除随机波动的影响,利用历史数据,进行统计分析,并对数据进行适合的处理,进行趋势预测。

自回归模型是用自身做回归变量的过程,即利用前期若干时刻的随机变量的线性组合来描述以后某时刻随机变量的线性回归模型,它是时间序列中的一个常见形式。

AR模型利用前期数值与后期数值的相关关系(自相关),建立包含前期数值和后期数值的回归方程,达到预测的目的,因此成为自回归过程。比较自回归过程和MA移动平均过程可知,移动平均过程其实可以作为自回归过程的补充,解决自回归方差中白噪声的求解问题,两者的组合就成为自回归移动平均过程,称为ARMA模型。

从回归方程可知,自回归移动平均模型综合了AR和MA两个模型的优势,在ARMA模型中,自回归过程负责量化当前数据与前期数据之间的关系,移动平均过程负责解决随机变动项的求解问题,因此,该模型更为有效和常用。

介绍时间序列平稳性时提到过,AR/MA/ARMA模型适用于平稳时间序列的分析,当时间序列存在上升或下降趋势时,这些模型的分析效果就大打折扣了,这时差分自回归移动平均模型也就应运而生。ARIMA模型能够用于齐次非平稳时间序列的分析,这里的齐次指的是原本不平稳的时间序列经过d次差分后成为平稳时间序列。

在现实生活中,存在很多非平稳的时间序列,它们的均值和方差是随着时间的变化而变化的,幸运的是,统计学家们发现,很多时间序列本身虽然不平稳,但是经过差分(相邻时间点的指标数值相减)之后,形成的新时间序列就变成平稳时间序列了。因此,差分自回归移动平均模型写成ARIMA(p,d,q)。p代表自回归阶数;d代表差分次数;q代表移动平均阶数。在spss软件中,有时输出的ARIMA模型包括6个参数:ARIMA(p,d,q)(P,D,Q),这是因为如果时间序列中包含季节变动成分的话,需要首先将季节变动分解出来,然后再分别分析移除季节变动后的时间序列和季节变动本身。这里小写的p,d,q描述的是移除季节变动成分后的时间序列;大写的P,D,Q描述的是季节变动成分。两个部分是相乘的关系。因此,ARIMA(p,d,q)(P,D,Q)也被称为复合季节模型。

3. 累积距平法(Cumulative.0ffset. .Verification, COV) /累积偏差法

累积距平是一种用于检验计量器的精度、稳定性和可靠性的方法。该方法通过分别记录被测计量器测量的结果和标准测量结果之间的差值,并将其累积起来,从而计算出平均差值和标准偏差。这种方法的优点在于可以消除系统漂移和运动误差的影响,从而提供更准确的结果。

在进行累积距平法检测之前,需要先确定所选的参考标准测量器是否符合要求。标准测量器应具有高精度、稳定性和可靠性,并经过校准。在检测过程中,被测计量器应准确地连接到标准测量器,并按指定的测量标准进行测量。同时还需保持测量环境稳定,并排除外力干扰。每次测量的差值将被累加起来,以得到平均差值和标准偏差。平均差值指的是所有测量结果与标准测量结果之间的差值的平均值,而标准偏差则表示这些…

利用距平法对洮河流域降水特性的分析

累积距平法是一种常用的数据分析方法,它通过计算数据点与平均值之间的差距,并累积这些差距值,来帮助我们判断数据的分布情况。通过绘制累积距平图,我们可以直观地了解数据的偏离程度。这可以帮助我们在实际应用中更好地理解和解释数据,从而做出更准确、可靠的决策。

累计偏差是指在一段时间内.数值或观测结果与预期值之间的累积差异或偏离程度。它可以用于分析和评估实际结果与理论模型、预测值或标准之间的差异。在统计学和数据分析领域,累计偏差通常用于衡量实际观测值与预期值之间的总体差异。它可以通过将每个观测值与预期值之间的差异相加来计算得出。

累计偏差可以在不同应用场景中起到重要作用。例如,在财务分析中,它可以用于评估公司的实际销售额与预期销售额之间的差距。在生产过程控制中,累计偏差可以用来监测产品质量是否符合规范要求。

通过计算累计偏差,我们可以获得对实际结果与预期值之间偏离程度的整体了解。这有助于识别系统中的潜在问题、改进预测模型或调整决策以提高结果的准确性和一致性。

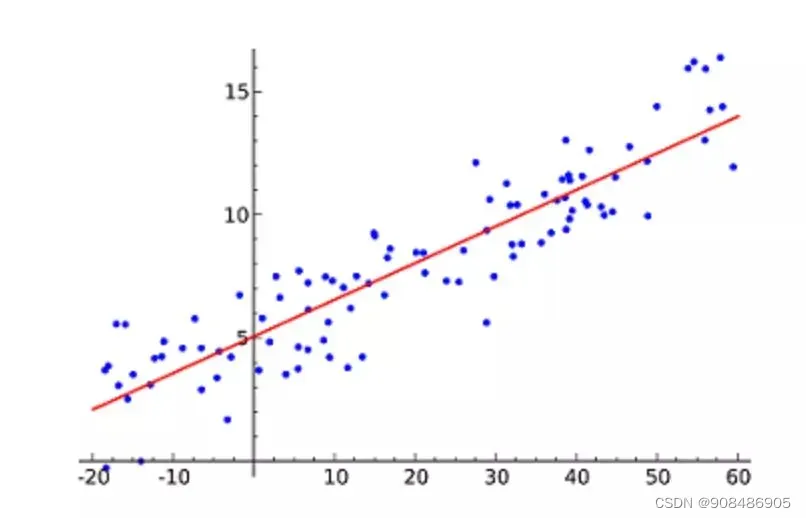

4. 线性回归

线性回归(Linear Regression)可能是最流行的机器学习算法。线性回归就是要找一条直线,并且让这条直线尽可能地拟合散点图中的数据点。它试图通过将直线方程与该数据拟合来表示自变量(x 值)和数值结果(y 值)。然后就可以用这条线来预测未来的值!这种算法最常用的技术是最小二乘法(Least of squares)。这个方法计算出最佳拟合线,以使得与直线上每个数据点的垂直距离最小。总距离是所有数据点的垂直距离(绿线)的平方和。其思想是通过最小化这个平方误差或距离来拟合模型。

比如预测明年的房价涨幅、下一季度新产品的销量等等。听起来并不难,不过线性回归算法的难点并不在于得出预测值,而在于如何更精确。

5. 分类算法

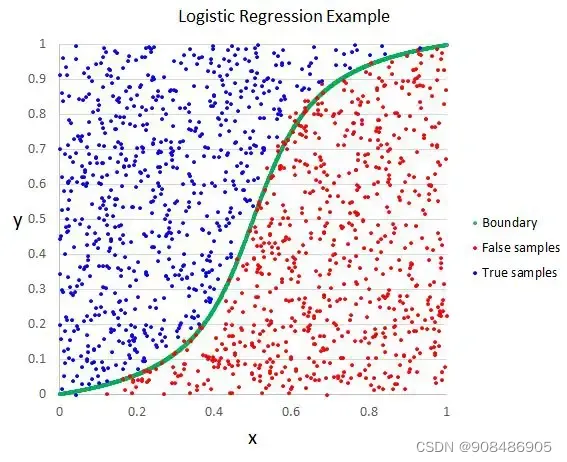

| 5. 逻辑回归—逻辑回归是线性分类器(线性模型)—— 主要用于二分类问题 | 逻辑回归(Logistic regression)与线性回归类似,但逻辑回归的结果只能有两个的值。如果说线性回归是在预测一个开放的数值,那逻辑回归更像是做一道是或不是的判断题。逻辑函数中Y值的范围从0到1,是一个概率值。逻辑函数通常呈S 型,曲线把图表分成两块区域,因此适合用于分类任务。逻辑回归经常被电商或者外卖平台用来预测用户对品类的购买偏好。

| ||||||

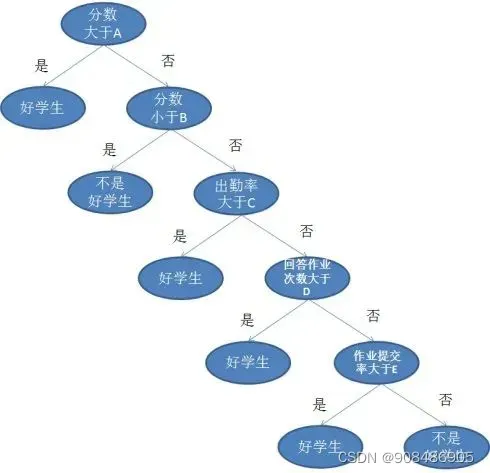

| 6. 决策树 | 如果说线性和逻辑回归都是把任务在一个回合内结束,那么决策树(Decision Trees)就是一个多步走的动作,它同样用于回归和分类任务中,不过场景通常更复杂且具体。举个简单例子,老师面对一个班级的学生,哪些是好学生?如果简单判断考试90分就算好学生好像太粗暴了,不能唯分数论。那面对成绩不到90分的学生,我们可以从作业、出勤、提问等几个方面分开讨论。

| ||||||

| 7. 朴素贝叶斯–朴素贝叶斯分类器(Naive Bayes Classifier) | 用非术语解释贝叶斯定理,就是通过A条件下发生B的概率,去得出B条件下发生A的概率。比如说,小猫喜欢你,有a%可能性在你面前翻肚皮,请问小猫在你面前翻肚皮,有多少概率喜欢你?比如小猫喜欢你,有b%可能和你贴贴,有c%概率发出呼噜声。所以我们如何知道小猫有多大概率喜欢自己呢,通过贝叶斯定理就可以从翻肚皮,贴贴和呼噜的概率中计算出来。 | ||||||

| 8支持向量机(Support Vector Machine,SVM) | 所以支持向量机想要解决的问题也就是如何把一堆数据做出区隔,它的主要应用场景有字符识别、面部识别、文本分类等各种识别。 | ||||||

| 6.K- 最近邻算法(KNN) | |||||||

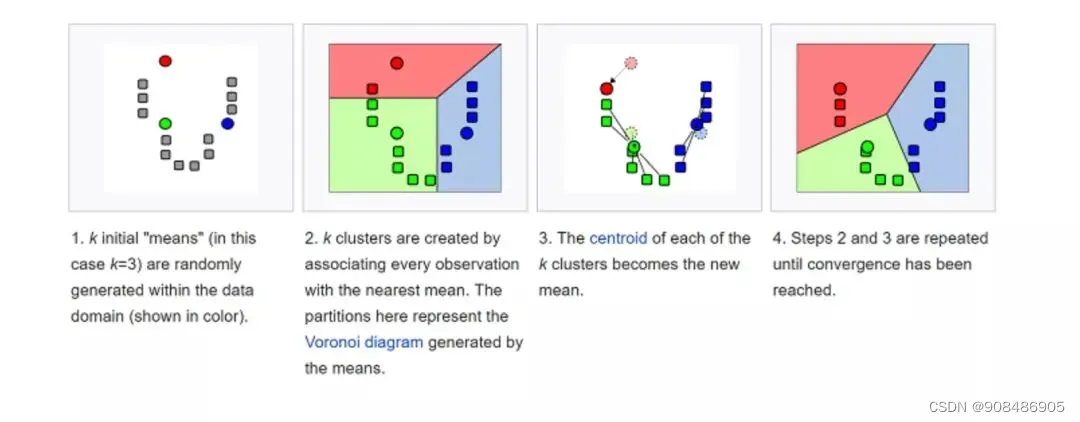

| 7.K-均值 | K-均值(K-means)是通过对数据集进行分类来聚类的。例如,这个算法可用于根据购买历史将用户分组。它在数据集中找到K个聚类。K-均值用于无监督学习,因此,我们只需使用训练数据X,以及我们想要识别的聚类数量K。 该算法根据每个数据点的特征,将每个数据点迭代地分配给K个组中的一个组。它为每个K-聚类(称为质心)选择 K 个点。基于相似度,将新的数据点添加到具有最近质心的聚类中。这个过程一直持续到质心停止变化为止。

生活中,K-均值在欺诈检测中扮演了重要角色,在汽车、医疗保险和保险欺诈检测领域中广泛应用。 | ||||||

| 6. 决策森林回归 | 决策森林回归是一种适用于精准度高、 训练时间短的场景的算法,它通过树形结构将数据划分为多个子集,每个子集对应着一个类别。 | ||||||

6. AI算法在微环境监测的应用—机器学习算法时间序列预测分析

大数据包含了大量的环境监测数据,包括传感器数据、卫星遥感数据、气象数据等。AI可以通过对大数据的挖掘和分析,发现隐藏在数据中的规律和趋势。例如,AI可以通过分析历史环境数据和相关因素的关联性,建立预测模型,预测环境污染事件的发生概率和严重程度。这有助于相关部门提前做好应对准备,采取相应的措施降低环境污染的影响。

机器学习算法在环境污染实时监测预警中扮演着重要角色。通过对历史监测数据的学习和训练,机器学习算法可以建立环境污染模型,并根据实时数据进行预测和预警。例如,利用监测数据和机器学习算法,可以建立空气质量预测模型,预测未来几小时或几天内空气质量的变化趋势。这样的预警系统可以提供准确的预测结果,帮助公众提前做好健康防护和应对措施。

AI技术的优势之一是其能够从大量数据中提取规律和趋势。 通过对历史监测数据的学习和训练, AI系统可以深入分析环境因素与污染物之间的关系,并预测环境变化的趋势。这样,我们就能更好地了解环境状况,并及时采取必要措施来应对潜在的问题。

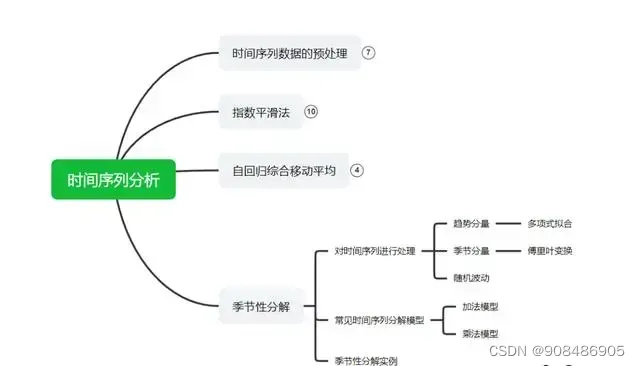

一、时间序列分析的基本概念和方法

1.1时间序列的定义和特点

时间序列是按照时间顺序排列的一系列数据点的集合,其中的数据点可以是连续的或离散的。时间序列的特点包括趋势、周期性、季节性和随机性。

1.2常用的时间序列分析方法

平稳性检验:通过检验时间序列是否具有平稳性来确定后续分析方法的选择。

| 可视化数据即绘制时间序列的折线图,看曲线是否围绕某一数值上下波动(判断均值是否稳定),看曲线上下波动幅度变化大不大(判断方差是否稳定),看曲线不同时间段波动的频率[~紧凑程度]变化大不大(判断协方差是否稳定),以此来判断时间序列是否是平稳的。 | |

| |

-自相关函数(ACF) 和偏自相关函数(PACF) :用于确定时间序列的自相关和偏相关性质,进而选择适合的模型。

| 自相关是指时间序列数据与其自身在不同时间点的相关性。它衡量了- -个时间序列与其滞后版本之间的线性关系。自相关函数(Autocorrelation Function, ACF)是用于测量自相关的工具。ACF的值范围在-1到1之间,其中-1表示完全负相关,1表示完全正相关,0表示无相关。 |

| 偏自相关是在控制其他滞后项的影响下,衡量-一个时间序列与其滞后版本之间的相关性。偏自相关函数(Partial AutocorrelationFunction,PACF)用于测量偏自相关。PACF的计算通常基于递归方法,如Yule-Walker方程。 相关分析用于分析两个事物之间的关系情况,在现实分析中,相关分析往往有第三变量的影响或作用,而使得相关系数不能真实地体现其线性相关程度。比如,研究身高与肺活量之间的关系,身高与肺活量都同体重有关系,如果不考虑体重的影响,就会得到身高越高,肺活量越大,这显然是不准确的。 因此,当存在可能会影响两变量之间的相关性的因素时,就需要使用偏相关分析,以得到更加科学的结论。

|

|

– 季节分解:将时间序列分解为长期趋势、季节性和残差三个部分,更好地理解和预测序列数据。

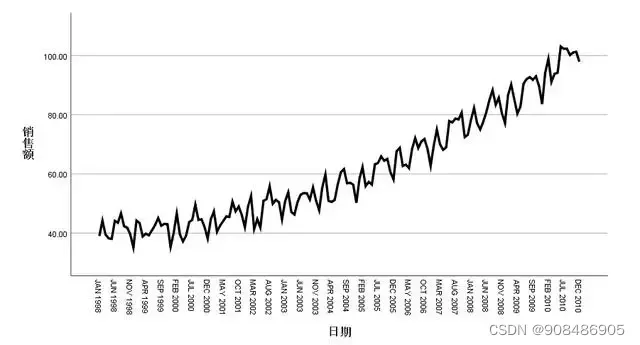

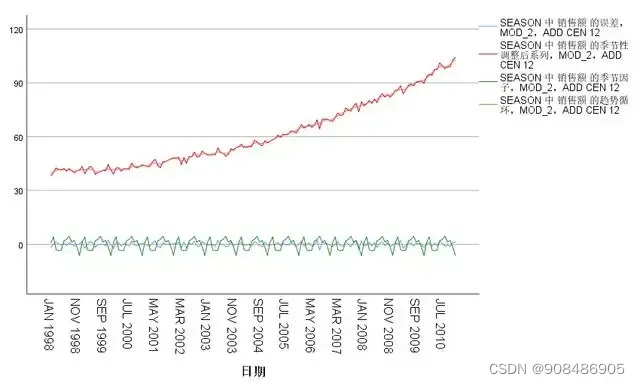

| 在实际工作中,人们经常按月(或年、季度、小时等)记录资料,如每个月的出生人口数、死亡率、某种疾病的发病率、某产品的销售额等,这些资料可能符合某种季节性分布,但这些数字的大小往往受多种因素的影响,从原始数据中很难看出季节趋势。 季节分解法将时间序列分解成三个组成部分,或称三个变量,即“趋势分量”,“季节分量”和“随机波动”,趋势分量采用多项式拟合,季节分量用傅里叶变换估计,其数学表达式为:Yt=f(Tt,St,It)。式中,Tt代表长期趋势(可以是线性趋势,也可以是周期性波动或长周波动),St是季节因子(幅度和周期固定的波动,日历效应为常见的季节因子),It为随机波动(可视为误差)。 |

| 百度安全验证 |

|

二、时间序列预测的基本方法

2.1传统的时间序列预测方法

-移动平均(MA)模型:根据时间序列的平均值来进行预测,适用于没有长期趋势和季节性的数据。

-自回归(AR)模型:根据时间序列自身的相关性来进行预测,适用于有长期趋势但没有季节性的数据。

– 自回归滑动平均(ARMA)模型:结合MA和AR模型,适用于同时存在长期趋势和季节性的数据。

– 季节性自回归滑动平均(SARMA) 模型:在ARMA模型的基础上考虑季节性的数据预测。

2.2利用机器学习进行时间序列预测的方法

-支持向量回归(SVR) :基于支持向量机(SVM)的回归算法, 通过寻找支持向量使得回归误差最小化来进行预测。

-随机森林回归(RF) :利用随机森林的决策树集合进行回归分析,通过集成多个决策树的结果来进行预测。

-神经网络(NN) :通过建立多层神经网络模型,利用前馈和反向传播的算法进行时间序列的预测。

-长短期记忆网络(LSTM) : -种基于循环神经网络的深度学习模型,适合处理长期依赖关系的时间序列预测。

三、机器学习在实际时间序列分析中的应用案例

3.1经济领域中的时间序列分析和预测

-股票市场预测:利用机器学习方法对股票市场中的时间序列数据进行分析和预测,帮助投资者做出决策。

-经济增长预测:通过对宏观经济指标的时间序列数据进行预测,为政府和企业提供可靠的经济发展趋势预测。

3.2环境领域中的时间序列分析和预测

-气候变化预测:基于历史气象数据,利用机器学习方法预测未来的气候变化情况,为农业、城市规划等提供决策支持。

空气质量预测:通过对空气质量指标的时间序列数据进行分析和预测,提前采取相应的防护措施以保护大众健康。

根据系统观测得到的时间序列数据,通过曲线拟合和参数估计来建立数学模型,分析其随时间的变化趋势,对预测目标进行外推的定量预测方法。

时间序列预测方法常用在国民经济宏观控制,企业经营管理,市场潜量预测,气象预报等方面。

主要介绍:移动平均、指数平滑。

2.1.1.1.移动平均

根据时间序列资料逐项推移,依次计算包含一定项数的序时平均值,以反映长期变化趋势。适用于短期预测。

移动平均法能有效地消除预测中的随机波动。

不足:

(1) 不能很好地反映出未来趋势;

(2)需要大量的过去数据的记录。

2.1.1.2.指数平滑

用过去数据的加权平均数作为预测值,即第t+1期的预测值等于第t期的实际观察值与第t期预测值的加权平均值。(指数平滑法是加权平均的–种特殊的形式,观察值时间越远,其权数也跟着呈现指数的下降,因而称为指数平滑)

优点:

(1)只需一个最近时期观测值的权数,其他时期数据的权数可自动推算;适用于短期预测。

(2)需要数据量较少,只需前一期的实际观测值及前一期的预测值。

7. 大数据分析AI工具的常用算法美林数据TempodataTempoAI

人工智能的概念始于1956年的达特茅斯会议,由于受到数据、计算力、智能算法等多方面因素的影响,人工智能技术和应用发展经历了多次高潮和低谷。2006年以来,以深度学习为代表的机器学习算法在机器视觉和语音识别等领域取得了极大的成功,识别准确性大幅提升,使人工智能再次受到学术界和产业界的广泛关注。数据、计算力和算法被认为是人工智能发展的三大核心要素,数据是基础,算法是核心,计算力是支撑。因此,要衡量一个大数据分析平台的核心能力,最为关键的一定是其所具备的算法能力。

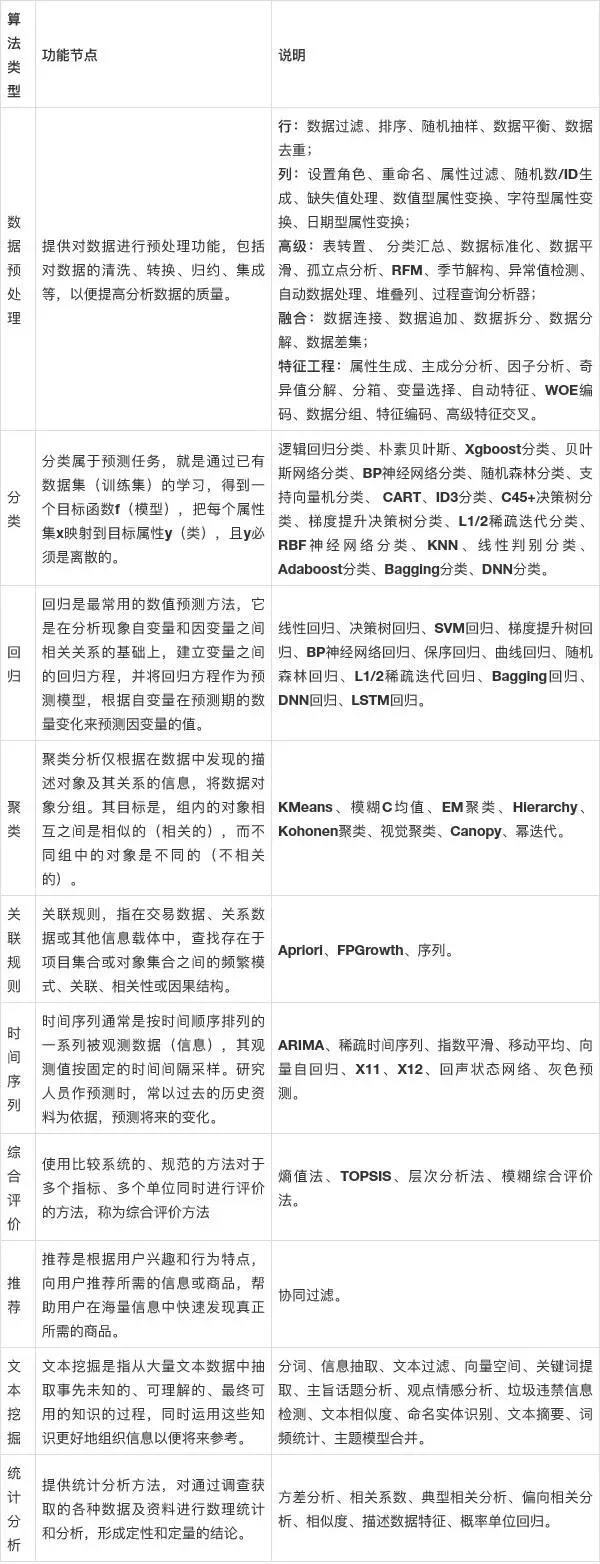

机器学习平台的核心算法体系,平台内嵌130余种数据分析方法,涉及数据预处理、回归、分类、聚类、关联、时间序列、综合评价、文本分析、推荐、统计图表十大类别。

智能化的自学习算法,平台内置自动择参、自动分类、自动回归、自动聚类、自动时间序列等多种自学习功能,帮助用户自动选择最优算法和参数,一方面降低了用户对算法和参数选择的经验成本,另一方面极大的节省用户的建模时间成本。

文章出处登录后可见!