文章目录

- 📚描述

- 📚数据

- 📚监督学习问题

- 📚二维线性回归

- 📚理解J(θ)

⭐️对应笔记

- 单变量线性回归

- 多变量线性回归

📚描述

第一个练习将提供线性回归练习。这些练习已经在Matlab上进行了广泛的测试。但它们也应该在中工作,这被称为“Matlab的免费版本”。如果您使用的是Octave,请确保安装Image包(可在Windows中作为选项使用)安装程序,可从Octave-Forge获得Linux。

📚数据

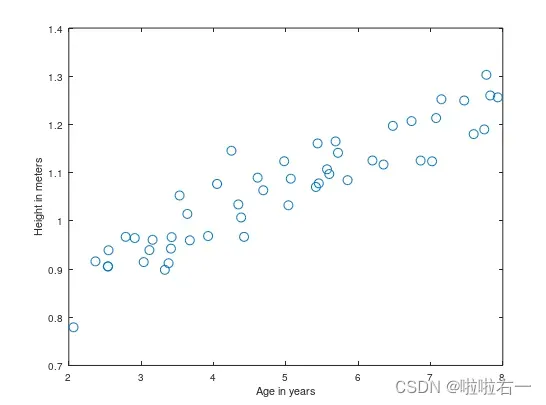

数据包里包含了一些测量2到8岁之间不同男孩身高的例子。y值是以米为单位测量的高度,x值是与身高对应的男孩的年龄。每个身高和年龄元组在我们的数据集中构成了一个训练示例。有m = 50个训练示例,我们用它们来开发一个线性回归模型。

📚监督学习问题

在这个问题中,我们使用梯度下降来实现线性回归。在Matlab/Octave中,我们可以使用这些命令加载训练集。

x=load('ex1x.dat');

y=load('ex1y.dat');

这将是我们针对具有n=1特征的监督学习问题的训练集(除了通常的,所以

)。用以下命令绘制训练集(并标记轴)

figure %open a new figure window(%是注释)

plot(x,y,'o');

ylabel('Height in meters')

xlabel('Age in years')

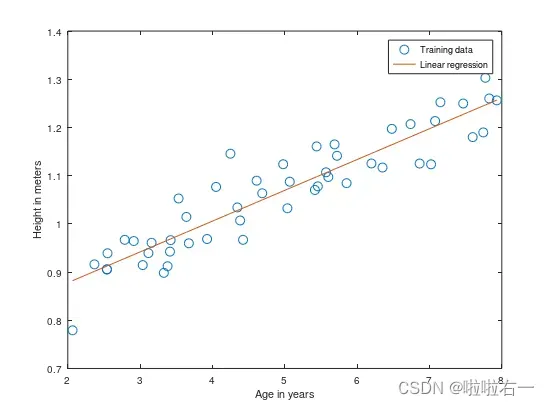

我们能看到一系列如下的数据点

m=length(y);%store the number of training examples(这里的m是约定符号)

x=[ones(m,1),x];%Add a column of ones to x

从这一点开始,我们需要记住,训练数据的年龄值实际上在x的第二列。这在以后绘制结果时很重要。

📚二维线性回归

现在,我们将对这个问题实现线性回归。回想一下,线性回归模型是,并且现在这种情况是

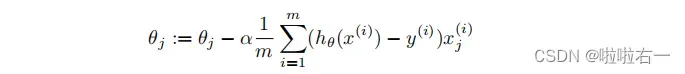

。而梯度下降更新规则为:

(1) 使用α = 0.07的学习率实现梯度下降。将参数初始化,,并从这个初始起点运行一次梯度下降的迭代。记录第一次迭代后得到的

和

的值。

alpha=0.07;%learning rate

%initial theta

theta0=0;

theta1=0;

%after one iteration

theta0=theta0-alpha*(1/m)*sum((theta0.*x(:,1)+theta1.*x(:,2)-y).*x(:,1));

theta1=theta1-alpha*(1/m)*sum((theta0.*x(:,1)+theta1.*x(:,2)-y).*x(:,2));

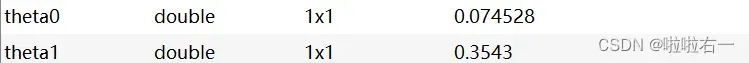

👇得到第一次迭代后

和

的值👇

(2) 继续运行梯度下降,进行更多的迭代,直到θ收敛(这总共需要大约1500次迭代)。收敛后,记录得到的和

的最终值,并根据θ在与训练数据相同的图上绘制算法的直线拟合。绘图命令将如下所示:

theta0(1,1)=0.074528;

theta1(1,1)=0.3543;

maxlter=1500;%max iteration

for i=1:maxlter-1

theta0(i+1,1)=theta0(i,1)-alpha*(1/m)*sum((theta0(i,1).*x(:,1)+theta1(i,1).*x(:,2)-y).*x(:,1));

theta1(i+1,1)=theta1(i,1)-alpha*(1/m)*sum((theta0(i,1).*x(:,1)+theta1(i,1).*x(:,2)-y).*x(:,2));

end

hold on;%plot new data without clearing old plot

plot(x(:,2),theta0(i+1,1)+x(:,2)*theta1(i+1,1),'-');

legend('Training data','Linear regression');

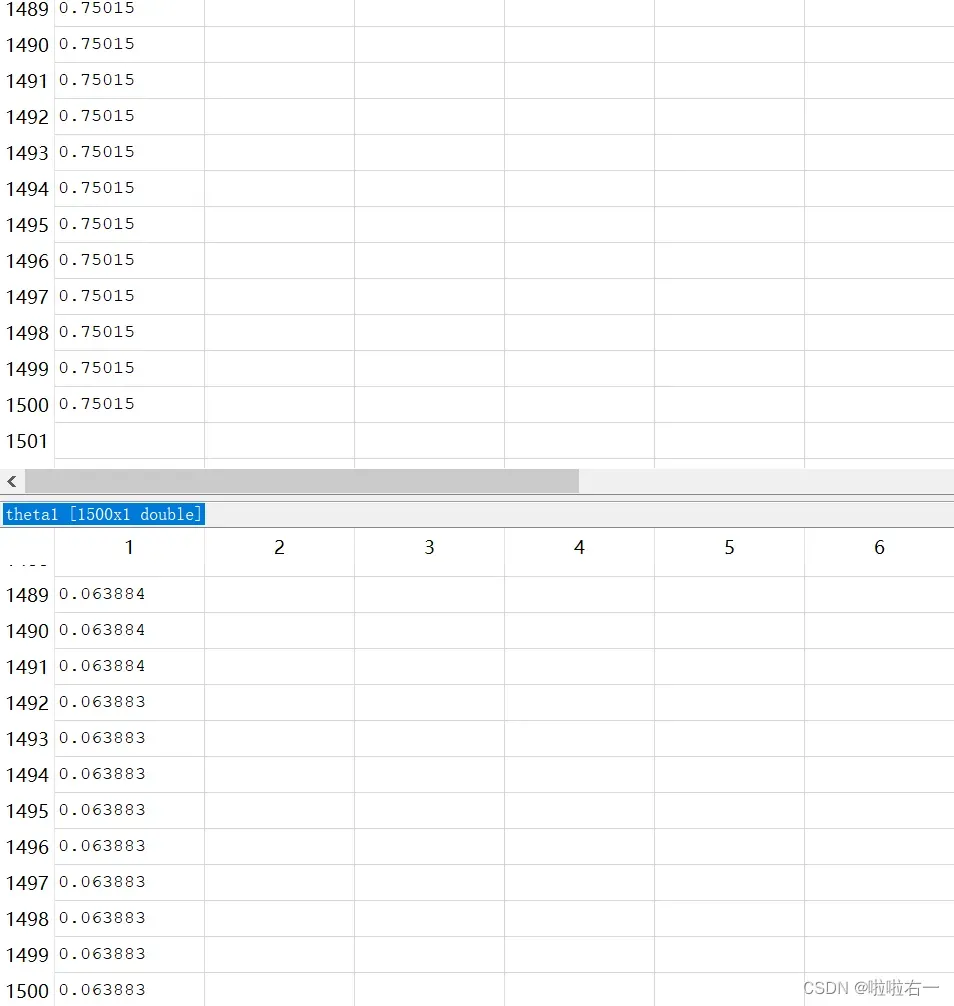

迭代1500次后,=0.75015,

=0.063883。

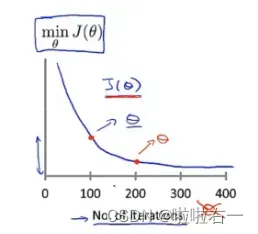

⚠️在这里我们提前预知了大致的迭代次数,当我们不能提前预知时,我们可以绘制迭代次数和代价函数的图表来观测算法在何时趋于收敛。

⚠️也有一些自动测试是否收敛的方法,例如将代价函数的变化值与某个阀值(例如 0.001)进行比较。

👀从变量编辑器中看到,趋于收敛时,迭代后值基本就不变了

注意,对于大多数机器学习问题,x是非常高维的,所以我们不能绘制。但是因为在这个例子中,我们只有一个特性,如果能够绘制出来,我们的结果就会得到一个很好的完整性检查。

(3) 最后,我们用学习到的假设来做一些预测。用所得到的模型来预测两个3.5岁和7岁的男孩的身高。

- 已知假设函数大致为:

- 3.5岁:

- 7岁:

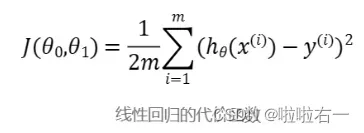

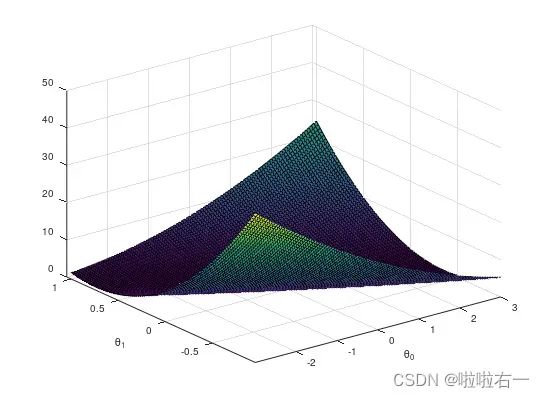

📚理解J(θ)

我们想更好地了解梯度下降所做的事情,并可视化参数和

之间的关系。在这个问题中,我们将把

绘制为一个三维曲面图。

当应用学习算法时,我们通常不会尝试绘制

,因为通常

是非常高维的,所以我们没有任何简单的方法来绘制或可视化

。但是因为这里的例子使用了一个非常低维的

,我们将绘制

来获得更多关于线性回归的直觉。

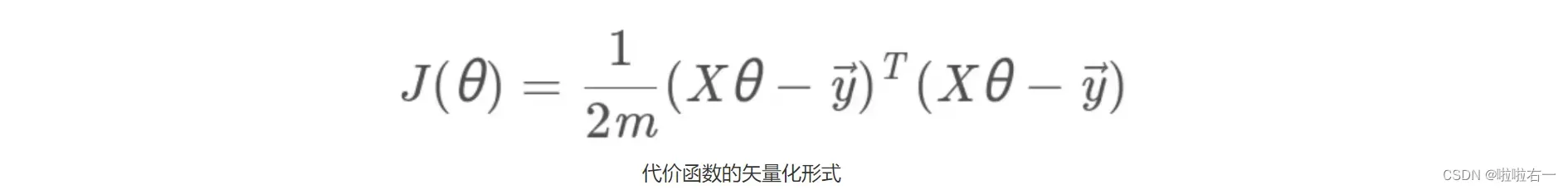

%以下代码中的参数为指导书指定

J_vals=zeros(100,100);

theta0_vals=linspace(-3,3,100);

theta1_vals=linspace(-1,1,100);

% linespace(x1,x2,N)中,x1、x2、N分别为起始值、终止值、元素个数。

for i=1:length(theta0_vals)

for j=1:length(theta1_vals)

t=[theta0_vals(i);theta1_vals(j)];

J_vals(i,j)=(0.5/m)*(x*t-y)'*(x*t-y);

end

end

J_vals = J_vals'; %转置

figure;

surf(theta0_vals,theta1_vals,J_vals);

xlabel('\theta_0');

ylabel('\theta_1');

这个3D曲面和实现梯度下降时发现的θ0和θ1值之间的关系是什么❓

这个3D曲面的最低点所对应的和

就是所求的假设函数对应的

和

。

扩展补充:surf函数

文章出处登录后可见!