class sklearn.tree.DecisionTreeClassifier(*, criterion=’gini’, splitter=’best’, max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features=None, random_state=None, max_leaf_nodes=None, min_impurity_decrease=0.0, class_weight=None, ccp_alpha=0.0)

sklearn中的DecisionTreeClassifier的参数众多, 但是重要的并不是很多, 其中比较难以搞明白的就是splitter, max_features,random_state这三个参数, 这篇文章就以一个简单的案例进行讲解.

import pandas as pd

import graphviz

from sklearn.tree import DecisionTreeClassifier,export_graphviz

df = pd.DataFrame({"房产": [1, 0, 0, 1, 1, 0, 0, 0, 0, 1], "婚姻": [1, 0, 1, 0, 2, 2, 1, 0, 1, 2],"年收入":[125, 100, 100, 110, 60, 95, 85, 75, 90, 220], "lable":[1, 1, 1, 1, 1, 0, 0, 1, 0, 1]})

X = df.iloc[:, :3]

y = df["lable"]

tree = DecisionTreeClassifier(splitter='random',

max_features=1,

# random_state=2

)

tree.fit(X, y)

dot_data = export_graphviz(tree, out_file=None, feature_names=X.columns, class_names=['不能', '能'], filled=True, rounded=True)

graphviz.Source(dot_data)

splitter, max_features,random_state这三个参数之间会相互影响, 刚开始并不是很容易理解, 因为sklearn中的使用和原始的算法并不是完全相同, 而且实际的算法会考虑到很多工程类的问题, 不是简单的数学算法能够顾全的.先分别说一下:

splitter: 有两个可选项, 分别是”random”, “best”, best很好理解就是每次选取该特征最合适的分裂点; random就是每次是随机选取一个分裂点, 这会和 max_features,random_state选取值有关, 下面细说.

max_features: 有很多可选项, 具体可以参考官网, 我们这里直说 int 型的参数的含义, 是每次分割的时候选取的特征数, 注意并不是创建整棵树选取的特征数;

random_state: 就是随机数的种子, 但是这个种子会决定上面两个特征的”随机”, 如果这个随机种子确定了, 那么及时上面的是splitter是random, max_features是小于全部特征数的, 那么也是确定的; 如果random_state没有指定, 也就是None, 那么有很大的随机性, 每次的模型都是不一致的;

下面使用案例进行说明:

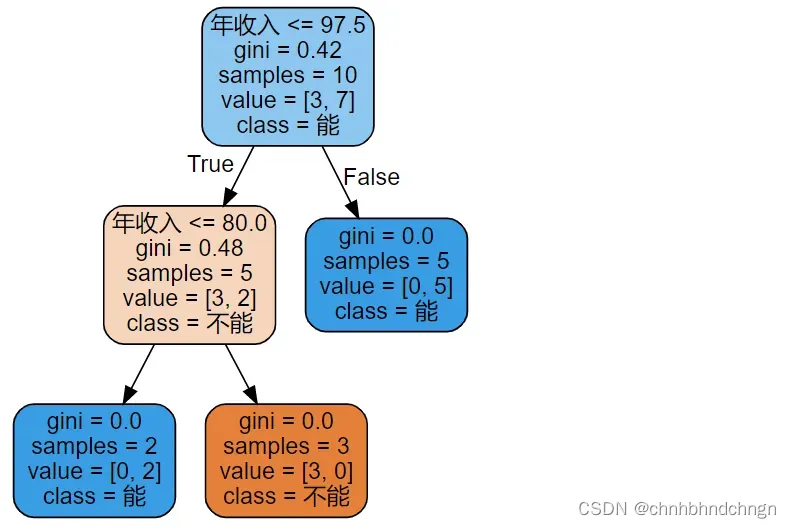

1. splitter=’best’, max_features=3 由于所有的特征是3个, 所以每次分裂需要考虑三个特征, 并且每个特征都是选取最好的分裂点, 所以每次就是(训练集)最好的情况, 没有变化, 这时random_state的值是对模型似乎没有影响的, 我们多次尝试都是下面的结果,

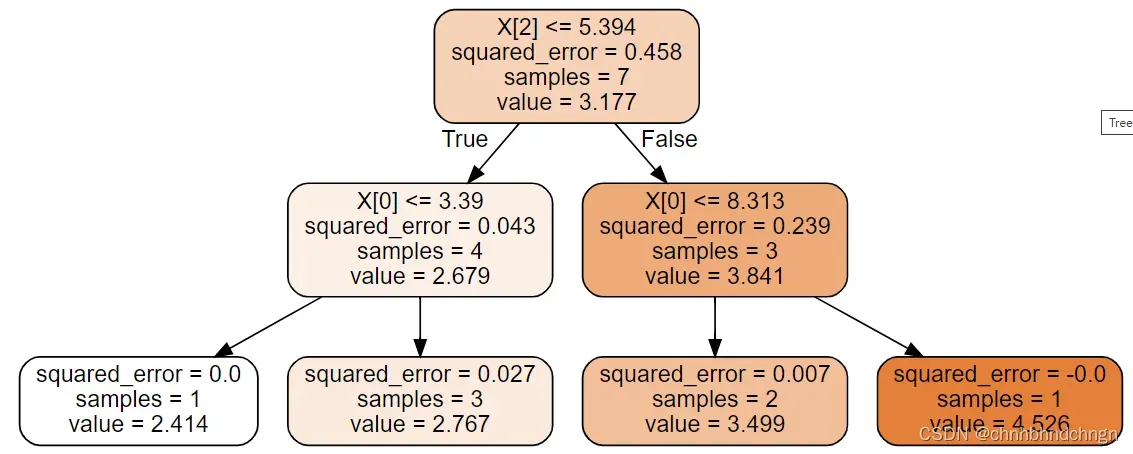

但是,有一种可能是: 训练集上的最优分裂点不是唯一的, 这时在测试集上就会有很大的差别, 下方是另外一个数据集的情况

from sklearn.tree import DecisionTreeRegressor

from sklearn.model_selection import train_test_split

import graphviz

from sklearn.tree import DecisionTreeClassifier,export_graphviz

from sklearn.datasets import fetch_california_housing

housing = fetch_california_housing()

X = housing["data"][:10, :3]

y = housing["target"][:10]

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.25, random_state=0)

tree = DecisionTreeRegressor(max_depth=2)

tree.fit(X_train, y_train)

print(tree.score(X_train, y_train))

print(tree.score(X_test, y_test))

dot_data = export_graphviz(tree, out_file=None, filled=True, rounded=True)

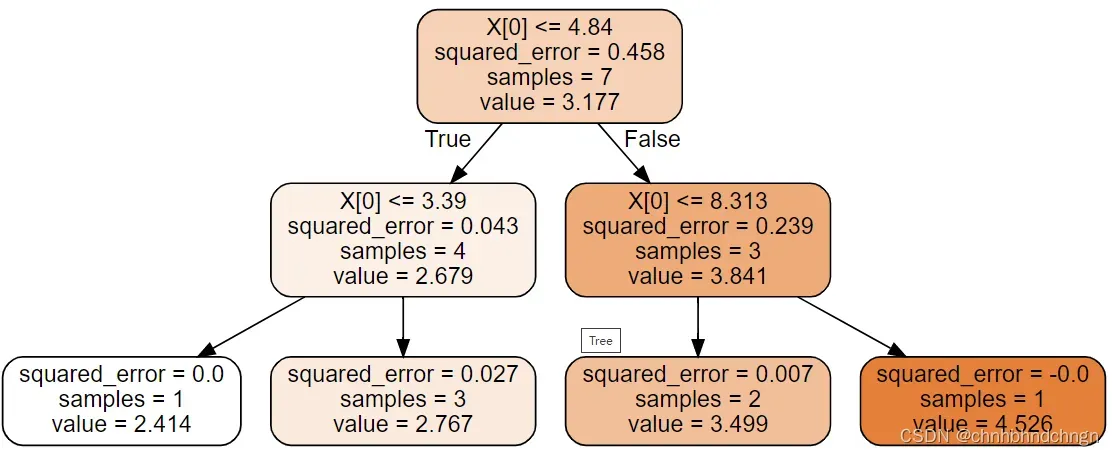

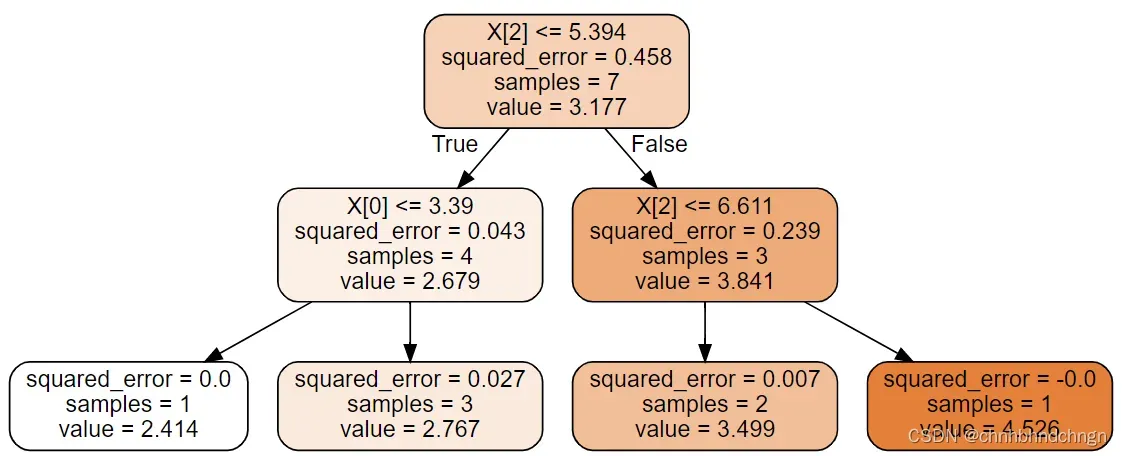

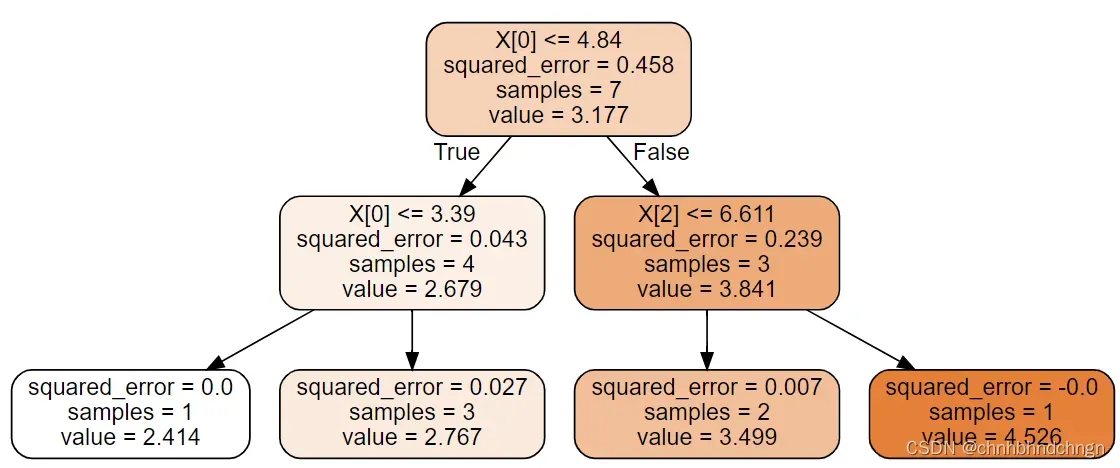

graphviz.Source(dot_data)多次运行, 会有四种不同的分裂模型, 其中的分裂特征和分裂点是不同的, 但是对于训练数据都是最好的情况, 但是对于测试集天差地别, 测试集上的得分从-0.5到0.97

综上, 决策树是很容易过拟合的

如果是全部特征和取最优分裂点仅仅想让测试结果一致, 可以加上random_state为定值

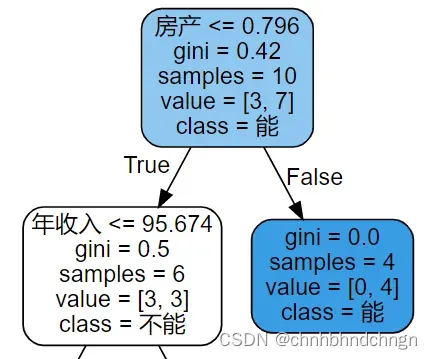

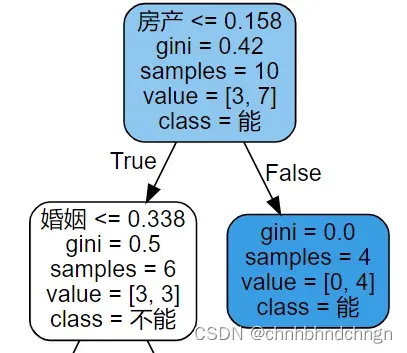

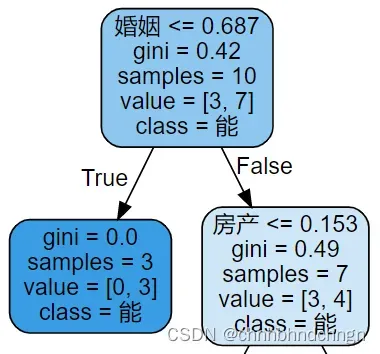

2. splitter=’random’, max_features=3, random_state=None

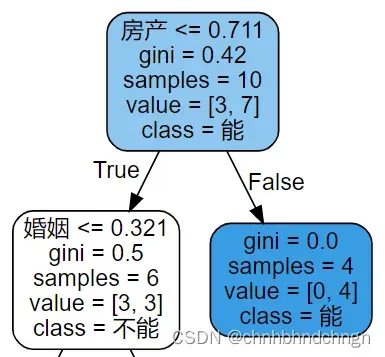

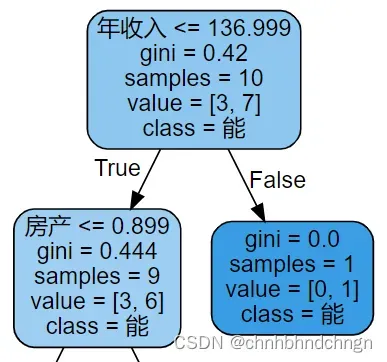

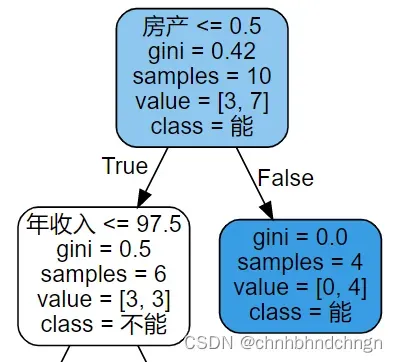

如果仔细分析原始数据就可以知道, 房产的取值是0, 1; 婚姻的取值是0, 1; 年收入的取值范围较大60-220;通过计算可知; 房产的中间值的熵无论如何是大于婚姻的中间任何值的, 年收入的取值范围较大, 取值好的时候是会好于房产的, 取值不好的时候可能比婚姻的结果还差, 如果考虑到概率, 年收入的情况并不会很好, 结果也是如此, 多次运行的结果如下(我们只查看第一个分裂点即可)

大部分都是前两种情况, 第三张图是运行几十次才有一次这种结果, 从中也可以看到分裂点都是随机选取的, 并不是两点的中间位置

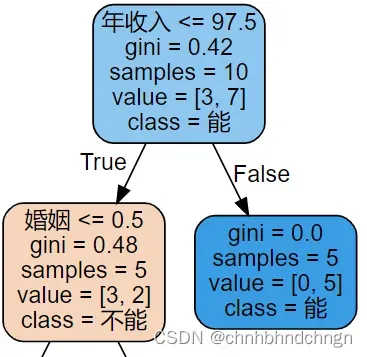

3. splitter=’random’, max_features=1, random_state=None

此时特征和特征的分裂点都是随机的, 所以随机性比较大, 会出现各种情况

4 splitter=’random’, max_features=1, random_state=定值

此时就没有任何随机性了, 多次运行都是相同的结果

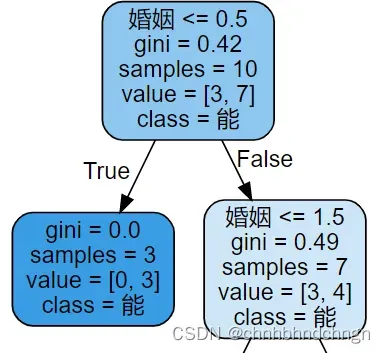

5. splitter=’best’, max_features=1, random_state=None

此时的分裂点都是每个特征最好的分裂点, 就看随机选取的是哪个特征了, 多次运行结果如下图

其他情况依次类推

就分析到这里, 有什么问题可以相互探讨

文章出处登录后可见!