接下来将详细介绍VoxelNet三维点云目标检测模型,将参考Github上的源码进行介绍,Github地址为https://github.com/skyhehe123/VoxelNet-pytorch。

本节将重点介绍数据处理中的crop.py的裁剪功能。

1 代码环境部署

conda create -n torch04 python=3.6

conda activate torch04

pip install torch==0.4.1

pip install torchvision==0.2.2

pip install cython opencv-python shapely cffi scipy mayavi

python setup.py build_ext --inplace

python nms/build.py2 数据介绍

代码中的数据集采用的是KITTI数据集。为了快速进行算法调试和验证,我制作了一份Mini KITTI数据集,目录结构与KITTI完全一致,含20个训练样本和5个测试样本。下载地址为:minikitti数据集-深度学习文档类资源-CSDN下载。KITTI数据集的介绍请参考KITTI数据集简介 — Mini KITTI_Coding的叶子的博客-CSDN博客。

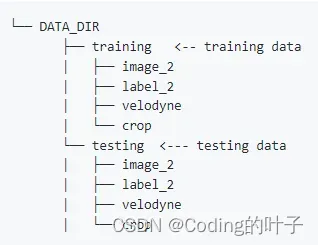

MINI KITTI数据集解压后按照下面目录保存。

除此之外还需要,在training文件夹下新建train.txt、val.txt、test.txt文件,指定各个任务对应的文件名称。样例请参考:train_val_testforminikitti-深度学习文档类资源-CSDN下载。

3 crop.py

crop程序的作用是把在图像坐标之外的点云进行裁剪删除,便于后期可视化验证。主要流程如下:

(1)读取图像数据(375x1242x3)和激光雷达数据(4xK),K表示激光雷达点云中点的数量,4分别表示x、y、z、反射强度。

(2)读取标定校准参数,各个参数的相关介绍参考。外参矩阵Tr_velo_to_cam(3×4)需要增加一行[0, 0, 0, 1]变成4×4的矩阵,这样可以同时对反射强度进行保存。同样地,R0_rect也增加一行[0, 0, 0, 1]变成4×4的矩阵。内参矩阵P的维度为3×4。相应的函数段为:

def load_calib(calib_dir):

# P2 * R0_rect * Tr_velo_to_cam * y

lines = open(calib_dir).readlines()

lines = [ line.split()[1:] for line in lines ][:-1]

#

P = np.array(lines[CAM]).reshape(3,4)

#

Tr_velo_to_cam = np.array(lines[5]).reshape(3,4)

Tr_velo_to_cam = np.concatenate( [ Tr_velo_to_cam, np.array([0,0,0,1]).reshape(1,4) ] , 0 )

#

R_cam_to_rect = np.eye(4)

R_cam_to_rect[:3,:3] = np.array(lines[4][:9]).reshape(3,3)

#

P = P.astype('float32')

Tr_velo_to_cam = Tr_velo_to_cam.astype('float32')

R_cam_to_rect = R_cam_to_rect.astype('float32')

return P, Tr_velo_to_cam, R_cam_to_rect(3)从原始点云中选出强度大于0的点,点云维度降为(4xL)。

(4)将点云第4个维度反射强度暂时设置为1,以便与外参矩阵和R0矩阵相乘时进行平移操作。内参矩阵左乘R0矩阵左乘外参矩阵左乘点云坐标后得到点云在相机坐标系中的坐标,参考:KITTI数据集简介(四) — 标定校准数据calib_Coding的叶子的博客-CSDN博客。筛选出z大于0的点,即在相机前方的点,这样点云维度进一步下降至4xL。将得到的点云坐标除以z方向上坐标后,可得到点云在像平面上的ix、iy坐标。相应的函数段为:

def project_velo_points_in_img(pts3d, T_cam_velo, Rrect, Prect):

'''Project 3D points into 2D image. Expects pts3d as a 4xN

numpy array. Returns the 2D projection of the points that

are in front of the camera only an the corresponding 3D points.'''

# 3D points in camera reference frame.

pts3d_cam = Rrect.dot(T_cam_velo.dot(pts3d))

# Before projecting, keep only points with z>0

# (points that are in fronto of the camera).

idx = (pts3d_cam[2,:]>=0)

pts2d_cam = Prect.dot(pts3d_cam[:,idx])

return pts3d[:, idx], pts2d_cam/pts2d_cam[2,:], idx(5)筛选出ix、iy坐标在图像宽高(242、375)范围内的点云,并将点云的颜色复制为图像中对应像素的颜色。最终点云的维度为Nx9,每个点有9个维度,即x、y、z、reflectance、R、G、B、ix、iy。最后将点云以bin格式保存到crop文件夹下。

4 运行crop程序

在运行crop.py之前,需要先在training和testing文件夹下新建crop文件夹,否则运行程序时会提示找不到相应文件。默认处理的文件夹为testing,循环次数需要由7518改为5,这是因为MINI KITTI中的测试样本数量为5。然后在程序中将处理的改文件夹为training,循环次数需要由5改为20,这是因为MINI KITTI中的训练样本数量为20。

更多三维、二维感知算法和金融量化分析算法请关注“乐乐感知学堂”微信公众号,并将持续进行更新。

文章出处登录后可见!