AI-理论-吃瓜教程-神经网络-task4

(Datawhale37期组队学习)

1知识点

- 神经元模型

- 感知机

- 多层网络

- 误差逆传播

- 全局最小与局部极小

- 常见NN

- DL

2具体内容

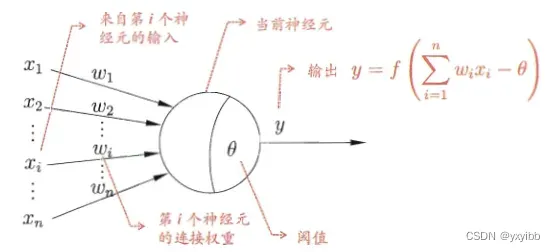

2.1神经元模型

-

神经元:简单单元

-

M-P神经元模型

-

多个输入+带权重连接+与阈值比较+激活函数

-

激活:sigmoid

-

多个神经元按一定层次结构连接形成神经网络

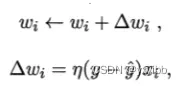

2.2感知机

- perceptron:两层神经元

- 阈值逻辑单元 threshold logic unit

- 阈值

:固定输入为-1.0的哑结点对应的连接权重

- 学习率

- 只有输出层神经元有激活函数处理,只有一层功能神经元

- 线性可分的学习

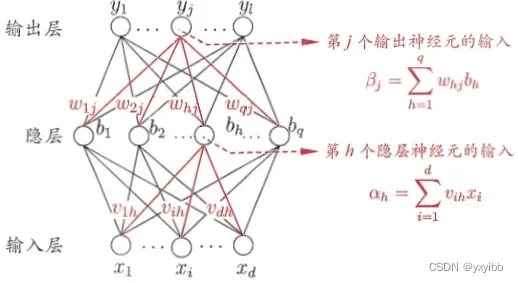

2.3多层网络

- 线性不可分的学习

- 输入层与输出层之间加入隐含层

- 每层神经元与下一层神经元全互连,神经元同层不互连,不跨层连接

- 多层前馈神经网络

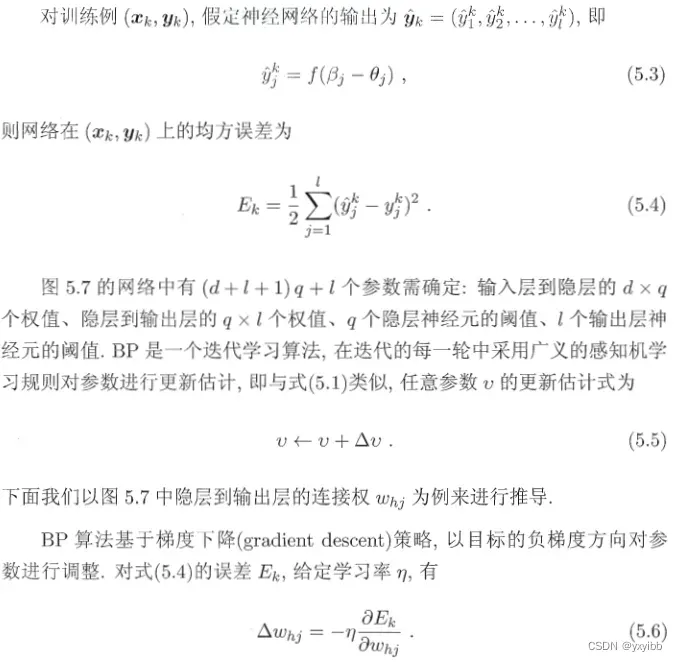

2.4误差逆传播

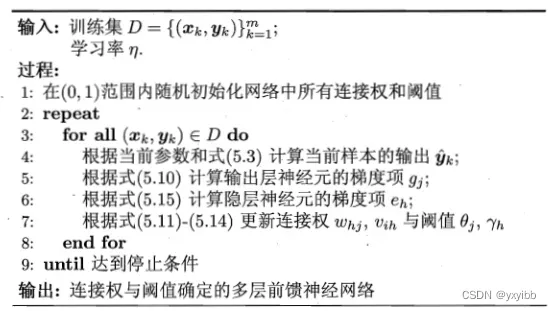

- 反向传播算法(BP)

- 推导过程:

- 学习率控制这算法每一轮迭代的更新步长,太大容易振荡,太小收敛过慢

- 流程:输入逐层传递信号产生输出,计算输出层误差,逆向传播至隐层神经元,根据隐层神经元误差对连接权与阈值调整,迭代至停止条件(误差达到理想值)

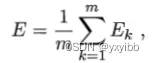

- BP目标:最小化训练集D的累积误差

- 基于累积误差最小化的更新规则得到了累积误差逆传播算法

- 标准BP每次更新针对单个样例,参数更新频繁,不同样例更新可能“抵消”,进行多次迭代

- 累积BP直接针对累积误差最小化,读取整个训练集D一遍后对参数更新,更新频率低

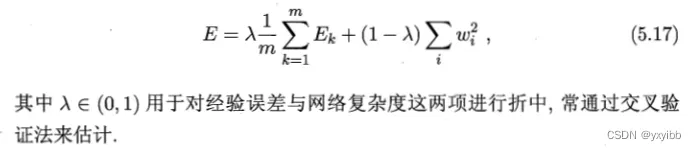

- 过拟合

- 早停:训练集误差降低但验证集误差升高,早停,返回具有最小验证集误差的连接权和阈值

- 正则化:误差目标函数增加描述网络复杂度的项

2.5全局最小与局部极小

- 参数空间内梯度为0的点:多个局部极小,一个全局最小

- 基于梯度搜索:计算误差函数在当前梯度,根据梯度确定搜索方向(负梯度方向)

- 跳出局部极小:(也可能跳出全局最小)

- 以多组不同参数值初始化多个NN,标准训练后取误差最小的解(从不同初始点开始)

- 模拟退火:以一定概率接受比当前解更差的结果,“跳出”局部极小,迭代接受“次优解”的概率随时间降低来保证算法稳定

- 随机梯度下降:计算梯度时加入随机因素,即便陷入局部极小但算出的梯度不为0

- 遗传算法

2.6常见NN

- RBF径向基网络

- 确定神经元中心(随机采样、聚类)

- BP算法确定参数

- ART自适应谐振理论网络(竞争型学习)

- 比较层、识别层(模式类、神经元数动态变)、识别阈值和重置模块

- SOM自组织映射网络(竞争型无监督)

- 级联相关网络(假定网络事先固定)

- 建立层级连接的层次结构

- 相关通过最大化新神经元的输出与网络误差之间的相关性来训练相关的参数

- Elman网络:递归神经网络(环形结构)

- t时刻输出状态不仅与t时刻输入有关,还与t-1时刻的网络状态有关,从而能处理与时间有关的动态变化

- sigmoid激活函数,推广的BP算法

- Boltzmann(基于能量的模型)

- 显层与隐层

- 神经元是布尔型的(1激活,0抑制)

2.7DL

- 增加隐层

- 预训练

- 微调

- 权共享

- 特征学习

3待补充

无

4Q&A

无

5code

无

6参考

- https://github.com/datawhalechina/pumpkin-book

文章出处登录后可见!

已经登录?立即刷新