前向传播是计算得分函数(权重乘以输入+偏置项)和损失函数(数据损失+正则化惩罚项)的过程

反向传播是从后向前逐层对损失函数求梯度的

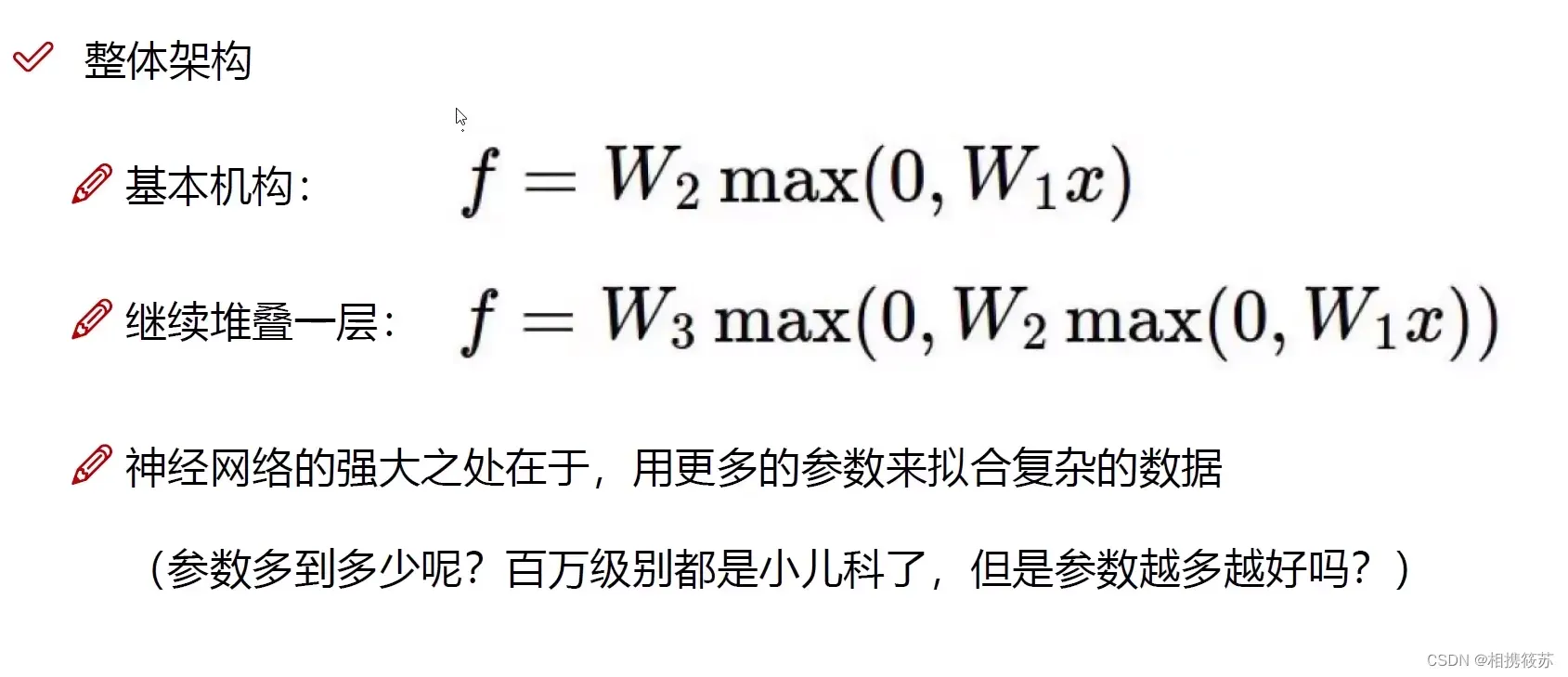

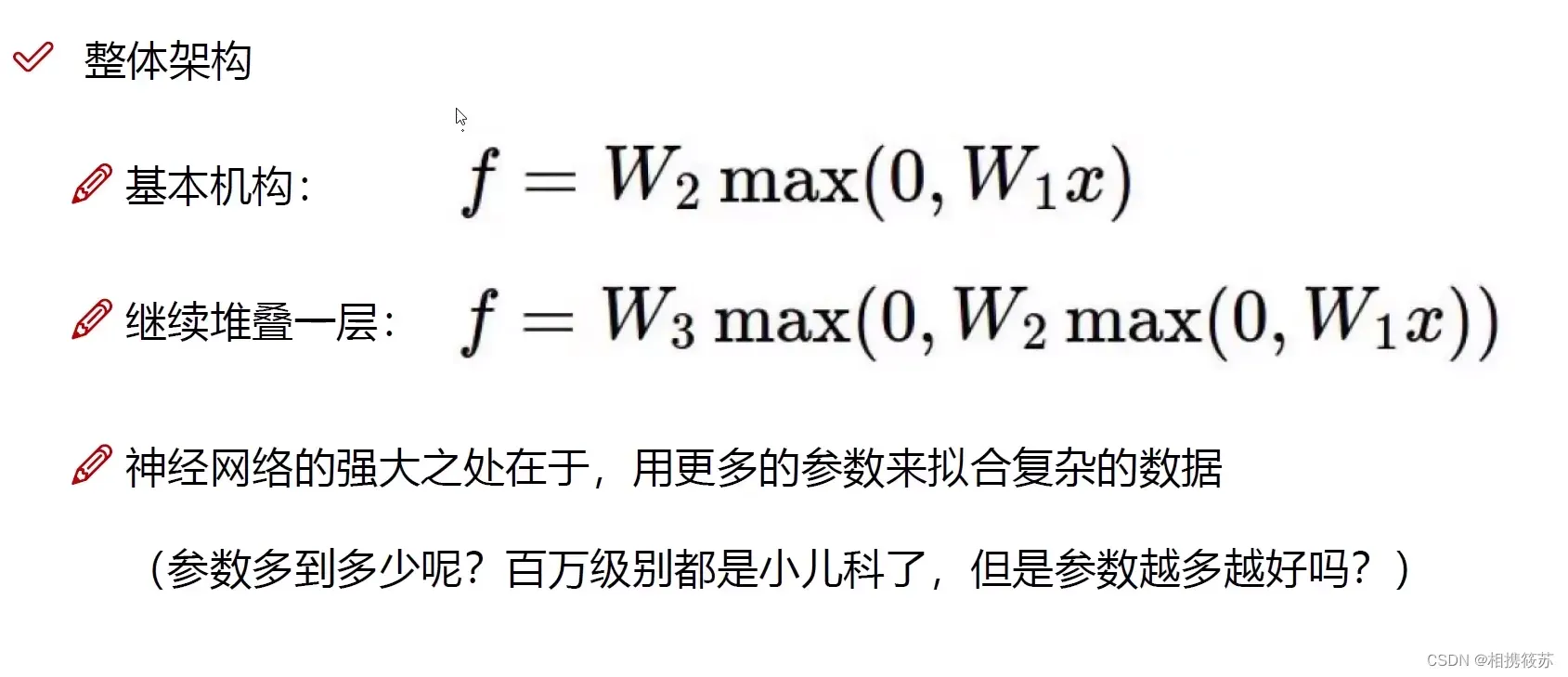

输入层和第一个隐含层运算之后做非线性变换(映射)再进入第二个隐含层

第一个问题:为何正则化惩罚项的系数越大,模型泛化性越好?

当考虑所有输入数据而其中某些少数特殊点使得一些权重较大,而这样会使模型泛化性较差,当增大正则化惩罚项的系数会倒逼权重减小,从而弱化特殊点对应权重带来的影响,所以使模型泛化性变好

文章出处登录后可见!

已经登录?立即刷新

前向传播是计算得分函数(权重乘以输入+偏置项)和损失函数(数据损失+正则化惩罚项)的过程

反向传播是从后向前逐层对损失函数求梯度的

输入层和第一个隐含层运算之后做非线性变换(映射)再进入第二个隐含层

第一个问题:为何正则化惩罚项的系数越大,模型泛化性越好?

当考虑所有输入数据而其中某些少数特殊点使得一些权重较大,而这样会使模型泛化性较差,当增大正则化惩罚项的系数会倒逼权重减小,从而弱化特殊点对应权重带来的影响,所以使模型泛化性变好

文章出处登录后可见!