1. 卷积神经网络的发展历程

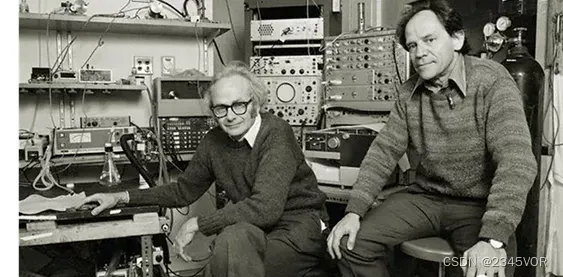

1962年,Hubel和Wiesel对猫大脑中的视觉系统的研究,Hubel和Wiesel记录了猫脑中各个神经元的电活动。他们使用幻灯机向猫展示特定的模式,并指出特定的模式刺激了大脑特定部位的活动。这种单神经元记录是当时的一项创新,由Hubel早期发明的特殊记录电极实现,他们通过这些实验系统地创建了视觉皮层的地图。

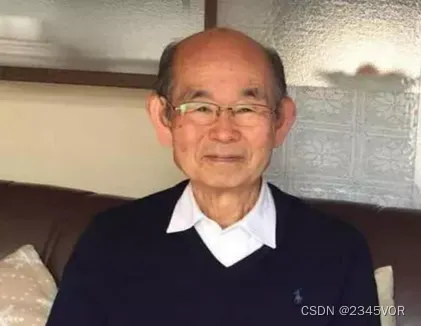

1980年,日本科学家福岛邦彦在论文《Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffectedby shift in position》提出了一个包含卷积层、池化层的神经网络结构。

1998年,在这个基础上,Yann Lecun在论文《Gradient-Based Learning Applied to Document Recognition》中提出了LeNet-5,将BP算法应用到这个神经网络结构的训练上,就形成了当代卷积神经网络的维形。Yann Lecun最早将CNN用于手写数字识别

CNN的全称是”Convolutional Neural Network”(卷积神经网络)。而神经网络是一种模仿生物神经网络(动物的中枢神经系统,特别是大脑)结构和功能的数学模型或计算模型。神经网络由大量的人工神经元组成,按不同的连接方式构建不同的网络。CNN是其中的一种,还有GAN(生成对抗网络),RNN(递归神经网络)等,神经网络能够类似人一样具有简单的决定能力和简单的判断能力,在图像和语音识别方面能够给出更好的结果。

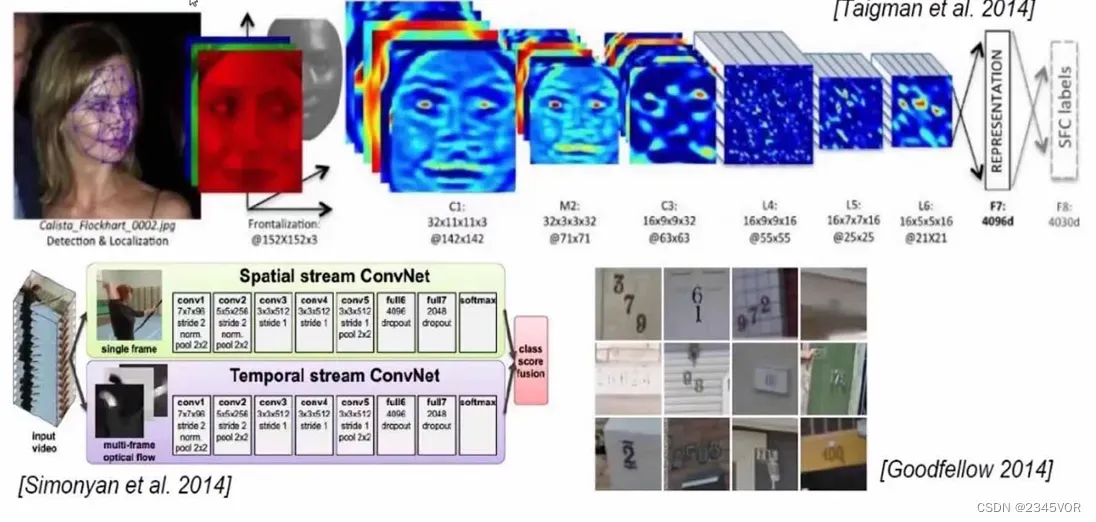

2. 卷积神经网络的应用领域

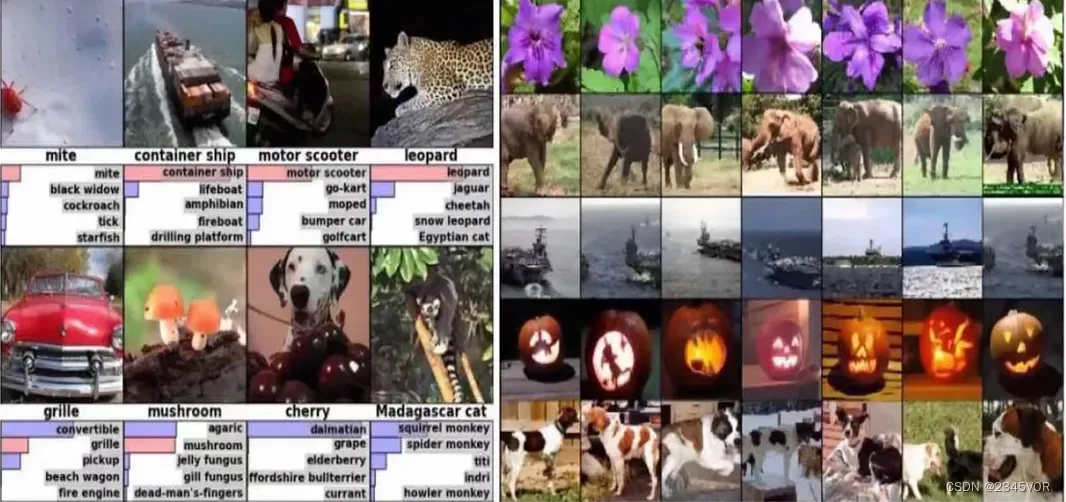

2.1 分类检系

2.2 目标检测

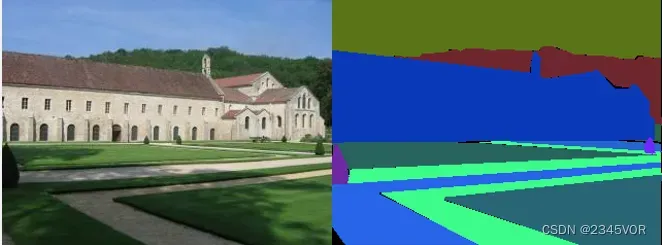

2.3 图像分割

2.4 无人驾驶

2.5 人脸识别

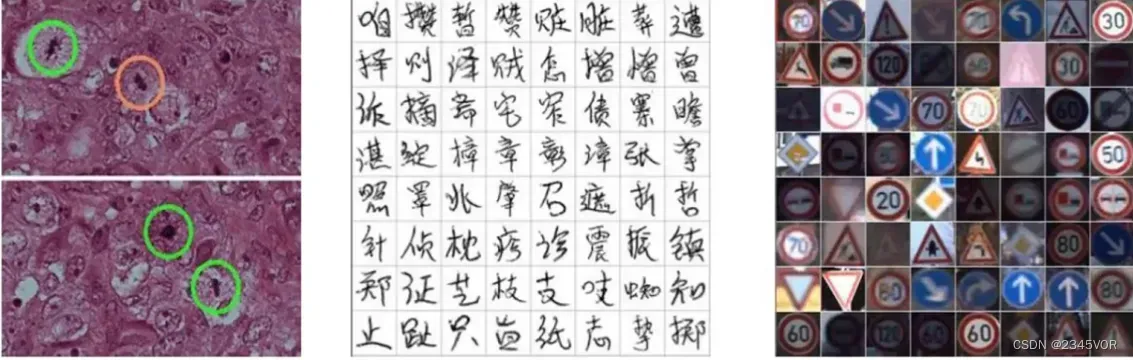

2.6 其它领域

医学任务、OCR、标识识别等:

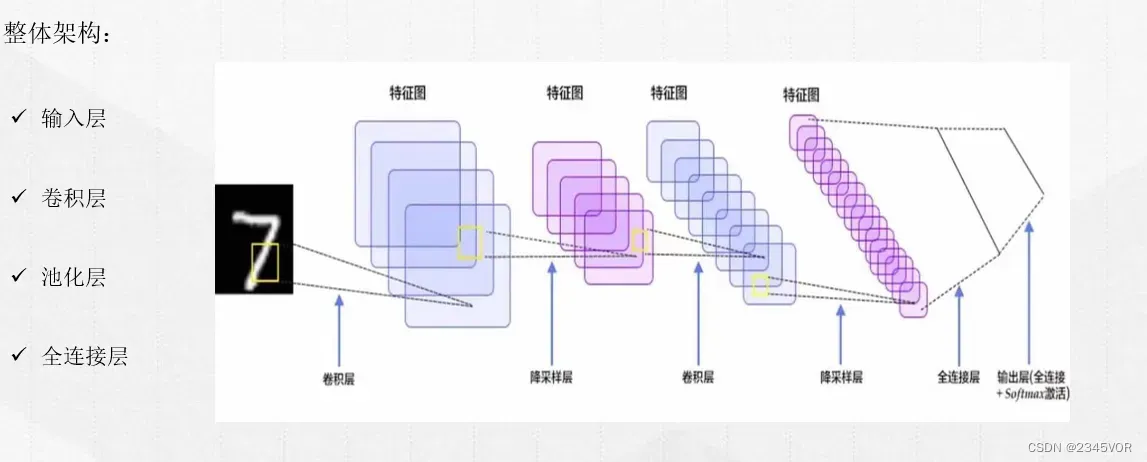

3. 卷积神经网络工作原理

基本框架

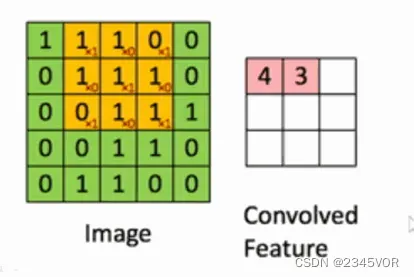

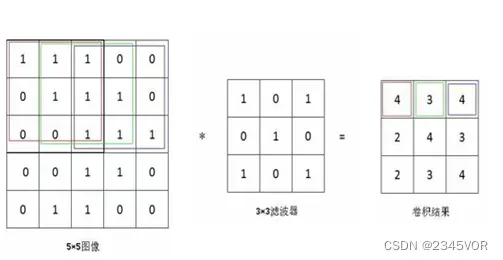

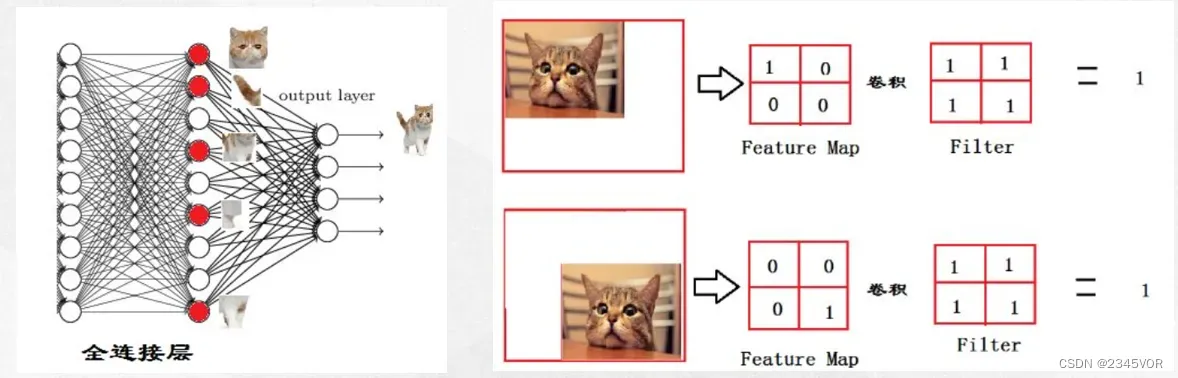

3.1 卷积层:

主要是用来提取图像数据的特征和学习图像数据的特征表示

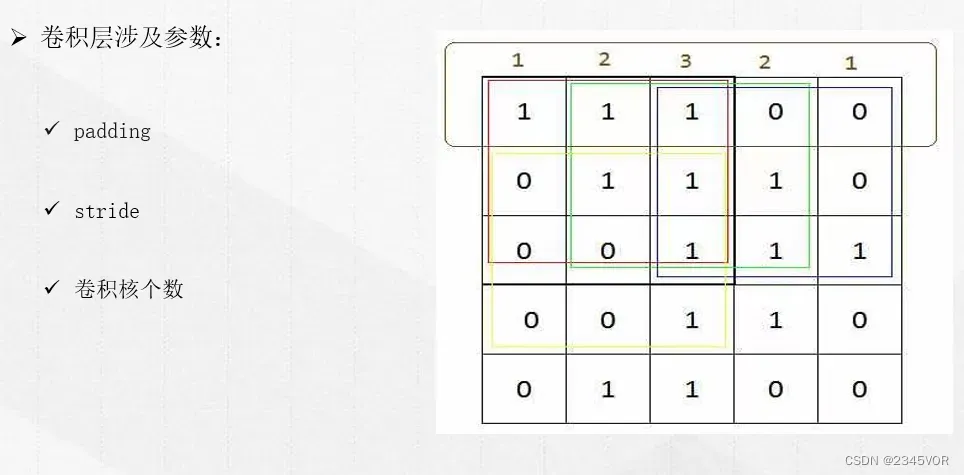

卷积层需要定义的参数

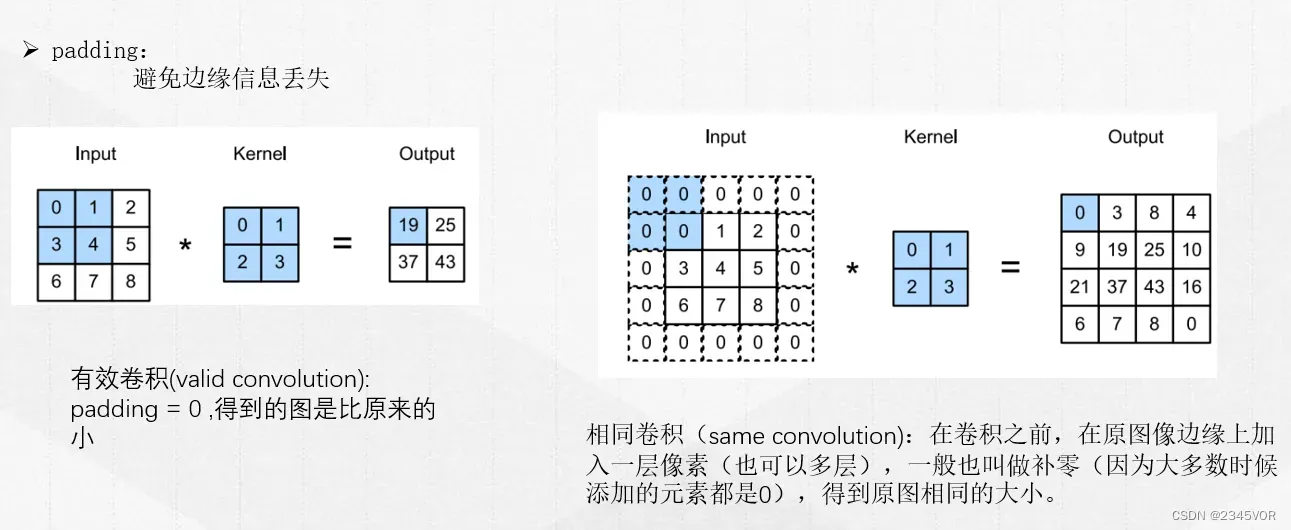

填充

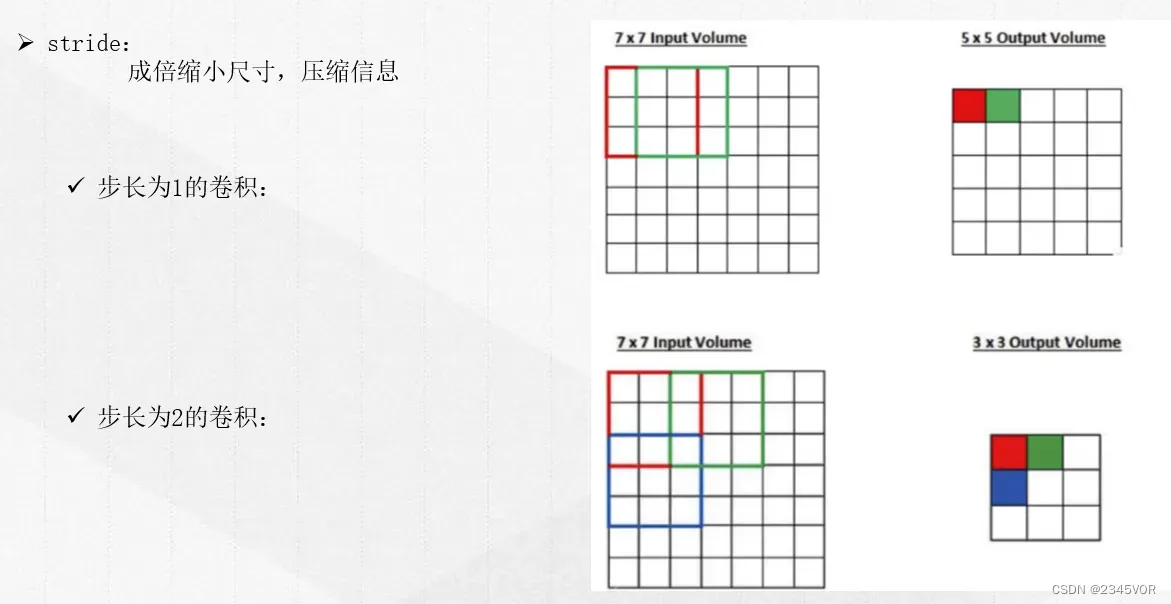

步长

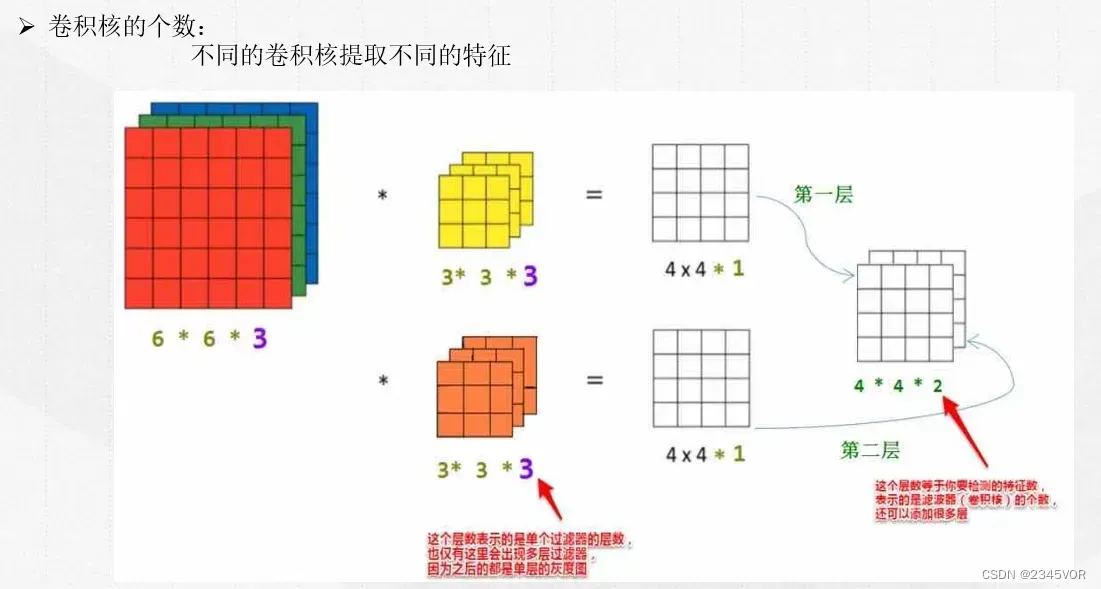

卷积核个数

3.2 池化层:

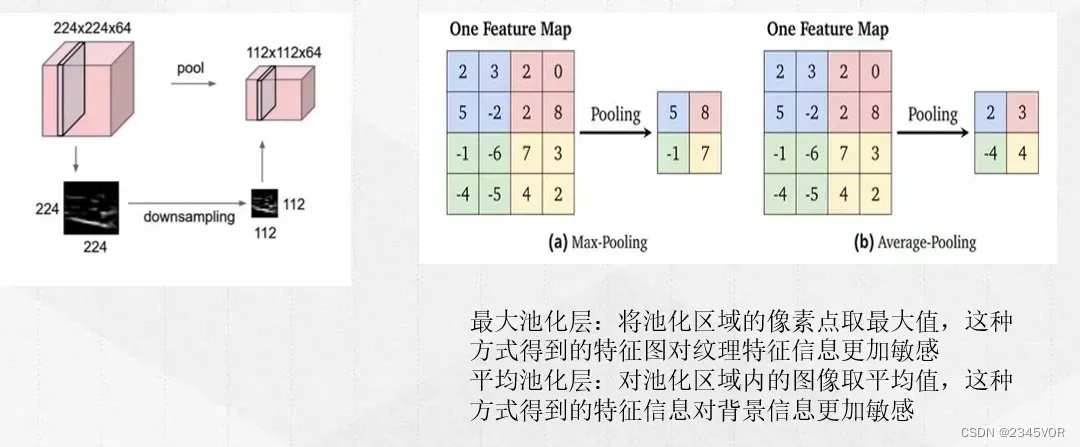

池化是一种down-sampling技术,本质是基于滑动窗口的思想,可以去除特征图中的冗余信息,对卷积层结果压缩的到重要特征,同时还可以有效的控制过拟合。池化一般通过简单的最大值、最小值或平均值操作完成。

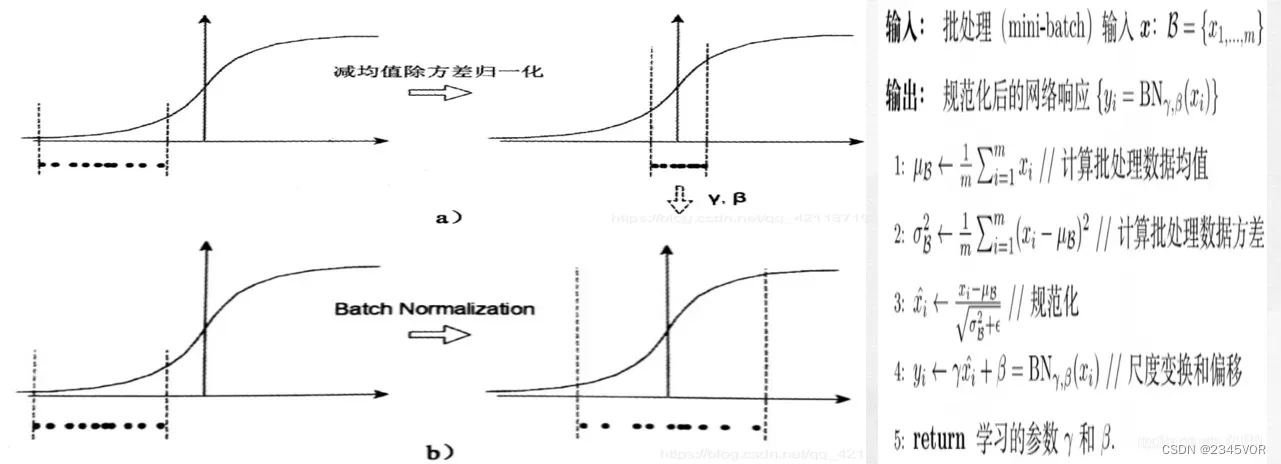

3.3 批归一化(Batch Nomarliaztion):

为了解决层与层之间传输数据,前面层的数据更新,导致后面层数据分布的变化,会产生网络收敛慢,学习速度降低问题。Batch Nomarliaztion简化了计算过程,并保留了原始数据的表达能力。

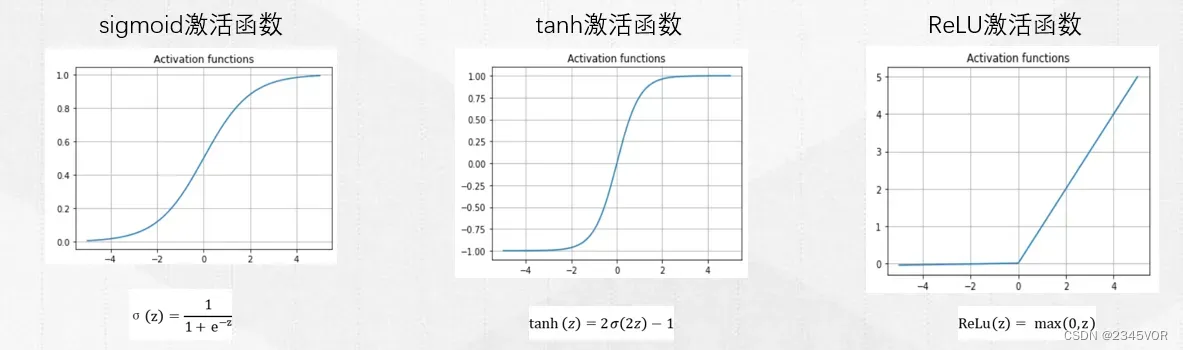

3.4 激活函数:

使得神经网络拥有能拟合所有非线性函数的本领。

- sigmoid激活函数:通常在二分类任务的输出层中使用

- tanh激活函数:通常用于分类任务的输出层和模型的隐藏层

- ReLU激活函数:常用于回归任务和卷积神经网络的隐藏层

3.5 优化器:

作用:加快学习速度。

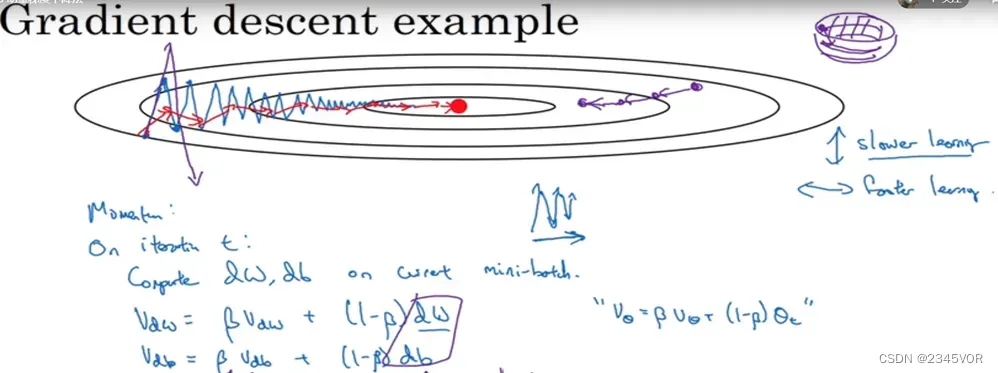

momentum动量优化:动量优化考虑更之前步骤的梯度,每一步将动量向量减去局部梯度m,并且将模型权重加上这一动量向量。换言之,梯度用于加速度,而不用于速度。

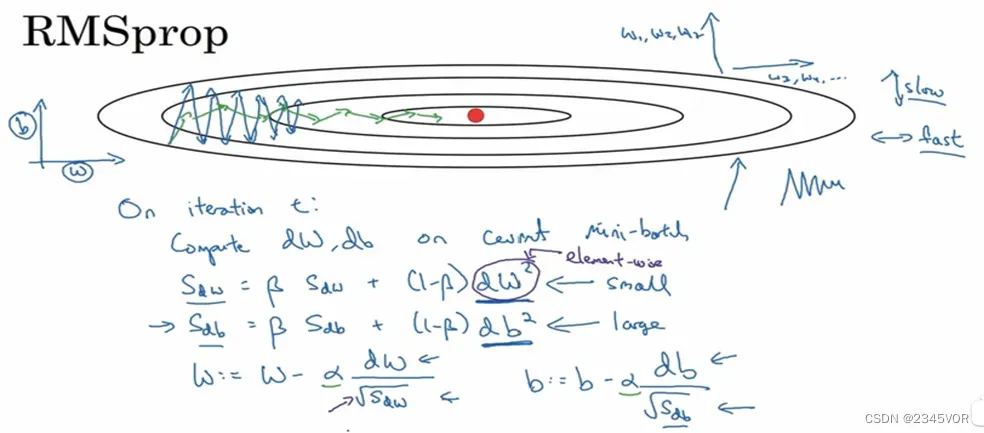

RMSProp优化器: RMSProp优化器在累计梯度时仅使用最近步骤的,而不是从训练一开始的。

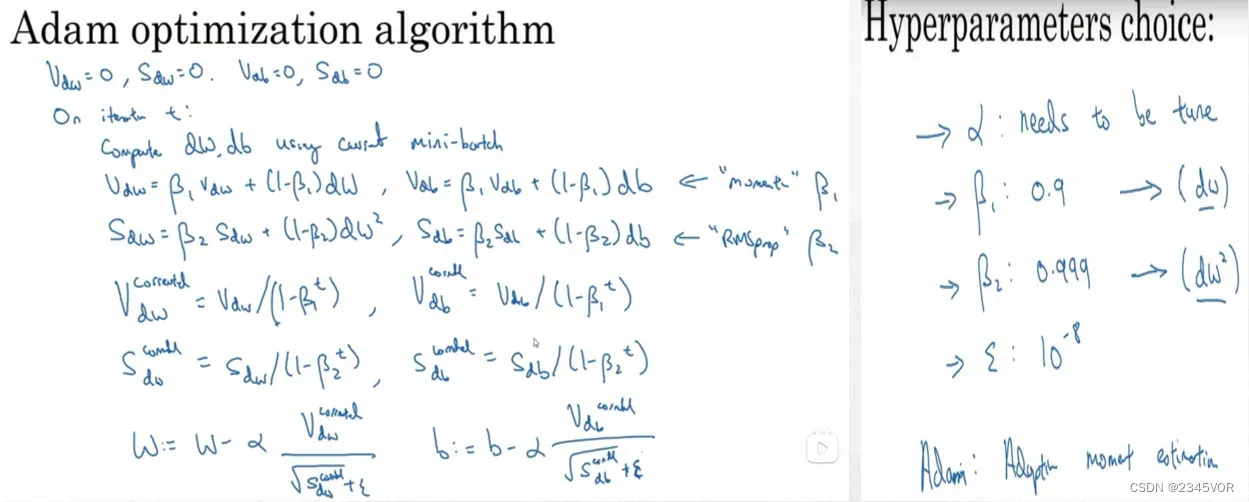

Adam优化器:结合了动量优化和RMSProp的思想。如同动量优化,该算法记录了过往梯度的指数衰减加权平均。如同RMSProp算法,该算法记录了过往梯度平方的指数衰减加权平均

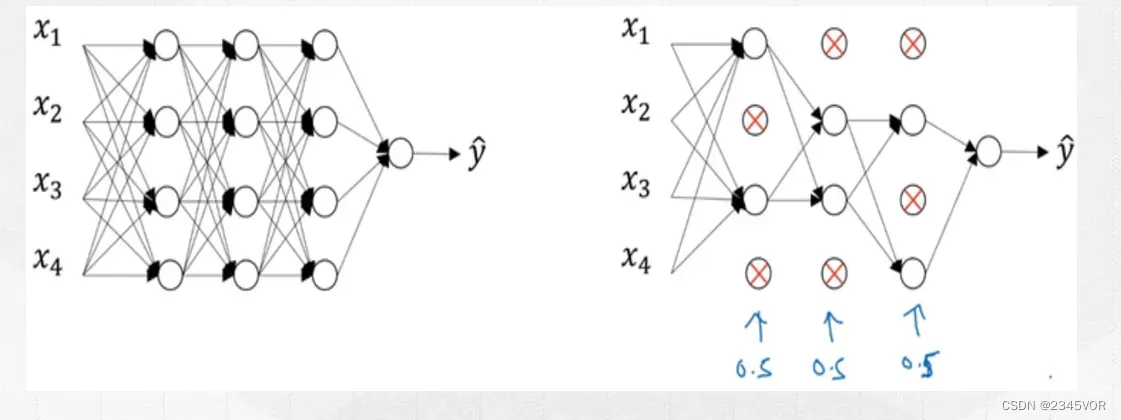

3.6 随机失活dropout方法:

在每个训练步骤中,每个神经元(包括输入神经元,但不包括输出神经元)都有p概率暂时性

被忽略,但在这一步中被忽略的神经元可能在下一步中活跃,如下图所示。超参数p称为dropout概率,通常设为10%到50%。训练结束后,神经元在预测和使用阶段不会被忽略。使用dropout后神经网络的精度能够提升1 -2%。可以防止过拟合。

3.7 全连接层

全连接层:当一层中的神经元与前一层的所有神经元都相连时,该层则称为全连接层(dense layer)。主要作用是将输入图像,在经过卷积和池化操作后提取的特征进行压缩,并且根据压缩的特征完成模型的分类功能。

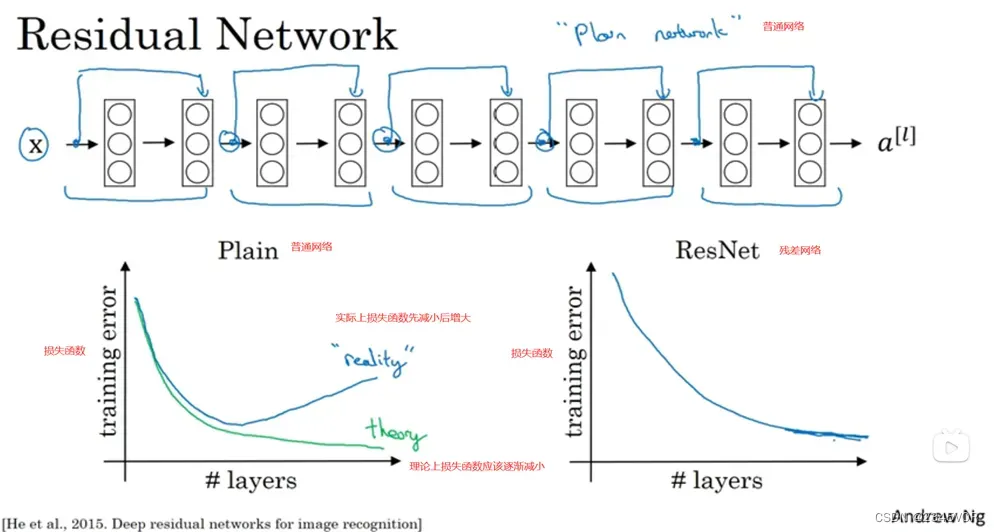

4. 残差网络

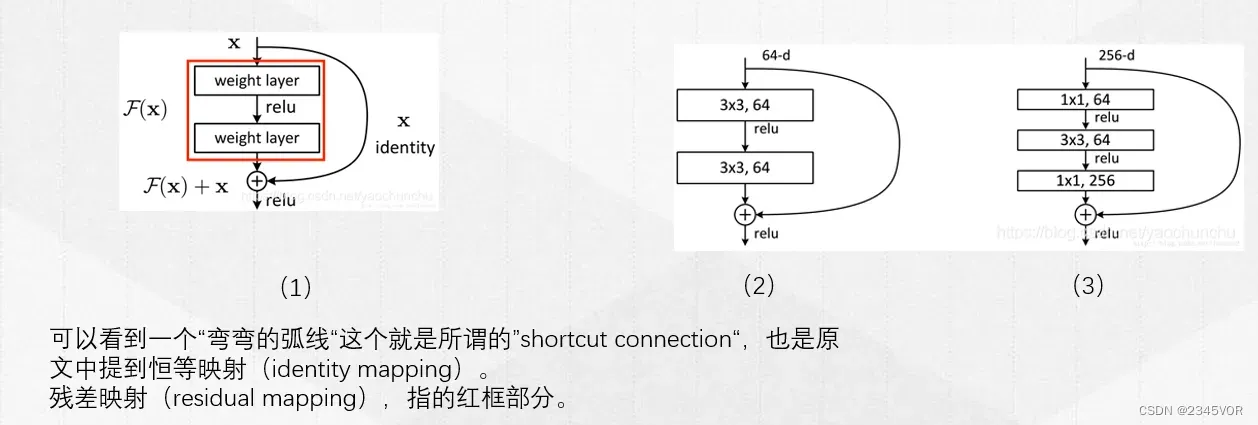

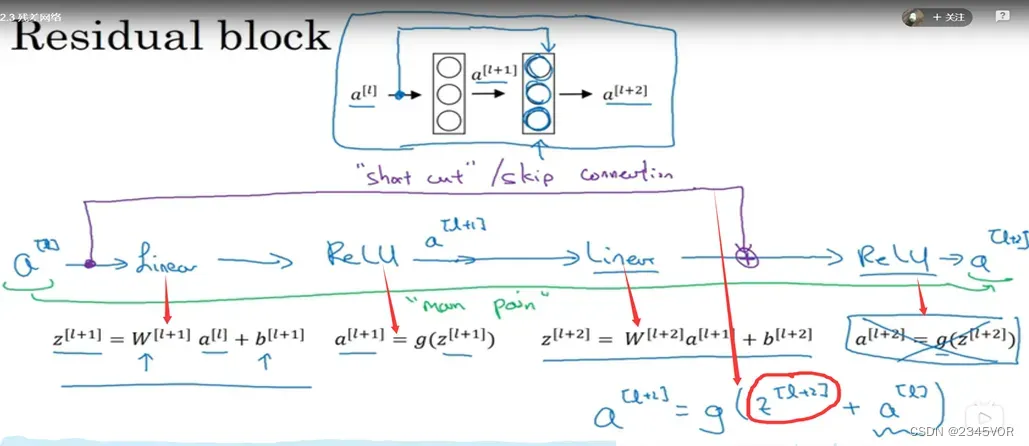

ResNet卷积神经网络结构赢得了2015年的ImageNet图像分类挑战赛,由Kaiming He等人提出,其前五预测错误率达到了3.6%。该结构包含了极其深的卷积层,达到了152层。总体趋势而言,模型变得越来越深,参数变得越来越少。而训练深度网络的关键则是使用跳跃连接(skip connection),即某一层的输入同时会加入更深层的输出。具体而言,训练神经网络的目标是构造一个目标函数h (x),当把输入x加入网络的输出时,则网络会试图构造 f(x)=h(x)-x而不是h(x),这就称为残差学习。

4.1 残差块

残差块就是有跳跃连接那—部分。

4.2 残差网络

残差网络可以解决当网络非常深时出现的梯度爆炸和梯度消失问题。

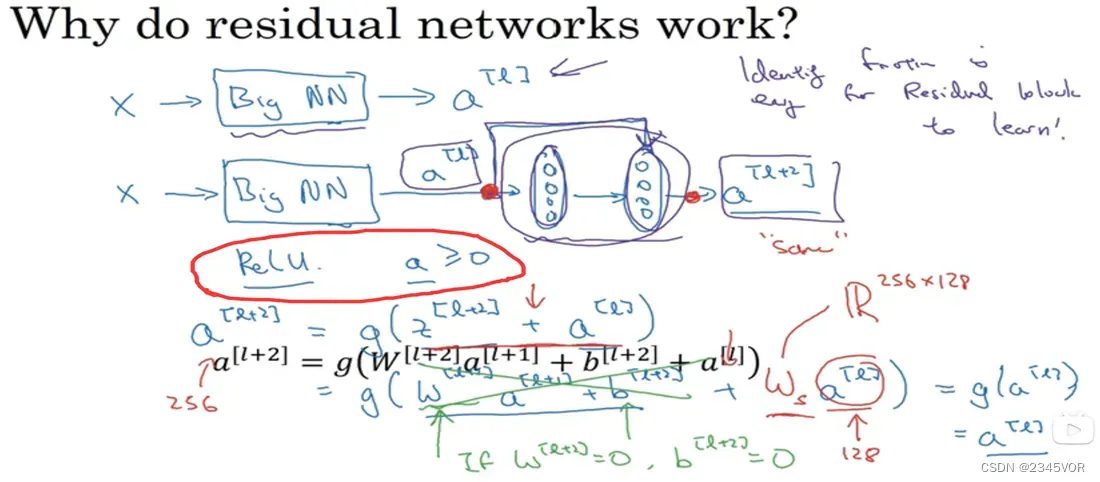

4.3残差网络的工作方式

当网络加深时,通过恒等函数可以保证网络性能不受影响,甚至可以提高效率。如果输入和输出有不同的维度,会使用一个1×1的卷积来升高或者降低输入维度

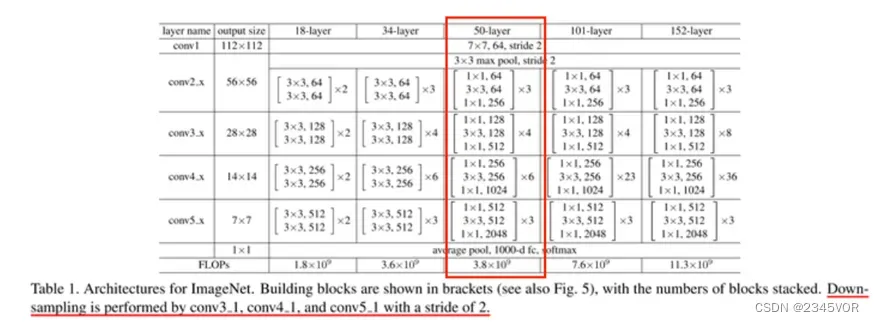

4.4 ResNet-50

残差网络网络结构

ResNet50:第5列,首先有一个7×7×64的卷积,然后经过3+4+6+3=16个残差块,每个块有3个卷积层(如图(3)),所以有16×3=48,最后有一个全连接层(fc),一共是1+48+1=50层。

参考文献:

https://www.bilibili.com/video/BV1FT4y1E74V?p=66

https://www.bilibili.com/video/BV1FT4y1E74V?p=67

https://www.bilibili.com/video/BV1FT4y1E74V?p=68

https://www.zhihu.com/question/41037974

https://blog.csdn.net/qq_42118719/article/details/113544673

本人学习模式识别课程陈莹、黎耀娟提供参考资料

特此鸣谢!!!

文章出处登录后可见!