本项目基于最新yolov5分支 v5.0(https://github.com/ultralytics/yolov5/releases/tag/v5.0)的yolov5s模型进行剪枝。

相关论文:https://arxiv.org/abs/1708.06519

在之前的博客有提到相关原理和整体的步骤:YOLOv5模型剪枝压缩_IEEE_FELLOW的博客-CSDN博客_yolov5压缩

先简单介绍一下yolov5模型,网上有很多yolov5模型的详细讲解博客,讲的都很好,但是到了v5.0分支后好像就没人更新了。

这里以yolov5s为例,m,l,x结构是一样的,只是网络宽度深度有所不同。

YOLOv5模型结构

yolov5s.yaml给出了模型的结构参数:

# parameters

nc: 80 # number of classes

depth_multiple: 0.33 # model depth multiple

width_multiple: 0.50 # layer channel multiple

# anchors

anchors:

- [10,13, 16,30, 33,23] # P3/8

- [30,61, 62,45, 59,119] # P4/16

- [116,90, 156,198, 373,326] # P5/32

# YOLOv5 backbone

backbone:

# [from, number, module, args]

[[-1, 1, Focus, [64, 3]], # 0-P1/2

[-1, 1, Conv, [128, 3, 2]], # 1-P2/4

[-1, 3, C3, [128]],

[-1, 1, Conv, [256, 3, 2]], # 3-P3/8

[-1, 9, C3, [256]],

[-1, 1, Conv, [512, 3, 2]], # 5-P4/16

[-1, 9, C3, [512]],

[-1, 1, Conv, [1024, 3, 2]], # 7-P5/32

[-1, 1, SPP, [1024, [5, 9, 13]]],

[-1, 3, C3, [1024, False]], # 9

]

# YOLOv5 head

head:

[[-1, 1, Conv, [512, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 6], 1, Concat, [1]], # cat backbone P4

[-1, 3, C3, [512, False]], # 13

[-1, 1, Conv, [256, 1, 1]],

[-1, 1, nn.Upsample, [None, 2, 'nearest']],

[[-1, 4], 1, Concat, [1]], # cat backbone P3

[-1, 3, C3, [256, False]], # 17 (P3/8-small)

[-1, 1, Conv, [256, 3, 2]],

[[-1, 14], 1, Concat, [1]], # cat head P4

[-1, 3, C3, [512, False]], # 20 (P4/16-medium)

[-1, 1, Conv, [512, 3, 2]],

[[-1, 10], 1, Concat, [1]], # cat head P5

[-1, 3, C3, [1024, False]], # 23 (P5/32-large)

[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)

]在backbone和head部分,给出每层的配置,yolov5一共有24个模块层,基本的模型有:

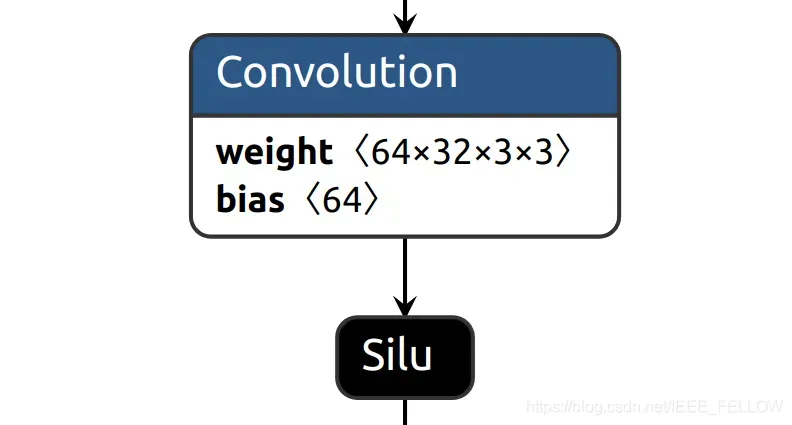

1. Conv

最基本的模块:

相关代码:

class Conv(nn.Module):

# Standard convolution

def __init__(self, c1, c2, k=1, s=1, p=None, g=1, act=True): # ch_in, ch_out, kernel, stride, padding, groups

super(Conv, self).__init__()

self.conv = nn.Conv2d(c1, c2, k, s, autopad(k, p), groups=g, bias=False)

self.bn = nn.BatchNorm2d(c2)

self.act = nn.SiLU() if act is True else (act if isinstance(act, nn.Module) else nn.Identity())

def forward(self, x):

return self.act(self.bn(self.conv(x)))

def fuseforward(self, x):

return self.act(self.conv(x))最基本的“卷积-BN-激活”模块,在yolov5里面,可以看到Focus,C3,nn.Upsample,SPP模块之间,会有3*3卷积,stride=2的Conv模块进行连接。

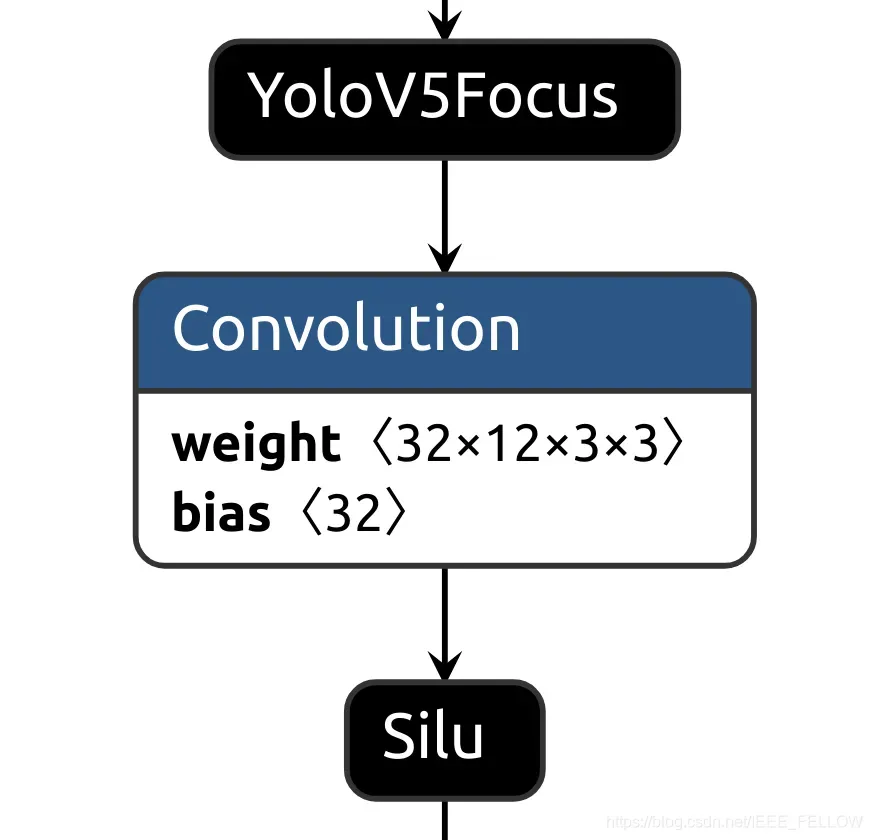

2. Focus

结构如图

这里BN层已经融合到卷积了,后面的图同理。

相关代码:

class Focus(nn.Module):

# Focus wh information into c-space

def __init__(self, c1, c2, k=1, s=1, p=None, g=1, act=True): # ch_in, ch_out, kernel, stride, padding, groups

super(Focus, self).__init__()

self.conv = Conv(c1 * 4, c2, k, s, p, g, act)

# self.contract = Contract(gain=2)

def forward(self, x): # x(b,c,w,h) -> y(b,4c,w/2,h/2)

return self.conv(torch.cat([x[..., ::2, ::2], x[..., 1::2, ::2], x[..., ::2, 1::2], x[..., 1::2, 1::2]], 1))可以看到,就是输入进行下采样,然后沿着通道方向拼接,然后经过一个Conv模块。

这里的Conv模块是可以进行剪枝的。

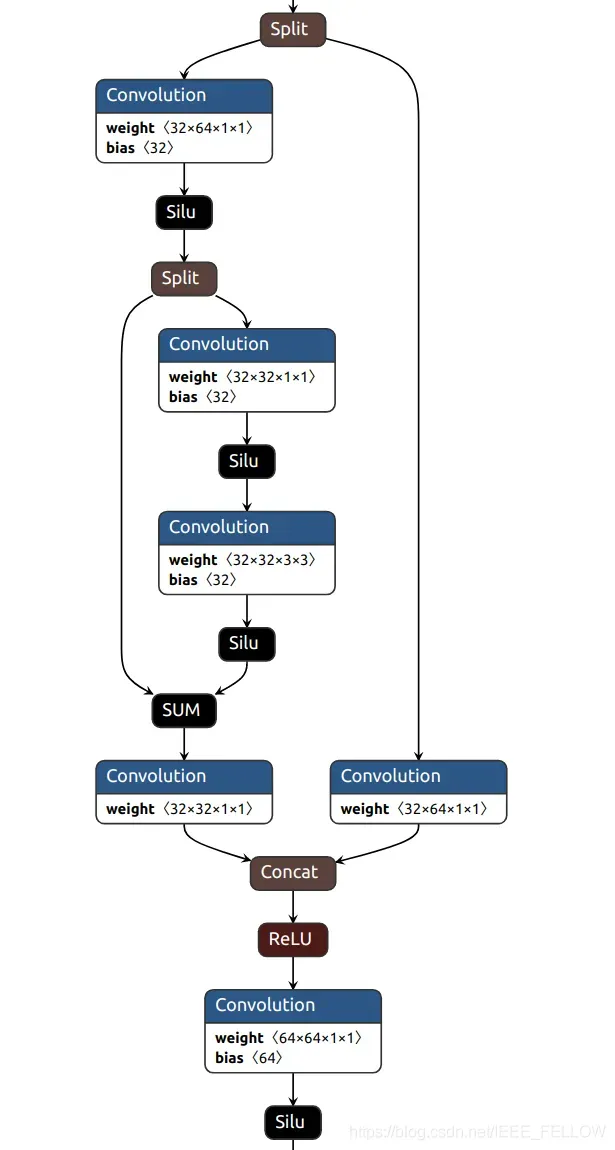

3. C3

结构如图所示:

相关代码:

class C3(nn.Module):

# CSP Bottleneck with 3 convolutions

def __init__(self, c1, c2, n=1, shortcut=True, g=1, e=0.5): # ch_in, ch_out, number, shortcut, groups, expansion

super(C3, self).__init__()

c_ = int(c2 * e) # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c1, c_, 1, 1)

self.cv3 = Conv(2 * c_, c2, 1) # act=FReLU(c2)

self.m = nn.Sequential(*[Bottleneck(c_, c_, shortcut, g, e=1.0) for _ in range(n)])

# self.m = nn.Sequential(*[CrossConv(c_, c_, 3, 1, g, 1.0, shortcut) for _ in range(n)])

def forward(self, x):

return self.cv3(torch.cat((self.m(self.cv1(x)), self.cv2(x)), dim=1))主要由3个Conv模块和一个由多个Bottleneck级联的模块组成。需要注意的是Bottleneck的定义:

class Bottleneck(nn.Module):

# Standard bottleneck

def __init__(self, c1, c2, shortcut=True, g=1, e=0.5): # ch_in, ch_out, shortcut, groups, expansion

super(Bottleneck, self).__init__()

c_ = int(c2 * e) # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c_, c2, 3, 1, g=g)

self.add = shortcut and c1 == c2

def forward(self, x):

return x + self.cv2(self.cv1(x)) if self.add else self.cv2(self.cv1(x))其中的add属性很重要,决定了是否有shortcut,其实在yolov5的backbone中的Bottleneck都是有shortcut的,在head中的Bottleneck都没有shortcut。

这里我们对与有shortcut的不进行剪枝,对应add = True,如果add=False,则进行剪枝。

由于C3中的self.cv2和self.m是通道拼接,所有 self.cv2是可以剪枝的。

self.cv3是可以剪枝的。

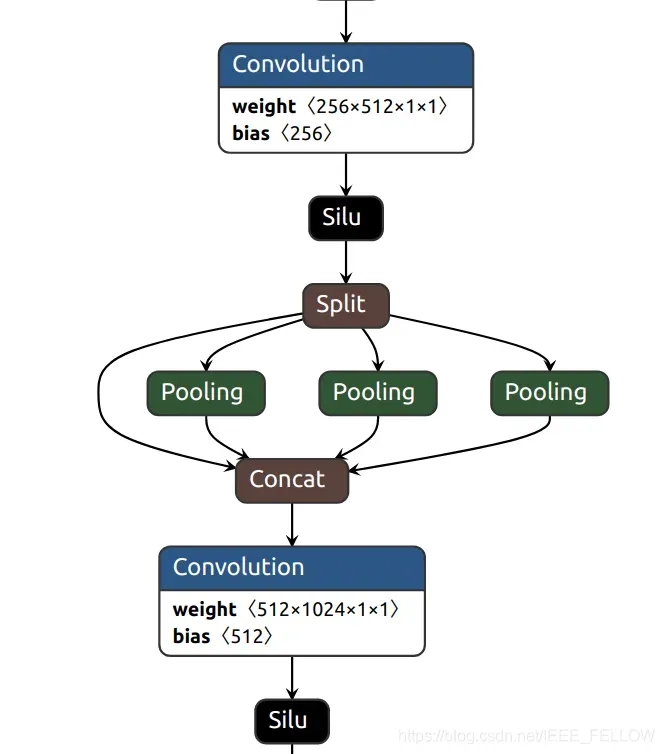

4. SPP

结构如图所示:

代码对应:

class SPP(nn.Module):

# Spatial pyramid pooling layer used in YOLOv3-SPP

def __init__(self, c1, c2, k=(5, 9, 13)):

super(SPP, self).__init__()

c_ = c1 // 2 # hidden channels

self.cv1 = Conv(c1, c_, 1, 1)

self.cv2 = Conv(c_ * (len(k) + 1), c2, 1, 1)

self.m = nn.ModuleList([nn.MaxPool2d(kernel_size=x, stride=1, padding=x // 2) for x in k])

def forward(self, x):

x = self.cv1(x)

return self.cv2(torch.cat([x] + [m(x) for m in self.m], 1))先通过一个Conv,然后分别进行不同kernel的pooling,3个pooling和输入拼接,在通过一个Conv。

这里两个Conv都是可以剪枝的。

5. nn.Upsample

yolov5中使用nearest方式上采样和之前的层融合。

6. Concat

拼接层,用于拼接之前的层,例如

[[-1, 6], 1, Concat, [1]], # cat backbone P4其中[-1, 6]是将上一层和第6个模块输出进行通道拼接。

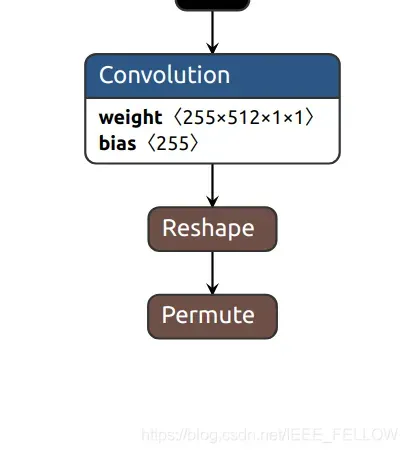

7. Detect

最后一个模块Detect是网络输出:

[[17, 20, 23], 1, Detect, [nc, anchors]], # Detect(P3, P4, P5)这里有三个输出,第17, 20, 23模块的输出进行预测:

例如第23模块对应的输出卷积层:

255是3×(80+5),对应3个anchor, 80个类别,使用bce做二分类判断是否为当前类别,4个坐标预测,1个是判断是否为目标或者背景。

这里没有bn层,不做剪枝。

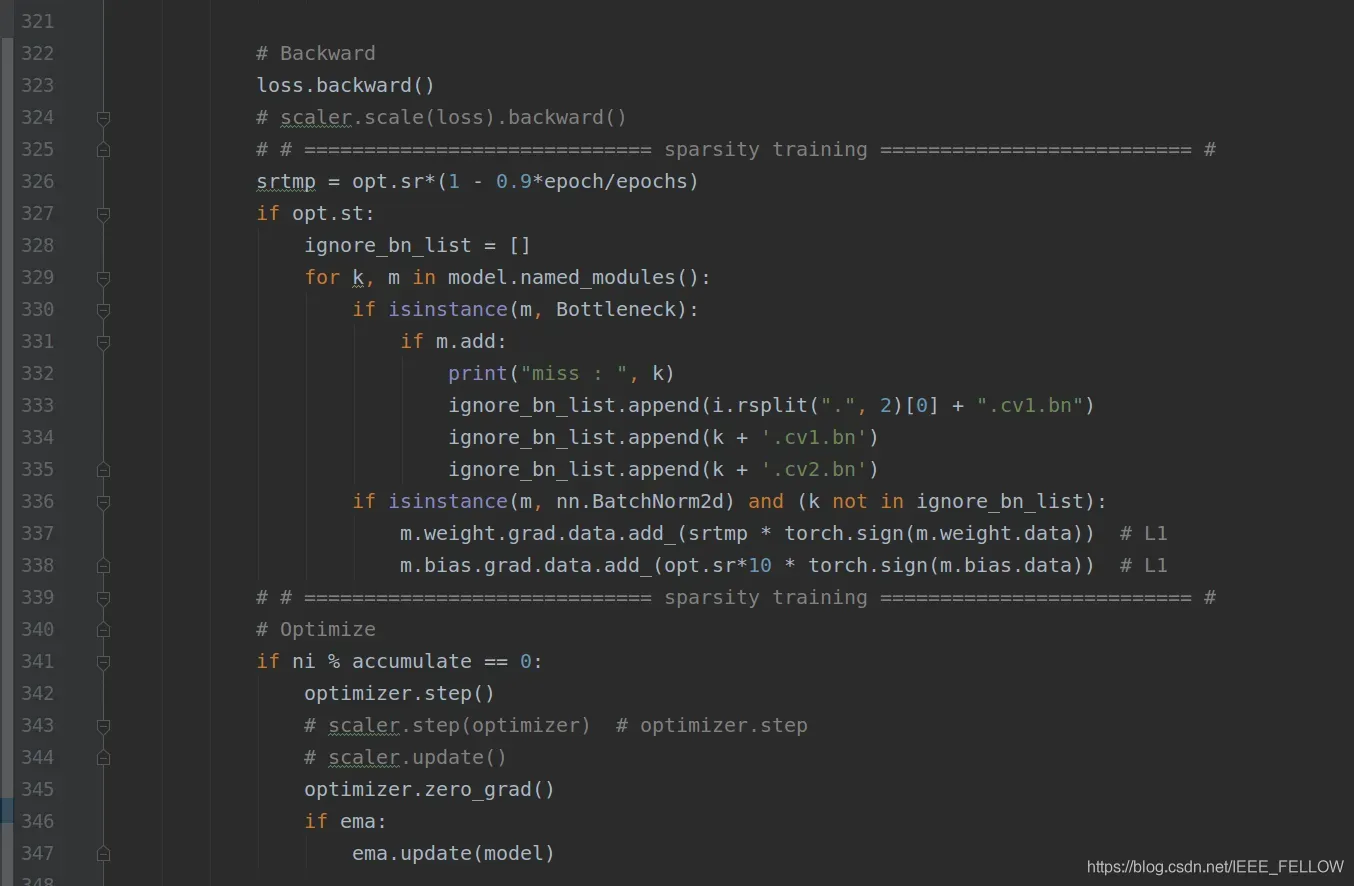

选择修剪过的图层

刚刚介绍完成所有的模块,因为对BN层进行剪枝,所有的BN层都接在卷积层之后,这里选择没有shortcut的层进行剪枝,在稀疏训练时候:

版权声明:本文为博主MidasKing原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/IEEE_FELLOW/article/details/117536808