内容

Recurrent Neural Network 递归神经网络

N-grams

RNN 递归神经网络

RNN的训练:The vanishing/exploding gradient problem 梯度消失/爆炸问题

Bidirectional RNNs 双向循环神经网络

评估:F1-score

Recurrent Neural Network 递归神经网络

场景:计算一个单词序列的概率

N-grams

思路:根据前词来预测

词的概率,但这会占用大量内存

RNN 递归神经网络

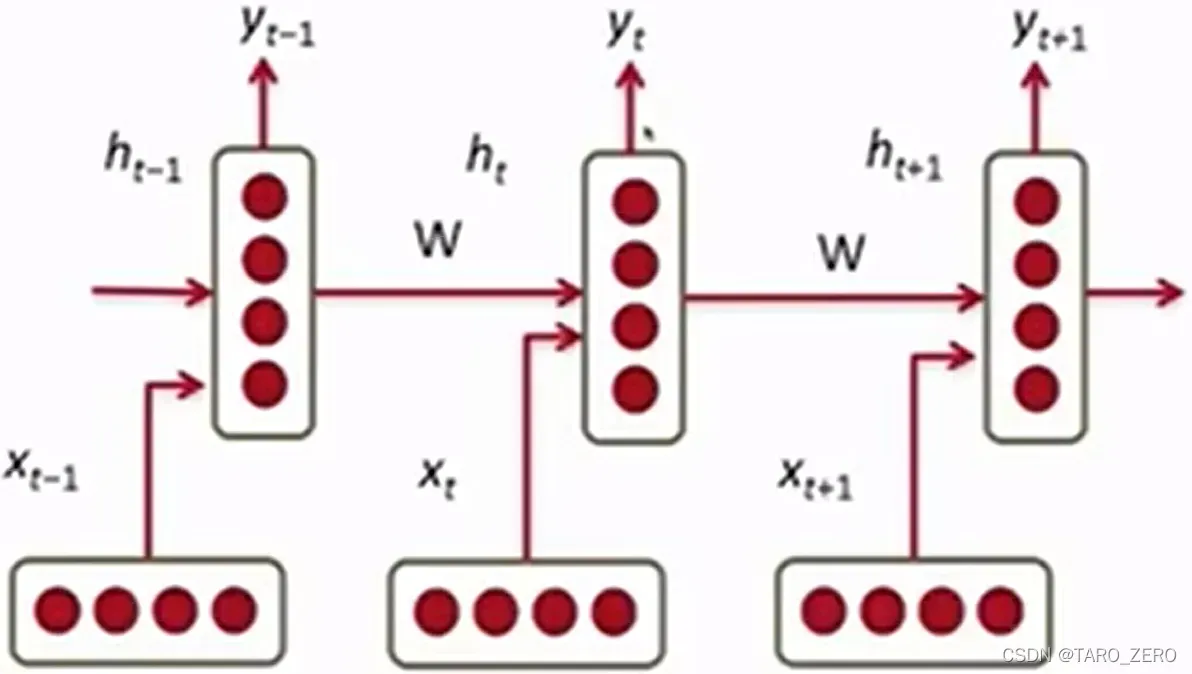

每一层使用相同的神经网络,训练相同的参数矩阵,通过上层结果和新的输入变量联合预测结果

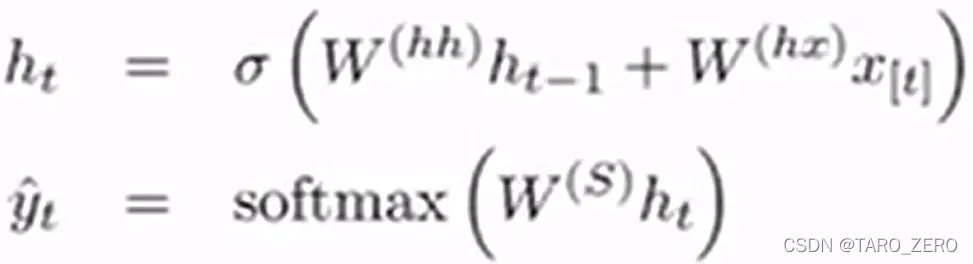

词向量序列为,参数矩阵可分为

三部分,各层预测的概率向量为

,各层的神经网络如下

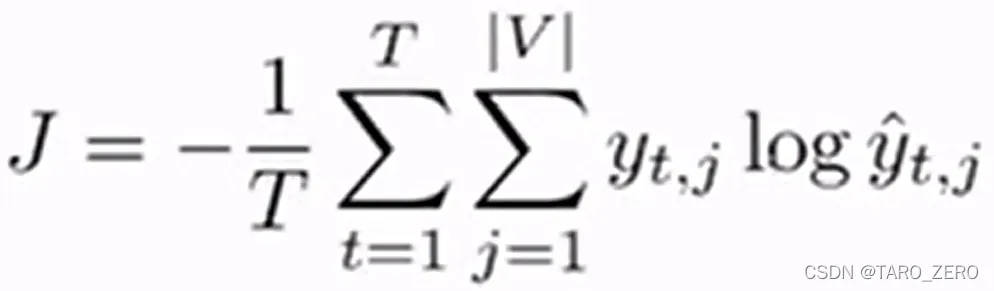

损失函数:使用交叉熵损失函数

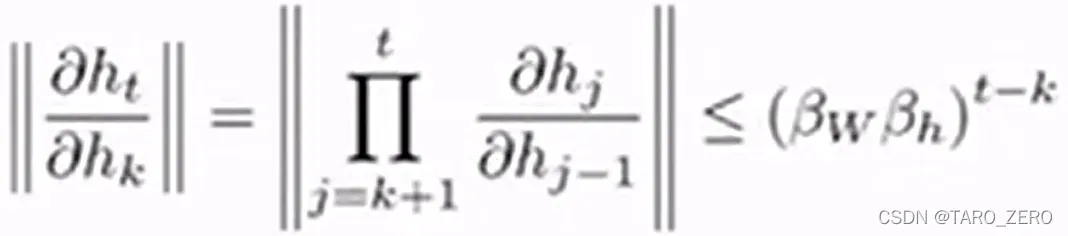

RNN的训练:The vanishing/exploding gradient problem 梯度消失/爆炸问题

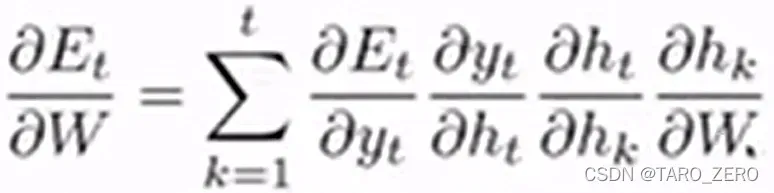

根据梯度下降,因为权重矩阵出现在每一层,推导时

如果的初始化范数小于或大于1,随着序列变长

增大,

也会迅速缩小或增大,成为梯度消失/梯度爆炸

梯度爆炸解:定义梯度阈值,梯度截断法

梯度消失解决方案:恒等初始化结合ReLu线性整流函数

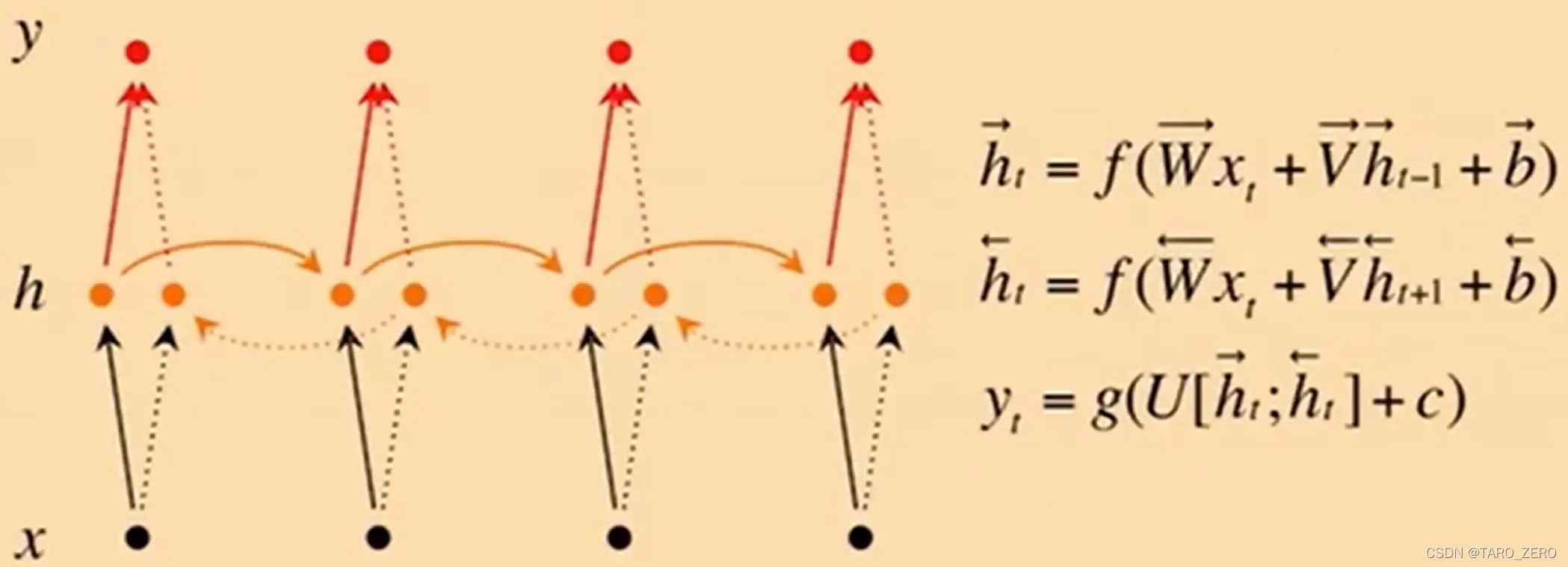

Bidirectional RNNs 双向循环神经网络

应用场景:情感分析&意见挖掘,此时无需考虑文本中词序的方向

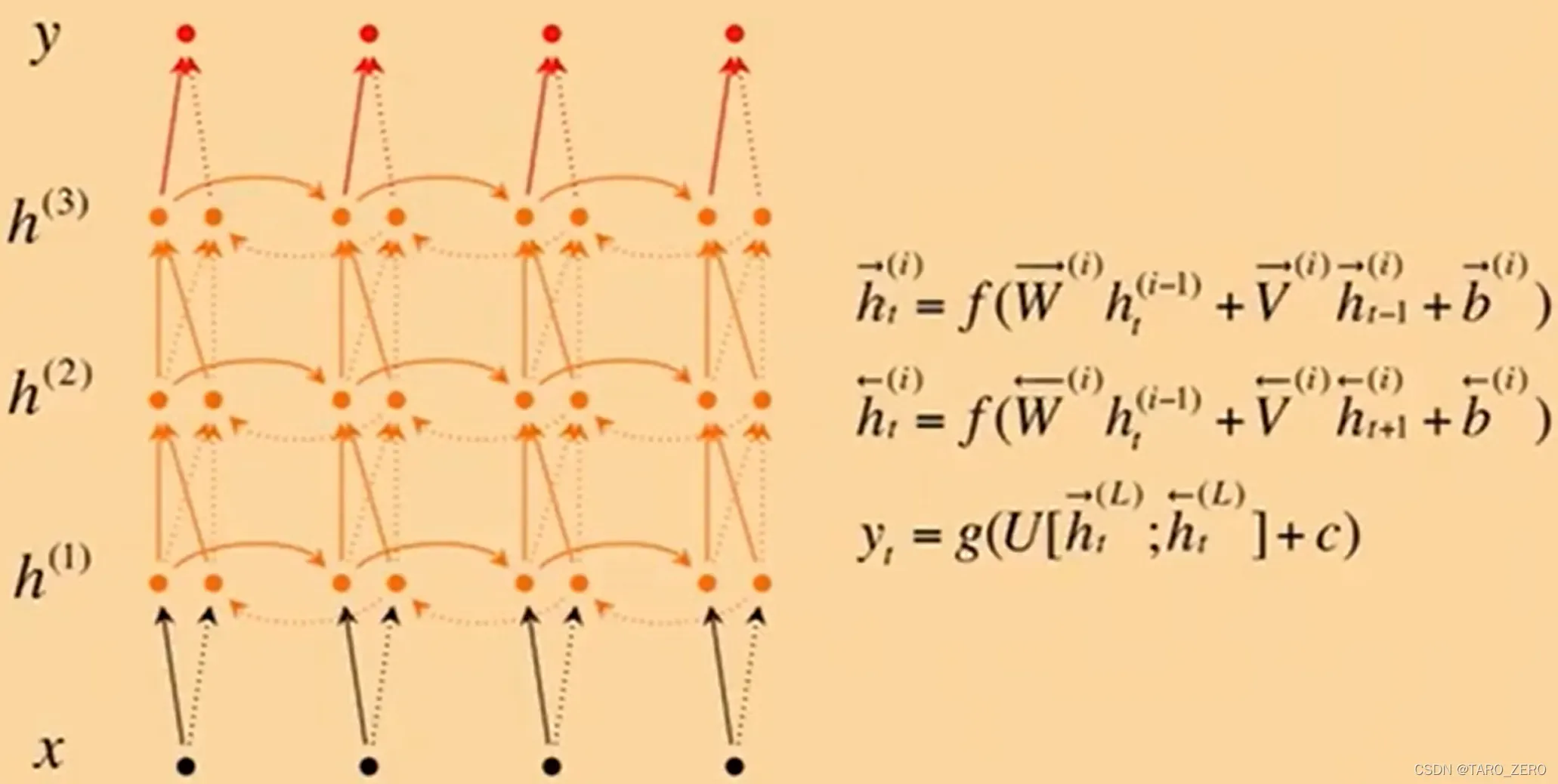

进一步还可扩展为Deep Bidirectional RNNs

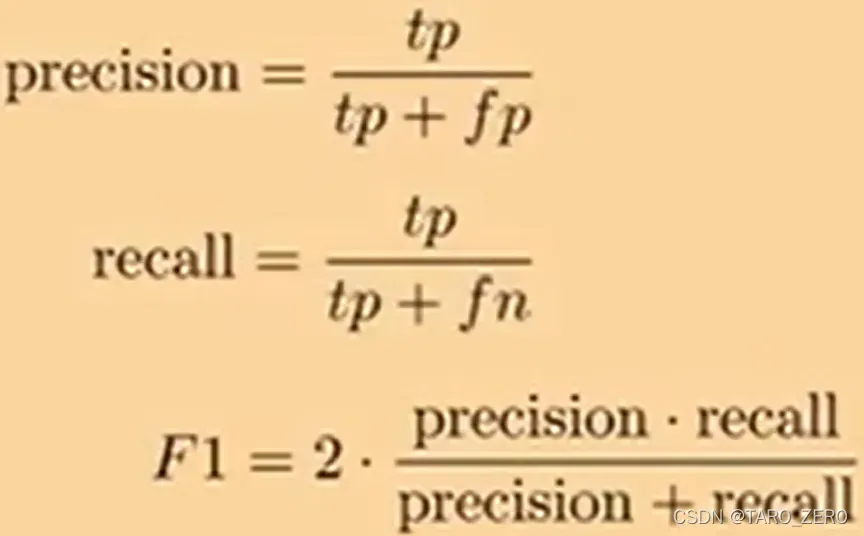

评估:F1-score

版权声明:本文为博主TARO_ZERO原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/TARO_ZERO/article/details/123142300