上一篇已经讲解了如何构建自己的私人GPT,这一篇主要讲如何让GPT支持中文。

privateGPT 本地部署目前只支持基于llama.cpp 的 gguf格式模型,GGUF 是 llama.cpp 团队于 2023 年 8 月 21 日推出的一种新格式。它是 GGML 的替代品,llama.cpp 不再支持 GGML。

本文主要采用国产YI-34B-CHAT模型。

1.模型下载

yi模型下载:TheBloke/Yi-34B-Chat-GGUF · Hugging Face

下载后放置在 models 文件夹下

embedding模型下载:BAAI/bge-small-en-v1.5 · Hugging Face

下载后放置在models/cache文件夹下,bge is short for BAAI general embedding,FlagEmbedding 可以将任何文本映射到低维密集向量,该向量可用于检索、分类、聚类或语义搜索等任务。它还可以用于法学硕士的矢量数据库

2.settings.yaml 文件修改:

主要修改local部分,使用YI模型使用prompt_style: “tag”类型的提示词模板

llm_hf_model_file: yi-34b-chat.Q4_K_M.gguf

prompt_style: "tag"3.代码修改

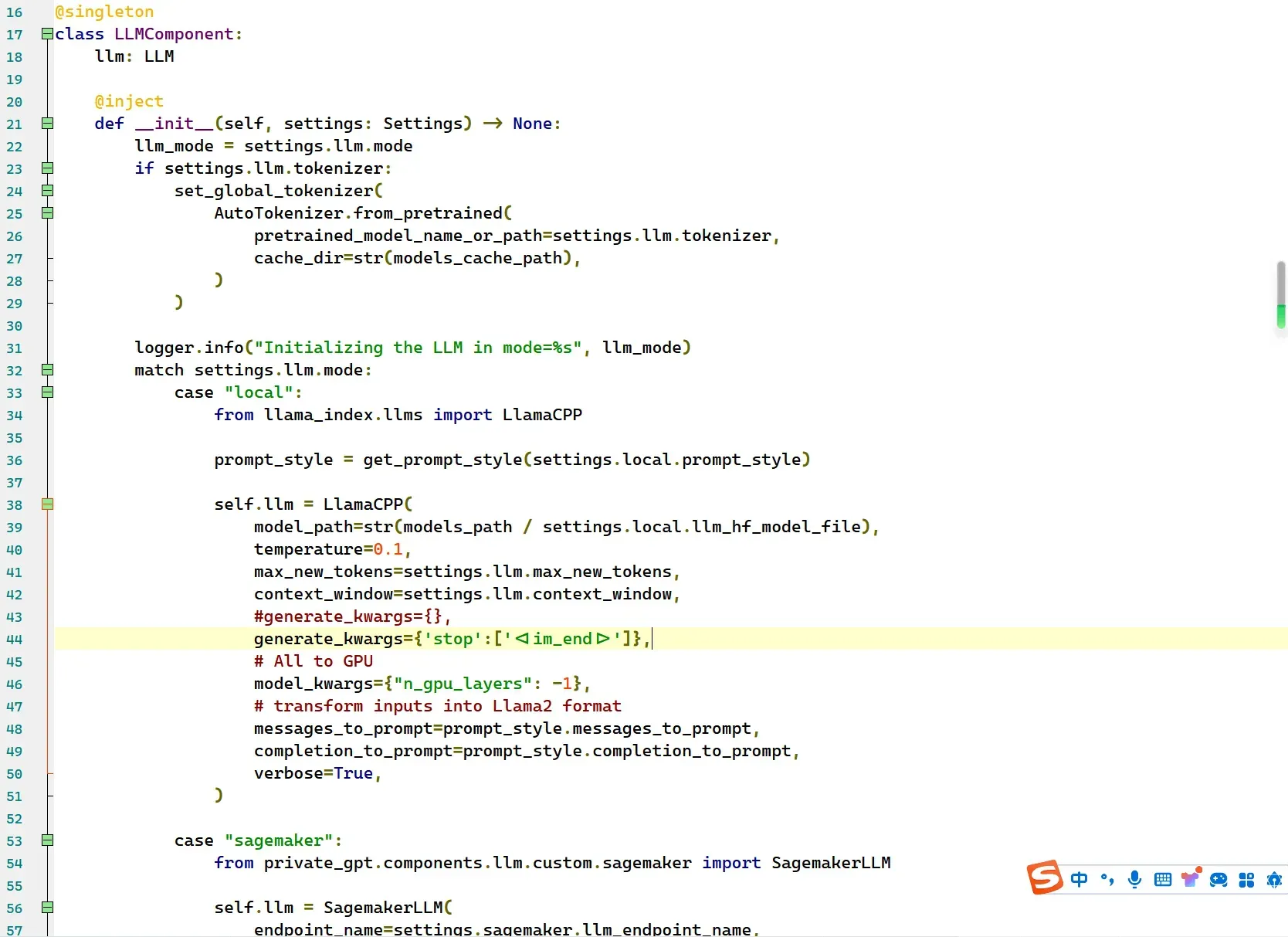

使用YI-34B-CHAT模型,源码要简单修改下,修改如下

文件路径 privateGPT/private_gpt/components/llm/llm_component.py

第44行,添加如下内容:

generate_kwargs={'stop':['<|im_end|>']},如图:

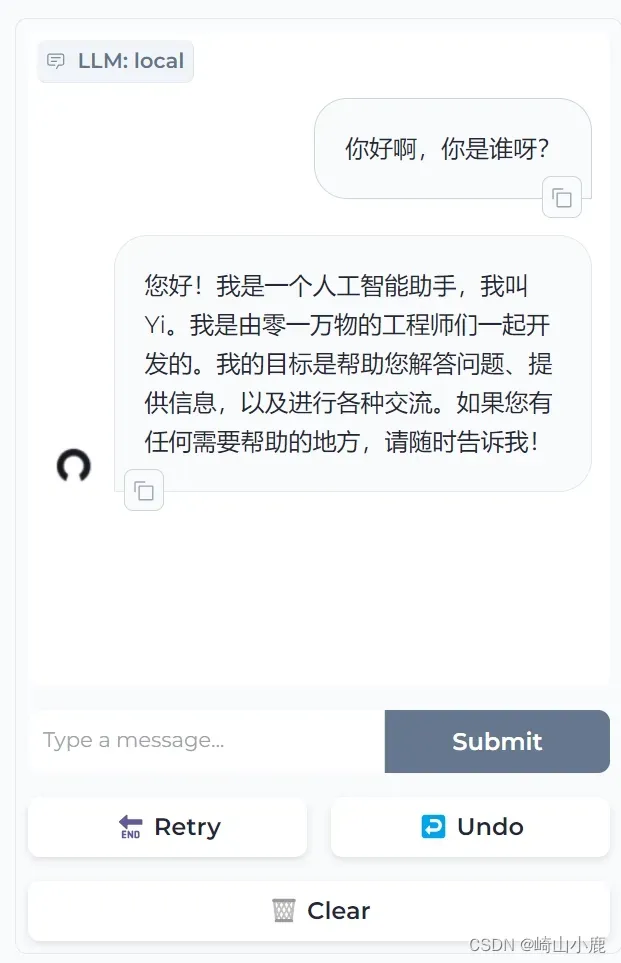

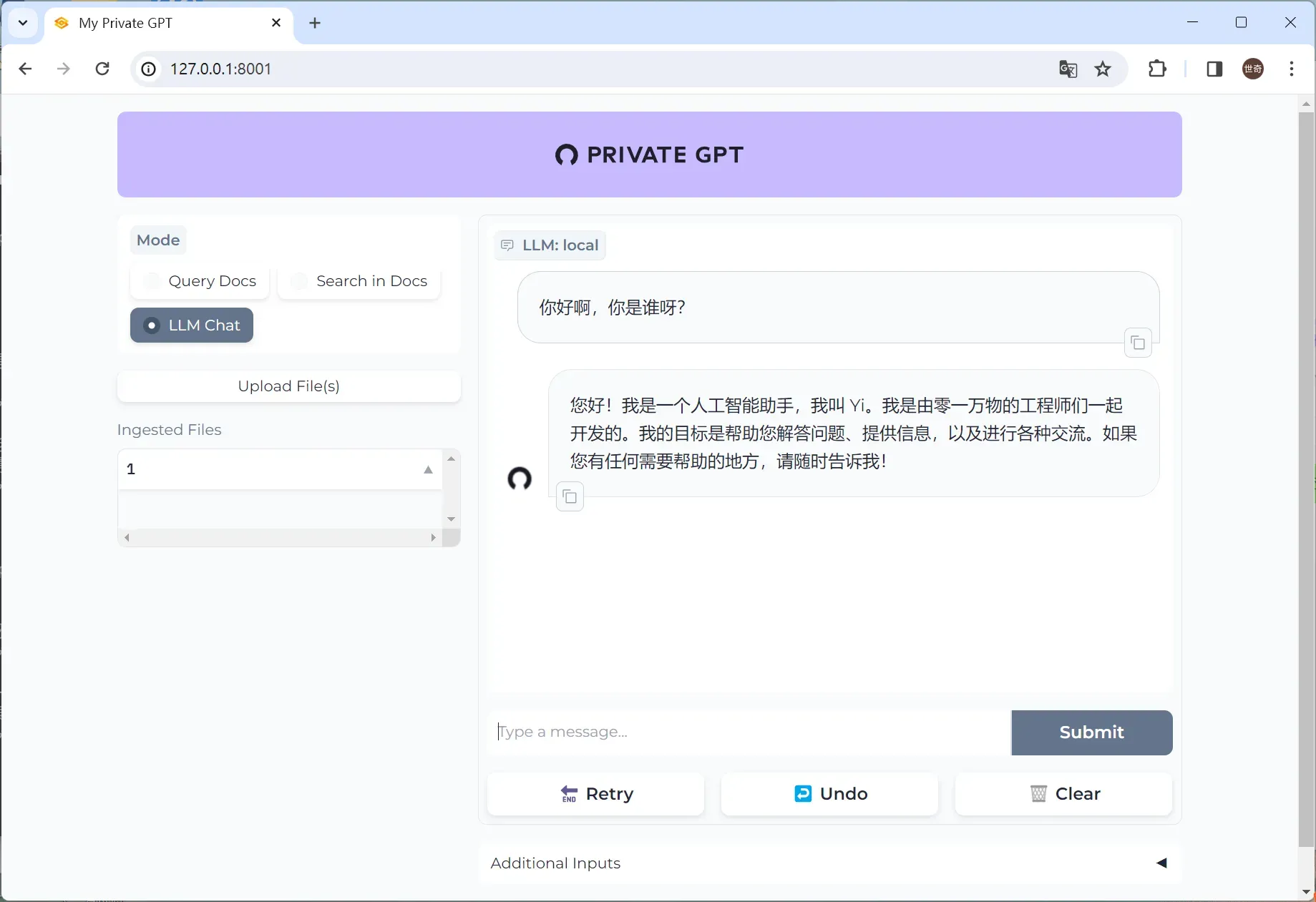

导航到 UI:在浏览器中打开 http://localhost:8001/。

创作不易,多多支持!

版权声明:本文为博主作者:崎山小鹿原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/selifecn/article/details/135477575