文章目录

- ⭐ 前言

- ⭐ 灵感来源

- ⭐ 项目准备

- ⭐ 项目实现

- ⭐ 不足与展望

⭐ 前言

10月17日,以“生成未来(PROMPT THE WORLD)”为主题的百度世界2023将在北京首钢园举办。百度创始人、董事长兼首席执行官李彦宏将带来以“手把手教你做AI原生应用”为题的一小时演讲。关于大模型、AI原生应用的最新进展也将悉数亮相。

这是百度世界四年来首次回归线下举办,除多场主题论坛外,还带来近50项AI科技展,包括Prompt胶囊墙、AI全息数字人等,为参会者带来沉浸式AI体验。

⭐ 灵感来源

百度智能云千帆大模型平台是一站式企业级大模型平台,提供先进的生成式AI生产及应用全流程开发工具链。具有丰富的产品功能、多样的交付方案与服务、全面领先的平台功能、内置丰富优质的大模型能力、预置典型的应用范式。例如训练与推理性能方面,MLPerf榜单训练性能世界领先,千亿模型分布式并行训练加速能力和算力利用率大幅提升。

10月1放假期间使用手机的频率有点高,导致视力下降,打算去眼镜店重新配个眼镜。可能是学生放假的缘故,眼镜店的人还真不少,就连测视力都排起了长龙。想到百度AI提供的人体分析技术,做一款【智能视力表】应用的想法油然而生。

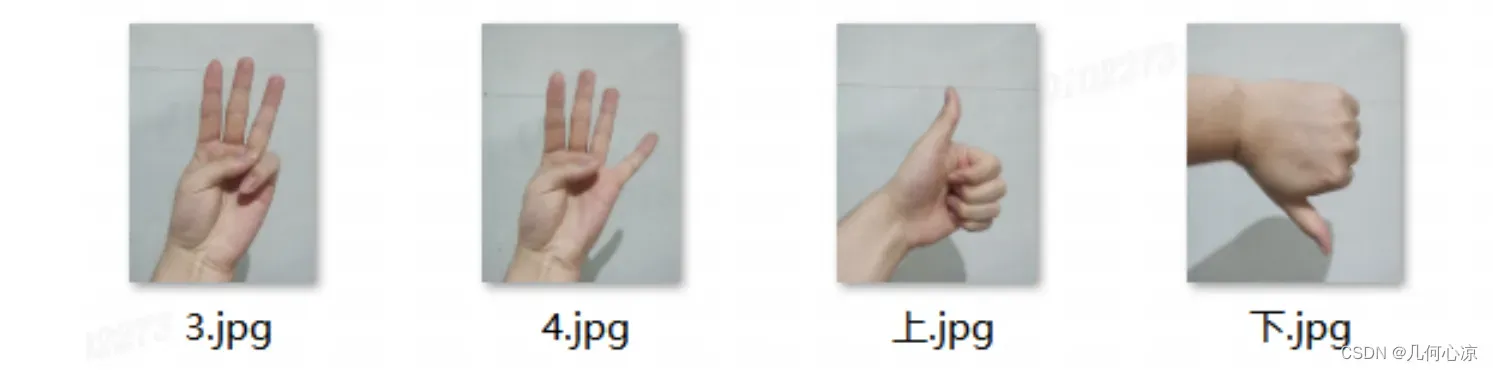

准备的图片如下:

3(Three)代表左,4(Four)代表右,上(Thumb_up)就是上,下(Thumb_down)就是下。以下就以动作代表的含义来描述。括号中的英文就是最终应用根据手势识别出的文字信息。

创意步骤:

- 将视力表中的“E”从上到下分好组,提前录入应用;

- 打开智能视力表,将手机固定到眼睛50cm的正前方,“上”代表左眼视力开始,“下”代表右眼视力开始;

- 开始之后应用会按“E”从小到大的顺序来弹出,人做出上下左右的手势,应用识别之后给出是否正确的答案;

- 如果正确就会给出同组的另一个“E”,连着两个回答正确才会通过,然后提示换另一只眼睛;如果连续的三次中有两个回答错误,就会弹出大一点的“E”,直到通过。

- 两只眼睛测试完毕之后给出最终的结果。

⭐ 项目准备

废话不多说,搭建来一波。我用的是Python环境,学过Python的同学应该都会搭建环境了,没学过的同学可以自行百度安装(此处不是本文重点)。

(1)安装千帆SDK

pip install qianfan

注意:目前支持 Python >= 3.7版本。

(2)调用千帆SDK

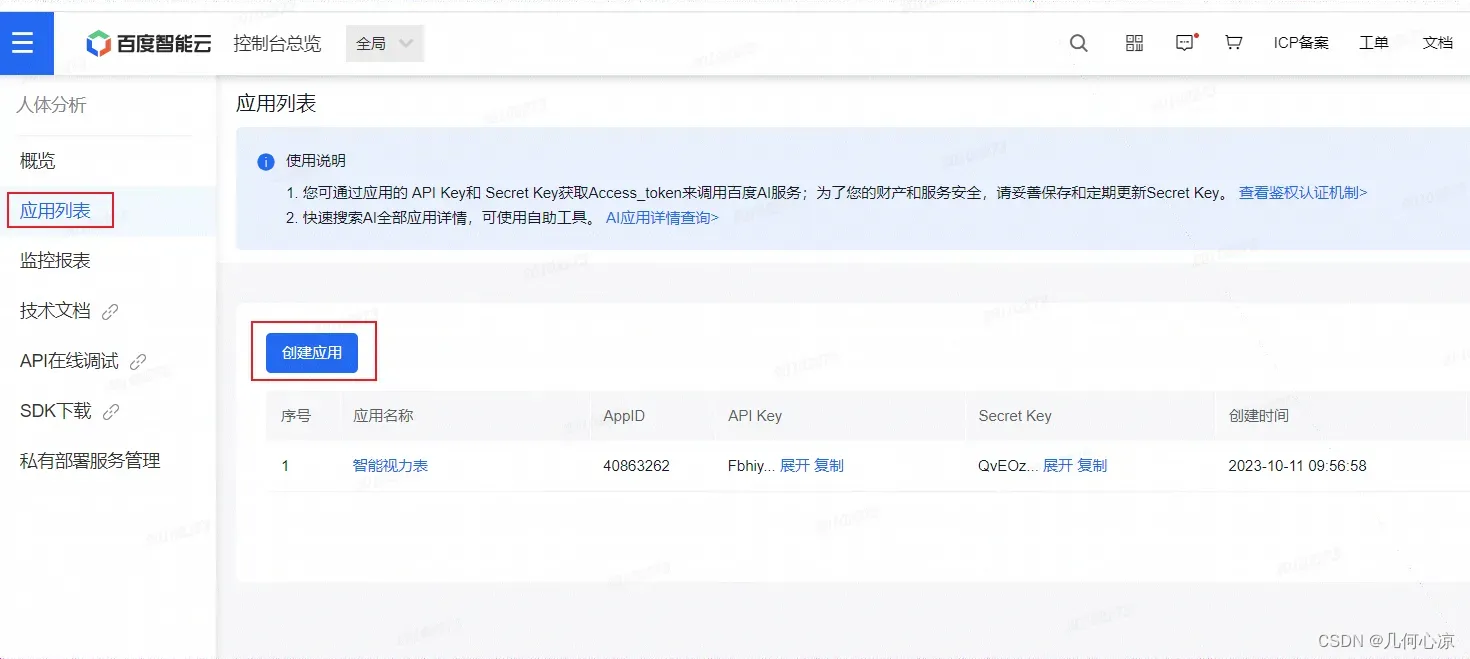

步骤一,创建应用,获取应用API Key(AK) 和 Secret Key(SK)。

步骤二,初始化AK 和 SK。

步骤三,调用SDK。

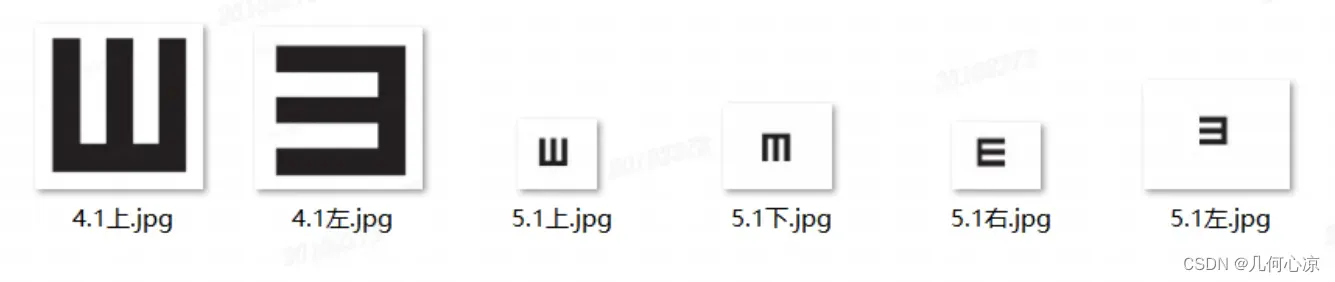

(3)视力表图片准备

如图,准备了几张示例照片,大家可以找专业的美工来定制不同的图片。

⭐ 项目实现

图片处理

模拟图片分组,将图片按照不同的视力数值分组

image_map = OrderedDict()

image_map[4.1] = ['4.1上.jpg', '4.1左.jpg']

image_map[5.1] = ['5.1上.jpg', '5.1下.jpg', '5.1左.jpg', '5.1右.jpg']

然后从最后一个索引开始随机弹出照片“5.1上.jpg”

代码如下:

def get_picture(image_map):

index = len(image_map.items())

key = list(image_map.keys())[index-1]

value = list(image_map.values())[index-1]

image = random.choice(value)

return key,image

创建应用

打开人体分析页面,创建“智能视力表”应用,获取应用API Key(AK) 和 Secret Key(SK)。

获取签名

通过应用的API_KEY和SECRET_KEY 获取应用的 access_token

def get_access_token():

url = "https://aip.baidubce.com/oauth/2.0/token"

params = {"grant_type": "client_credentials", "client_id": API_KEY, "client_secret": SECRET_KEY}

return str(requests.post(url, params=params).json().get("access_token"))

手势识别

我们看到应用随机出现的“E”之后,用手势来表示看到的“E”开口方向

应用首先要获取到图片对应的base64编码

def get_file_content_as_base64(path, urlencoded=False):

with open(path, "rb") as f:

content = base64.b64encode(f.read()).decode("utf8")

if urlencoded:

content = urllib.parse.quote_plus(content)

return content

根据获取的 access_token ,调用手势识别接口获取手势的意义。

def gesture():

url = "https://aip.baidubce.com/rest/2.0/image-classify/v1/gesture?access_token=" + get_access_token()

payload = get_file_content_as_base64("下.jpg",True)

headers = {

'Content-Type': 'application/x-www-form-urlencoded',

'Accept': 'application/json'

}

response = requests.request("POST", url, headers=headers, data=payload)

print(response.text)

得到的调试结果如下:

{

"result": [

{

"classname": "Thumb_up",

"top": 175,

"left": 158,

"probability": "0.5745857357978821",

"width": 397,

"height": 536

}

],

"result_num": 1,

"log_id": "1711926132646834128"

}

将result中的classname取出与最早定义好的“上(Thumb_up)”对比来判断对错就可以了。

⭐ 不足与展望

我上边只是将创意进行了简单的实现,里边还有些许不完美的地方,比如视力表图片的制作,视力表图片的录入,判断连续几次成功或者失败的逻辑等都是可以继续优化的地方。希望在不久的将来我可以用上相关厂家提供的【智能视力表】。作为参会者,我非常期待在百度世界大会上看到最新的人工智能技术,希望AI科技展的AI全息数字人能带给我不一样的震撼与体验。同时也非常期待百度世界大会后将会有更多的AI原生应用涌现。最后,祝百度世界大会圆满成功。

文章出处登录后可见!