这是一篇ICLR2023 top 5%论文

论文链接:https://openreview.net/pdf?id=vSVLM2j9eie

代码:https://github.com/Thinklab-SJTU/Crossformer

1. Multivariate Time Series Forecasting

MTS,多变量时序数据预测。利用MTS的历史值可以预测其未来的趋势,例如心电图(ECG),脑电图(EEG)脑磁图(MEG)的诊断以及系统监测等等都是固有的多变量问题。该任务数据每个实例序列拥有多个维度,是一个d维向量和m个观测值(时间序列)的列表,如下所示数据(借鉴自综述论文:《The great multivariate time series classification bake off: a review and experimental evaluation of recent algorithmic advances》)

2. 动机

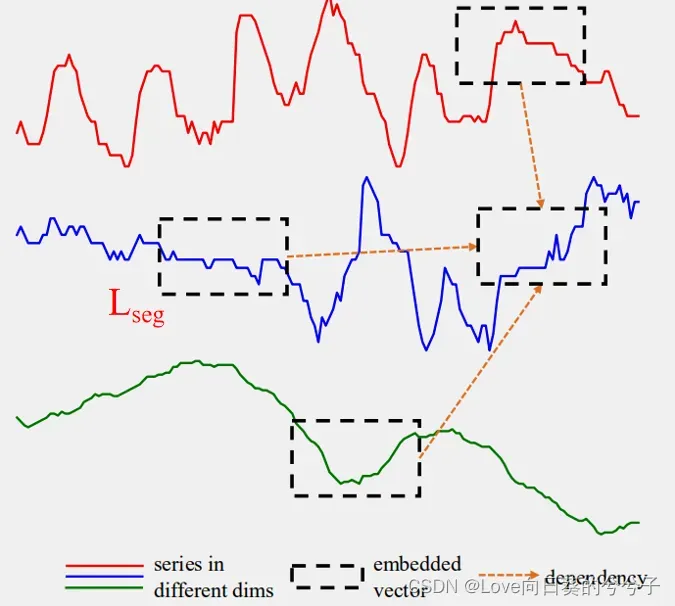

MTS的核心额外复杂性在于,区别性特征可能存在于维度之间的相互作用中,而不仅仅存在于单个序列中的自相关性中。标准的Transformer中核心self-attention可能仅仅建模了单个序列的自相关性,忽略了跨维度的依赖关系。

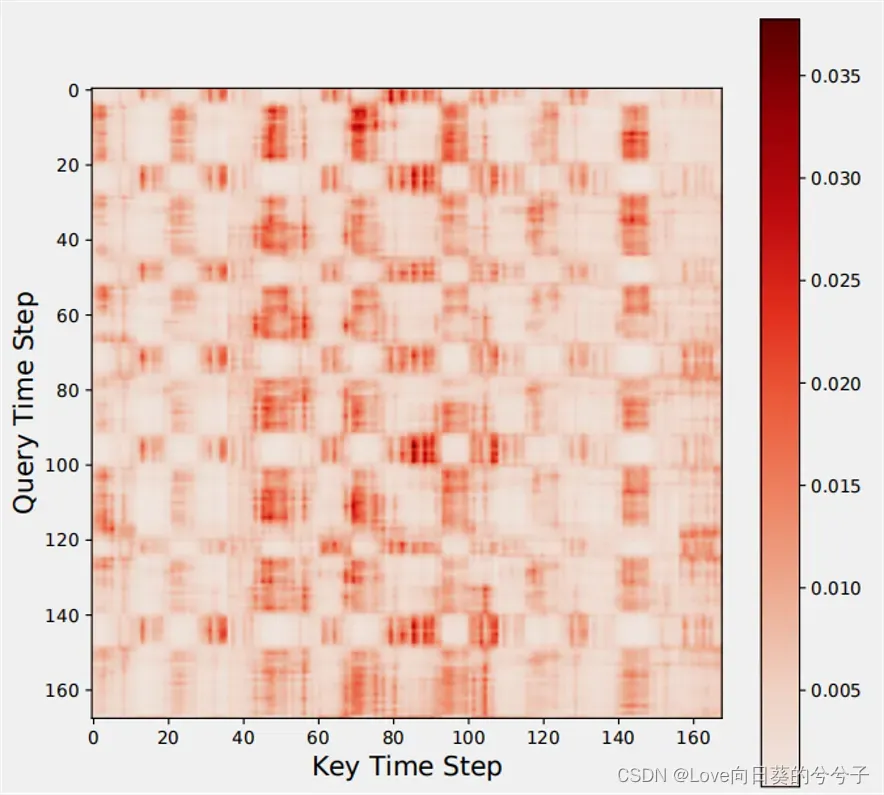

此外,如下图所示,当数据序列很长时,计算复杂性高,但是可以观察到,接近的数据点具有相似的注意权重!

基于此,作者提出一个分层encoder-decoder框架Crossformer.

3. Crossformer

目标:输入一段历史序列,预测未来的一段序列

.

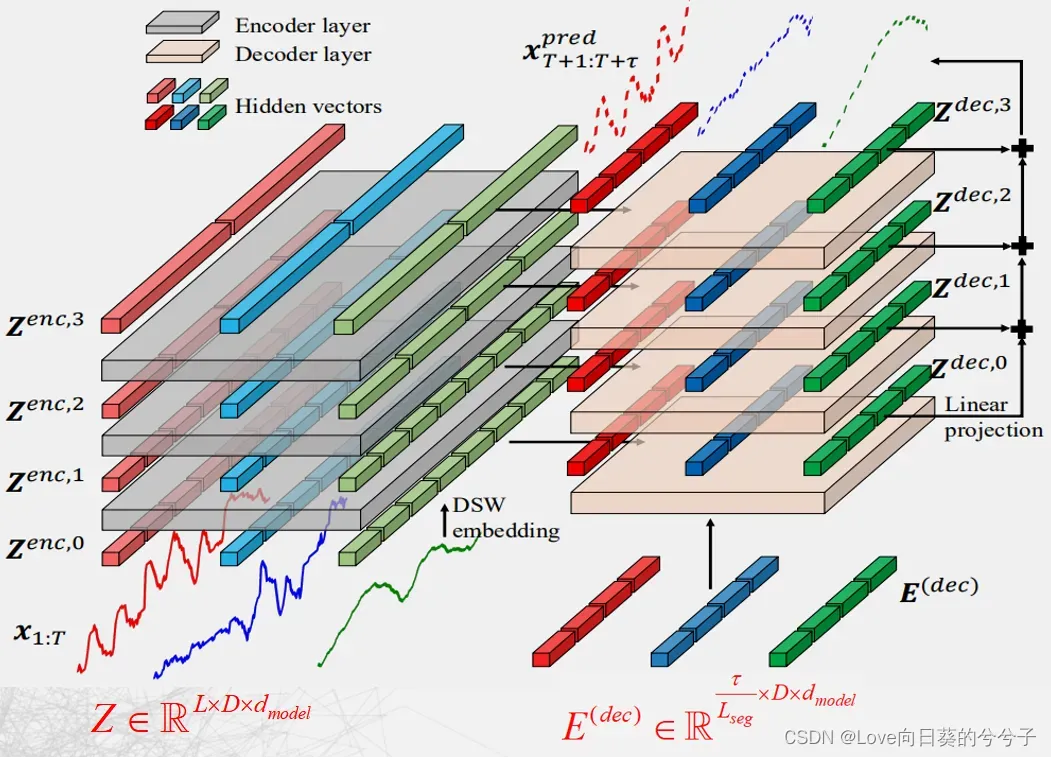

3.1 Hierarchical Encoder-Decoder

作者提出一个新的层次Encoder-Decoder的架构,如下所示,由左边encoder(灰色)和右边decoder(浅橘色)组成。其主要包含Dimension-Segment-Wise (DSW) embedding,Two-Stage Attention (TSA)层和Linear Projection。

- Dimension-Segment-Wise (DSW) embedding:为了将输入

进行分segment,从而减少计算复杂性。如果最后每个序列要分成

个segment,每个序列

的通道数,则最后的输入记为:

.

- Two-Stage Attention (TSA)层:捕获cross-time和cross-dimension依赖关系。替待原来的self-attention在encoder和decoder中的位置。

- Linear Projection:应用于每一个decoder层的输出,以产生该层的预测。对各层预测结果进行求和,得到最终预测结果

.

3.2 Dimension-Segment-Wise embedding (DSW)

输入,表明输入包含

个序列,每个序列有

个维度。如下所示,如果我们分的每个segment的长度为

,则每个序列中可以划分出

个segment,每个序列有

个维度,则整个输入共包含

个segment,故

可以记为:

。在

维度中的第

个segment的size记为

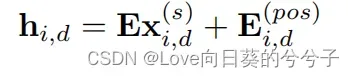

,然后使用线性投影和位置嵌入将每个段嵌入到一个向量中:

最后,可以获得一个2D的向量数组.

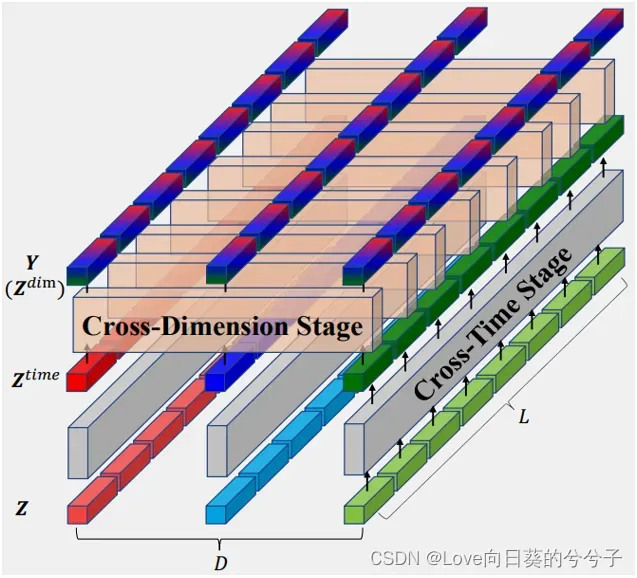

3.3 Two-Stage Attention (TSA)

由上可得输入现在为:,为了方便,记

,则输入为

。TSA主要由cross-time stage和

cross-dimension stage组成,如下图所示。

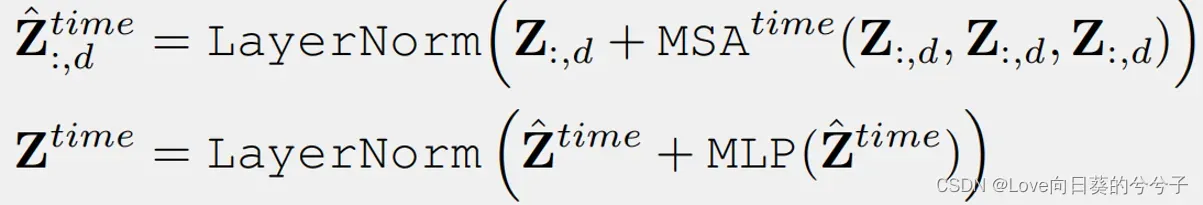

- Cross-Time Stage

对于每个维度,包含所有时间序列。因此,对于维度

上,cross-time依赖关系可记为:

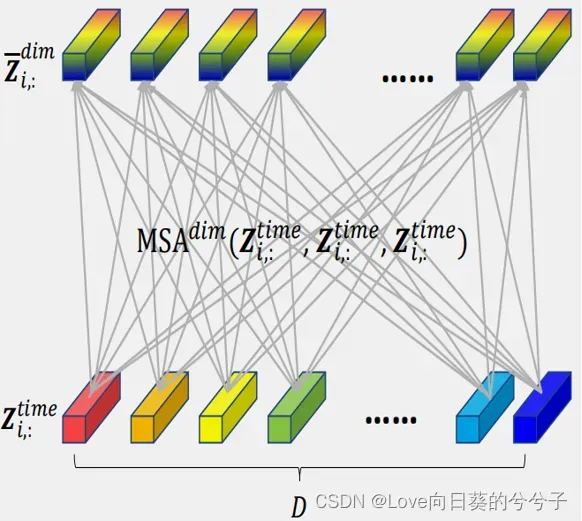

- Cross-Dimension Stage

对于每个时间点,包含所有维度。因此,对于第时间点

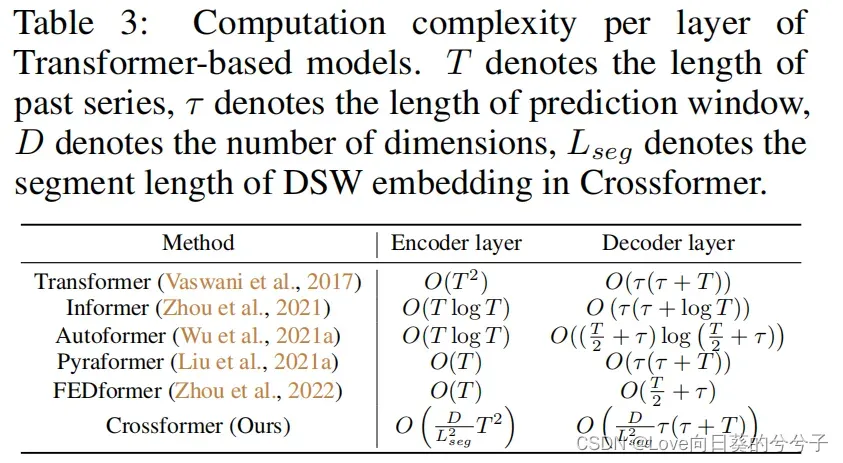

1)如果使用标准Transformer进行,如下图所示,可以很容易得到复杂性为!总共有

个时间segment,因此总复杂性为

.

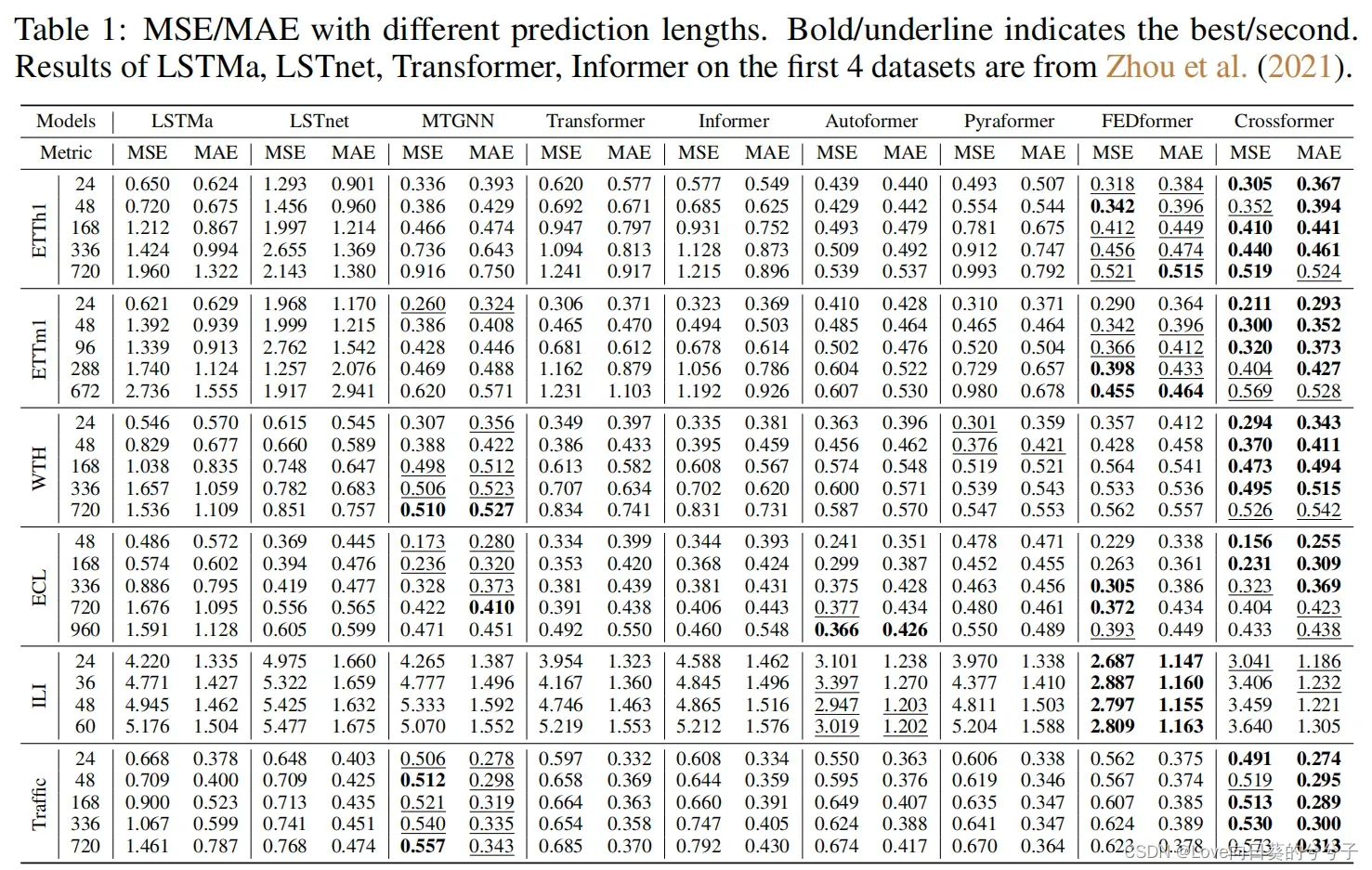

4 实验

-

SOTA方法对比

-

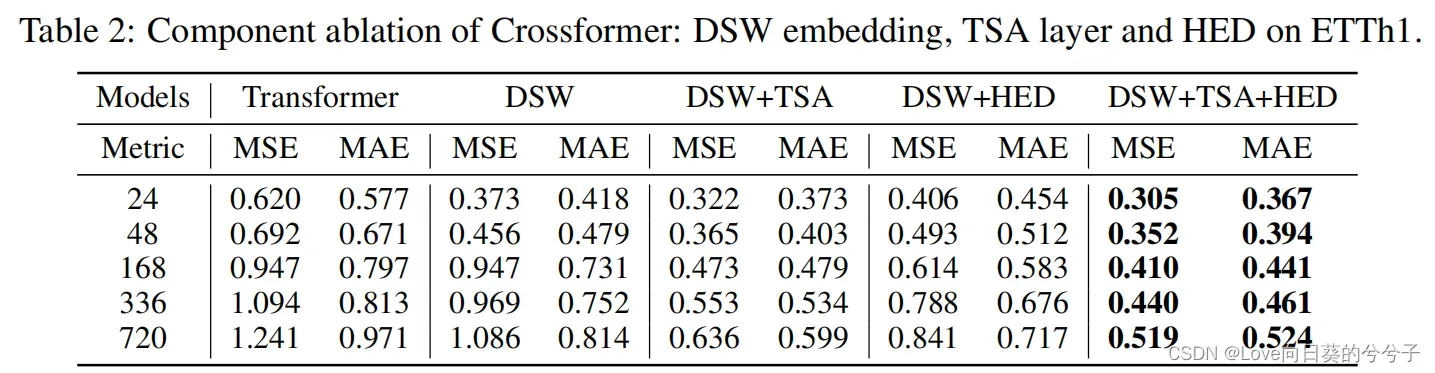

消融实验

-

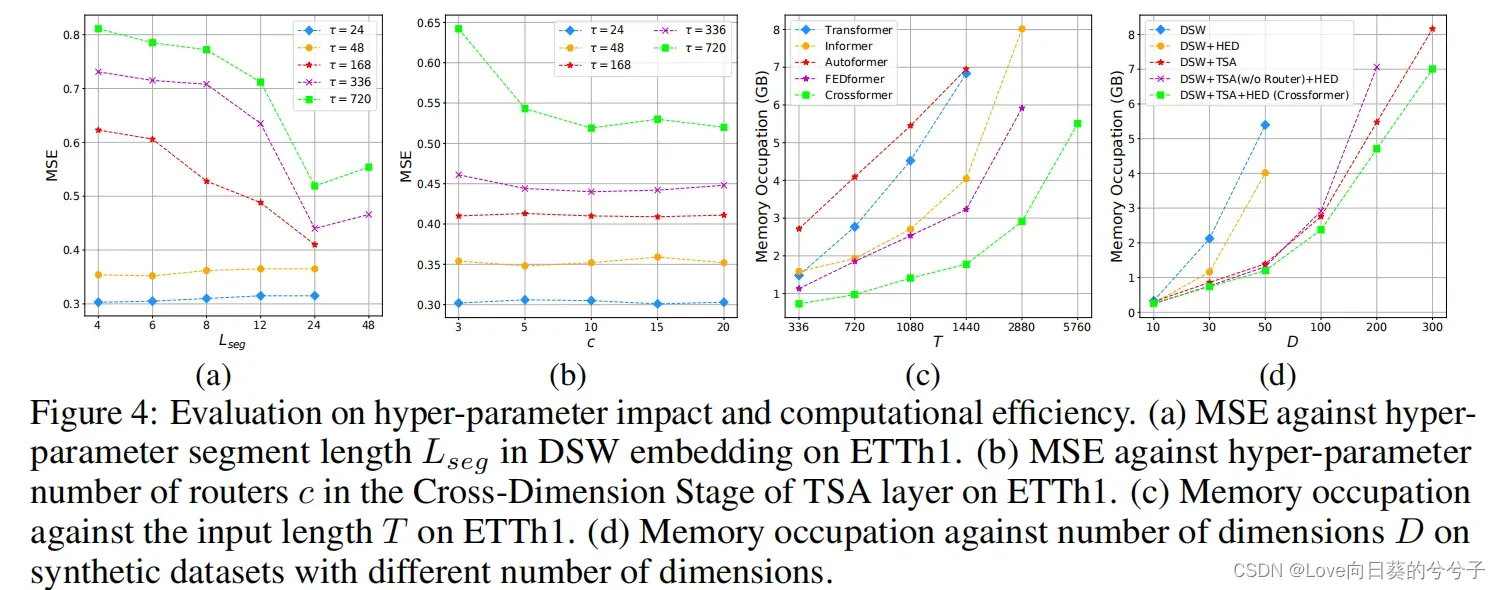

参数分析

-

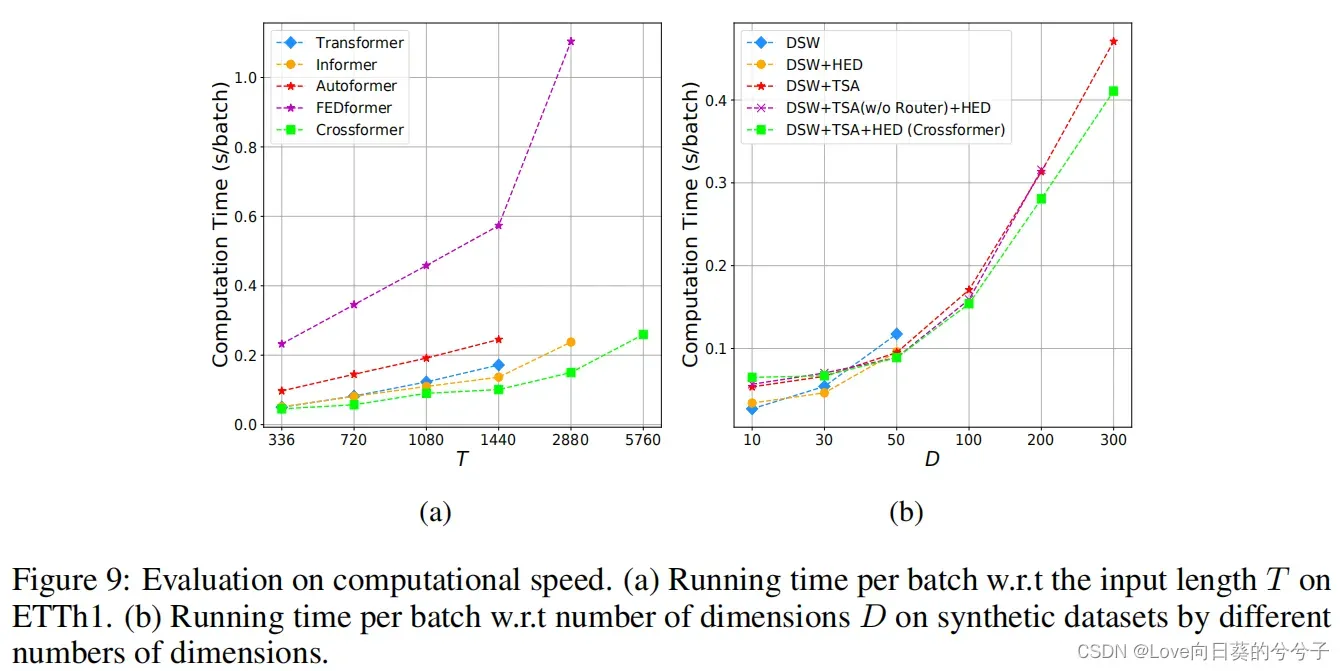

复杂性分析

-

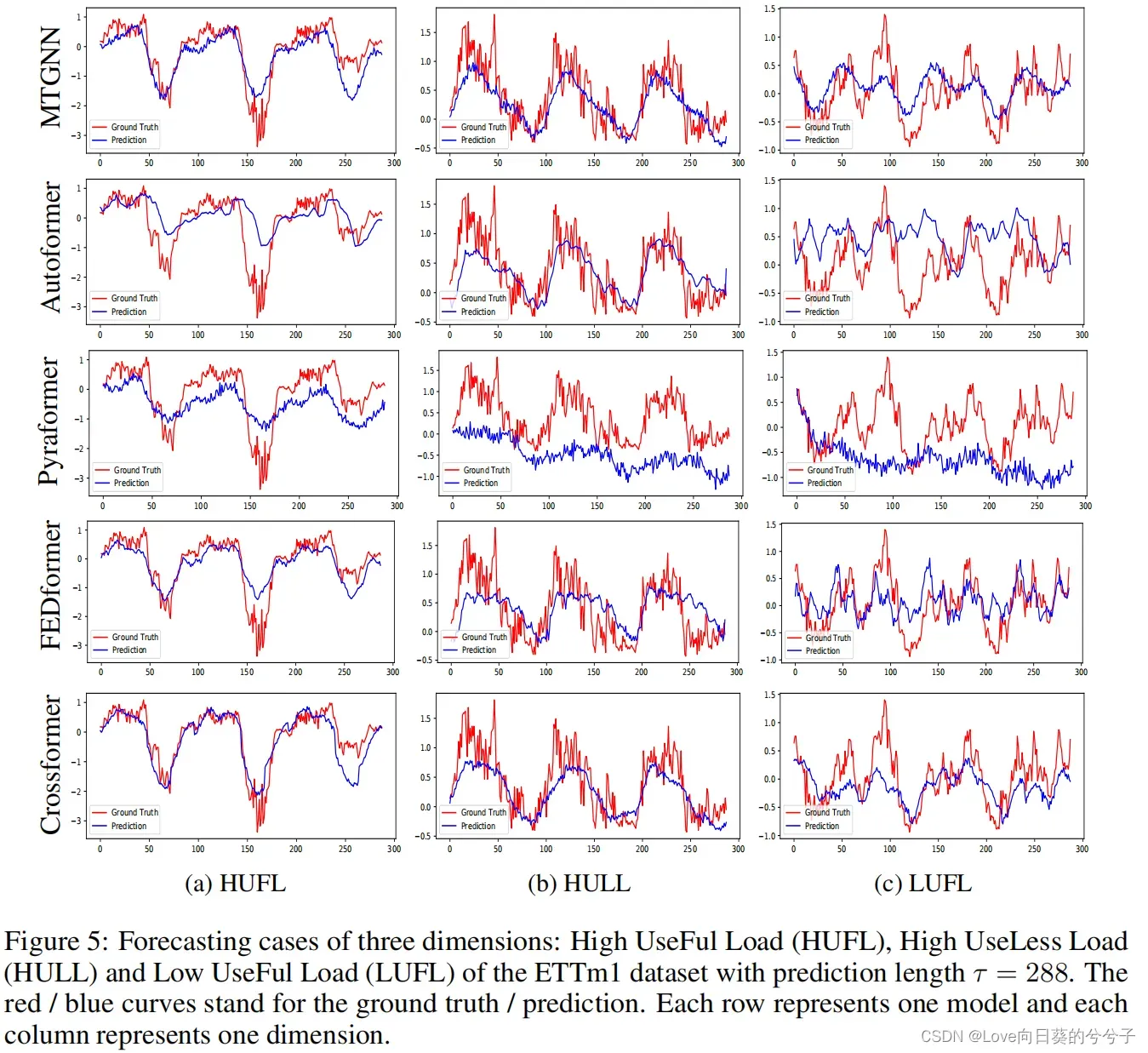

可视化

-

运行速度对比

5. 结论

- 提出了Crossformer,一种基于transformer的模型,利用跨维度依赖进行多元时间序列(MTS)预测。

- DSW (dimension – segment – wise)嵌入:将输入数据嵌入到二维矢量数组中,以保留时间和维度信息。

- 为了捕获嵌入式阵列的跨时间和跨维度依赖关系,设计两阶段注意(TSA)层。

- 利用DSW嵌入和TSA层,设计了一种分层编码器(HED)来利用不同尺度的信息。

在6个数据集上的实验结果展示了该方法优于之前的先进技术。

以上仅为本人小记,有问题欢迎指出(●ˇ∀ˇ●)

文章出处登录后可见!