最近在学习stable diffusion model,但是这个模型成本比较高,作为低端学习者,借助colossal-ai加速训练,即能满足显卡要求又能节约时间。

Colossal-AI 是一个集成的大规模深度学习系统,具有高效的并行化技术。该系统可以通过应用并行化技术在具有多个 GPU 的分布式系统上加速模型训练。该系统也可以在只有一个 GPU 的系统上运行。

Colossal-ai的安装

创建虚拟环境:

conda create -n colossal python=3.8

注:这里的“colossal”是虚拟环境的名字,想怎么改就怎么改

创建成功进入该环境

conda activate colossal

接下来一步是安装pytorch

pip install torch==1.12.1+cu116 torchvision==0.13.1+cu116 trochaudio==0.12.1 –extra-index-url https://download.pytorch.org/whl/cu116

![]()

这样就安装成功torch环境了。

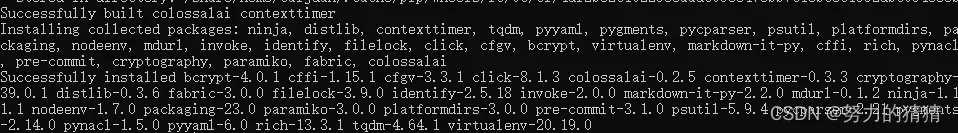

接下来直接安装colossalai

pip install colossalai

安装成功!

给一下Colossal-AI开源包的github地址: GitHub – hpcaitech/ColossalAI: Making big AI models cheaper, easier, and more scalable

下载并解压缩,进入ColossalAI/ -> examples/ -> tutoriall/ -> hybrid_parallel/

这个文件夹里面有两个用于训练的文件config.py 和train.py。

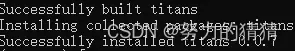

在训练之前我们需要安装好当前hybrid_parallel目录下的依赖:

pip install -r requirements.txt

接下来就是测试训练了:

colossalai run –nproc_per_node 4 train.py –config config.py

表示在当前节点上启动4卡训练,使用默认端口。

小编是在集群的服务器上测试的,所以通过slurm启动colossalai

这一步具体参考这篇文章:启动 Colossal-AI | Colossal-AI (colossalai.org)

文章出处登录后可见!