概率论知识

- Random Value

- 随机变量:

- 随机变量的观测值(没有随机性):

:随机变量

的定义域

- 随机变量:

- Probability Density Function:随机变量在某个确定的取值点附近的可能性

- 概率密度函数:

- 连续分布:

- 离散分布:

- 概率密度函数:

- Expectation:函数

的期望

- 期望:

- 连续分布:

- 离散分布:

- 期望:

- Random Sampling

- 随机抽样

强化学习专业术语

- state:状态

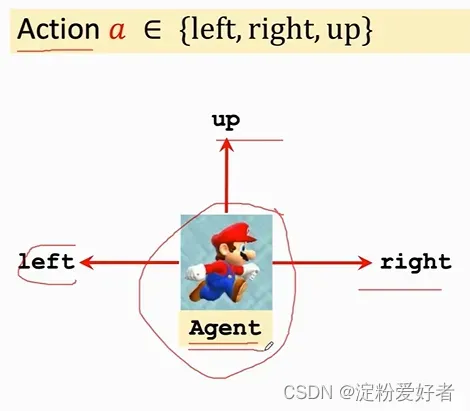

- action:动作

-

agent:动作的发出者

-

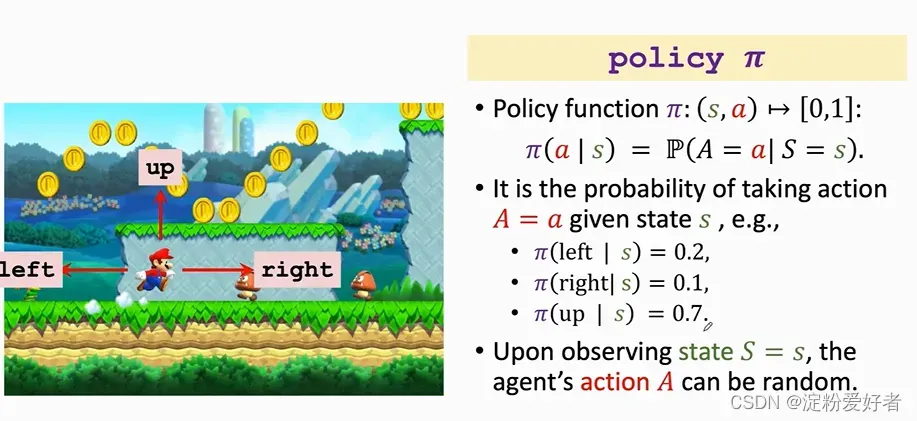

policy:策略

,根据观测到的状态做出决策来控制agent运动

- 强化学习学的就是policy函数

- agent动作随机,根据policy来做动作

-

reward:奖励

- agent做出一个动作后会得到一个奖励,通常需要自己定义

- 奖励定义的好坏十分影响强化学习的结果

- 强化学习的目标:获得的奖励总和尽量高

-

state transition:状态转移

- 当前状态下做出一个动作后转移到新的状态

- 状态转移可以是确定的也可以是随机的,通常是随机的(随机性来源于环境)

- 状态转移函数:

-

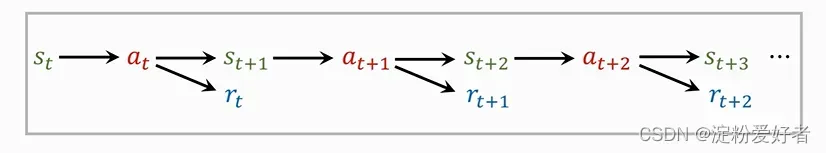

trajectory:轨迹 (state, action, reward)

-

-

agent与environment交互

- 环境给出当前state

- agent根据

做出动作

- 环境更新状态state为

,并给agent奖励

💡 状态、动作奖励等变量如果被观测到了就用小写字母表示,没被观测到就是随机变量用大写字母表示 - 环境给出当前state

强化学习的随机性来源

-

action

-

action是由policy函数随机抽样得到的

-

-

state transition

-

环境用状态转移函数

算出概率,用概率随机抽样得到下一个状态

-

Rewards, Returns & Value Fuctions

- Return:回报(aka cumulative future reward,即未来累计奖励)

时刻的回报

从

时刻的奖励开始一直加到结束

- 未来的奖励

没有现在的奖励

值钱→

的权重应低于

- Discounted return:折扣回报(aka cumulative discounted future reward)

:折扣率,

,超参数,需要自己调

- 未来的权重和现在一样:

- 奖励越不重要,

越小

- 未来的权重和现在一样:

时刻的折扣回报

- Value Function:价值函数

-

是随机变量,依赖于未来的所有动作

以及未来的所有状

-

Action-value Function:动作价值函数,与当前的状态

和动作

以及policy函数

有关

- 直观意义:已知policy函数

,

给当前状态下所有的动作

打分,从而得知动作的好坏

- 直观意义:已知policy函数

-

Optimal action-value function:最优动作价值函数,对

关于

求最大值,即选择使用让

值最大的

- 直观意义:观测到状态

后对动作

做评价,agent可以根据此对动作做出决策

- 直观意义:观测到状态

-

State-value function:状态价值函数,对

关于动作

求期望把

消掉,得到的

只与

和状态

有关

- 直观意义:

- 已知policy函数

,可以判断出当前的局势如何(状态越好数值越大)

- 判断policy函数

的好坏。

越好,

越大

- 已知policy函数

- 直观意义:

-

强化学习用AI控制agent

- Policy-based learning:策略学习,学习policy函数

,用

控制agent做动作

- 每观测到一个状态

,把

作为policy函数的输入,

函数输出每一个动作的概率

- 用得到的概率做随机抽样得到

- agent执行动作

- 每观测到一个状态

- Value-based learning:价值学习,学习最优价值函数

,用

控制agent做动作

- 每观测到一个状态

,把

作为

函数的输入,用

函数对每一个动作做评价,得到每一个动作的Q值

- 选择让

函数最大化的动作

作为下一个动作

:

- 每观测到一个状态

- 强化学习的任务就是学习

函数或

函数

- 强化学习的目的是学会怎样控制agent,让agent根据当前的状态

来做出相应的动作

,争取在未来得到尽量多的奖励

- 常用标准库:OpenAI Gym https://gym.openai.com/

文章出处登录后可见!

已经登录?立即刷新