本文项目学习并整理b站up炮哥带你学,欢迎各位共同讨论并学习。

后来在GitHub发现了相似代码的作者mikel-brostrom,github上面缺失yolov5部分的代码,需要自行补充,不过也可以用我放在最后的完整代码。还是很推荐大家去GitHub上学习这个项目

整理的代码与数据集放在最后。

目录

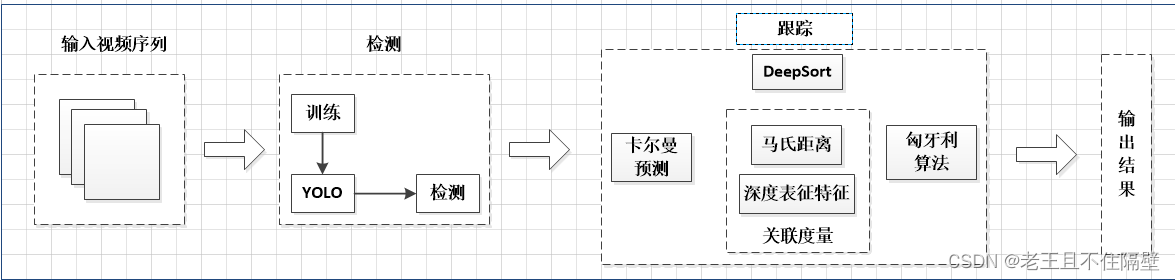

YOLOv5+DeepSort目标跟踪项目大致流程如下:

即分为检测和跟踪两部分,也就是说我们要训练出自己的检测权重和跟踪权重。

本文博客以训练跟踪行人为例(训练其他目标更换相应数据集即可)

1、用YOLOv5训练自己的检测模型

本文YOLOv5代码采用的YOLOv5_5.0版本,目前(2022.5.13)好像已经更新到了6.1版本。 如何训练YOLOv5的行人检测权重这里不做详细介绍,可以参考博主这篇博客炮哥带你学的博客,后面会提供一个行人权重,方便各位实现跟踪部分的训练。(补充一下:检测模型的好坏对后续的跟踪权重的影响还是很大,强烈推荐各位自己从头训练一个检测模型。这里检测模型作用,以行人跟踪为例,利用YOLOv5将视频序列的行人从背景中提取出来,提取的效果越好,当然对后面跟踪训练帮助越大。)

2、训练跟踪网络

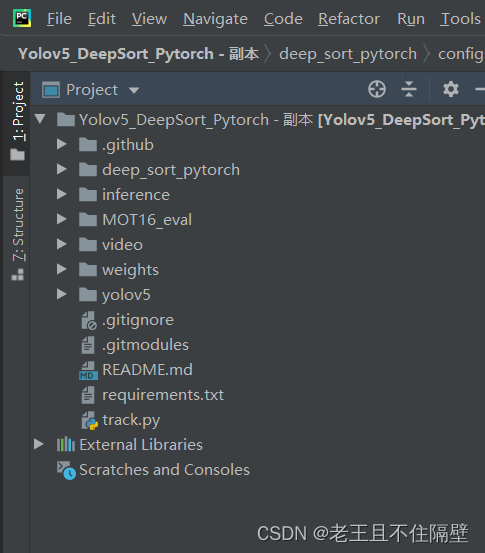

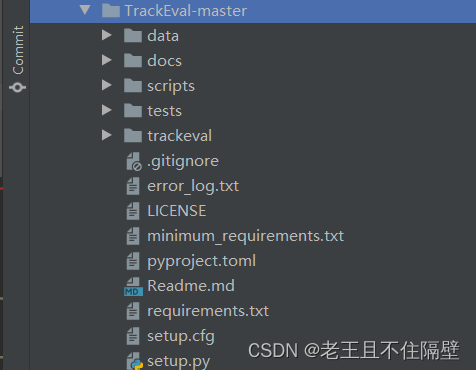

代码解压打开如下图:

文件夹介绍:

deep_sort_pytorch:跟踪训练部分的代码

inference:后续跟踪检测时保存结果的文件夹

MOT16_eval:评估MOT16数据的脚本

video:保存的测试视频

weights:保存的YOLOv5 5.0版本的权重

yolov5:yolov5相关的部分代码

2.1训练跟踪网络的数据集准备

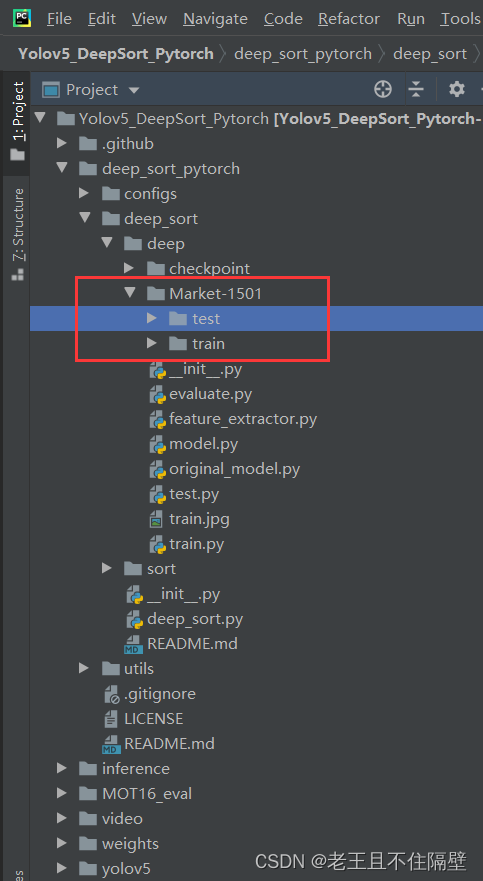

以Market-1501为例,该数据集包含了751个类别行人(即train和test文件夹下方各有751文件夹,下格式图仅写了'0002'为例子),按照下面方式存放数据集:(代码里会给出划分好的数据,想训练其他数据集按照下面格式存放图片就行)

–Market-1501

–test

–0002(0002是文件夹名称,下面存放视频连续帧的图片)

–train

–0002(0002是文件夹名称,下面存放视频连续帧的图片)

数据集在代码中的位置如图:

2.2利用数据集训练跟踪权重

在开始训练我们自己数据集的权重之前,我们打开pycharm左下角的命令终端,输入如下的命令pip install -r requirements.txt,就可以对相应环境安装了。

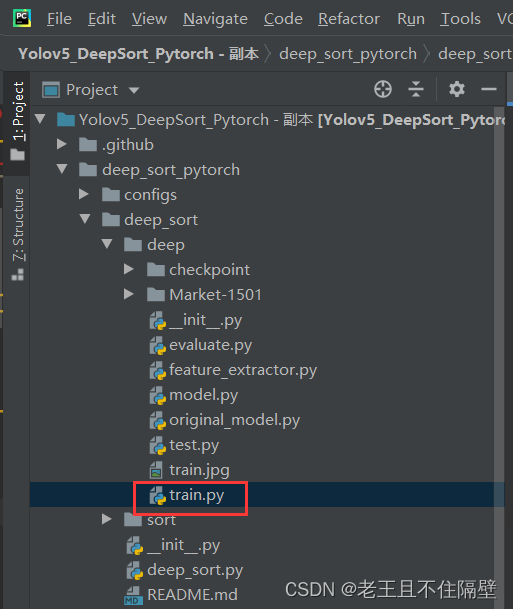

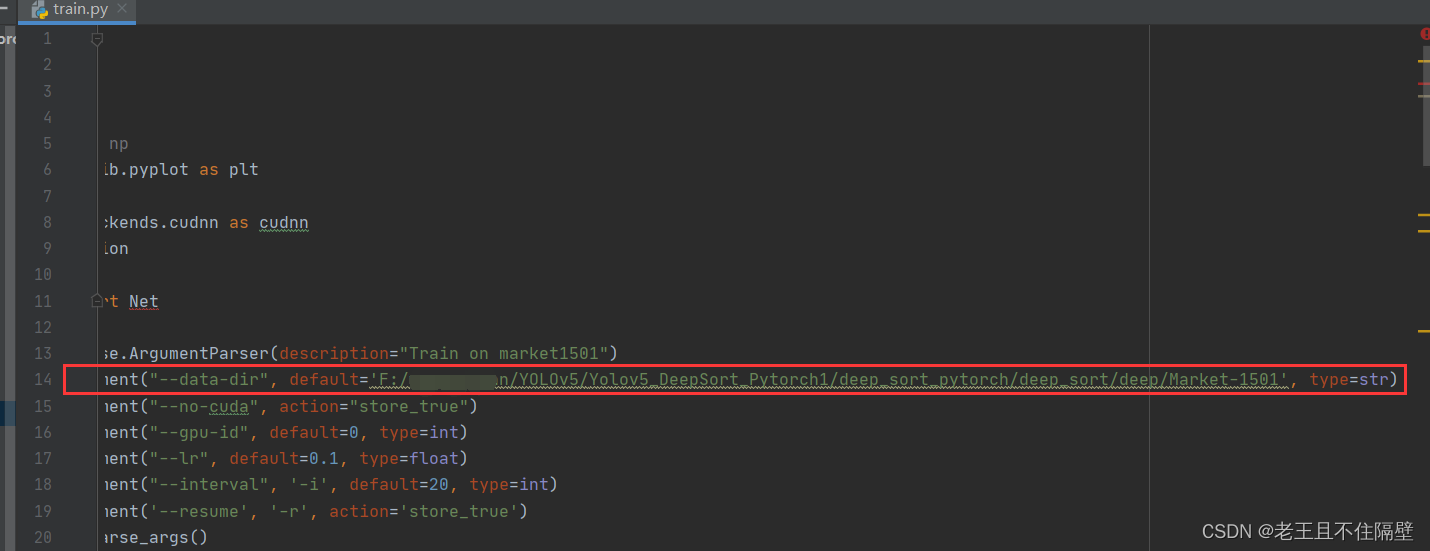

pip install -r requirements.txt所需的环境安装好了之后,在根目录打开deep_sort_pytorch/ deep_sort/ deep/ train.py文件

1、只需要修改该train.py下第14行代码,存放数据集路径,要放绝对路径。(其他参数默认就行)如下图

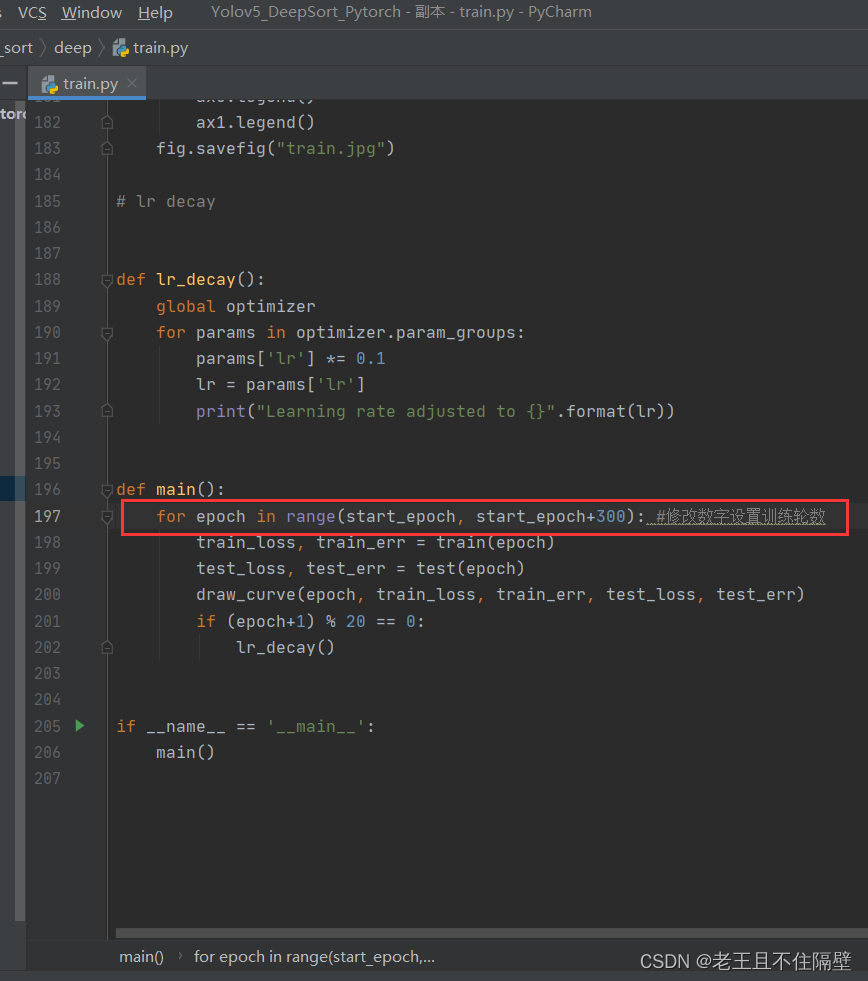

2、第197行,修改数字‘300’,改成自己训练的轮数。

3、然后直接运行train.py就可以训练了。训练结束后会在deep_sort_pytorch/ deep_sort/ deep/ checkpoint文件夹下生成一个跟踪权重ckpt.t7。(代码中附带了一个预训练跟踪权重)

3、利用训练的跟踪权重进行评估

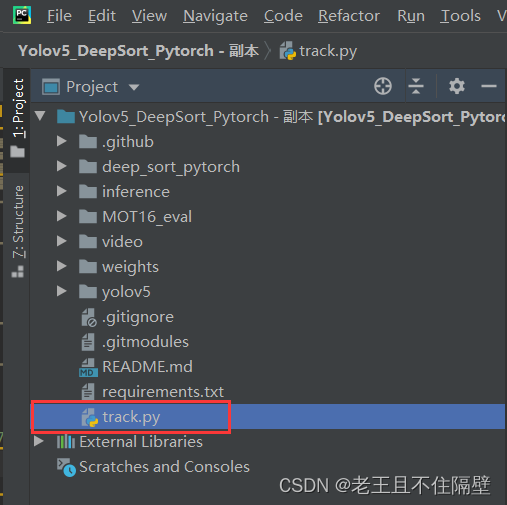

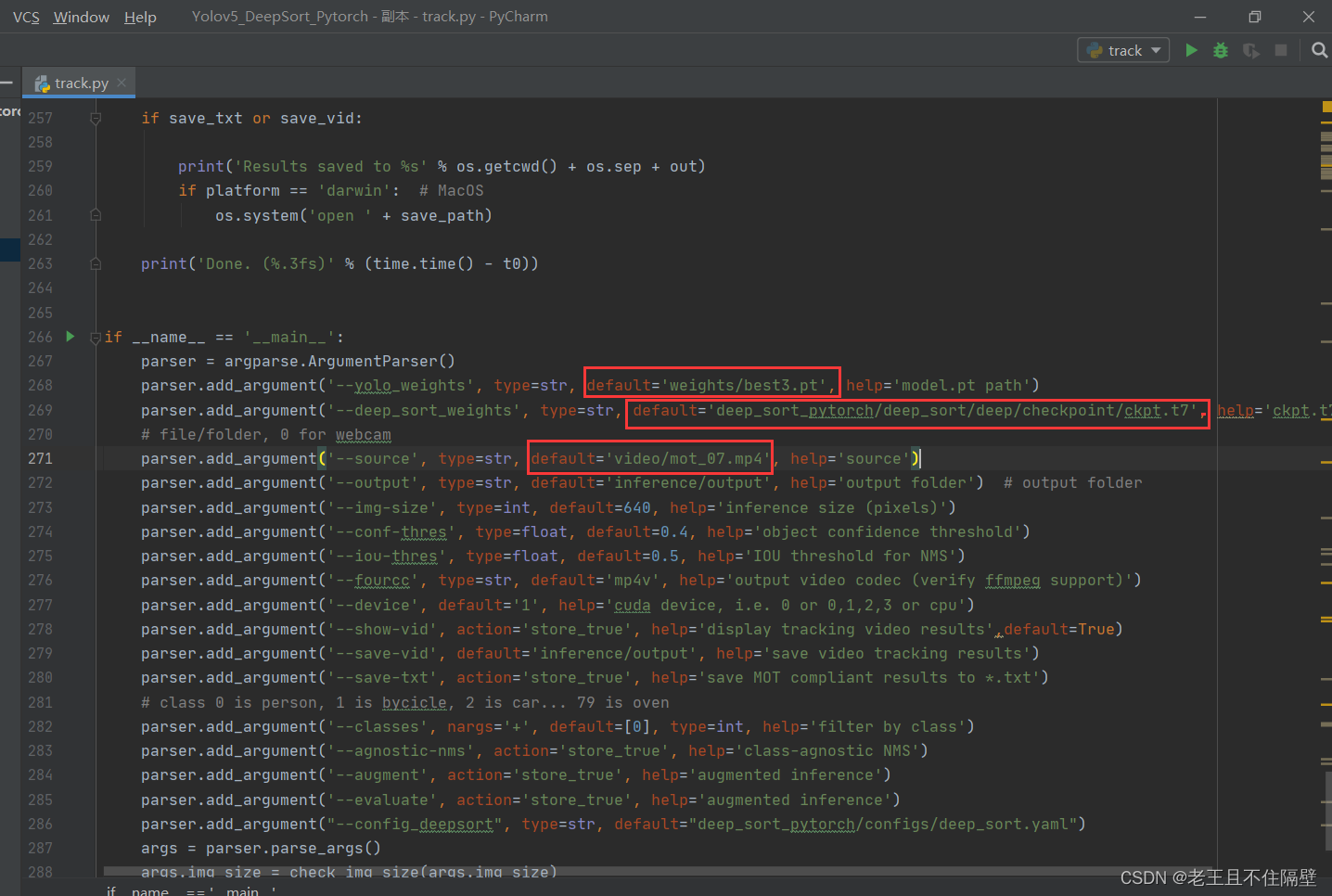

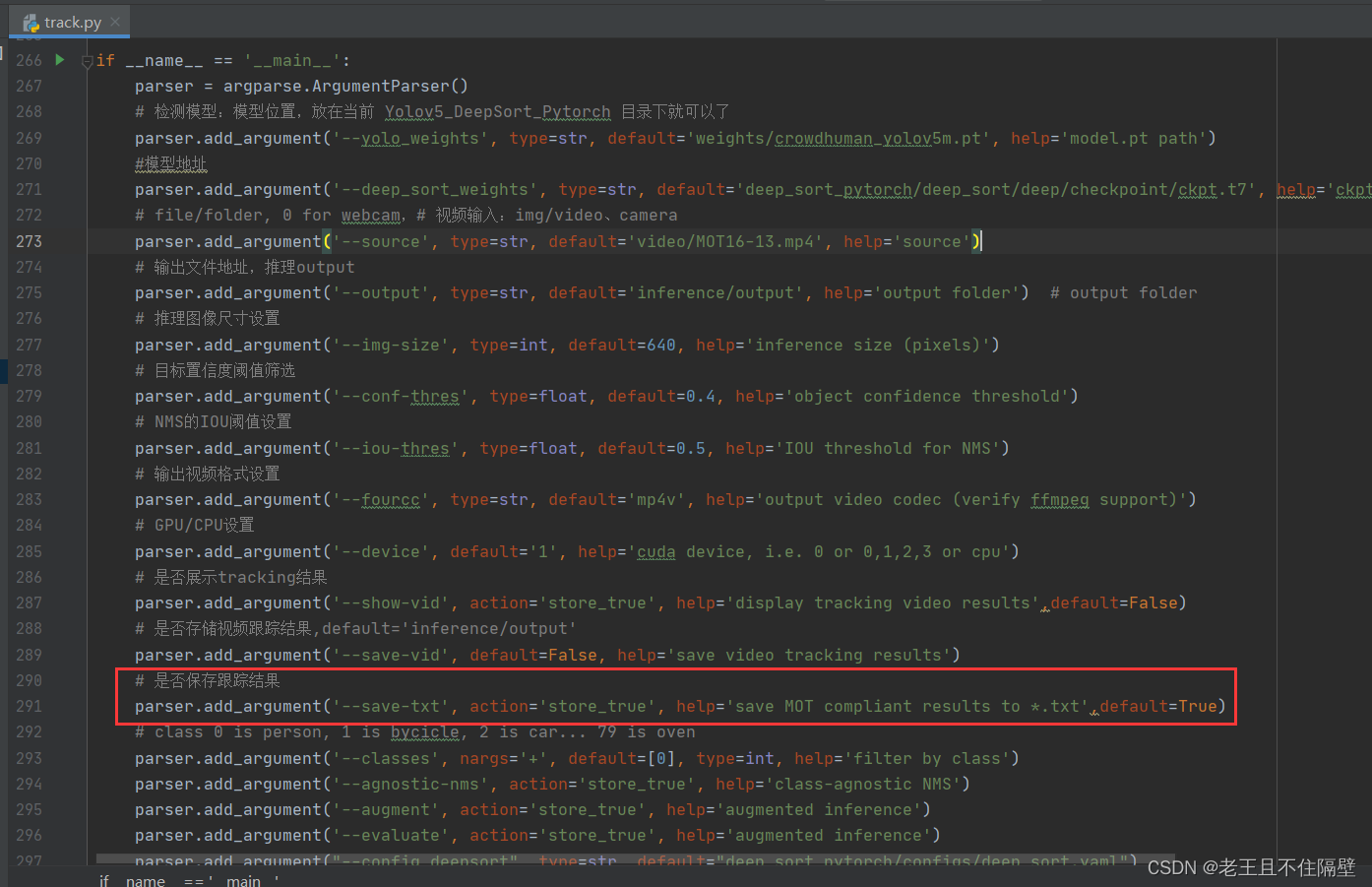

打开根目录下track.py.

修改权重路径和测试视频的路径,即可对视频流中的行人进行检测跟踪,并将检测结果保存。

如图,分别修改268行,设置YOLO权重路径;269行,设置跟踪权重的路径;271行,设置输入视频的路径。检测结果保存在根目录inference/output下。

3.1对MOT-16代码进行评估

代码自带了一个mot-16评估的脚本,感兴趣的小伙伴可以自行测试,这里不做过多赘婿。

需要安装GIT软件,安装好了需要配置一下,方法见博客实现pycharm运行.sh文件,配置好了之后在pycharm命令终端输入

./MOT16_eval/eval.sh 脚本命令应该是要下载MOT-16数据集,这个过程可能会很久,有兴趣的去原作者mikel-brostrom/GitHub研究。

这里给出一个参考其他博主的方法王定邦,大家可以参考一下。

需要准备两个部分:

1.下载TrackEval-master代码(后面我给出整理好的代码)

2.利用自己训练权重的跑出跟踪文件TXT文本(后面将展示如何保存)

3.1.1下载下载TrackEval代码

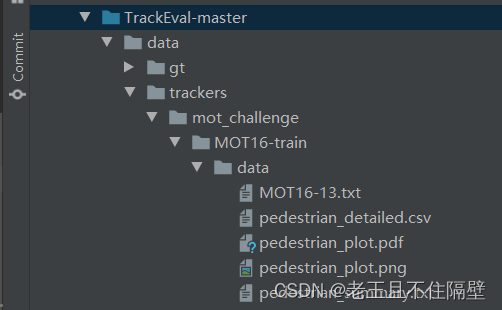

代码整体结构如下图:(这个代码是独立的,运行的时候TrackEval-master为根目录即可)

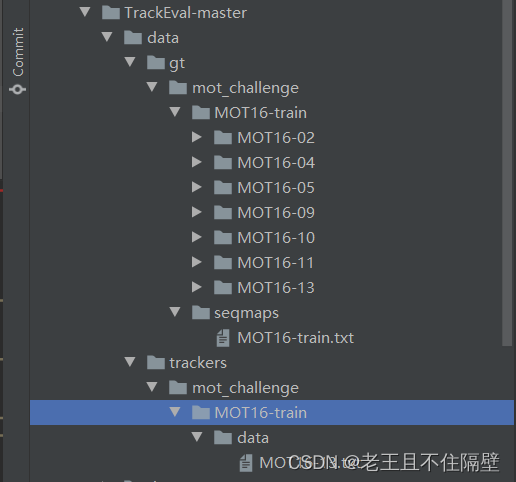

代码的data目录如下结构如下:

1、在data/gt/mot_challenge/下文件内容都是官方给出的数据,对视频中行人进行标定,可以理解为标准答案,不需要改动。

2、在data/trackers/mot_challenge/MOT16-train/data/下存放你跑MOT-16训练集视频得到的跟踪TXT文本。(下面会说明如何生成TXT文本)

3.1.2生成跟踪文本

在跑跟踪的track.py时,设置保存TXT文本即可,见下图画红框,最后添加:default=True

parser.add_argument('--save-txt', action='store_true', help='save MOT compliant results to *.txt',default=True)

比如我track.py跑的MOT16-13的视频,就会在目录的inference/output下生成一个MOT16-13.txt的文本,依次跑完7个训练视频(视频我会放在最后),可得到7个txt文件(需要自己跑代码生成),将得到的txt文件放在data/trackers/mot_challenge/MOT16-train/data/下即可(3.1.1节提到的),准备工作就完成了。

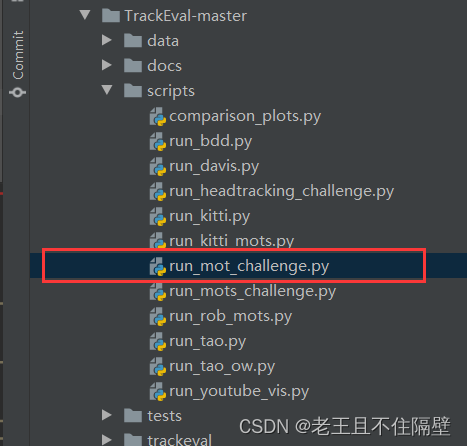

3.1.3得到MOT16训练集跟踪结果

打开scripys/run_mot_challenge.py,直接运行即可。

同时,得到的结果也可在data/trackers/mot_challenge/MOT16-train/data/下查看(即我们刚刚存在自己跑出来跟踪txt文本目录下)

TrackEval-master代码链接:

https://pan.baidu.com/s/1HrZZO74qUXXVg5aeZ9MKdQ?pwd=5555

提取码:5555

MOT16训练集视频链接:https://pan.baidu.com/s/1e64qRvysIbstIY3FMK3Zow?pwd=5555&_at_=1658213501964

提取码:5555

(PS:这个视频是我用MOT16训练集照片自己合成的,帧率根据官网给的)

下面的代码包括:

YOLOv5 5.0权重(weight文件中):best3(检测行人权重)、yolov5s(官方自带权重)

跟踪权重:ckpt.t7(deep_sort_pytorch/ deep_sort/ deep/ checkpoint文件夹下)

Market-1501数据集(划分好的):在deep_sort_pytorch/ deep_sort/ deep下

链接:https://pan.baidu.com/s/1eanZEuFTaA39ZTo5J7JuIA?pwd=5555&_at_=1652499323482

提取码:5555

文章出处登录后可见!