简介

👨💻个人主页:@云边牧风

👨🎓小编介绍:欢迎来到云边牧风破烂的小星球🌝

📋专栏:Python课程

🔑本章内容:CNN卷积神经网络

记得 评论📝 +点赞👍 +收藏😽 +关注💞哦~

目录

摘要

1. 引言

1.1 研究背景和意义

1.2 报告结构

2. 卷积神经网络(CNN)简介

2.1 CNN基本原理

2.2 CNN的优势和应用领域

3. 矩阵在CNN中的应用

3.1 图像表示与卷积运算

3.2 特征提取与矩阵分解

3.3 参数优化与梯度计算

3.4 图像生成与矩阵合成

4. 矩阵运算在CNN设计与优化中的启发

4.1 模型参数组织与计算优化

4.2 矩阵分解与特征选择

4.3 并行计算与加速技术

4.4 矩阵运算与推理硬件的关系

5. 实际应用案例

5.1 图像分类与目标检测

5.2 人脸识别与姿态估计

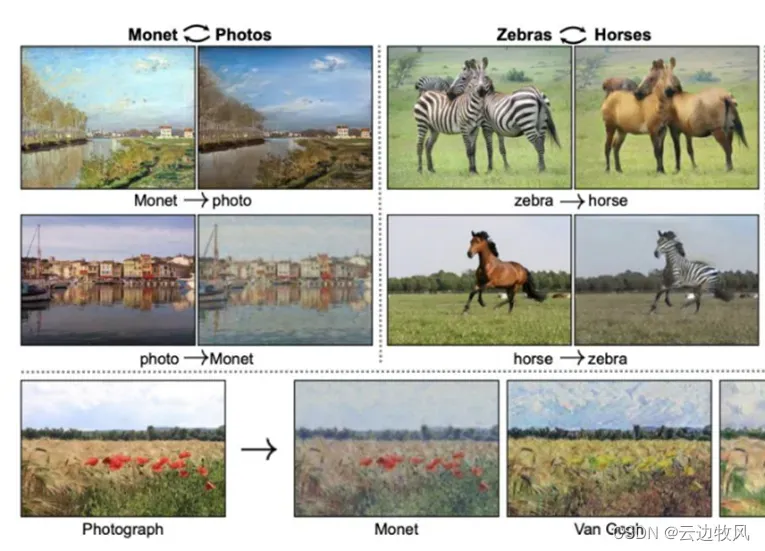

5.3 图像生成与风格迁移

6. 挑战与未来展望

6.1 计算效率与模型规模

6.2 鲁棒性与对抗性攻击

6.3 深度学习与矩阵运算的融合

7. 结论

参考文献

摘要:

我此次调研对矩阵及其运算在卷积神经网络(CNN)中的应用与启发进行了深入的学习和分析。通过调查和总结相关文献和研究成果,我们发现矩阵和其运算在卷积神经网络(CNN)中扮演着关键的角色,在对于图像处理和计算机视觉任务具有重要意义。本报告阐述了矩阵在卷积神经网络(CNN)中的各种应用场景和技术,同时学习了矩阵运算在CNN中的数学原理,最后我们一起探讨了矩阵运算在CNN设计和优化中的启发。

关键词:矩阵;数学原理;卷积神经网络;CNN;应用与启发;机器学习

Abstract:Our group conducted in-depth learning and analysis of the application and inspiration of matrices and their operations in convolutional neural networks (CNNs). By investigating and summarizing relevant literature and research results, we find that matrices and their operations play a key role in convolutional neural networks (CNNs) and are of great significance for image processing and computer vision tasks. This report describes various application scenarios and techniques of matrix in convolutional neural networks (CNNs), and learns the mathematical principles of matrix operations in CNNs, and finally discusses the inspiration of matrix operations in CNN design and optimization.

Keywords: matrix; Principles of mathematics; convolutional neural networks; CNN; Application and inspiration; machine learning

1.引言

随着近年来深度学习的快速发展,卷积神经网络(CNN)已经成为图像处理和计算机视觉领域的重要技术。CNN通过层层堆叠的神经元网络,能够自动学习和提取图像中的特征,从而在图像分类、目标检测、人脸识别等任务中取得了显著的成果[1]。而在CNN的实现过程中,矩阵及其运算发挥着重要的作用,并在CNN的设计和优化中提供了重要的启发。

矩阵作为一种数学工具,广泛应用于数据表示、线性代数和优化等领域。在卷积神经网络中,矩阵被用来表示和处理图像数据,通过矩阵乘法、卷积运算等操作,实现了对图像特征的提取和表示。此外,矩阵运算还能够为CNN模型的参数优化、梯度计算等关键步骤提供高效和可扩展的算法。

本调研报告旨在深入探讨矩阵在CNN中的各种应用场景和技术,同时探讨矩阵运算在CNN设计和优化中的启发。通过对相关文献和研究成果的调查和分析,我们将介绍矩阵在图像表示、特征提取、参数优化、图像生成等方面的具体应用,并探讨其对CNN性能和效果的影响。

矩阵及其运算在CNN中的应用与启发是近年研究的热点之一,具有重要的理论和实践意义。通过对矩阵在CNN中的深入学习,我们讨论如何为图像处理和计算机视觉领域的发展带来新的突破和进步提供学生们的启发。

-

- 研究背景和意义

研究背景:

(1) 矩阵作为一种重要的数学工具,广泛应用于数据表示、线性代数和优化等领域。矩阵运算在表示和处理图像数据时具有重要的作用,使得卷积层、池化层等核心模块的操作更加高效[2]。

(2)近年来,卷积神经网络(CNN)作为一种强大的深度学习模型,取得了在图像处理和计算机视觉领域的显著成果。CNN能够学习和提取图像中的特征,并在图像分类、目标检测、人脸识别等任务中取得优秀的性能。

研究意义:

(1)矩阵在CNN中的应用具有重要的意义。通过矩阵表示和运算,可以将图像数据转化为二维结构,从而更好地进行卷积、池化、矩阵分解等操作,有效提取和表示图像中的关键特征。

(2)学习矩阵运算在CNN中的应用可以为图像处理和计算机视觉任务提供更高效、更准确的方法和技术。深入理解和应用矩阵运算可以帮助改进CNN模型的设计和优化,提升算法的性能和效率。

(3)探索矩阵在CNN设计和优化中的启发,有助于推动深度学习和机器学习领域的发展。矩阵运算的相关技术和优化算法能够为CNN的训练和推理提供指导,进一步推动相关研究的进展和创新。

(4)随着深度学习的不断发展,对于大规模图像数据和复杂计算任务的处理需求越来越高。研究矩阵及其运算在CNN中的应用与启发,有利于在计算效率、模型规模、以及算法稳定性等方面解决当前面临的挑战。

- 报告结构

我们小组在确定调研内容后,决定分工开展,此次调研报告的结构正如目录所示,通过引言部分简要介绍我们的调研主题、调研的背景和意义,随后用数学角度解析卷积神经网络(CNN)的原理,进而拓展到CNN的具体技术和应用,比如卷积运算、矩阵分解、梯度计算、矩阵合成,从数学原理让大家更加深入理解矩阵在提取特征值上的优势,然后是矩阵用在CNN上的具体运用:图像分类与目标检测、人脸识别和图像生成等,最后我们将对矩阵在CNN中的挑战与未来展望发表我们小组的结论和启发。

2.卷积神经网络(CNN)简介

2.1 CNN基本原理

卷积神经网络(convolutional neural network, CNN),是一种专门用来处理具有类似网格结构的数据的神经网络。例如时间序列数据(可以认为是在时间轴上有规律地采样形成的一维网格)和图像数据(可以看作是二维的像素网格)。卷积网络在诸多应用领域都表现优异。“卷积神经网络’’ 一词表明该网络使用了卷积(convolution)这种数学运算。卷积是一种特殊的线性运算。卷积网络是指那些至少在网络的一层中使用卷积运算来替代一般的矩阵乘法运算的神经网络。

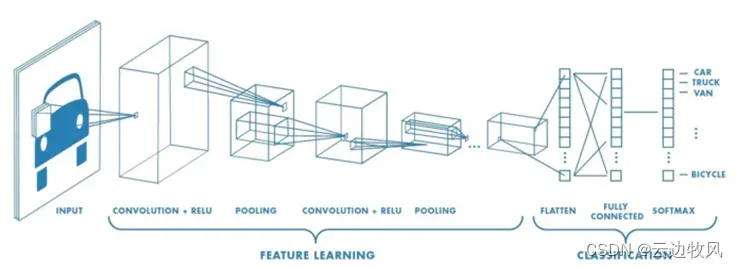

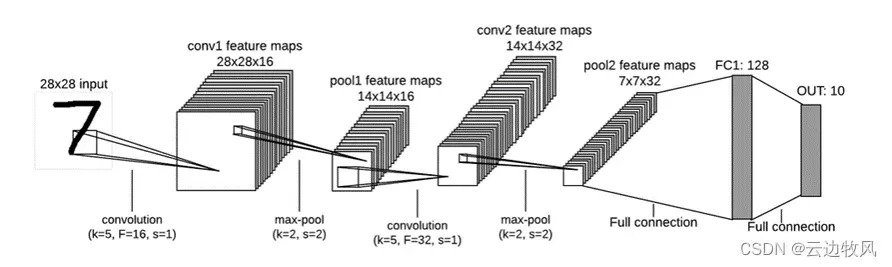

一个卷积神经网络是由输入层(Input)、卷积层(Convolution)、池化层(Pooling)、全连接层(Fully Connected) 组成。在输入层输入原始数据,卷积层中进行的是前面所述的卷积过程,用它来进行提取特征。全连接层就是将识别到的所有特征全部连接起来,并输出到分类器(如Softmax)后进行训练和测试.

图2-1 卷积神经网络结构

- 输入层

即输入的图片等数据。

(2)卷积层

卷积层是卷积网络中最为重要的部分。和传统全连接层不同,卷积层中每一个节点的输入只是上一层神经网络的一小块,这个小块常用的大小有3 * 3或者5 * 5,卷积层会增加原始节点的深度。通常卷积层这部分被称为过滤器(filetr)或者卷积核(kernel)。

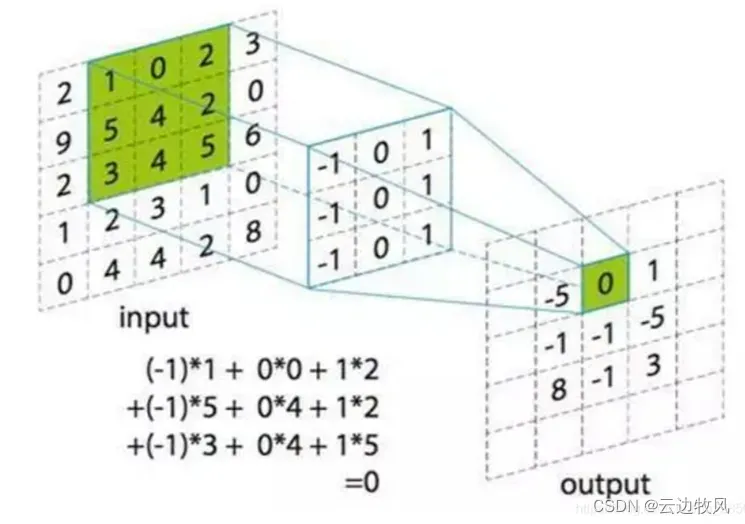

使用过滤器做卷积计算:

在输入矩阵中选取和过滤器一样大小的数据,进行卷积计算,即求对应位置的乘积和。这个乘积和即为卷积计算的输出值。

以此为例,我们在5 * 5原图上选取一个3 * 3的区域,每次移动一格,那么输出就是3 * 3的矩阵。这个一格,就是步长。如果我们把步长设为2,那么输出就是2 * 2的矩阵。

每一个卷积层中卷积核的参数都是一样的,这就巨幅减少了网络结构中的参数量。假设我们卷积核的尺寸为5 * 5,深度为16(可以理解为16个不同的5 * 5的而为过滤器),那么这一层的参数就是5 * 5 * 3 * 16 + 16 = 1216个。倘若我们使用全连接神经网络,一个32 * 32 * 3的输入,在第一层有200个隐藏节点,那么就需要32 * 32 * 3 * 200 + 200 = 614600个参数。

图2-2卷积计算示意图

步长和padding(填充)

前面可以看到,大小为5×5的矩阵与大小为3×3的滤波器进行卷积运算,得到的结果是大小为3×3的矩阵。假设矩阵的大小为n×n,而滤波器的大小为f×f,f一般是个奇数,则卷积后结果的大小就为(n−f+1)×(n−f+1)。(相当于去除了图像最外面一圈的像素)

卷积计算过程中,原来的矩阵与滤波器进行卷积后的结果中损失了部分,每经过一次卷积计算,原数据都会减小。可以使用padding对原矩阵填充。

在进行卷积操作前,在原矩阵的边界上填充一些值,以增加矩阵的大小,通常都用“0”作为填充值。

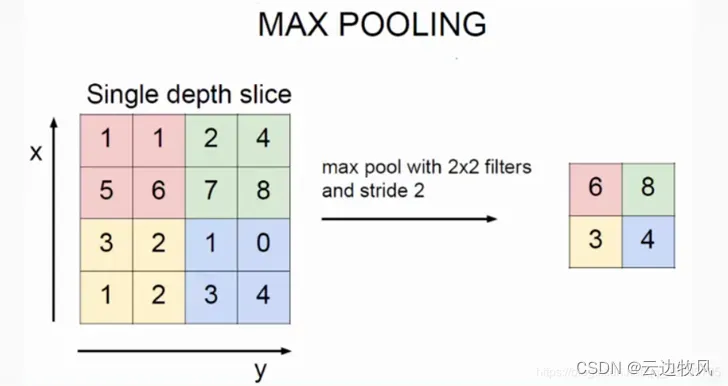

- 池化层(pooling)

图2-3 池化层位置

池化层用于卷积层中间,可以有效的缩减矩阵的尺寸,进一步减少参数量,加快运算并防止过拟合。

池化层神经网络不会改变三维矩阵的深度,但是它可以缩小矩阵的大小。池化操作可以认为是将一张分辨率较高的图片转化为分辨率较低的图片。通过池化层,可以进一步缩小最后全连接层中节点的个数,从而达到减少整个神经网络中的参数的目的。

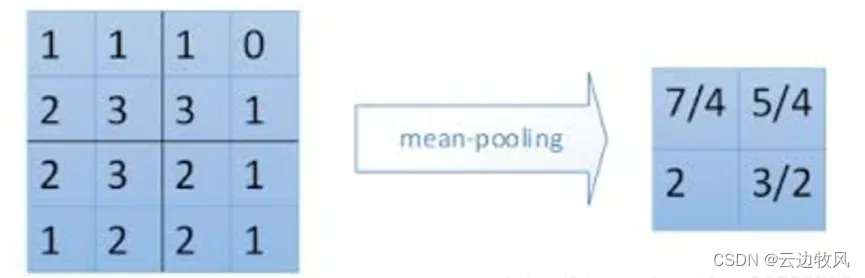

池化层的使用类似于卷积层,它规定一个窗口大小,比如2 * 2, 然后将输入中每2 * 2的区域用一个值来代替。

最大池化层(max pooling) 使用最大值操作,是被使用得最多的池化层结构。

图2-4最大池化层

平均池化层(average pooling) 使用平均值操作。

图2-5最大池化层

我们可以将卷积层和池化层看成自动图像特征提取的过程。

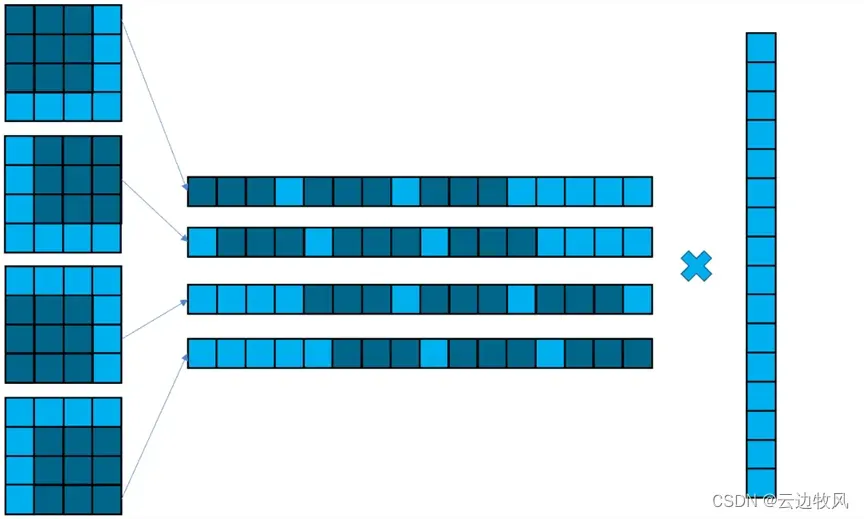

(4)全连接层

经过若干层卷积和池化之后,我们需要全连接层来进行最后的分类。全连接层(fully connected layers,FC) 在整个卷积神经网络中起到“分类器”的作用。

(5)softmax函数

softmax位于卷积神经网络层的最后一层,用于分类问题。

softmax的输入是T * 1的向量,输出也是T * 1的向量,只不过输出的向量的每个值的大小范围为0到1。softmax的输出向量就是该样本属于各个类的概率。

(6)训练

利用反向传播算法来更新过滤器权重,最小化损失函数,使模型在训练数据上表现好。

(7)测试

在测试数据上评估模型的表现能力,如分类准确率。

所以总体来说,CNN就是通过卷积层提取本地连接特征,池化层降维,全连接层分类,通过反向传播训练模型来实现图像分类或目标检测等任务。

2.2 CNN的优势和应用领域

卷积神经网络(CNN)在本质上是一种输入到输出的映射,它能够学习大量的输入与输出之间的映射关系,而不需要任何输入和输出之间的精确的数学表达式,只要用已知的模式对卷积网络加以训练,网络就具有输入输出对之间的映射能力。

CNN一个非常重要的特点就是头重脚轻(越往输入权值越小,越往输出权值越多),呈现出一个倒三角的形态,这就很好地避免了BP神经网络中反向传播的时候梯度损失得太快。此外CNN的核心优势在于具有强大的特征提取能力。它通过多层次的卷积和池化操作,可以自动学习和提取输入数据如图片中的空间结构特征,如边缘、颜色等。这比传统机器学习手工设计特征效果更好。此外,CNN采用的参数共享机制,每个过滤器在整个输入区域都使用相同的权重,大大减少了模型参数数量。同时,卷积运算具有很强的并行计算能力,能够充分利用GPU等硬件加速计算,提高训练速度。

卷积神经网络CNN主要用来识别位移、缩放及其他形式扭曲不变性的二维图形。由于CNN的特征检测层通过训练数据进行学习,所以在使用CNN时,避免了显式的特征抽取,而隐式地从训练数据中进行学习;再者由于同一特征映射面上的神经元权值相同,所以网络可以并行学习,这也是卷积网络相对于神经元彼此相连网络的一大优势。卷积神经网络以其局部权值共享的特殊结构在语音识别和图像处理方面有着独特的优越性,其布局更接近于实际的生物神经网络,权值共享降低了网络的复杂性,特别是多维输入向量的图像可以直接输入网络这一特点避免了特征提取和分类过程中数据重建的复杂度。

基于这些优点,CNN广泛应用于各类图像和视频处理任务。比如图像分类任务,如图片识别、物体识别等;目标检测任务,如人脸检测、车辆检出等;图像分割任务,如语义分割、实例分割等。此外,CNN也在图像生成任务中表现出色,如图片生成、风格迁移等。除此之外,CNN在医学影像分析中用于CT、MRI图像识别诊断,也在远程传感数据处理中用于航拍图像处理等方面都有很好的效果。总体来说,只要问题涉及到图像和视频等结构化数据的特征学习,CNN模型都能很好地解决。它已经成为计算机视觉、语音识别等领域的主流技术。

- 矩阵在CNN中的应用

3.1 图像表示与卷积运算

图像作为计算机视觉任务重要的输入数据,其表示方法直接影响后续算法的效果。传统上,图像以像素矩阵的形式表示,每个元素代表对应位置像素的颜色强度,但忽略了像素间的空间结构关系。卷积神经网络(CNN)通过矩阵形式的图像表示和多次卷积运算,很好地解决了这个问题。

在CNN中,图像使用矩阵进行表示。每个矩阵元素对应图像中的一个像素,这样很好地保留了像素位置的空间信息。这种表示方法具有以下优势:

1. 简洁明了,与图像本身对应,方便理解和处理。

2. 充分利用计算机的矩阵运算能力,高效地提取和表示图像特征。

3. 易于描述和实现卷积等操作,利用矩阵计算加速算法。

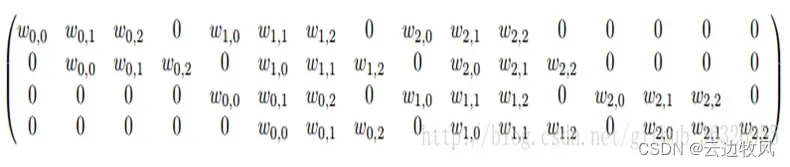

本部分讨论矩阵在图像表示与卷积运算方面的关系,而卷积可以写成矩阵乘法:

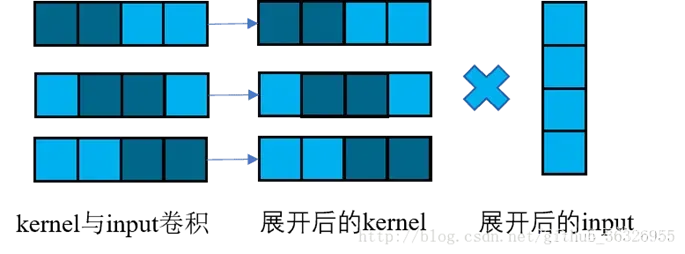

图3-1

在上面这张图中,阴影表示的是kernel,按理说我们展开kernel应该是9个元素。但是在这里,我们展开kernel的方式是,把kernel放在input上,按照input的尺寸展开。这样以来,空余的部分(就是图1展开后的kernel中浅蓝色没有加阴影的部分)就写成0。0与任何数乘积为0。这样每一步的卷积,相当于展开后的kernel的对应的一行与展开的input的矩阵乘积。

令展开后的kernel矩阵为C,那么C用数学的表达方式写成:

这样,矩阵卷积可以写成:

上标 flat表示将矩阵展平为一维向量。

那么,对于有填充的卷积,该怎么办呢?

事实上,对于有填充的卷积,相当于对input进行了扩展,得到了input_extend,然后我们对input_extend与kernel再次运用上面的原理进行计算。

在很多计算平台中,例如tensorflow,matlab等,我们就是通过矩阵乘法来计算卷积的。基本原理就是上面说的东西,只是在具体的实现中,还需要处理一些细节上的问题。

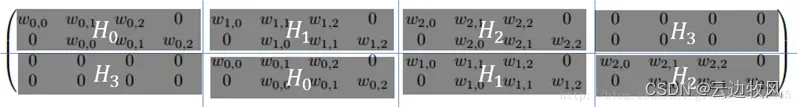

在上面的这个C矩阵中,我们可以做这样的一个分割:

我们看到每一个子块Hi都是一个循环矩阵(circulant matrix),而整个矩阵则是这些子块的循环矩阵。因此我们把这样的矩阵叫做双块循环矩阵(doubly block circulant matrix)。

上述研究的是二维情况,接下来,是一维情况。加入input为1×4,kernel为1×2:

图3-2

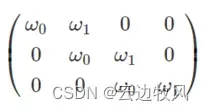

这时,对应C矩阵为:

这个矩阵也是一个循环矩阵,但是,除此之外,还可以注意到,它与对角线平行的每一条线上的元素都是相同的。这样的矩阵叫做托普勒斯矩阵(Toeplitz matrix)。总而言之,离散卷积可以被认为是矩阵的乘法。

CNN采用多个小尺寸滤波器矩阵进行多次与图像矩阵的卷积运算。这相当于一个局部连接的神经网络,可以有效捕获图像局部区域的特征信息。不同于全连接网络,卷积运算保留了输入和输出数据之间的部分空间结构关系,更适用于处理二维结构的数据如图像。

卷积运算的本质是滤波器矩阵与图像矩阵进行点乘求和运算,具有以下优势:

1. 这实现了局部连接,有效捕获空间结构信息。

2. 矩阵乘法运算速度快,支持大规模并行计算。

3. 矩阵框架统一了卷积的描述和实现,简化模型设计。

这种矩阵乘法运算可以提取图像不同区域的特征,且具有一定的平移不变性。随后的池化层对特征图进行下采样,进一步增强了平移不变性,提升模型的泛化能力。通过重复进行卷积和池化运算,CNN可以逐层提取图像从低级特征到高级结构的表示。

矩阵在CNN中的应用很好地解决了图像表示和特征提取中的问题。它通过矩阵运算提取图像空间结构中的信息,为CNN在计算机视觉任务中的广泛应用奠定理论基础。矩阵运算可以捕获图像局部特征,且具有一定的平移不变性。池化层增强了这个属性,提升了模型的泛化能力。CNN重复使用这种矩阵运算机制,实现了从低级特征到高级结构的多层表示提取。这就是CNN在视觉识别等任务上优于传统机器学习方法的重要原因。

3.2 特征提取与矩阵分解

卷积神经网络(CNN)作为一种深度学习模型,广泛应用于计算机视觉任务中。CNN成功的重要原因之一是采用矩阵运算实现特征提取。图像作为矩阵进行表示,滤波器也以矩阵的形式存在。通过滤波器矩阵与图像矩阵的卷积运算可以有效提取图像特征。此外,矩阵分解也在CNN模型的优化与压缩中发挥重要作用。

在CNN中,图像以矩阵的形式表示,每个元素对应一个像素点,这种表示方式保留了图像空间结构信息。CNN使用多个小尺寸滤波器矩阵进行卷积运算,这相当于一个局部连接神经网络,可以有效提取图像局部区域的低级特征,如颜色、边缘等。随后的池化层对特征图进行下采样,提取出更高级的结构特征。通过重复卷积和池化运算,CNN可以逐步提取图像各层次的特征表示。矩阵运算使CNN具有很强的特征学习能力。

此外,矩阵分解技术也在CNN模型优化中发挥重要作用。例如奇异值分解(SVD)可以分解卷积核矩阵,提取其主要成分,从而压缩模型规模。低秩分解可以近似原始矩阵,大幅减少参数数量,同时保留重要信息。这有利于加速模型 inference 速度,也可以防止过拟合。同时,矩阵分解还可以实现滤波器的可视化,帮助理解卷积核学习到的特征。

总之,矩阵运算机制赋予了CNN在特征学习和模型优化上的强大能力。它通过卷积提取多层特征表示,又利用矩阵分解技术实现了模型压缩。

3.3 参数优化与梯度计算

卷积神经网络(CNN)作为一种深度学习模型,广泛应用于计算机视觉任务。CNN成功的一个重要原因是采用了基于矩阵运算的梯度下降算法进行参数优化。

在CNN模型训练中,我们需要优化卷积层和全连接层中的参数,以最小化损失函数。传统上,这通过反向传播算法计算参数对损失函数的梯度,并使用梯度下降法更新参数来实现。CNN将卷积层视为矩阵乘法,这使得通过矩阵计算来实现反向传播和梯度计算变得可能。

具体来说,卷积层可以看作是输入特征图矩阵与卷积核矩阵的乘积加偏置项。利用矩阵微分的规则,我们可以直接计算出卷积核矩阵和输入特征图矩阵对损失函数梯度的导数。这种矩阵运算带来的优势是:

和传统循环实现相比,矩阵运算速度更快;

2. 易于对整个卷积层进行批处理。

除此之外,CNN中参数的稀疏性也可以利用矩阵运算加快训练。例如,利用卷积核矩阵的稀疏性,可以只更新非零项对应的梯度,大幅减少计算量。此外,一些优化技术如批标准化也可以看作是对特征图矩阵进行变换,从而利用矩阵计算实现。

总之,矩阵运算为CNN在参数更新和梯度计算中带来了重要优势。它不仅提高了效率,还统一了框架,使得CNN模型的训练可以利用矩阵的平行计算能力。这是CNN在深度学习领域广泛应用的重要理论基础。

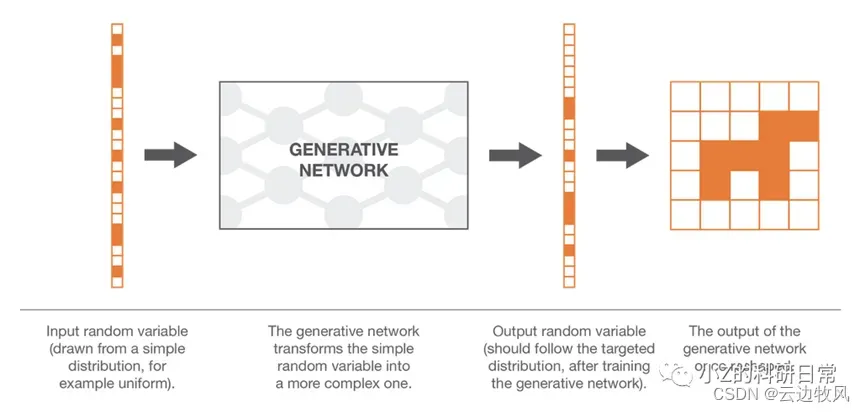

3.4 图像生成与矩阵合成

卷积神经网络(CNN)在计算机视觉任务中表现出色,同时也开始应用在图像生成任务中。这得益于CNN利用矩阵运算描述图像与提取特征的能力。

在图像生成任务中,CNN通过矩阵运算实现生成模型的设计。生成模型以矩阵形式描述图像,每个元素对应一个像素点。生成网络学习映射函数,将低维随机噪声向量映射成这种矩阵表示的图像。这种矩阵框架下,生成网络可以看作多层矩阵变换,最终输出目标分布的样本。

具体来说,生成网络通过一系列卷积层和全连接层实现随机向量到图片矩阵的转换。其中,卷积层看作是输入特征图矩阵与滤波器矩阵的乘积,可以提取并合成不同级别的特征。随后的上采样层通过矩阵插值实现特征图的放大,逐步重构原始图片矩阵。这种端到端的矩阵变换学习图像内在分布,生成真实样本。

此外,矩阵运算也在GAN等对抗生成模型中发挥重要作用。例如,判别器可以看作一个分类器,通过串联卷积层对输入图片矩阵进行编码,输出概率矩阵,判断图片真假。生成器学习生成能过关的图片,与判别器进行对抗游戏。这种矩阵描述极大简化了模型设计。

总之,矩阵为CNN在图像生成任务中提供了统一且高效的解决框架。它描述了图像与学习目标的数学形式,利用矩阵运算实现了端到端的生成学习,在保留空间结构信息的同时,极大提高了生成模型的效率。

4. 矩阵运算在CNN设计与优化中的启发

4.1 模型参数组织与计算优化

深度学习技术是人工智能领域的热门话题,它已被广泛应用于图像识别、自然语言处理等各种领域。在深度学习中,参数调整和模型优化是非常关键的环节,它们直接影响到模型的性能和效果。以下是一些深度学习技术中的参数调整与模型优化方法,来理解如何通过调整参数和优化模型来提升深度学习的性能。

参数调整是指在深度学习模型中所使用的权重和偏置等可调整的参数的调整过程。深度学习模型中通常有大量的参数,因此如何合理地调整这些参数对于模型的训练和性能至关重要。

首先,我们可以通过使用合适的初始化方法来设置模型的参数初始值。常见的初始化方法包括正态分布、均匀分布和零初始化等。合适的初始值有助于减少网络训练的时间和提高模型收敛的速度。

其次,我们可以调整学习率来控制参数的更新速度。学习率直接决定了模型参数在每次迭代中的更新量,过大或过小的学习率都会影响模型的性能。通常,可以通过学习率衰减或动态调整的方式来逐渐减小学习率,以避免参数更新过快而导致模型无法收敛或收敛速度过慢。

此外,优化器的选择也对参数调整起着重要作用。常用的优化器包括随机梯度下降(SGD)、Adam、Adagrad等。这些优化器具有不同的特点和适用场景,通过选择合适的优化器可以提高模型的收敛速度和性能。对于深度学习中的模型优化方法,主要包括正则化、批标准化和梯度剪裁等。

正则化是一种常用的模型优化方法,它通过在损失函数中添加正则化项来控制模型的复杂度。常见的正则化方法包括LI正则化和L2正则化。正则化可以有效地避免模型过拟合的问题,从而提高模型的泛化能力。

批标准化是一种用于深度学习模型的优化技术。它通过对每一层的输入进行归一化处理,使得模型更加稳定且易于训练。批标准化能够加速模型的收敛速度,同时也有助于避免梯度消失和梯度爆炸等问题。

梯度剪裁是一种常用的防止梯度爆炸问题的优化方法。在深度学习中,由于网络层数的增加,梯度往往会变得非常大,导致模型无法正常训练。梯度剪裁通过限制梯度的范围来解决这个问题,可以确保梯度在一个可控的范围内,从而提高模型的稳定性和性能。

除了上述的参数调整和模型优化方法外,还有其他一些常用的技术可以进一步提升深度学习的性能。例如,数据增强技术可以通过对训练数据进行一系列的随机变换来扩充训练集,从而改善模型的泛化能力。模型集成技术可以通过结合多个模型的预测结果来提升模型的准确性和稳定性。

综上所述,深度学习技术中的参数调整与模型优化是提升模型性能的重要环节。通过合理地调整参数和优化模型,可以提高模型的收敛速度、泛化能力和稳定性。在实际应用中,需要根据具体问题和数据情况选择合适的调整方法和优化技术来达到更好的效果。

4.2 矩阵分解与特征选择

矩阵分解算法是真正意义上的基于模型的协同过滤算法。通过将用户和标的物嵌入到低维隐式特征空间,获得用户和标的物的特征向量表示,再通过向量的内积来量化用户对标的物的兴趣偏好,思路非常简单、清晰,也易于工程实现,效果也相当不错,所以在工业界有非常广泛的应用。矩阵分解算法算是开启了嵌入类方法的先河,后面非常有名的Word2Vec也是嵌入方法的代表,深度学习兴起后,各类嵌入方法在大量的业务场景中得到了大规模的应用。

在使用时我们要扬长避短。

1.矩阵分解算法作为一类特殊的协同过滤算法,具备协同过滤算法的所有优点,具体表现在:

(1)不依赖用户和标的物的其他信息,只需要用户行为就可以为用户做推荐

矩阵分解算法也是一类协同过滤算法,它只需要用户行为就可以为用户生成推荐结果,而不需要用户或者标的物的其他信息,而这类其他信息往往是半结构化或者非结构化的信息,不易处理,有时也较难获得。

矩阵分解是领域无关的一类算法,因此,该优点可以让矩阵分解算法基本可以应用于所有推荐场景中,这也是矩阵分解算法在工业界大受欢迎的重要原因。

(2) 推荐精准度不错

矩阵分解算法是Netflix推荐大赛中获奖算法中非常重要的一类算法,准确度是得到业界一致认可和验证的,我们公司推荐业务中也大量利用矩阵分解算法,效果也是非常不错的。

(3) 可以为用户推荐惊喜的标的物

协同过滤算法利用群体的智慧来为用户推荐,具备为用户推荐差异化、有惊喜度的标的物的能力,矩阵分解算法作为协同过滤算法中一类基于隐因子的算法,当然也具备这个优点,甚至比user-based和item-based协同过滤算法有更好的效果。

(4) 易于并行化处理

通过第三节ALS求解我们可以知道矩阵分解是非常容易并行化的,Spark MLlib中就是采用ALS算法分布式进行矩阵分解的。

2.缺点

上面讲了这么多矩阵分解算法的优点,除了这些优点外,矩阵分解在下面这两点上是有缺陷的,需要采用其他的方式来弥补或者避免。

(1) 存在冷启动问题

当某个用户的用户行为很少时,我们基本无法利用矩阵分解获得该用户比较精确的特征向量表示,因此无法为该用户生成推荐结果。这时可以借助内容推荐算法来为该用户生成推荐。

对于新入库的标的物也一样,可以采用人工编排的方式将标的物做适当的曝光获得更多用户对标的物的操作行为,从而方便算法将该标的物推荐出去。

(2) 可解释性不强

矩阵分解算法通过矩阵分解获得用户和标的物的(嵌入)特征表示,这些特征是隐式的,无法用现实中的显示特征进行解释,因此利用矩阵分解算法做出的推荐,我们无法对推荐结果进行解释,只能通过离线或者在线评估来评价算法的效果。不像user-based和item-based协同过滤算法基于非常朴素的”物以类聚、人以群分“的思想,可以非常容易做解释。但也不是绝对的,其中参考文献5中的实现方法就提供了一个为矩阵分解做推荐解释的非常有建设性的思路。

深度学习技术近年来在各个领域取得显著的进展,尤其在让计算机视觉、自然语言处理和语音识别等任务中表现出色。深度学习模型通常需要大量的特征作为输入,而特征的选择对模型性能至关重要。

特征选择是指从原始特征集合中选择子集,以达到降维、提高模型性能和减少过拟合的目的。在深度学习中,特征选择的主要挑战在于高维特征空间。深度学习模型通常对大量的特征具有较好的适应能力,但过多的特征可能会导致维度灾难和模型泛化能力下降。

深度学习技术中的特征选择方法有过滤式、包裹式、嵌入式和基于深度学习的方法。过滤式方法计算特征和目标变量之间的关联性,适用于线性相关性问题;包裹式方法利用学习算法的性能选择特征子集,可以解决非线性关系问题;嵌入式方法直接嵌入到模型训练中,通过优化损失函数选择有意义的特征;基于深度学习的方法通过深度学习模型自动学习特征表示来选择最具区分性的特征。在实际应用中,我们可以根据具体任务需求选择合适的特征选择方法以优化深度学习模型的性能和效果。

特征选择在深度学习中起到了至关重要的作用。了解不同的特征选择方法及其适用场景,对于构建高效的深度学习模型至关重要。随着深度学习技术的不断发展,特征选择方法也将不断进化和改进。通过持续研究和探索,我们可以进一步挖掘深度学习技术在特征选择方面的潜力,为各个领域带来更加优秀的应用与成果。

4.3 并行计算与加速技术

深度学习是一种基于人工神经网络的机器堂习方法,通过多层次的神经网络结构来模拟人脑的学习和推理过程。然而,由于深度学习算法的复杂性和计算量的庞大,常常需要大量的计算资源来进行训练和推理。为了提高深度学习的效率和性能,研究人员发现了并行计算和加速方法可以有效地提升深度学习的速度和效果。

并行计算是指将任务分割成多个子任务,然后分配给多个处理器或计算节点同时进行。在深度学习中,通过并行计算可以同时处理多个样本或多个神经网络层的计算,从而加快训练和推理的速度。常见的并行计算方法包括数据并行和模型并行。

数据并行是将输入数据划分成多个批次,然后分配给不同的处理器或计算节点进行处理。每个处理器或计算节点独立地计算并更新模型参数,最后将结果进行汇总。数据并行的优点是可以通过增加处理器或计算节点的数量来提高计算速度,适用于在单个处理器或计算节点上无法容纳全部数据的情况。然而,数据并行也存在通信开销较大的问题,因为不同处理器或计算节点之间需要进行参数更新的同步。

模型并行是将模型划分成多个子模型,然后分配给不同的处理器或计算节点进行计算。每个处理器或计算节点只负责计算和更新分配给它的部分模型参数,最后将结果进行整合。模型并行的优点是可以减少通信开销,因为每个处理器或计算节点只需要与其他节点进行部分数据的通信。然而,模型并行也存在负载均衡的问题,即不同处理器或计算节点之问的计算量可能不均衡。

除了并行计算,深度学习还可以通过加速方法来提高效率和性能。常见的加速方法包括硬件加速和软件优化。

硬件加速是通过专用的硬件设备来加速深度学习计算。例如,图形处理器(GPU)是一种高性能并行处理器,特别适用于深度学习的并行计算。GPU具有大量的处理单元和高带宽的内存,可以并行地执行大规模的矩阵计算和神经网络计算。与传统的中央处理器(CPU)相比,GPU在深度学习中可以提供数倍甚至数十倍的加速效果。

软件优化是通过改进算法和优化代码来提高深度学习的效率和性能。例如,深度学习框架(例如TensorFlow和PyTorch)中提供了各种优化技术,如自动微分、张量运算、权值共享和卷积计算优化等。这些优化技术可以减少计算和存储的开销,提高深度学习的速度和效果。

总之,深度学习技术中的并行计算和加速方法可以显著提高深度学习的效率和性能。通过并行计算和加速方法可以同时处理多个样本或多个神经网络层的计算,从而加快训练和推理的速度。并行计算可以采用数据并行和模型并行的方式,而加速方法可以采用硬件加速和软件优化的方式。这些方法在实际应用中具有重要的意义,可以帮助研究人员和工程师更好地利用深度学习技术解决现实世界的问题。因此,进一步研究和探索并行计算和加速方法对于深度学习的发展和应用具有重要的价值。

4.4 矩阵运算与推理硬件的关系

深度学习在这十年,甚至是未来几十年内都有可能是最热门的话题。虽然深度学习已是广为人知了,但它并不仅仅包含数学、建模、学习和优化。算法必须在优化后的硬件上运行,因为学习成千上万的数据可能需要长达几周的时间。因此,深度学习网络亟需更快、更高效的硬件。

深度学习的背后是神经网络,神经网络本质是矩阵运算,矩阵运算也就是很多次乘加运算(Multiply-Accumulate (MAC))。对于一款用于深度学习的计算硬件,其核心便是执行MAC的速度。因此,业界会使用TOPS(Tera-operations per second,每秒万亿次运算)作为评估硬件算力的一个关键指标:每秒能够执行的MAC次数越高,算力越强。

然而,这一TOPS指标只是硬件能够达到的理论峰值,它与芯片运算单元的个数(PE(处理单元,Process Element)的个数)、运行频率有关。实际使用中的TOPS值又和下面的一些因素有关:

1.模型的并行性:数据并行和运算并行的程度,这与神经网络模型的设计和编译器有关;

2.内存的大小和内存带宽的大小:与硬件设计有关。

既然实际中不能仅以TOPS作为选择硬件的唯一指标,并且在不知道硬件内部及其编译器具体设计和实现方案的基础上,我们需要更多的指标,用以综合评价硬件:

1.理论峰值TOPS:虽然我们认为不能以TOPS作为唯一的评价指标,但不能否认TOPS仍然是最直观的指标。它直接反映了硬件上的“堆料”情况,即处理单元PE的数量。

2.能耗(Energy and Power):能耗对于边缘计算非常重要,毕竟没人会想要一个会大幅缩短手机电池使用时间的应用。一个神经网络应用的能耗可以分为两大块——MAC运算和数据搬运。

因此在设计时需要:减少数据搬运次数、利用数据复用方法、减少MAC数、避免片外存储的访问次数

3.硬件成本(Cost):要提高第1、2点的指标,最直接的方法便是增加PE数量、片上存储空间、使用HBM(High Bandwidth Memory)、更先进的制程等,但这必然会带来更高的硬件成本。因此,一个设计目标是——在给定的成本下,提升其他指标。

4.吞吐量和延迟(Thoughput and Latency):吞吐量表示每秒处理的数据量,延迟表示从输入到得到输出的时间。吞吐量和延迟在某些时候是冲突的,例如积攒一个星期的脏衣服进洗衣机,这样的吞吐量很高,但是对于其中第一件衣服而言,就存在一个星期的延迟(可能你其实马上就想穿)。因此,对于批处理的情况,需要对吞吐量和延迟进行权衡。

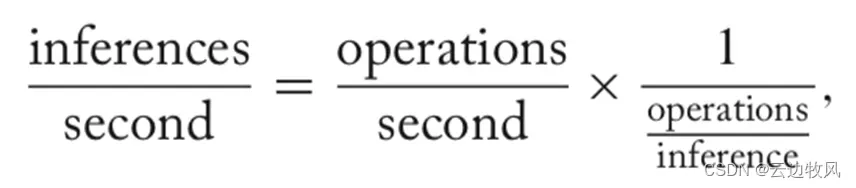

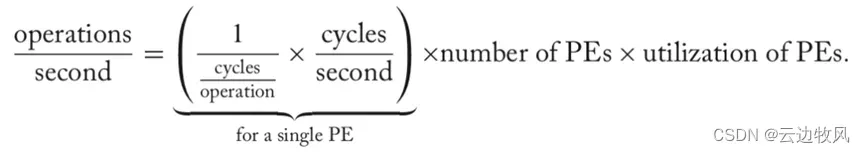

吞吐量的计算理论上由下式表示:

其中operations/inference指的模型每次推理所需要的MAC数量,该项由神经网络的模型设计支配,即减少模型的运算数量可以提升吞吐量。

operations/second可以继续分解为下式:一个PE的吞吐量(可以通过超频、硬件设计、优化MAC的指令设计等进行提升)、PE的数量(通过提升单位面积下的PE个数)、PE的利用率(通过调度平衡多个PE的工作量、提供足够的带宽,避免出现空闲的PE)。

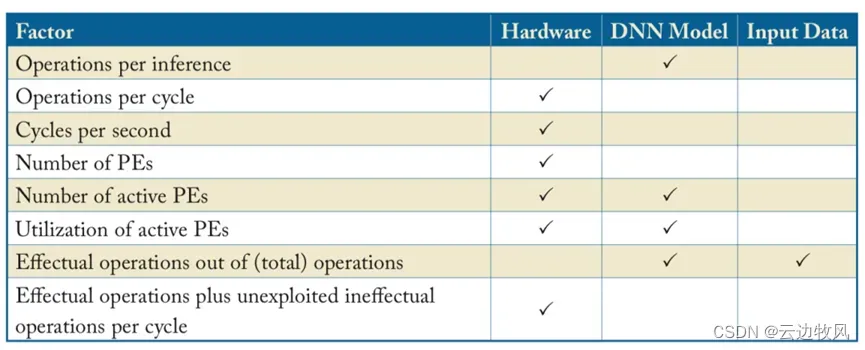

下表列出了影响吞吐量的关键因素,以及所属类别(硬件、模型、输入数据):

图4-1 影响吞吐量的关键因素

吞吐量和延迟是一个比较复杂的指标,会受到诸多因素的影响。在设计轻量化神经网络模型时,需要考虑模型的运算量、参数的稀疏化程度,以及结合硬件设计的模型效率

5.准确性(Accuracy):不同模型在不同数据集/任务下的模型指标(如视觉的分类任务的准确率指标)。

6.灵活性(Flexibility):能够(高效)支持的深度学习模型、算子等。深度学习模型的更新速度一定是快于计算硬件的设计,因此硬件的设计和实现需要 a)功能上支持多个模型的运行;b)性能上也能保障不同模型的吞吐量、准确性。

7.扩展性(Scalability):随着硬件资源的增加,性能的扩展性。例如随着PE和片上存储的资源扩展,吞吐量和能耗是否也能够随之扩展。

8.易用性(Usability):这一项和计算硬件的工具链或者生态相关。在训练深度学习模型时,可能因人而异会涉及到多种不同的框架(tensorflow、caffe、pytorch、mxnet等),计算硬件的生态对框架的支持程度、工具链对算法开发人员的易用程度也会作为考量因素。

最后,我们会发现,这些指标是会相互影响的——选择合适的硬件,竟然还是一个带约束的多目标优化问题:约束可以是【必须支持某一些模型、必须支持某一框架】,目标可以是【成本最低、准确率最高、吞吐量最高等】。这也就是一直以来广为人所接受的理念:适合所有模型的统一架构是不存在的,因为不同的模型需要不同的硬件处理架构。

5.实际应用案例

5.1 图像分类与目标检测

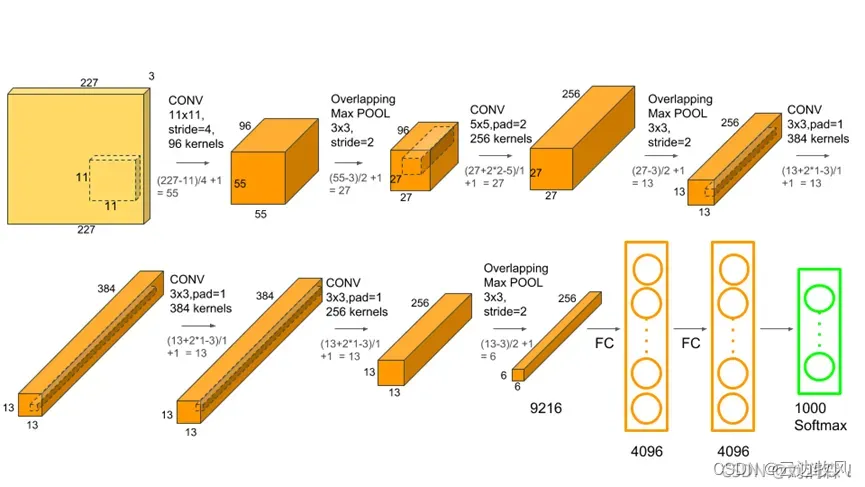

矩阵乘法在卷积层中广泛应用,卷积层利用滤波核做卷积运算提取图像特征,这相当于矩阵乘法。例如ImageNet图像分类任务中,AlexNet利用多个卷积-池化层组合提取多尺度特征,并用全连接层分类,其中卷积层就相当于矩阵乘法。目标检测任务中,YOLO利用卷积层提取特征图,再利用全连接层预测边界框和类别,实现实时目标检测。

5.1.1实现图像分类

图像分类是比较基础的应用,他可以节省大量的人工成本,将图像进行有效的分类。对于一些特定领域的图片,分类的准确率可以达到95%+,其中矩阵及其运算在CNN中的图像分类任务中起着重要作用。

例:2012 年,AlexNet 由 Alex Krizhevsky 为 ImageNet 大规模视觉识别挑战赛 ( ILSVRV ) 提出的,ILSVRV 评估用于对象检测和图像分类的算法。

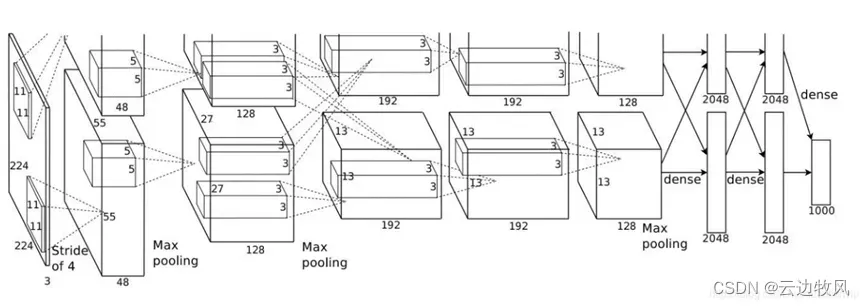

AlexNet 总共由八层组成,其中前5层是卷积层,后3层是全连接层。

单一映射:卷积第2层、第4层和第5层的核只连接到前一层的核映射上 ;

多映射:卷积 第 3 层 的核连接到 第 2 层 的所有核映射上 ;

全连接:全连接层中的神经元与 前一层中的所有神经元相连接 ;

非线性激活:每个卷积层 和 全连接层的输出应用 ReLU非线性 ;

前两个卷积层连接到重叠的最大池化层以提取最大数量的特征。第三、四、五卷积层直接与全连接层相连。卷积层和全连接层的所有输出都连接到 ReLu 非线性激活函数。最后的输出层连接到一个 softmax 激活层,它产生 1000 个类标签的分布。

图5-1

图5-2 AlexNet网络结构图

矩阵在其中的作用:在CNN的卷积层中,滤波核可以看作是一个小规模的矩阵,它通过与输入特征图进行矩阵乘法,实现对特征图各区域的卷积操作,提取出不同空间位置和尺度的特征。例如AlexNet网络中的第一个卷积层采用96个5×5大小的滤波核,它们通过与224x224x3的输入图片进行矩阵乘法,提取出不同空间位置的低层特征。随后的卷积层继续使用不同规模的滤波核进行矩阵乘法,提取出更高层的语义特征。这些卷积操作实际上就是利用矩阵乘法在不同层次上提取特征图。

在CNN的全连接层中,也大量使用矩阵运算。例如AlexNet网络中的第一个全连接层将上一层卷积层输出的特征图展平成一维向量,与权重矩阵进行矩阵乘法,提取出更高层次的分类特征。随后的全连接层也采用类似的矩阵乘法操作。这些全连接层通过矩阵运算实现特征选择和分类预测。

通过加载AlexNet参数对图像进行分类,可以识别出如下图小狗的种类:

图5-3 AlexNet对图像进行分类识别示例图

总之,卷积层通过滤波核矩阵与输入特征图的矩阵乘法提取多层次特征;全连接层通过权重矩阵与特征向量的矩阵乘法实现分类预测。这些矩阵运算为CNN提供了强大的特征学习和分类能力,极大提高了图片分类任务的效果。它成为CNN在图像分类中成功的重要数学基础。

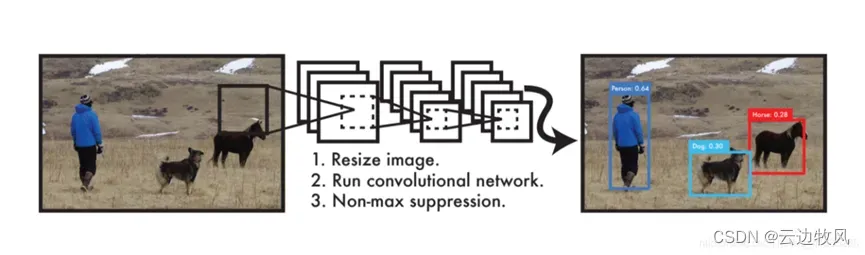

5.1.2实现目标检测

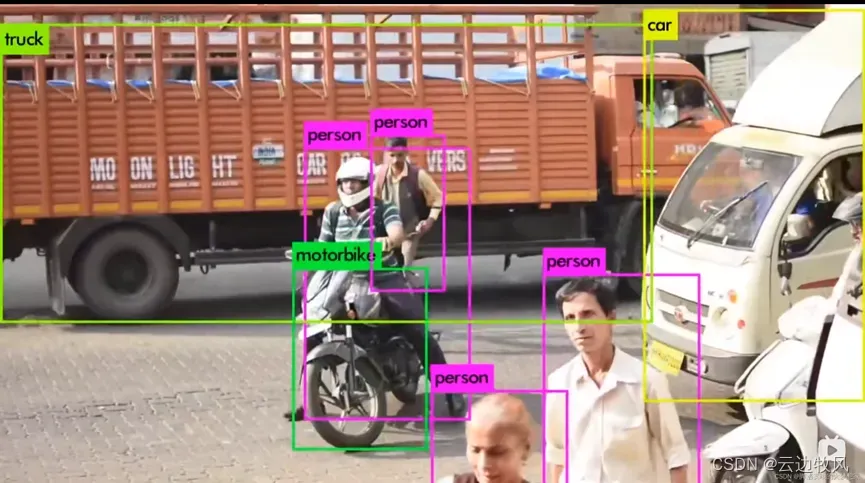

目标检测问题是我们所熟知的最经典最重要的问题之一。目标检测需要在一幅大图片中定位到多个目标的位置和类别。目标检测的应用范围很广,比如在超市通过视频检测消费者的进出、工业制造业领域中的异常行为检测等。另一个典型的场景是,在自动驾驶时车辆需要定位视线范围内的所有物体,并识别其类别以判断危险程度。这都给目标检测这一领域提供了丰富的应用空间。

例:YOLO(You Only Look Once)是当前目标检测领域性能最优算法的之一。YOLO系列算法没有显式寻找区域的过程,可以实现端到端的快速预测,即输入一幅图片,在输出中给出若干目标的位置、类别和置信度。其优势在于又快又准,可实现实时的目标检测。

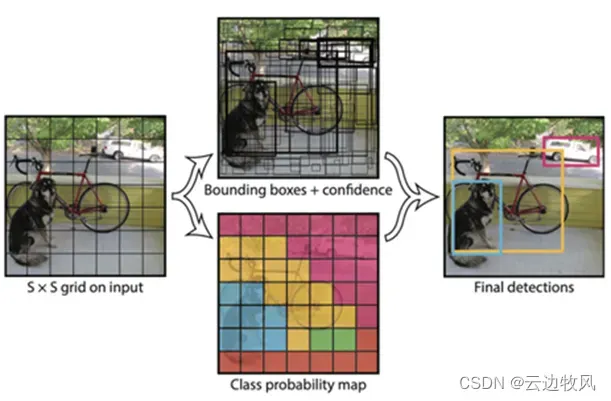

图5-4

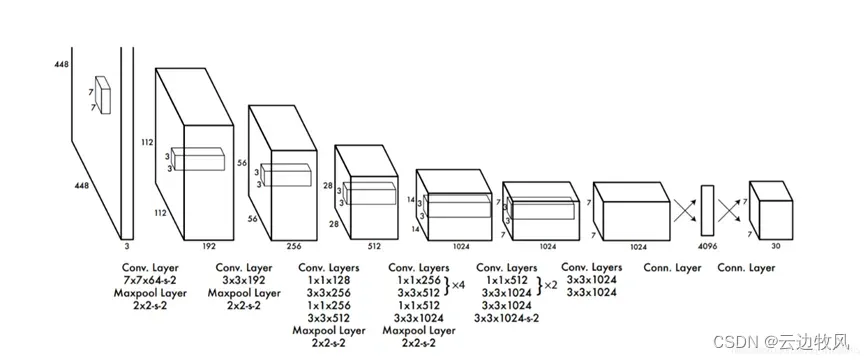

YOLO的网络结构并没有什么特别,和我们熟悉的图像分类一样都是卷积神经网络,但它的输出向量却不太一样。如果把神经网络看作我们熟悉的回归分析问题,那YOLO做的事情就是改变了模型响应Y的结构,而这也奠定了YOLO目标检测的基础。YOLO的输出向量不仅包括目标的类别,还有边界框的坐标和预测的置信度。它的核心思想在于把图像分割成S*S的若干个小块,在每个格子中预先放置两个边界框,通过卷积神经网络预测得到每个边界框的坐标、类别和置信度,然后通过非极大值抑制获得局部唯一的预测框。

图5-5

YOLO的结构非常简单(不包括候选区),就是单纯的卷积、池化最后加了两层全连接。最大的差异是最后输出层用线性函数做激活函数,因为需要预测bounding box的位置(数值型),而不仅仅是对象的概率。YOLO网络结构由24个卷积层与2个全连接层构成,网络入口为448×448(v2为416×416),图片进入网络先经过resize,网络的输出结果为一个张量,维度为:![]()

其中,S为划分网格数,B为每个网格负责的边框个数,C为类别个数。每个小格会对应B个边界框,边界框的宽高范围为全图,表示以该小格为中心寻找物体的边界框位置。每个边界框对应一个分值,代表该处是否有物体及定位准确度:![]()

,每个小格会对应C个概率值,找出最大概率对应的类别P(Class|object),并认为小格中包含该物体或者该物体的一部分。

图5-6 YOLO网络层

YOLO的最后一层采用线性激活函数,其它层都是Leaky ReLU。训练中采用了drop out和数据增强(data augmentation)来防止过拟合。

矩阵在其中的作用:YOLO网络采用全卷积结构,其卷积层广泛使用矩阵运算来提取特征。例如第一个卷积层使用32个3×3大小的卷积核进行卷积,这相当于利用这32个3×3卷积核矩阵分别与输入图片矩阵进行矩阵乘法运算,提取出32张低级特征图。随后的卷积层也使用不同尺寸的卷积核矩阵与上一层特征图矩阵进行矩阵乘法,不断提取出更高层次的语义特征图。这些特征图包含了目标和背景各个区域的特征信息,为后续预测提供支持。

在预测阶段,YOLO网络利用矩阵运算实现区域预测和边界框回归。它采用一个3×3的卷积核生成预测特征图,相当于利用这个3×3卷积核矩阵与最后一层特征图矩阵进行矩阵乘法,提取预测特征。然后对每个网格预测框类别概率和坐标,这也可以看作是利用预测特征与分类模板和回归模板的内积,实现了矩阵乘法运算。

在后处理阶段,YOLO网络利用1×1卷积核生成每个预测框的置信度,这相当于利用1×1卷积核矩阵与特征图矩阵进行矩阵乘法,对预测框进行评分。同时,它还采用非极大抑制算法筛选重合预测框,实现了矩阵运算。

图5-7 YOLO对图像进行目标检测示例图

总之,YOLO目标检测网络在各个关键环节如特征提取、预测生成和后处理中,广泛利用了卷积层的矩阵乘法操作。这为网络提供了强大的多尺度特征学习能力,并通过整体设计发挥协同效应,有效提升了目标检测的精度和速度,是其成功的重要保障。矩阵运算为YOLO网络提供了重要的数学基础和技术支撑。

5.2 人脸识别与姿态估计

在人脸识别任务中,矩阵运算在特征提取与分类阶段都有重要应用。DeepFace通过多个卷积-池化层提取人脸特征图,再利用全连接层实现人脸识别分类。在姿态估计任务中,矩阵乘法在卷积层中提取姿态特征,再利用回归预测具体姿态角度。例如OpenPose利用卷积神经网络提取人体关键点特征图实现多人姿态估计。

5.2.1实现人脸识别

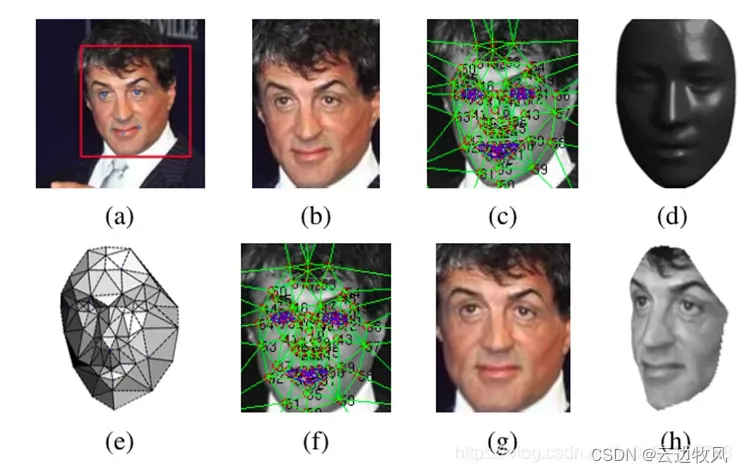

人脸识别在现如今的生活中应用非常广泛,人脸识别是指在已经检测到人脸的基础上,通过对其特征进行比较和匹配,将其与先前存储的一组人脸数据集中的个体进行识别和辨认的过程。

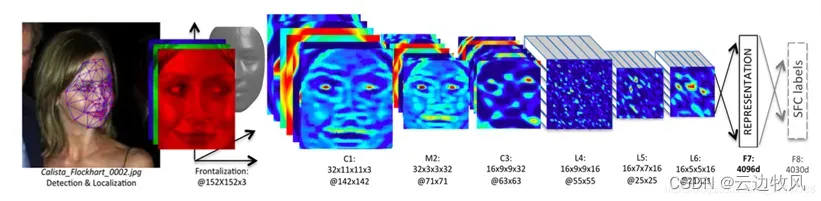

例:Deepface 是一个用于 python 的轻量级人脸识别和人脸属性分析(年龄、性别、情感和种族)框架。它是一个混合人脸识别框架。DeepFace网络采用卷积神经网络结构,其卷积层广泛使用矩阵运算来提取人脸图像的特征。

利用DeepFace进行人脸识别的基本流程是:

1.人脸对齐:使用3D模型来将人脸对齐,从而使CNN发挥最大的效果。

图5-8

2.人脸表征(人脸特征描述):经过3D对齐以后,形成的图像都152×152

的图像,输入到如下网络结构中

图5-9

3. 人脸表示归一化:对于输出的4096-d向量:先每一维进行归一化,即对于结果向量中的每一维,都要除以该维度在整个训练集上的最大值。再将每个向量进行L2归一化。

4. 人脸识别、分类:得到表示后,使用了多种方法进行识别、分类:直接算内积、加权的卡方距离、使用Siamese网络结构。

矩阵在其中的作用:例如第一个卷积层使用96个11×11大小的卷积核,这相当于利用这96个11×11卷积核矩阵分别与输入人脸图片矩阵进行矩阵乘法运算,提取出96张低级特征图。随后的卷积层也使用不同尺寸的卷积核矩阵与上一层特征图矩阵进行矩阵乘法,不断提取出更高层次的语义特征图。这些特征图包含了人脸各个区域如眼睛、鼻子、嘴巴等部位的特征信息。

在后续的全连接层,DeepFace网络利用矩阵运算实现人脸识别。它将最后一层特征图展平为一个长向量,与分类模板进行内积运算,这相当于利用分类模板矩阵与特征向量矩阵进行矩阵乘法,提取分类特征。对每个人物进行这样的矩阵运算,就可以实现对输入人脸图片的识别。DeepFace网络还采用三阶张量来表示人脸图片的三维结构信息。它利用卷积核三维张量与输入张量进行卷积,相当于对每个通道进行独立的二维卷积,提取了人脸三维结构的特征。这也是一种高阶矩阵运算。

总之,DeepFace网络在特征提取、识别分类等各个关键环节,广泛利用了卷积层的矩阵乘法操作和高阶张量运算。这为网络提供了强大的多尺度和三维结构特征学习能力,有效捕捉人脸细微差异,大大提升了识别准确率,是其成功的重要保障。矩阵运算为DeepFace网络提供了重要的数学基础。

5.2.2实现姿态估计

人体姿态估计(Human Posture Estimation),是通过将图片中已检测到的人体关键点正确的联系起来,从而估计人体姿态。进一步的是,增加时间序列,看一段时间范围内人体关键点的位置变化,可以更加准确的检测姿态,估计目标未来时刻姿态,以及做更抽象的人体行为分析,例如判断一个人是否在打电话等。

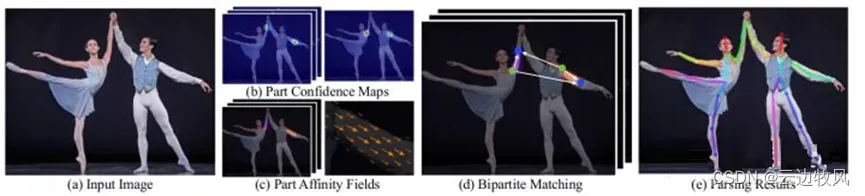

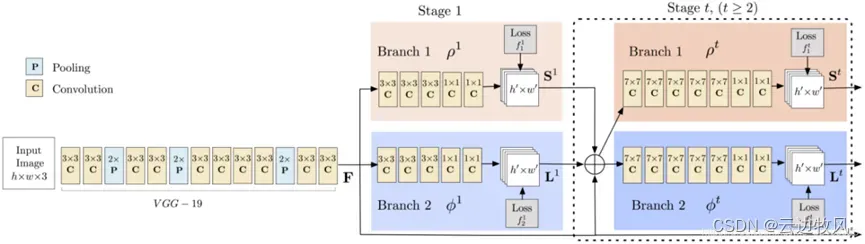

例:OpenPose人体姿态识别项目是美国卡耐基梅隆大学(CMU)基于卷积神经网络和监督学习并以Caffe为框架开发的开源库。可以实现人体动作、面部表情、手指运动等姿态估计。适用于单人和多人,具有极好的鲁棒性。是世界上首个基于深度学习的实时多人二维姿态估计应用,基于它的实例如雨后春笋般涌现。

其实现原理为:输入一幅图像,经过卷积网络提取特征,得到一组特征图,然后分成两个岔路,分别使用 CNN网络提取Part Confidence Maps 和 Part Affinity Fields;得到这两个信息后,我们使用图论中的 Bipartite Matching(偶匹配) 求出Part Association,将同一个人的关节点连接起来,由于PAF自身的矢量性,使得生成的偶匹配很正确,最终合并为一个人的整体骨架;最后基于PAFs求Multi-Person Parsing—>把Multi-person parsing问题转换成graphs问题—>Hungarian Algorithm(匈牙利算法)

图5-10

神经网络在其中的实现分为三个阶段:

阶段一:VGGNet的前10层用于为输入图像创建特征映射

图5-11

阶段二:使用2分支多阶段CNN,其中第一分支预测身体部位位置(例如肘部,膝部等)的一组2D置信度图(S)。如下图所示,给出关键点的置信度图和亲和力图 – 左肩。

图5-12

第二分支预测一组部分亲和度的2D矢量场(L),其编码部分之间的关联度。 如下图所示,显示颈部和左肩之间的部分亲和力。

图5-13

阶段三: 通过贪心推理解析置信度和亲和力图,对图像中的所有人生成2D关键点。

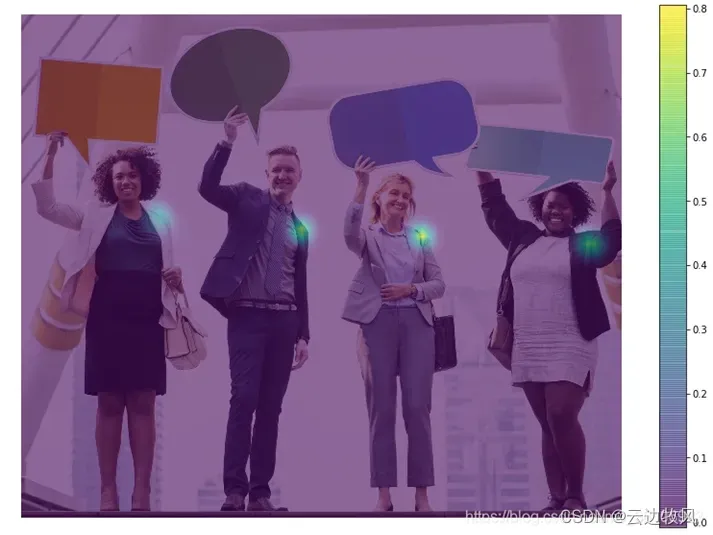

矩阵在其中的作用:OpenPose网络采用全卷积结构,其卷积层广泛使用矩阵运算来提取人体关键点特征。例如第一个卷积层使用32个3×3大小的卷积核进行卷积,这相当于利用这32个3×3卷积核矩阵分别与输入图片矩阵进行矩阵乘法运算,提取出32张包含人体部位低级特征的特征图。随后的卷积层也使用不同尺寸的卷积核矩阵与上一层特征图矩阵进行矩阵乘法,不断提取出更高层次的语义特征图,包含了各个人体部位如头、肩、腿等不同区域的特征信息。

在后续的关键点预测模块中,Pose网络利用矩阵运算实现多人姿态估计。它采用一个1×1的卷积核生成每个预测点的热力图,这相当于利用1×1卷积核矩阵与最后一层特征图矩阵进行矩阵乘法,提取预测特征。对每个预测点进行这样的矩阵运算,就可以为每个人生成完整的关键点热力图。

OpenPose网络还利用高维卷积核提取人体关节连接等结构信息。它利用高维卷积核张量对特征图进行卷积,相当于对每个通道进行矩阵乘法,提取了人体多维结构特征。这也是一种高阶矩阵运算。

总之,Pose网络在特征提取和关键点预测等各个关键环节,广泛利用了卷积层的矩阵乘法操作和高阶张量运算。这为网络提供了强大的多维结构特征学习能力,有效实现了多人姿态解析任务,体现出矩阵运算在该任务中的重要性。

5.3 图像生成与风格迁移

生成对抗网络(GAN)利用矩阵乘法生成真实图片。例如DCGAN通过多层卷积-反卷积神经网络生成假图片,再利用鉴别器判断真伪,不断优化生成网络。风格迁移任务中,内容网络和风格网络通过卷积层提取内容和风格特征图,再利用矩阵乘法实现特征图融合,生成新的图片实现风格迁移。

5.3.1实现图像生成

通常深度学习(监督学习)需要依靠大量数据来训练网络,数据量越多,训练出来的网络具有更好的泛化性能。然而,收集数据需要耗费人力和财力,这使得研究人员只能针对各别相对重要的任务收集足量的数据。因此,如何采集数据或增大数据量成为了解决大多数视觉问题的首要任务。针对没有训练数据或数据量太少的问题,研究人员提出了无监督训练,图像生成(数据增广)等方法。

图5-14 图像生成示例

例:生成对抗网络 (GAN) 是一种算法架构,它使用两个神经网络,其中一个对另一个(因此称为“对抗性”),以便生成新的合成数据实例,这些实例可以通过真实数据。它们广泛用于图像生成、视频生成和语音生成。

GAN 由两个组件组成:

生成器 – 生成新的数据实例;

鉴别器 – 尝试将生成的或虚假的数据与真实数据集区分开来。

通过训练,生成器和鉴别器不断迭代,最终生成器可以生成比较逼真的图像。

图5-15

矩阵在其中的作用:GAN网络由生成网络组成。生成网络学习数据分布,并能生成真实样本样式的假数据。鉴别器网络D的任务是判断输入数据是否来自真实数据分布。在这一框架下,矩阵及其运算贯穿于整个GAN网络训练过程。具体来说,生成网络经网络结构,各层主要利用矩阵运算来提取和转换特征。例如卷积层通过卷积核矩阵与输入特征图矩阵的乘法运算来提取特征,反卷积层通过特征图矩阵与反卷积核矩阵的转置运算实现特征还原。这些都是基于矩阵乘法的特征学习。

鉴别器网络D也采用类似多层神经网络结构来学习特征。最后一层通过输入特征向量矩阵与权重矩阵的乘法来实现分类判断,这也是一种矩阵运算。

在训练过程中,GAN通过梯度下降优化,这里梯度计算也需要利用矩阵微分法求导。例如对卷积层参数进行梯度下降,需要利用卷积核矩阵、输入和输出特征图矩阵来计算参数更新量。

总之,无论是特征学习、还原、分类判断,还是模型训练过程中的梯度下降,矩阵运算都发挥着重要作用,为GAN网络提供了强大的数学基础,实现了生成对抗训练的目的。这也体现了矩阵在GAN这类生成模型中的不可或缺的重要性。

5.3.2实现风格迁移

风格迁移,又称为风格转换。只需要给定原始图片,并选择艺术家的风格图片,就能把原始图片转换成具有相应艺术家风格的图片。图像的风格迁移始于2015年Gatys的论文“Image Style Transfer Using Convolutional Neural Networks”,所做的工作就是由一张内容图片和一张风格图片进行融合之后,得到经风格渲染之后的合成图片。

图5-16 风格迁移示例图

矩阵在其中的作用:风格迁移任务通过学习内容图片和风格图片的特征,实现将风格图片的风格迁移到内容图片上。其中,卷积神经网络广泛采用矩阵运算来提取多层次的特征表示。具体来说,每个卷积层通过卷积核矩阵与输入特征图矩阵进行矩阵乘法运算,提取出更高层次的语义特征。例如第一个卷积层可能使用64个3×3大小的卷积核矩阵,通过与输入图片矩阵进行矩阵乘法运算提取64张低级特征图。随后的卷积层也会使用不同尺寸的卷积核矩阵来提取特征。这些特征图就包含了内容和风格信息的表示。网络通过多层矩阵运算逐步提取出更丰富的语义特征。

风格迁移网络还利用成分分解等矩阵运算,来分离内容和风格特征。例如通过奇异值分解将特征图分解为内容空间和风格空间,这也是一种矩阵运算。在迁移过程中,网络需要通过损失函数来衡量内容和风格的匹配程度,这也需要利用矩阵内积来计算特征图之间的相似性。

总之,从特征提取到内容风格分离,以及模型训练过程中的损失函数定义,矩阵运算贯穿整个风格迁移任务,为有效学习和迁移风格提供重要的数学基础。这也体现了矩阵在这类生成任务中的重要应用价值。

6.挑战与未来展望

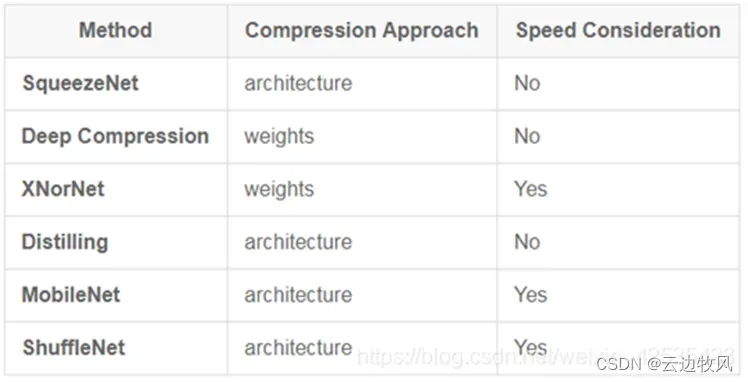

6.1 计算效率与模型规模

在深度学习中,卷积神经网络被广泛应用于计算机视觉和图像处理任务。然而,随着模型的不断发展和复杂化,CNN面临着计算效率和参数量过大的问题。

- 深度可分离卷积

为了提高计算效率以及模型小型化,采用深度可分离卷积可以有效改善这些问题。

深度可分离卷积是一种将标准卷积操作拆分为两个独立步骤的卷积方法。这两个步骤分别是深度卷积(depthwise convolution)和逐点卷积(pointwise convolution)。

a. 深度卷积(Depthwise Convolution):深度卷积是对输入数据的每个通道进行独立的卷积操作。它使用一个与输入通道数相等的卷积核对每个通道进行卷积运算,生成相同数量的特征图。

b. 逐点卷积(Pointwise Convolution):逐点卷积是对深度卷积的输出应用1×1卷积操作,以将通道数降低至所需数量。这个步骤会进一步组合特征图,并生成最终的输出特征图。

深度可分离卷积通过将卷积过程分解为两个独立的步骤,可以显著减少计算量和参数数量,并且在保持模型性能的同时提高计算效率。

深度可分离卷积具有以下优势:

a. 减少计算量:相比于传统的标准卷积操作,深度可分离卷积需要更少的计算量。由于深度卷积只对每个通道进行卷积运算,而逐点卷积则使用1×1卷积核进行通道融合,整体计算复杂度大幅下降。

b. 减少参数量:深度可分离卷积通过降低每个卷积核的尺寸和通道数,从而大幅减少了网络中的参数量。这对于部署和存储模型非常重要,特别是在资源受限的环境中。

c. 提高计算效率:由于减少了计算量和参数量,深度可分离卷积能够大幅提高计算效率。它可以加快模型的训练速度和推理速度,使得在边缘设备和嵌入式系统中实现实时的高性能计算成为可能。

d. 提高模型泛化能力:深度可分离卷积通过减少参数量和计算量,限制了模型的容量。这有助于降低过拟合风险,并提高模型的泛化能力。同时,逐点卷积操作还提供了更多的非线性变换能力,进一步增强了模型的表达能力。

2. 神经网络剪枝

神经网络剪枝是神经网络模型压缩的常用方法之一,剪枝算法通过移除网络中的冗余权重实现模型压缩。通道粒度是神经网络剪枝粒度之一,通道级剪枝算法将每个滤波器中的权重作为整体进行移除,减少了卷积神经网络中的通道数量,降低了权重与输入特征图的计算复杂性。由于通道级剪枝保留了矩阵运算的结构化特性,使用通用软硬件,即可实现推理加速,因此通道级剪枝算法广泛用于卷积神经网络的模型压缩场景。

但是,绝大多数的神经网络剪枝方法仅关注了压缩后的稀疏模型的推理性能,而忽略了由于使用剪枝算法带来的高昂训练开销。由于神经网络的体量巨大,训练神经网络需要极大的计算开销,当使用剪枝算法对模型进行压缩时,网络的训练开销将进一步增加。额外开销的来源包括但不仅限于以下两方面:(1)剪枝算法评估权重贡献度带来的额外计算。(2)冗余权重移除后的模型微调计算。

此外,现有的剪枝方法超参数的设定需要一定的先验知识,当模型或任务发生改变,超参数的设定值将发生改变,无法实现对数据集和网络模型的自适应,因此具有一定的局限性。

因此,对于神经网络剪枝这一方法仍然有待优化。

除此之外,主要从模型权重数值角度压缩和从网络架构角度压缩两个方面,还有着许多经典的压缩方法:

图6-1 几种经典压缩方法

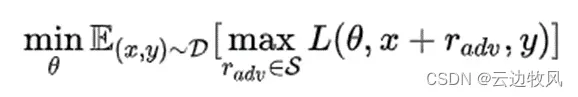

6.2 鲁棒性与对抗性攻击

以深度学习为代表的人工智能技术在计算机视觉、语音识别等众多领域均取 得了显著进展,规模化应用已现曙光。但现有深度学习模型存在鲁棒性不足的问题,很容易被攻击者恶意构造的对抗样本欺骗,产生错误的预测结果。深度学习鲁棒性的不足已被证实会对一些与安全密切相关的领域带来威胁。同时,这一问题也阻碍了深度学习的进一步发展。

由于机器学习算法的输入形式是一种数值型向量(numeric vectors),所以攻击者就会通过设计一种有针对性的数值型向量从而让机器学习模型做出误判,这便被称为对抗性攻击。和其他攻击不同,对抗性攻击主要发生在构造对抗性数据的时候,该对抗性数据就如正常数据一样输入机器学习模型并得到欺骗的识别结果。这些数据样本看起来像正常样本,但以某种方式受到干扰以欺骗机器学习系统。 例如在给定的图像中,并非所有像素都具有相同的重要性,如果可以识别最重要的像素(用于 ML 系统做出分类决策)并更改它们,那么算法决策也会发生变化,样本的结果也会发生变化,但是从肉眼看起来它还是正常的。

对于神经网络,为了应对对抗性攻击,往往会选择对抗训练提高网络的鲁棒性。AI模型的鲁棒性可以理解为模型对数据变化的容忍度;假设数据出现较小偏差,只对模型输出产生较小的影响,则称模型是鲁棒的。而对抗训练是一种在深度学习中使用的技术,其主要思想是通过生成对抗样本来训练模型;这些对抗样本是由原始样本经过人为干扰后生成的,干扰的方式可以是添加噪声、修改输入等等。对抗训练的目的是提高模型的鲁棒性和泛化性能,从而使其在实际应用场景中更加可靠。

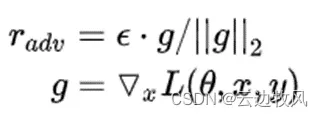

对抗训练基本思想——Min-Max公式

中括号里的含义为,我们要找到一组在样本空间内、使Loss最大的的对抗样本(该对抗样本由原样本x和经过某种手段得到的扰动项r_adv共同组合得到)。这样一组样本组成的对抗样本集,它们所体现出的数据分布,就是该中括号中所体现的。

外层min()函数指的则是,我们面对这种数据分布的样本集,要通过对模型参数的更新,使模型在该对抗样本集上的期望loss最小。

我们知道如何在已有数据上进行模型更新,但如何找到最佳扰动r_adv呢?很简单——梯度上升。所以说,对抗训练本质上来说,在一个step中,实际上进行了两次梯度更新,只不过是被更新的对象是不同的。

常见的几种对抗训练算法有FGM、PGD和FreeLB。

- Fast Gradient Method(FGM)

- 一切照常,计算前向loss,然后反向传播计算grad(注意这里不要更新梯度,即没有optimizer.step())

- 拿到embedding层的梯度,计算其norm,然后根据公式计算出r_adv,再将r_adv累加到原始embedding的样本上,即 x+r ,得到对抗样本;

- 根据新对抗样本 x+r ,计算新loss,在backward()得到对抗样本的梯度。由于是在step(1)之后又做了一次反向传播,所以该对抗样本的梯度是累加在原始样本的梯度上的;

- 将被修改的embedding恢复到原始状态(没加上r_adv 的时候);

- 使用step(3)的梯度(原始梯度+对抗梯度),对模型参数进行更新(optimizer.step()/scheduler.step())

- Projected Gradient Descent(PGD)

相比较于FGM的一步对抗到位,PGD采用小步多走的策略进行对抗。具体来说,就是一次次地进行前后向传播,一次次地根据grad计算扰动r,一次次地将新的扰动r累加到embedding层的grad上,若超出一个范围,则再映射回给定范围内。最终,将最后一步计算得到的grad累加到原始梯度上。即以累加过t步扰动的梯度对应的grad对原梯度进行更新,相比较于FGM的一步对抗到位,PGD采用小步多走的策略进行对抗。具体来说,就是一次次地进行前后向传播,一次次地根据grad计算扰动r,一次次地将新的扰动r累加到embedding层的grad上,若超出一个范围,则再映射回给定范围内。最终,将最后一步计算得到的grad累加到原始梯度上。即以累加过t步扰动的梯度对应的grad对原梯度进行更新。

- FreeLB

FreeLB每轮计算则不做model.zero_grad(),相当于每轮的 loss.backward()都在param.grad上做累加,不论是delta.grad还是其余模型的model.params.grad都是如此。

综上,我们可将对抗训练整体思想总结为:内层梯度上升优化扰动δ,外层梯度下降优化模型参数Θ。

6.3 深度学习与矩阵运算的融合

神经卷积网络中的卷积操作就是卷积核(过滤器 / Filter)在原始图片中进行滑动得到特征图(Feature Map)的过程,对于卷积操作如果去用一系列的for循环来实现,效率会十分低下;而矩阵的乘法可以被高度优化和加速,且目前有很多现成的算法和加速包。于是问题就转换为:将卷积操作转换为矩阵的乘法。

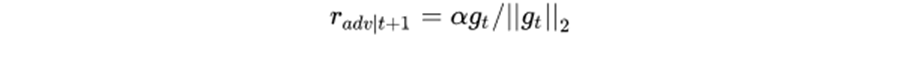

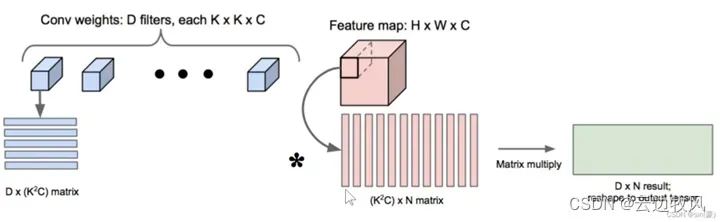

- 将卷积核化为矩阵

假设在某一层有D个卷积核,尺寸为K × K × C(即有C个channel,说明输入的feature map有C个channel);把每一个K×K×C维度的卷积核拆成一个K2C长度的行向量,把D个K2C长度的行向量按行堆叠,就形成了一个D×(K2C)的二维矩阵

图6-2

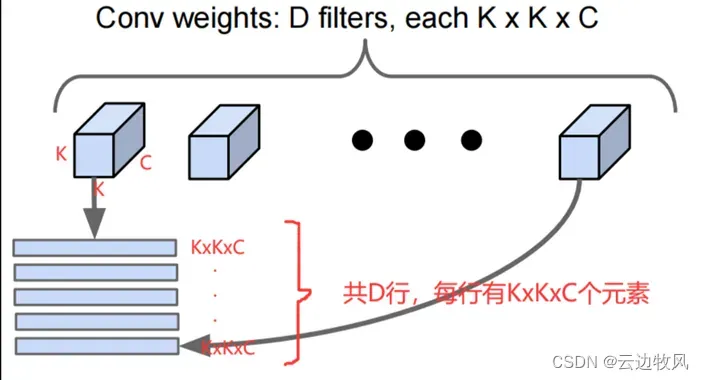

- 将输入的Feature Map化为矩阵

假设输入的feature map尺寸为H × W × C,H、W为高和宽,C代表C个channel,我们知道,感受野会在整个输入图像中滑动,每次滑动一个stride,假设感受野在整张图象上滑动N次。一个感受野为一K×K×C的矩形,我们将其拉伸为K2C个元素列向量,如下图:

图6-3

由于感受野在输入图像上滑动了N次,每次都会产生一个K2C的列向量,我们把这些列向量按列堆叠,就形成了一个(K2C)×N的二维矩阵。

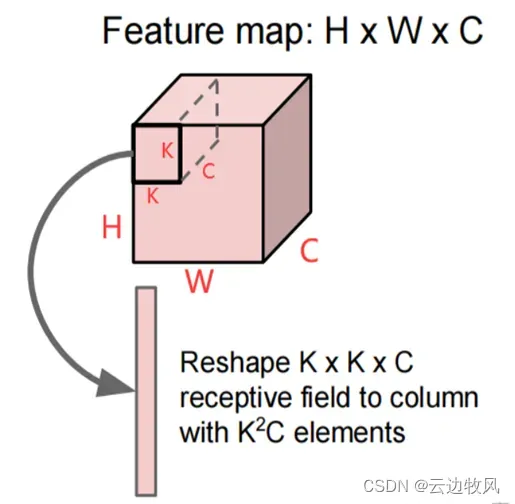

- 矩阵乘法

我们将卷积核转换成的D×(K2C)矩阵与输入的feature map经过感受野滑动得到的(K2C)×N矩阵进行相乘,得到D×N的二维矩阵

图6-4

最终输出D x N的二维向量的每一行代表:一个卷积核生成的feature map拉成的行向量(共N个元素)。

7.结论

经过对于矩阵在卷积神经网络方面的多维度的学习,我们了解到卷积神经网络(CNN)是一种常用于图像处理和模式识别的深度学习模型。在CNN中,矩阵及其运算扮演着重要的角色,并在多个方面得到应用和启发。

首先,在图像表示与卷积运算方面,输入图像被表示为二维矩阵,其中每个元素代表图像中的像素值。卷积核也是一个二维矩阵,通过在输入图像的矩阵上进行卷积运算,提取图像的特征信息。这种卷积运算可以通过矩阵乘法和求和来实现,从而将图像中的局部信息映射到特征图中。

其次,矩阵运算在特征提取与矩阵分解中发挥着重要作用。通过卷积操作,CNN可以提取输入图像的各种特征,比如边缘、纹理等。同时,矩阵分解可以用于对卷积核进行降维或特征选择,从而减少计算复杂度和参数量,提高模型的效率和泛化能力。

此外,矩阵运算在参数优化与梯度计算中也发挥着重要作用。在CNN的训练过程中,通过梯度下降算法对模型的参数进行优化,其中就包括对矩阵中的元素进行更新。通过反向传播算法,可以高效地计算出模型中各个参数的梯度,从而实现参数的更新和优化。

矩阵运算还在图像生成与矩阵合成中扮演着关键角色。通过利用卷积神经网络生成模型,可以从随机噪声中生成逼真的图像。这一过程涉及到矩阵的合成和变换,通过学习训练数据的统计特性,模型可以生成具有高度真实感的图像。

在CNN的设计与优化中,矩阵运算也提供了重要的启发。通过合理组织模型的参数矩阵,可以减少参数量、加速计算和降低存储空间的需求。同时,矩阵分解和特征选择等方法也可以帮助优化模型的结构和性能。

并行计算和加速技术也与矩阵运算密切相关。由于矩阵运算具有良好的并行性,可以利用GPU等硬件平台进行高效的并行计算,从而加速CNN的训练和推理过程。

矩阵运算与推理硬件之间的关系也是CNN中的一个重要问题。为了充分发挥矩阵运算的优势,人们设计了专用的硬件加速器,如GPU、TPU等,来加速CNN的推理和部署。

在实际应用中,CNN在图像分类与目标检测、人脸识别与姿态估计以及图像生成与风格迁移等领域取得了显著的成果。通过训练大量的图像数据,CNN可以学习到图像的复杂特征,并实现高效准确的图像处理和模式识别。

总的来说,矩阵及其运算在卷积神经网络中发挥了重要的作用,并在CNN的设计、优化和应用中提供了许多启发。通过矩阵运算,CNN可以高效地处理图像数据,提取图像的特征信息,实现准确的图像识别和处理,并在许多不同领域中取得良好的应用效果。

参 考 文 献

[1] Le Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[2] Goodfellow I J, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets[ances in neural information processing systems. 2014: 2672-2680

[3] 严春满,王铖.卷积神经网络模型发展及应用.计算机科学与探索,1673-9418/2021/15(01)-0027-20

[4] 周志华.机器学习[M].北京:清华大学出版社.2016:114-114,399-400

[5] Taigman Y, Yang M, Ranzato M A, et al. Deepface: Closing the gap to human-level performance in face verification[C]//Computer Vision and Pattern Recognition (CVPR), 2014 IEEE Conference on. IEEE, 2014: 1701-1708.

[6] mageNet Classification with Deep Convolutional Neural Networks

[7] 香博士.模型压缩加速-五种CNN模型的尺寸,计算量和参数数量对比,CSDN,15 Jan 2021,www.csdn.net.

[8] C_19870.如何解决卷积网络的计算效率和参数量的问题,CSDN,21 Jul 2023,www.csdn.net.

[9]徐中天. 基于二值化掩码的卷积神经网络通道剪枝算法研究[D].中国科学技术大学,2023.DOI:10.27517/d.cnki.gzkju.2022.001201.

[10]董胤蓬,苏航,朱军.面向对抗样本的深度神经网络可解释性分析[J].自动化学报,2022,48(01):75-86.DOI:10.16383/j.aas.c200317.

[11] _illusion_.对抗训练的理解,以及FGM、PGD和FreeLB的详细介绍,CSDN,08 Dec 2023,www.csdn.net.

[12] deephub.对抗性攻击的原理简介,CSDN,24 Dec 2021,www.csdn.net.

[13] SinHao22.计算机如何计算卷积操作,CSDN,14 Apr 2022,www.csdn.net.

[14]Kula M .Metadata Embeddings for User and Item Cold-start Recommendations[J].Computer Science, 2015.DOI:10.48550/arXiv.1507.08439.

[15]Sze V, Chen Y H, Yang T J, et al. Efficient processing of deep neural networks: A tutorial and survey[J]. Proceedings of the IEEE, 2017, 105(12): 2295-2329.

版权声明:本文为博主作者:云边牧风原创文章,版权归属原作者,如果侵权,请联系我们删除!

原文链接:https://blog.csdn.net/weixin_44732200/article/details/133625443